笠原一輝のユビキタス情報局

WordやPhotoshopにも生成AI。推論性能を強化するNVIDIAの新GPUなど、AIプロセッサ市場の競争が激化

2023年3月22日 01:15

ChatGPTやStable Diffusionのような生成AI(Generative AI)と呼ばれ、コンテンツを生成したり、人間がしゃべっているかのように反応したりするチャットボットが大きな話題になっている。そうした中、MicrosoftやAdobeが相次いで、Word/PowerPoint/Photoshop/Premiere Proに生成AIを実装する計画を明らかにした。

学習用のGPUの性能向上で生成AIが実用レベルに

ChatGPTやStable Diffusionのような生成AI(Generative AI)と呼ばれるコンテンツを生成するAIが大きな注目を集め、テック系メディアだけでなく、TVや新聞でも「未来を変える」技術として取り上げられている。

とは言え「こうした技術って昔からあったよね? なぜ今みんな大騒ぎしているの?」と、筆者は以前からAIを追いかけていたこともあり、メディアの編集者などから最近よく質問される。

ChatGPTのGPT(Generative Pre-trained Transformer)とは、OpenAIという研究所が開発したAIのモデルで、自然言語を処理することに長けたAIとして開発されたものだ。

ChatGPTやMicrosoftのBingチャットなどに採用されているのはGPT-3やGPT-4で、当然1や2もあったわけだが、1や2の頃はそんなに有名ではなかった。

最近開発されたGPT-3やGPT-4になってようやく、この手のテクノロジに詳しくない人にも「意外と使えるよね」と分かるレベルにまで成熟したことが、今のようなブームを呼んでいるのだろう。

AIのモデルというのは、AIにどのような処理をさせるのかを決定するプログラムのことだ。

自然言語処理に特化したものが、GPT-3やGPT-4であり、画像生成のAIに使われているものであれば、Stable DiffusionのLDM(Latent Diffusion Model)などがよく知られている。

そうしたモデルの多くは、オープンソースで開発され、世の中に提供されている。

ただし、AIモデルは作っただけではただの箱で、そこにデータを読み込ませて、AIを鍛える「学習」というプロセスが必要になる(英語ではTrainingだが、日本では「学習」が一般的に使われる)。

AIの学習というのは、簡単に言えば画像認識を行なうAIモデルであれば、猫の画像を読み込ませて「それは猫だよ」と教えてあげる(そうしたデータを教師データという)、あるいは自分で学習してもらうプロセスのことだ。

子どもが親に猫を見させられて猫を学習するのと同じように、AIモデルも学習で猫を猫、犬は犬と認識できるようになっていく。

この学習のプロセスこそが、AIモデルの善し悪しを左右すると言っても過言ではない。いかにして必要なデータを集めて、GPUや学習専用のプロセッサなどを活用し、短時間で使えるAIモデルを構築するかが、優れたAIを提供する上で最も重要になる。

NVIDIAは、学習に利用するGPUについて、いくつか共有されている部分はあるものの、PC向けとAI向けで設計を分離しており、その性能は年々上がり続けている。

昨年のGTCではそのAI向けGPUの最新版としてHopperの開発コードネームを持つ「NVIDIA H100 GPU」が発表された。そして、このNVIDIA H100 GPUを8つ搭載している学習用スーパーコンピューター「DGX-H100」が今年に入ってから、ようやく出荷されるようになった。

何が言いたいのかというと、高性能な学習用演算装置の環境が整ってきているので、GPT-3やGPT-4、そしてLDMのような学習に時間がかかるAIモデルの学習時間が短縮され、ソフトウェアベンダーがさらに強力なAIモデルの開発を加速していく。そうした好循環が、今の生成AIという新しいブームにつながっているということだ。

Word/PowerPoint/Photoshop/Premiere Proへの生成AIの実装が始まる

生成AIモデルは、今やプラットフォームレベルから、アプリケーションのレイヤーに波及している。それが今起きていることだ。

ChatGPTやStable Diffusionのような生成AIが今や一般のメディアでも取り上げられ、人々が競うようにしてチャットボットに質問して、SNSに投稿する。あまつさえ生成した画像を販売する。一昔前なら冗談だったようなことが現実になっている。

そして、それは既存のITプラットフォーマーにとっても、見逃せないトレンドになっている。

MicrosoftとGoogleは競って自然言語処理を自社のサービスに取り込もうとしており、Microsoftがいち早くBingに自然言語処理を取り込んで、話題を集めたのは記憶に新しい。

プラットフォーマーらのこの動きは、自然言語処理が次世代のUX(ユーザー体験)になると考えているからだろう。

1990年代にブラウザ戦争でMicrosoftがNetscapeを駆逐してインターネットの覇権を握り、2000年代には検索エンジンを押さえたGoogleがインターネットの覇権を握る……そうした競争の次の段階に自然言語処理があると、MicrosoftやGoogleが考えているからこそ、競うように実装を進めているのだ。

また、AIモデル特有の事情として、こうした処理はユーザーに使ってもらえばもらうほどデータを収集でき、より賢くできる。そのため、他社に先んじようと激しい競争になっているのだと理解できる。

MicrosoftやAdobeは、デスクトップアプリケーションのレベルにも生成AIの実装を始めている。

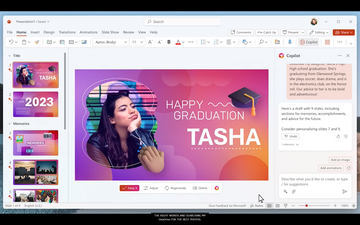

Microsoftは先週の金曜日に米国で記者会見を開き、生成AIをMicrosoft 365のデスクトップアプリケーションに実装する「Microsoft 365 Copilot」の計画を明らかにした。いずれも生成AIをWordやPowerPointのような、アプリケーションの中から使えるようにしたものだ。

そして、今週にAdobe Summitを開催しているAdobeもそれに続いている。Fireflyという自社の生成AIモデルを発表し、これまで「Adobe Sensei」として提供してきたAI基盤にそれを統合し、「Adobe Sensei GenAI Service」として提供することを明らかにした。

Adobeの生成AIの特徴は、学習データとして同社がCreative Cloudの契約ユーザー向けに提供しているストック画像サービス「Adobe Stock」のデータを利用することだ。

そのため、その学習の成果を利用する生成AIに、著作権や商標といった他者の権利を法的に侵害する恐れがない。

これまでの生成AIはインターネット上に公開されているけれど、著作権で保護されている画像データも学習データに含んでいることが一般的で、法的な権利処理に関して「グレーゾーン」の中で運営されてきた。

仮に著作権を持つホルダーが、生成AIの運営者を訴えた場合、その生成AIの成果を利用している利用者も法的な論争に巻き込まれる恐れがある。これが特にコンプライアンスを重視する大企業が抱えていた、生成AIに対する懸念だった。

Fireflyは、そうした懸念を払拭できるため、企業が生成AIを利用する場合の決定版になると思われる。AdobeはFireflyの生成AI機能を、Creative CloudやExperience Cloudなどのクリエイター/デジタルマーケティングツールにも提供する計画だ。

Creative Cloud向けにはデスクトップアプリの機能として提供し、Photoshop、Illustrator、Premiere Pro、ExpressなどにFireflyをベースにした生成AIを順次実装していく。

現時点では開発意向表明の段階で、すぐに提供されるという話ではないが、Adobeは例年10月~11月に開催されるAdobe MAXでCreative Cloud関連の発表を集中して行なうため、そのあたりで詳細が明らかになるだろう。

FireflyはNVIDIAの生成AI開発環境「Picasso」を利用

AdobeはFireflyを、3月21日(日本時間3月22日)から米国ネバダ州ラスベガス市で開催されているデジタルマーケティングソリューション向け年次イベント「Adobe Summit」において発表した。

そして、同時期に開催されているNVIDIAの年次イベント「GTC」で、Adobe FireflyのAIモデルが、NVIDIAの生成AI開発環境「NVIDIA Picasso」(以下Picasso)で開発されていることを明らかにした。

NVIDIAはすでに自然言語処理向けのAI開発環境として「NVIDIA NeMo」を提供しているが、それに加えて画像生成AIの開発環境が加わることになる。

Picassoは学習済みのモデルと、データ処理、ベクトルデータベースなどを行なうフレームワーク、さらに推論を行なうためのエンジンなどがセットで提供される。

これにより、ソフトウェアベンダーは短期間で生成AIのモデル構築、学習、推論を行ない、ユーザーにサービスを提供するところまでを一気通貫に構築可能になる。

さらに、このPicassoは、NVIDIAが今回発表した「DGX Cloud」(クラウドベースで提供されるDGX)上で動作しており、ソフトウェアベンダーは特別なハードウェアを用意することなく、生成AIを構築可能になる。

こうした環境を利用しているため、Adobeは非常に短期間でFireflyの開発を終えて、世に出せたというのだ。

NVIDIAは今回さらに推論用の新しいGPUを発表している。推論(英語ではInference)というのは、AIの処理のうち「認知」に相当する機能で、学習で取得したデータを元に、猫の写真が来たら「猫」、犬の写真が来たら「犬」と判別する機能のことを言う。

こうした推論処理は、一般的にクラウドデータセンターにあるx86プロセッサで処理されるのが一般的だった。というのも、推論処理は学習に比べると負荷が大きくなく、CPUでも十分だったからだ。

2019年の段階ではほぼ100%に近いシェアで、推論はx86プロセッサ上で行なわれていた。しかし、生成AIがその状況を大きく変えつつある。

自然言語処理や画像生成AIは、CPUでは処理しきれないほどの負荷がかかる。このため、従来のCPUによる推論処理をGPUに切り替えるところも増えている。

NVIDIA ハイパースケール/HPC担当副社長 イアン・バック氏は「先週、Microsoftは16の地域で、数十万個のGPUの導入を開始し、それを推論処理に利用すると発表した。推論処理でもGPUを使う動きが加速している」と述べている。

このため、NVIDIAは今回のGTCに合わせて2つの推論向け新製品を発表している。

1つはPCI Expressカードの1スロット向け製品のL4で、Ada Lovelace世代のアーキテクチャを採用したデータセンター向けのGPUとなる。従来のA10と比較して生成AIの性能で約2.7倍となる性能を発揮する。

もう1つは、H100 NVLになる。H100 NVLは簡単に言うと、H100を搭載したPCI Expressカードベースの製品を、NVLinkを利用して連結したものだ。

NVLinkによって両方のボードに搭載されているメモリにそれぞれのGPUがアクセス可能になり、メモリ帯域幅が向上する。

| H100 PCIe | H100 NVL | |

|---|---|---|

| FP16 | 1,513TFLOPS | 3,958TFLOPS |

| FP8 | 3,026TFLOPS | 7,916TFLOPS |

| メモリ | 80GB | 186GB |

| メモリ帯域 | 2TB/s | 7.8TB/s |

これにより、DGX-A100に搭載されているA100に比べてメモリのスループットは12倍になり、GPT-3のような大規模なAIモデルを活用した推論を、より高速に処理可能になる。

クラウド側の推論向けプロセッサの競争が激化。エッジ側はNPUの注目度が上がる

生成AIの登場は、AI向け半導体の競争の軸を変えつつある。従来、学習はNVIDIAのCUDA GPU、推論はx86 CPUという明確な棲み分けがあった。しかし、生成AIが登場したことで、推論向けプロセッサの競争が激しくなっていくと考えられる。

しばらくは処理が軽いものはCPUで、重いものはGPUとなるだろうが、最近はSambaNovaやTenstorrentなどの半導体ベンチャーが開発した、AI特化のプロセッサやアクセラレータなども注目を集めている。Intelが買収してラインナップに加えているHabana Labsのアクセラレータもここに入る。

AI専用プロセッサやアクセラレータの特徴は、電力あたりの処理能力、つまり電力効率が汎用プロセッサのGPUよりも優れていることだが、その反面独自のプログラミングモデルを学ばなければならないというのが課題になる。

もう1つ指摘しておかなければならないことは、今後はエッジ側、つまりクライアントPCやスマートフォンに搭載されるNPU(Neural Processing Unit)の重要性が増していくだろうということだ。

MicrosoftやAdobeの例に見るように、デスクトップアプリケーションに生成AIの機能が実装され始めている。今はまだ始まったばかりなので、たとえば自然言語の処理などはほとんどがサーバー側で行なわれている。

しかし、将来的にはそれらの機能はエッジ側で処理するような実装が増えていくだろう。たとえば、画像生成AIなどは、Stable Diffusionがそうであるように、クライアントPC側の演算リソースを利用するようになっている。

同じような機能をMicrosoft 365やCreative Cloudに実装していくのであれば、今のクライアントPC向けのCPU/GPUの処理能力では足りず、ディスクリートGPUが必須ということになる。

デスクトップPCであればそれでもいいかもしれないが、ノートPCではそうはいかないことは明らかで、そこで登場するのがNPUというわけだ。

その実例としてQualcommはスマートフォン用SoC(Snapdragon 8 Gen 2)に内蔵されているNPU(同社の呼び方ではDSP)で画像生成処理をするデモをMWCで見せている。

もともと推論処理に特化したNPUで行なうことで、CPUやGPUに負荷をかけることなく生成AIを利用可能になる。Qualcomm、Appleともにスマートフォン向け、PC向け、どちらのSoCにもすでにNPUを内蔵している。

また、x86プロセッサでも、AMDがRyzen 7000モバイルプロセッサのうち開発コードネーム「Phoenix」で呼ばれているダイに、Xilinx由来のFPGAを統合することで、NPUとして利用できるようにしている。

Intelは開発コードネームKeem Bayで知られる単体NPUをOEMメーカーに提供しており、今年後半に登場予定の次世代製品「Meteor Lake」でCPUに統合する計画だ。

今後はそうしたNPUもクライアントPCやスマートフォン向けSoCの新しい競争軸として浮上してくると考えられ、半導体メーカーの動向にも要注目だ。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:5位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![大河の一滴 最終章 [ 五木 寛之 ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/5293/9784344045293_1_3.jpg?_ex=128x128)

![水卜さくら写真集『水うらなひ』 [ 田村浩章 ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/noimage_01.gif?_ex=128x128)

![古乃ほの1st写真集『ほのたん』 [ GOTA SUZUKI ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0431/9784823610431.gif?_ex=128x128)

![幸せな結末 大滝詠一ができるまで [ 萩原 健太 ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0801/9784163920801_1_7.jpg?_ex=128x128)

![わたしの定番服 ちゃんと学べて長く着られる服づくり [ ただ服をつくる いづみ ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/5658/9784529065658_1_2.jpg?_ex=128x128)

![不徳のギルド 17巻【電子書籍】[ 河添太一 ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/9038/2000019629038.jpg?_ex=128x128)

![ギャルに優しいオタク君(6) (ガンガンコミックスONLINE) [ 138ネコ ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/3939/9784301003939_1_3.jpg?_ex=128x128)

![ONE PIECE 114 (ジャンプコミックス) [ 尾田 栄一郎 ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0191/9784088850191_1_9.jpg?_ex=128x128)