西川和久の不定期コラム

Ryzen搭載のミニPCで簡単に楽しめる生成AI画像アプリ「Amuse」!+少しLLM

2025年3月25日 06:11

このコラムで2回ほどRyzen AI 9 HX 370を搭載したミニPCをご紹介したが、AIと付いている割にほとんどAIっぽいことはしなかった。そこで今回は、AMD専用のGPUに加えNPUも使う生成AI画像アプリをご紹介し、最後に少しLLMについても触れてみたい。

Amuseとは!?

今回ご紹介する生成AI画像アプリ「Amuse」自体は、去年(2024年)7月に以下のような記事が載っている。

これはAMDが発表したアプリで、開発はAI系企業のTensorStackと提携しているようだ。上の記事の時点では2.0 Betaだったが、現在(執筆時)は2.3.15となり、“Beta”が取れた状態だ。AMDの冠が付いているだけあって無料で利用できる。

サイトを眺めると、RECOMMENDED SPECIFICATIONS FOR AMD LAPTOPS:(AMDラップトップ推奨仕様)として、

- AMD Ryzen AI 300 series processors with 24GB of RAM or higher

- AMD Ryzen 8040 series processors (AMD XDNA Super Resolution requires the latest OEM MCDM and NPU driver update) with 32GB of RAM

RECOMMENDED SPECIFICATIONS FOR AMD GRAPHICS CARDS:(グラフィックスカード推奨仕様)として、

- Radeon RX 7000 Series Graphics Cards

になっている。つまり、CPUだけに絞って見ると、最新のRyzen AI 300系のプロセッサを搭載していてもメモリ16GBではNG。(24GBはあまり見かけないので)32GBが必要となる。

これは生成AIではVRAMを使うため、モデルにもよるが16GBは欲しくなるためだ。そうすると元々16GBのミニPCではどうにもならないのだろう。今後AI対応プロセッサ搭載PCを購入する場合、少なくとも32GBはあった方が無難だろう。

参考までにメモリ32GB搭載「GMKtec EVO-X1」のUMAは、BIOS(起動時[DEL]キー)→Advanced→Configuration→UMAで変更することができる。

設定可能な容量は1/2/4/8/16GB。最大はメモリの半分なのか違うのかは、16GBや64GB搭載モデルを触ってないので不明。

今回は32GBあるのでUMAで16GBを設定、以降、この状態でアプリを試用している。では早速使ってみたい。

簡単セットアップで初心者でも生成AI画像を楽しめる!

Amuzeのセットアップは簡単だ。サイトの「DOWNLOAD AMUSE V2.3.15 with AMD XDNA Super Resolution」のボタンを押し、Amuse_v2.3.15.exeをダウンロード/実行、あとはウィザードに従いインストールするだけと、Pythonの環境を作ったり別途ドライバの用意などは一切不要。初心者でも簡単だ。

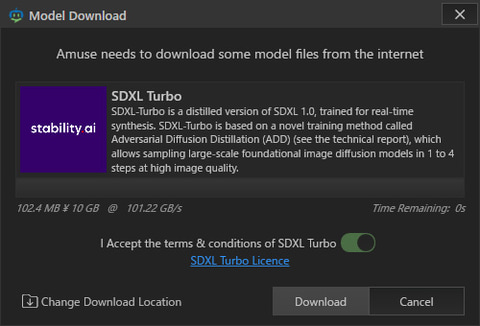

実行すると、まずEasyモードで起動する。ご覧のようにPromptと縦横比指定程度の簡単なUIだ。Promptに何か入れ、[Generate Images]ボタンを押すと、初回はモデルが何も入っていないのでSDXL Turboをダウンロード、その後、生成される。

なおデフォルトでモデルは C:\Users\[ユーザー名]\AppData\Local\Amuse\Models に入っているので、もう少し扱いやすいフォルダへ変更した方がいいかもしれない(Settingsで変更可能)。

使用しているモデルがSDXL Turboなので1:1だと512×512ピクセル(px)。ステップ数(Steps)は4。4枚生成しても6.9秒と速い。ただし画像はご覧のように結構雑だ。

Easyモードで面白いのがAI Filter。Promptにたとえば“Cherry blossom park style”と書くと、元画像からそれっぽい画像が生成される。作例は元画像が照明機材バックだったこともあり、夜桜的に仕上がった(笑)。4枚作って(Upscale 2xあり)、74.3秒だと十分速い。

次はEasyモード / Design。仕掛け的にはDreamshaper v7 LCMとControlNet / Scribbleが使われている。つまり(雑な)線画から画像を生成する。適当に富士山、雲、川っぽいのを線で書き、PromptでMount Fuji, clouds, riverとしたところ見事に写真(絵?)となった。

ここまででも十分遊べそうだが、画面を眺めると左下に[Advanced]モードがあるので、それに切り替えると、Image Generation、Video Generation、Model Managerのタブが現れる。

Model Managerには見慣れた有名なモデルがいろいろ並んでおり、ダイレクトにダウンロードできるため、WebブラウザでCivitaiへ行く必要もない。

さっそくDreamshaper Lightningを使って生成したのが上記の画面となる。かかった時間は832×1,216ピクセル、8ステップで20.6秒。速くはないが、我慢できない時間でもない。

Ryzen AI 9 HX 370クラスのiGPUの場合、dGPUほど強力ではなく、SD 1.5もしくはSDXLでもLCMやTurbo、Lightningなど、基本ステップ数を少なくできるモデルを使うのがコツとなる。

普通のSDXLやFLUX.1などで生成すると分単位でかかるため(怖いもの見たさ以外は)使わない方が無難だろう。もちろんVideoも重い処理なので禁止(笑)。ただ、dGPUのRadeon RX 7000シリーズをお持ちの方はフルに使って問題ないだろう。

少し戸惑うのは、モデルを選択して、その後、右下にある[Load]ボタンを押さないとロードされず、パラメータの設定もできない点。一瞬「あれ?」と思ってしまう。

一方で便利なのは、いろいろなテンプレートが用意されており、Loadした時点でステップ数など必要なパラメータは自動的に標準的な値に書き換わる点。この項目にどんな値を?と悩まなくても正常な画像を生成でき、ユーザー側で操作が必要なのは幅×高さの指定程度だ。

ほかにも左側を眺めてると、Image To Image、Paint To Image、Image Paint、Upscaler、Feature Extractorなどが並び、その下にRAM/SRAM/VRAM、CPU/NPU/GPUの使用率を表示する小さいインジケータもある。加えて、Settingsには、ControlNetやUpscalerなども。今回は一部しか試していないものの、いろ楽しめそうな内容になっている。

一瞬だがNPUも動く!

ここまではRyzen AI 9 HX 370のiGPUを使っての処理だが、実はNPUを使う処理もAmuseは搭載している。生成時にAMD XDNA Super Resolutionにチェックすると、指定の解像度から2xにUpscaleされるのだが、これに一瞬NPUが使われる。

リソースモニタ / NPUの表示がちょっと山形になっている部分がNPUを使った証拠だ。せっかくNPUを搭載しているのだから、もっとほかでも使って欲しいのだが、見る限りAMD XDNA Super Resolutionだけの用途となっている。

とは言え、たったこれだけの負荷で832x1,216pxが1,664x2,432pxになるのだから(しかも結構速い)、使わない手はないだろう。

以上、ザックリであるがAmuseの機能紹介となる。強力なdGPUがなくてもRyzenプロセッサとメモリがあれば、ミニPCやノートPCのみで生成AI画像を試すことができ、ある意味画期的。一昨年(2023年)3月頃、四苦八苦していたのが嘘のようだ。該当するPCを持っていればぜひ試していただきたい。

ちなみにAmuseはAMD向けのソフトウェアであるが、IntelやQualcommにもAIプロセッサ対応の同様アプリを用意して欲しいところだ。

おまけ!CPU/RAMでLLMが動く!?

ここまではAMDのプロセッサやGPUに特化した話だが、以降の多くは一般的なPCの話となる。

先日PADの動画配信でLLM全般について話したのだが、

この最後の最後、CPUとメインメモリだけで、cyberagent-DeepSeek-R1-Distill-Qwen-14B-Japanese-gguf(DeepSeek蒸留版)と、Gemma-3-27b-it(Vision/画像認識対応)を動かしている(どちらもQ4_K_M)。

ご覧のようにCPU/RAMだけで画像認識しているのが分かる。速度的に8.85 token / secと、環境を考えると結構速く、一般的に15 token /secを超えるとそこそこ使えるので後一歩という感じだ。

これは使ったミニPCが、GMKtec EVO-X1と、メモリがオンボードでLPDDR5X-7500ということもあるのだが(Core i9-12900/平均70%使用、DDR4-3200/約16GB使用で試したところ、4.44 tok/secだった)、それにしてもGPUなしでこれだけ動くとは結構衝撃的だったりする。

AI PCと聞くと、画像生成だったり、LLMでのチャットはもちろん、LLMを使った何かのアプリケーションを想像するとは思うが、NPUが乗っていてもこれらをサクッと使える状況にはなっていない。プロセッサメーカーやMicrosoftはこの点、もっと頑張ってほしいところ。AI対応プロセッサが絵に描いた餅ではもったない話だ。

この1つの回答としてMicrosoftは、DeepSeek-R1-Distill-Qwen-1.5B(1.5Bではおしゃべり程度。7B及び14Bも近日公開予定)をCopilot+PC用にNPU上で動作するよう、移植。

Visual Studio Codeの拡張機能、AI Toolkitを経由しての提供となる。ただ現在はArm版のみで、Intel版およびAMD版は未だとのこと。こう言った動きが活発になるとAI対応プロセッサの需要も増えるのではないだろうか。

以上、最後は少し違う話になったものの、RyzenおよびRadeon向けの生成AI画像アプリ「Amuse」をご紹介した。AMDが出してるだけあって同社のiGPU/dGPUがあれば特に難しい設定もなく、サクッと動いてしまうのは流石。

せっかくRyzen AI 300シリーズプロセッサ搭載ミニPCを購入してもAIらしいことをしてないな……という人は、ぜひ試してほしい。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:4位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![【エントリーで最大全額ポイント還元|3/11まで】 LENOVO|レノボジャパン ノートパソコン IdeaPad Slim5 Light Gen10 83J20053JP [13.3型 /Windows11 Home /AMD Ryzen 7 /メモリ:16GB /SSD:512GB /M365 (24か月) or Office 選択可能 /2025年12月モデル] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/biccamera/cabinet/product/15527/00000014725626_a01.jpg?_ex=128x128)

![新品 アップル MacBook Air 15インチ Apple M2チップ搭載モデル [SSD 512GB メモリ 8GB 8コアCPUと10コアGPU ] ミッドナイト MQKX3J/A 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/sanshintech/cabinet/11848448/imgrc0107119445.jpg?_ex=128x128)

![【スーパーSALE限定 P20倍】WINTEN モバイルモニター 15.6インチ テレワーク/デュアルモニター/サブモニターに最適!ゲーミング 1080P FHD IPSパネル 軽量 薄型 非光沢 カバー付 ミニPC Switch iPhone Type-C/HDMI接続 [1年保証] WT-156H2-BS 5523 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/win10/cabinet/monitor/imgrc0112809238.jpg?_ex=128x128)

![フィリップス 32E1N3100LA/11 [31.5型液晶ディスプレイ/1920×1080/HDMI、D-sub/ブラック/スピーカー:あり] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/etre/cabinet/itemimage29/1252759.jpg?_ex=128x128)

![【特典】治療薬ハンドブック2026(治療薬ハンドブックオリジナル マッキーワーク) 薬剤選択と処方のポイント [ 堀 正二 ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0963/2100014770963.jpg?_ex=128x128)

![BE-PAL(ビーパル) 2026年 4月号 [雑誌] 【特別付録: Coleman特製 ”キャンプ”カレー皿】 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0462/4912176310462_1_3.jpg?_ex=128x128)

![おともだちえほん はじめての「よのなかルールブック」 [ 高濱正伸 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1540/9784284001540_1_3.jpg?_ex=128x128)

![薫る花は凛と咲く(22)【電子書籍】[ 三香見サカ ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/4318/2000019794318.jpg?_ex=128x128)

![【楽天ブックス限定特典】乃木坂46川崎桜 1st写真集『エチュード』(限定カバー) [ 川崎桜 ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1009/2100014821009_1_3.jpg?_ex=128x128)

![会社四季報 2026年 4月号 [雑誌] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0462/4912023230462_1_2.jpg?_ex=128x128)