ニュース

足りないメモリは超高性能SSDで拡張する。AI時代に向けたキオクシアの製品開発

2025年9月3日 06:26

キオクシアは9月2日、同社のAI市場向けフラッシュメモリ技術や製品に関する製品説明会を開催した。

説明会では、同社メモリ事業部メモリ応用技術統括部技術統括部長の松寺克樹氏、SSD事業部SSD応用技術技師長の福田浩一氏が登壇。8月に米国で開催されたメモリ/ストレージ関連の大型イベント「FMS(the Future of Memory and Storage)」での発表内容を含め、同社のフラッシュメモリ技術やAI市場に向けた製品展開などについて説明が行なわれた。

3つの次世代フラッシュメモリで多様なニーズに対応

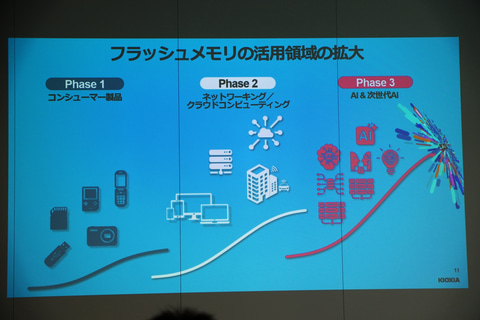

フラッシュメモリの活用領域は、デジタルカメラや携帯電話といったコンシューマ製品から徐々に発展し、PCやスマートフォン、データセンターやクラウドコンピューティングでも広く使われるようになった。

特に昨今はAIの急速な進化により、フラッシュメモリの活躍の場がさらに拡大。高性能/大容量/低消費電力なストレージとして欠かせない存在となっている一方、要求される性能もより高度になっているという。

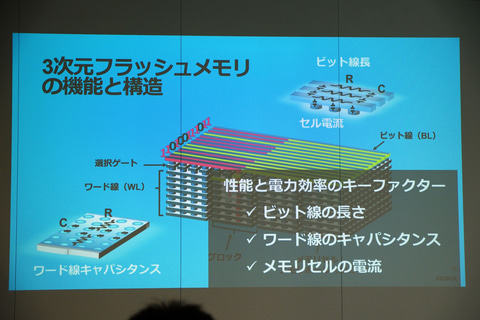

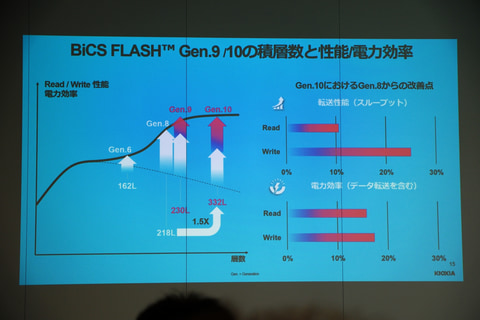

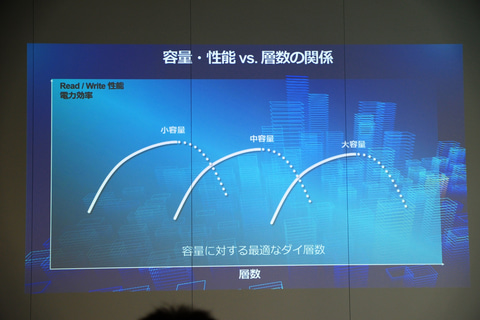

高性能化が求められているSSDだが、同社のBiCS FLASHをはじめとした3次元フラッシュメモリでは、性能と電力効率を左右する重要な要素として、ビット線の長さ、ワード線のキャパシタンス、メモリセルの電流の3つが主に挙げられるという。

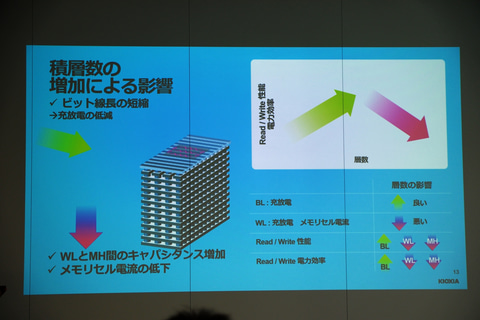

たとえば、縦方向の積層数を増やし、その分横方向のチップサイズを小さくすると、同じメモリセルの容量を保ちながらフットプリントを縮小できる。これによってビット線の長さが短くなり、性能改善や電力効率改善を図ることができる。しかし、当然積層数が増えることによるマイナスの作用もあるため、ただ積層数が増やすだけだと、あるところから逆に性能が落ちてしまうことになる。

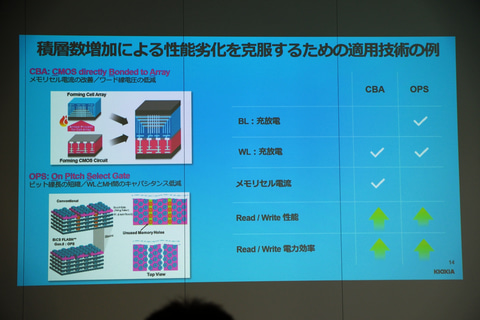

同社ではこうした副作用に対するさまざまな技術を投入し、積層数増加による性能劣化の抑止を図っているという。説明会では例として、CBA(CMOS directly Bonded to Array)、OPS(On Pitch Select Gate)といった技術が紹介された。

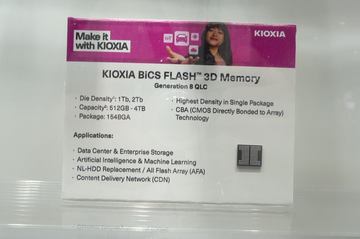

CBAはメモリセルと周辺回路のウェハを別々に作り、ウェハ同士を貼り合わせる技術、OPSはメモリホールの間に選択ゲート分離用の溝を作る技術。どちらも現行の第8世代BiCS FLASHで導入したもので、ダイサイズの削減や電力効率の向上に貢献している。

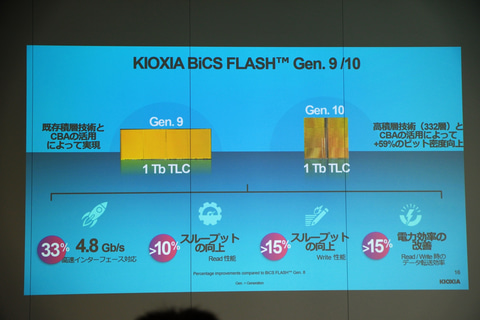

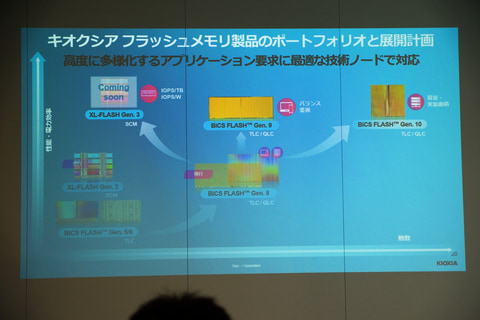

その上で、次世代フラッシュメモリとなる第9世代および第10世代BiCS FLASHメモリについて説明。第9世代BiCS FLASHは、第8世代で用いられている積層技術とCBAを活用し、メモリホールなどの装置も既存のものを可能な限りそのまま使用しつつ、性能アップを図った製品となる。積層数は230層に達する。

第10世代BiCS FLASHは、新たな製造装置や技術、CBAなどを組み合わせてより積層数を高めた製品。ビット密度は59%向上し、積層数は332層に達する。

性能面はどちらもインターフェイス速度が4.8Gbpsで第8世代比33%アップとなっているほか、スループットはリードで10%以上、ライトで15%以上、電力効率も15%以上の改善を実現したとしている。

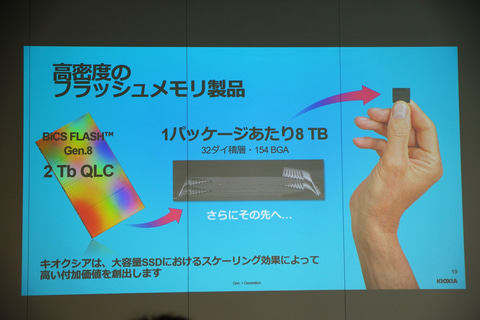

それ以外にも、現行の第8世代BiCS FLASHを使った2Tb QLCも開発。32層積層することで1パッケージで8TBの大容量を実現する高密度品となっている。

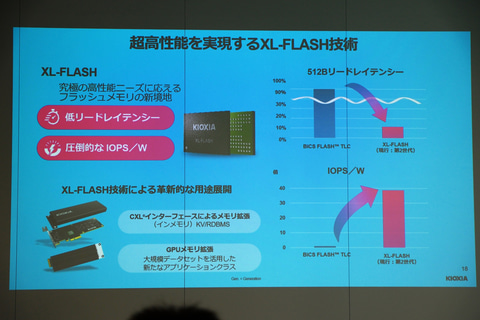

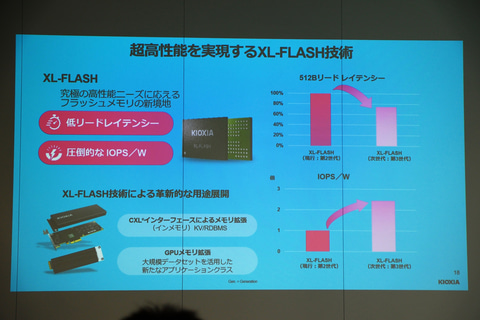

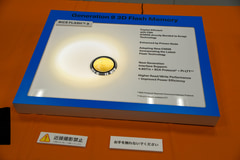

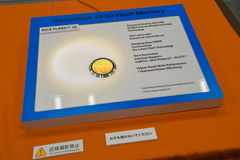

また、超低レイテンシなフラッシュメモリのXL-FLASHについても紹介。現在第2世代製品が投入されており、TLC NANDフラッシュと比べてリードレイテンシは8分の1~10分の1、IOPS/W(1WあたりのIOPS数)は35~40倍に達するという。

第3世代も開発が進んでおり、第2世代と比べて512Bリードレイテンシを80%以下に抑えるとともに、IOPS/Wを約2.5倍に引き上げているという。CXLインターフェイスを使ったメモリ拡張や後述のGPUメモリ拡張などでの活用を見込む。

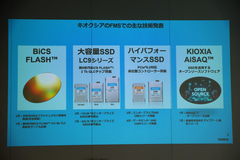

同社は今後、PCやスマートフォンなどに向けたコストと性能のバランスに優れる第9世代BiCS FLASH、データセンターなどに向けた容量や実装面積重視の第10世代BiCS FLASH、レイテンシやランダムアクセス性能重視の第3世代XL-FLASHの3つを主要なポートフォリオとして展開。複数の世代の製品を使って多様化するアプリケーション要求に対応していくとした。

AIで加速するSSD需要。245.76TBの大容量SSDなども投入

加えて、昨今急速に拡大しているAIにおけるSSDの役割についても説明を行なった。HDDと比べるとSSDはまだまだ高価であり、データセンターなどでは今でもHDDの方がよく用いられているが、AI需要の高まりとともにSSDの使用比率が伸びてきているという。

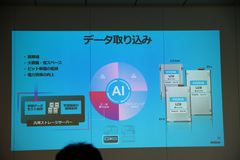

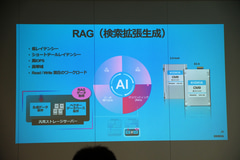

AIのワークフローは主に、データ取り込み、学習、推論、グラウンディング(RAG)の4つに分けられる。それぞれのフローでまったく異なる処理を行なうため、ストレージに要求される性能も違ってくる。そういった中でも同社は、各フローに適したSSD製品を提供できているとアピールした。

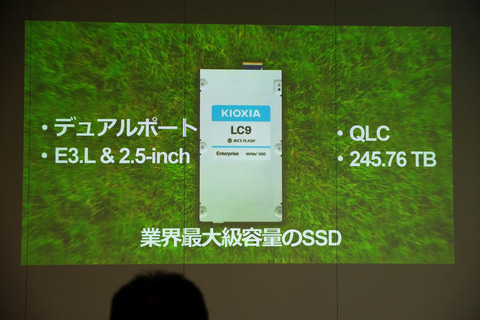

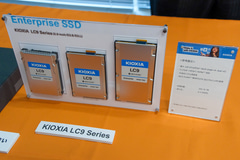

特にAIの学習データやRAGにおけるベクターデータベースは容量が膨大となるが、そういった用途に向けては245.76TBの大容量SSD「KIOXIA LC9」を開発。業界最大級の容量を実現したという製品で、245.76TBモデルは2.5インチおよびE3.Lフォームファクタで用意する。フラッシュメモリには第8世代BiCS FLASHベースの2Tb QLCを使用している。

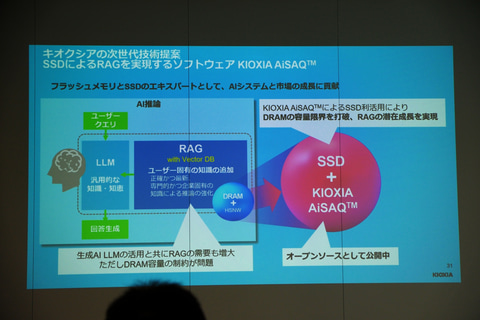

あわせて、DRAMの代わりにSSDへRAG用のベクトルデータベースを保存できるようにするソフトウェア「KIOXIA AiSAQ」も提供中。オープンソースで公開しており、生成AIとともに高まるRAGの需要に対し、DRAMが持つ容量やコスト面の課題解決を図る。

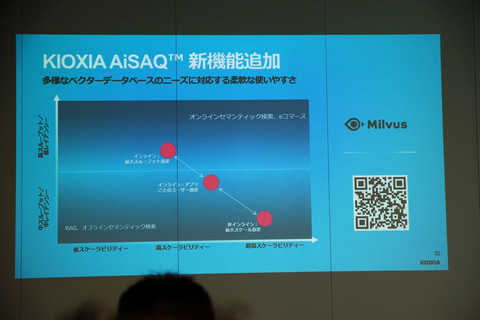

直近では、スループットとレイテンシのバランスを調整できる機能が加わり、より幅広いニーズに対応できるようになったほか、オープンソースのベクトルデータベースであるMilvusでもAiSAQが利用可能となった。

GPUメモリやキャッシュなど、単なるストレージではないSSDの使い方も模索

また、同社ではAI分野におけるSSDの新たな用途として、GPUメモリ拡張やGPU近傍キャッシュといった、通常のストレージとは違ったSSDの使い方も見据えているという。

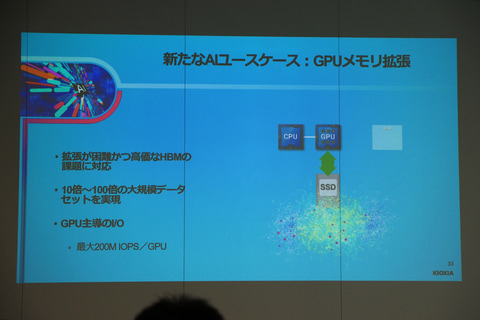

GPUメモリ拡張は、GPU内蔵メモリであるHBMを補うかたちでSSDを活用しようというもの。HBMは高価で拡張が難しいが、GPUが高性能なSSDと直接やり取りすることで、SSDを超大容量メモリのように使えるようにする。

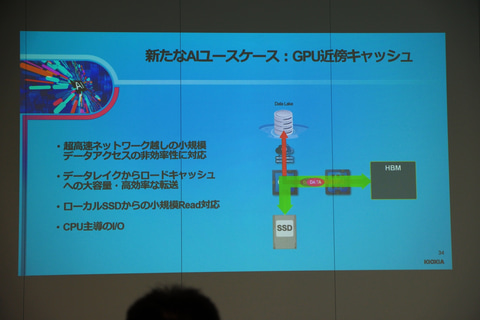

GPU近傍キャッシュは、GPUがデータ処理する際のキャッシュとしてSSDを活用しようというもの。ネットワーク接続されたデータレイクからGPUがデータを読み出して処理するケースなどでは、ネットワーク帯域がボトルネックとなってしまうことがあるが、ローカルでSSDがキャッシュを担うことでこの解消を図る。

ただし、実際にSSDがこれらの役割を果たすには非常に高い性能が必要だと説明。GPU拡張メモリの場合では、今までの10~100倍の速度が必要で、現状で1GPUあたり2億IOPSの性能が求められているとのことだった。

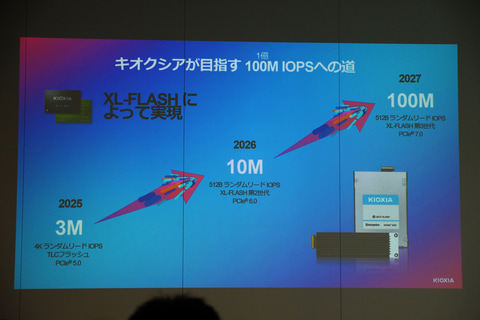

上述のXL-FLASHの実装により、こういった用途に対応する超高性能SSDが開発可能になる。2026年には第2世代品で512Bランダムリードで1,000万IOPS、2027年には第3世代品で1億IOPSの達成を目指している。

そのほか説明会では、FMSのブースに実際に並べられた一部製品の展示なども行なわれた。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:2位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![Lenovo ThinkPad L590(Win11x64) 中古 Core i5-1.6GHz(8265U)/メモリ8GB/SSD256GB/フルHD15.6インチ/Webカメラ [C:並品] 2020年頃購入 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/usedpc/cabinet/url1/5726376c.jpg?_ex=128x128)

![四畳半神話大系 愛蔵版 [ 森見 登美彦 ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9865/9784041169865_1_13.jpg?_ex=128x128)

![+act. (プラスアクト) 2026年 4月号 [雑誌] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/noimage_01.gif?_ex=128x128)

![変わりゆく災害時医療まるごとブック 実践的なマニュアルづくりに活かす✕南海トラフ地震にも備える (Emer-Log 2024年秋季増刊) [ 阿南 英明 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2844/9784840482844_1_3.jpg?_ex=128x128)

![お気楽領主の楽しい領地防衛 8【電子書籍】[ 青色まろ ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/3480/2000019753480.jpg?_ex=128x128)

![【楽天ブックス限定特典】乃木坂46川崎桜 1st写真集『エチュード』(限定カバー) [ 川崎桜 ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1009/2100014821009_1_3.jpg?_ex=128x128)