福田昭のセミコン業界最前線

「演算器内蔵メモリ」まで登場~AI時代に求められる記憶装置の姿

2024年8月28日 12:32

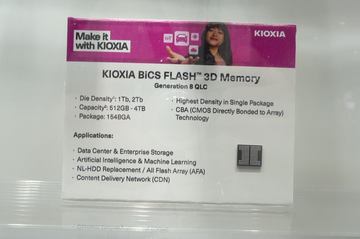

次世代のメモリとストレージに関する世界最大のイベント「フューチャー・メモリ・アンド・ストレージ(FMS:Future Memory and Storage)」が2024年8月6日~8日(米国時間)に米国カリフォルニア州シリコンバレー地域の会議場「サンタクララコンベンションセンター」で開催された。前年(2023年)までの「フラッシュメモリサミット(FMS:Flash Memory Summit)」を改称したイベントであり、枠組み(講演会と展示会、サブイベント)そのものは変わっていない。

恒例の基調講演では、久しぶりに半導体メモリ大手が出そろった。DRAMの大手ベンダーはSamsung Electronics、SK hynix、Micron Technologyの3社である。この3社はいずれも、フラッシュメモリ大手を兼ねる。フラッシュメモリ大手ではほかに、キオクシアとWestern Digitalが基調講演に参加した。これらの5社は、フラッシュストレージのベンダーでもある。

AIコンピューティングに向けた4つのDRAMソリューション

本コラムでは前回、国内の大手フラッシュメモリベンダーのキオクシアによる基調講演と展示ブースの概要をご報告した。今回はフラッシュ大手兼DRAM大手のSK hynixによる基調講演と展示ブースの概要をご報告する。

SK hynixはAI(人工知能)に向けたソリューションを今年は前面に打ち出してきた。基調講演と展示ブースの両方とも、AIに向けたメモリとストレージの最新製品をアピールした。前年の基調講演では321層の超高層3D NANDフラッシュを筆頭にNANDフラッシュの開発と量産に大半の時間を割いていた。今年は3D NANDフラッシュにはまったくふれていない。同じ企業とは思えないほど、講演内容が激変していた。

基調講演の概要をご説明しよう。前半がAIに向けたDRAMとそのモジュール、後半がAIの課題とSK hynixのソリューション、という体裁になっていた。始めはコンピュータシステムのハードウェアがAIの普及によってどのように変化するかを示した。

過去のシステムハードウェアは、CPUとDRAM、HDDという単純な構成だった。それが最近では、CPUとDRAMに、GPUとHBMあるいはGDDR系DRAMが加わり、HDDはSSDに置き換えられた。

そして近い将来のAI向けハードウェアは、GPU、NPU、ASIC、PIM(Processing in Memory)がそれぞれ特定の演算処理を受け持ち、CXL(Compute Express Link)インターフェイスを介してCPUと接続するようになる、と述べていた。CPUはCXLインターフェイスを通じて拡張記憶(Memory Expansion)やストレージプール、メモリプールとも接続する。「アクセラレイテッド・コンピューティング」とも呼ばれるシステム構成だ。

続いてAIコンピューティングに向けた4つのDRAMソリューションを示した。「HBM(」、「PIM」、「LPDDR5」、「CXL」である。HBMは広帯域かつ大容量のDRAMモジュール、「PIM」は演算回路を備えた広帯域DRAM、「LPDDR」は低消費電力かつ広帯域のDRAM、「CXL」は広帯域、大容量、不揮発性を備えたメモリモジュールと位置付ける。

GPUの標準的な主記憶となったHBM

SK hynixのHBMは、大手GPUベンダーのNVIDIAが高性能GPUモジュールの主記憶に採用したことで、注目を浴びることになった。AIの学習(「訓練」とも呼ぶ)と推論に使われるGPUモジュールは、GPUダイとHBMを同じ基板(インターポーザ)に近接して配置し、膨大な数の配線で接続してある。

SK hynixのHBMが採用された大きな理由は、独自開発の低熱抵抗封止技術「MR-MUF(Mass Reflow-Molded Underfill)」だとされる。第3世代に相当する「HBM2E」でSK hynixが量産に採用した。

HBMは2014年に開発されてから、継続して改良を重ねてきた。製品化されている最新の世代は第5世代に相当する「HBM3E」である。データ転送速度(入出力帯域)は最大1.2TB/sと高い。次世代の「HBM4」では入出力帯域を最大2.0TB/sと2倍近くに向上させる。

HBM用DRAMシリコンダイの記憶容量は、HBM3EとHBM4とも24GbitとDRAMでは最大級を誇る。DRAMダイの積層数はHBM3Eが最大12枚(36GB)、HBM4が最大16枚(48GB)となる。HBM3Eモジュールは2024年3月に量産を開始した。HBM4モジュールの量産開始は2025年を予定する。

PIMがデータ転送と消費電力の効率を大幅に向上

先述のように、AIコンピューティングに向けた2つ目のDRAMソリューションは「PIM」である。デジタル信号処理やマシンラーニングなどで良く使われる積和演算器(MAC)をDRAMセルアレイと混載したメモリだ。

積和演算の結果をPIMとCPU/GPUと送受信するので、送受信するデータ量が少なくなる、CPU/GPUの作業負荷が減少するといった利点が生じる。GPUとHBMを組み合わせたモジュールと比べ、実質的なデータ転送速度は10倍以上、電力効率は7倍以上になるとする。

3つ目のDRAMソリューションは「LPDDR5」だ。前世代のLPDDR4と比べてデータ転送速度を2倍に高め、電力消費を20%削減した。LPDDR5系では性能を向上させた「LPDDR5X」を2022年11月に開発した。入出力ピン当たりのデータ転送速度は8.5Gbit/sと高い。2023年1月には、さらに性能を高めた「LPDDR5T」(Tはターボの意味)を開発している。入出力ピン当たりのデータ転送速度は9.6Gbit/sに達する。

CXLメモリモジュールがメモリ帯域の向上と記憶容量の拡大に貢献

4つ目のDRAMソリューションは「CXL」である。CXLインターフェイスを備えたメモリモジュール「CMM(CXL Memory Module)」は、モジュールが内蔵するメモリによってさまざまな要求仕様に対応できる。講演では2つのモジュールを例示していた。

1つはDDR5 DRAMを記憶媒体とする「CMM-DDR5」である。サーバー用主記憶の拡張メモリに向けた。広い帯域を重視するメモリであり、記憶容量はあまり大きくない。サーバー本体に格納する。

もう1つはメモリコントローラとDRAMをまとめた「CMM-MDS(Managed DRAM Solution)」である。こちらは記憶容量を大きく確保することが目的となる。サーバー本体ではなく、外部にモジュールを数多く配置する。

なお展示会場のSK hynixブースでは、上記4つのソリューションを含めたDRAMとDIMMなどを展示していた。具体的にはHBM3Eの12枚積層品と8枚積層品、NVIDIAのGPU「H200」、8Gbit(4Gbitダイ×2枚)のGDDR6 DRAMをベースとしたAiM(Accelerator-in-Memory)、LPDDR5Tメモリ、DDR5のDIMM 3種、CMM-DDR5モジュールである。

AIコンピューティングの課題とSK hynixの対応策

基調講演の後半は、AIコンピューティングの課題とSK hynixの対応策を説明した。対応策には時間軸の違いで2種類あり、1つは現行製品による対応策、もう1つは次世代品での対応策となっていた。

始めに、AIコンピューティングのデータパイプラインとデータ入出力の特徴を述べた。データパイプラインはデータの「取り込み」、「データの準備」、「学習あるいは訓練」、「データの保存と復元」、「推論」の5段で構成される。

「取り込み」はメモリを通じてストレージへのシーケンシャル書き込みとなる。「データの準備」も大半はシーケンシャルの読み出しと書き込みである。しかし「学習あるいは訓練」では、ほとんどのデータ移動がランダムアクセスとなる。「データの保存と復元」は、データ移動の大半がシーケンシャルの読み出しと書き込みである。そして「推論」は、ほとんどがシーケンシャル読み出しとなる。

AIサーバーあるいはAIデータセンターは、先述のデータパイプラインに沿ってマシンラーニングの訓練と推論を実行する。サーバーを収容するラックの許容電力と容積(搭載可能なSSDとプロセッサの台数)が限定されているのに対し、取り扱うデータセットの容量は急速に増えつつある。この結果、2014年から2024年までの10年間でデータセンターのラック当たりの平均消費電力は3倍に、プロセッサの動作時消費電力は5倍に増加したとする。

またオンデバイスAIと呼ぶPCやスマートフォンなどへのAI実装は、AIモデルの取り込みに要する時間と、ユーザー体験の品質が課題となる。SSDに格納してあるAIモデルをDRAMに移動するための時間は1秒以内が望ましい。またAI PCの演算処理能力(TOPS)は今後2年で1.5倍に高まる。このため、従来よりも高い性能のSSDが要求される。

現世代のAIソリューションはPCIe Gen5 SSDや大容量QLC SSDなど

これらの課題に対処するため、現世代では以下のような製品を提供しつつある。AIデータセンター向けには、PCIe Gen5インターフェイスの高速エンタープライズSSD(eSSD)「PS10x0」とQLC方式のNANDフラッシュを搭載した記憶容量が61TBと大きなエンタープライズSSD「D-P5336」を用意した。オンデバイスAI向けには、PCIe Gen5インターフェイスの高速クライアントSSD(cSSD)「PCB01」と、ゾーンの概念を取り入れたUFS「Zoned UFS」を販売する。

次世代のAI向けメモリは演算機能内蔵へ

そして次世代のAIソリューションでは、演算機能を内蔵したメモリと、演算機能を内蔵したストレージを提供していく。従来のフラッシュストレージでは、PCIe Gen6インターフェイスのSSD、UFS 5.0を開発する。

演算機能を内蔵したメモリでは、オンデバイスAIに向けたAiMを用意する。LPDDR DRAMと演算回路を混載しており、一般行列とベクトルの乗算(GEMV:General Matrix-Vector Multiplication)を高速に実行する。なおGEMVは生成AI(特に大規模言語処理)で大量に使われる演算であり、この演算におけるメモリアクセスが処理速度のネックとなっている。

演算機能内蔵メモリにはもう1つ、CXLインターフェイスを備えたモジュール「CMS(Computational Memory Solution)」がある。データ分析の処理をCPUからCMSに移行することで、CPUの負荷を下げ、処理性能を高め、消費エネルギーを削減する。

演算機能を内蔵したストレージでは、オブジェクトベースの計算ストレージ(OCS:Object based Computational Storage)を例示した。オブジェクト(ID、メタデータ、データ)を格納し、フィルタリングの機能を備える。ホスト側でフィルタリングする代わりに、ストレージ側でオブジェクトをフィルタリングする。データ分析の実行時間を短縮するとともに、データの移動回数(ホストとストレージの間)を大幅に削減できる。

321層の3D NANDとQLC方式を組み合わせた2TbitのNANDフラッシュを展示

なお基調講演ではふれなかったが、展示会では前年に披露した321層の3D NANDフラッシュ(V9 3D NAND)を控えめに展示していた。TLC方式の1Tbitシリコンダイを作り込んだウエハーと、そのパッケージ封止品、それからQLC方式を採用して大容量化した2Tbitダイのパッケージ封止品、TLC方式で高速化した1Tbitダイのパッケージ封止品である。

同じFMSでもカバー範囲を広げたことで、SK hynixはAIソリューションを前面に押し出してきた。ほかの企業も、AI用途を主眼に置いた開発や製品などをアピールしているところが多い。「フラッシュ」と「SSD」のイベントから「ハードウェア」のイベントへとFMSは変貌したように感じた。先行きが楽しみだ。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![dynabook G83/HS (2021年モデル) [ Windows11 / Office付き / SSD 256GB / 16GBメモリ / 第11世代 Corei5] 初期設定不要 Win11 東芝 ダイナブック 中古 中古ノートパソコン ノートパソコン A6G9HSFAD521 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/be-stock/cabinet/recommend/redynag83_01.jpg?_ex=128x128)

![[新品]転生したらスライムだった件 (1-31巻 最新刊) 全巻セット 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/mangazenkan/cabinet/syncip_0018/m7360468756_01.jpg?_ex=128x128)

![角川まんが学習シリーズ 日本の歴史 5大特典つき全16巻+別巻5冊セット [ 山本 博文 ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/3680/9784041153680_1_17.jpg?_ex=128x128)

![きのう何食べた?(25) (モーニング KC) [ よしなが ふみ ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/3165/9784065423165_1_2.jpg?_ex=128x128)

![[新品][ライトノベル]転生したらスライムだった件 (全23冊) 全巻セット 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/mangazenkan/cabinet/syncip_0014/n3698499547_01.jpg?_ex=128x128)

![Ma.K. in SF3D ARCHIVE 2017.6-2018.11 vol.6 [ 横山 宏 ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1034/9784798641034_1_5.jpg?_ex=128x128)

![物語要素事典 [ 神山重彦 ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/6458/9784336076458_1_3.jpg?_ex=128x128)

![【楽天ブックス限定抽選特典】【クレジットカード決済限定】CANDY TUNE 3rd Anniversary写真集(仮)(オンラインラッキードロー抽選権) [ CANDY TUNE ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2708/2100014832708_1_2.jpg?_ex=128x128)

![神さまの言う通り さとうみつろう短編集4 [ さとうみつろう ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1328/9784198661328_1_2.jpg?_ex=128x128)