ニュース

ACE Studio、オープンな音楽生成AIモデルを公開。5090なら4分の音楽を1秒で

2026年2月5日 11:26

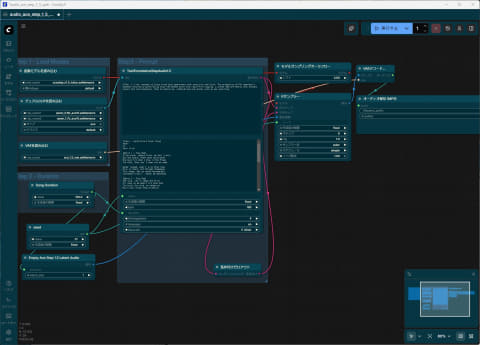

AIによる音楽制作ツールを開発するACE Studioは2月4日、オープンソースの音楽生成モデル「ACE-Step v1.5」をGitHubで公開した。すでにComfyUI上から利用できるようになっている。

ACE-Step v1.5はまったく新しいLM(言語モデル)+DiT(拡散トランスフォーマー)によるハイブリッドアーキテクチャを導入したというAI音楽生成モデル。中核となる言語モデルは、ユーザーからのシンプルなクエリを包括的な楽曲設計図に変換する多機能なプランナーとして機能し、短いループから10分間の楽曲までを生成できる。

また、分布マッチング蒸留のZ-ImageのDMD2を活用し、高速生成と高品質を両立。本質的な強化学習により、外部報酬モデルからのバイアスを排除したほか、オーディオトークナイザはDiTトレーニング中に学習され、生成とトークナイズ間のギャップを埋めた。

ACE Studioによれば、ACE-Step v1.5は主要な商用モデルや既存のオープンソースモデルと比較して、一般的なベンチマークで上回る性能(音楽の一貫性で4.72のスコア)を実現。PCおよびMacでローカル実行可能なだけでなく、LoRAによるファインチューニング、そしてモデルを自分で所有/運用できるOSSである点が特徴だという。

50以上の言語の対応がうたわれており、英語、中国語、日本語、韓国語、スペイン語、ドイツ語、フランス語、ポルトガル語、イタリア語、ロシア語を強力にサポートできる

なお、モデルに対して任意の曲を入力とし、新しいプロンプトと歌詞を与えると、異なるスタイルでトラックを再構築する「カバー」機能や、生成されたトラックの一部分だけを修正する「再描画」機能もサポートしているが、現時点ではComfyUI上から利用できず、今後のアップデートで対応する見込み。

【お知らせ】

— ACE Studio 公式 (@ACEStudio_jp)February 4, 2026

弊社のリサーチチームより、

オープンソース音楽生成モデル「ACE-Step v1.5」 をリリースしました。

ACE-Step v1.5 は、

主要な商用モデル/既存のオープンソースモデルと比較して一般的なベンチマークで上回る性能を達成しています。

さらに、

・PC / Mac でローカル実行可能

・LoRA…https://t.co/3P9DxEhk0D

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:2位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【25日限定P10倍+最大4,000円OFF+最大100%ポイントバック】 【3年保証】HP PRODESK 400 G4 DM [新品SSD] SSD256GB メモリ8GB Core i3 Windows 11 Pro 中古 返品 送料無料 中古デスクトップパソコン 中古パソコン デスクトップパソコン デスクトップ PC ミニPC OFFICE付き 製品画像:3位](https://thumbnail.image.rakuten.co.jp/@0_gold/pcwrap/goods/4bo257723_1.jpg?_ex=128x128)

![DELL|デル デスクトップパソコン ブラック SAD50-FN [モニター無し /Windows11 Home /intel Core Ultra 5 /メモリ:16GB /SSD:512GB /2025年夏モデル] 製品画像:2位](https://thumbnail.image.rakuten.co.jp/@0_mall/biccamera/cabinet/product/12848/00000014128860_a01.jpg?_ex=128x128)

![【エントリーと合わせてポイント14倍★2/19 20:00〜】モニター iiyama ProLite XB3270QSU-B1 [31.5型 IPS方式パネル ノングレア液晶] ディスプレイ WQHD(2,560×1,440) DisplayPort HDMI モニター ケーブル付属 広い表示領域で快適な作業効率<新品> 製品画像:3位](https://thumbnail.image.rakuten.co.jp/@0_mall/mousecomputer/cabinet/8_iiyama/xb3270qsu-b1.jpg?_ex=128x128)

![IO DATA(アイオーデータ) Mini LED採用ゲーミングモニター GigaCrysta KH-GDQ271JLAQ ブラック[27型/WQHD(2560×1440)/200Hz/リモコン付属] KHGDQ271JLAQ 製品画像:2位](https://thumbnail.image.rakuten.co.jp/@0_mall/akibamac/cabinet/mc5045/2522853.jpg?_ex=128x128)

![ASUS エイスース 液晶ディスプレイ Eye Care [23.8型 / フルHD(1920×1080) / ワイド] VA249HG 製品画像:1位](https://thumbnail.image.rakuten.co.jp/@0_mall/r-kojima/cabinet/n0000001461/4711387795194_1.jpg?_ex=128x128)

![SPY×FAMILY 17 (ジャンプコミックス) [ 遠藤 達哉 ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0092/9784088850092_1_11.jpg?_ex=128x128)

![NieR Re[in]carnation 公式資料集 -『檻』と祈りの物語ー [ 電撃ゲーム書籍編集部 ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/7350/9784047337350_1_21.jpg?_ex=128x128)

![ウェス・アンダーソンの世界 フレンチ・ディスパッチ ザ・リバティ、カンザス・イヴニング・サン別冊 [ マット・ゾラー・サイツ ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2126/9784866472126_1_2.jpg?_ex=128x128)

![転生したらスライムだった件(31)【電子書籍】[ 川上泰樹 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/5604/2000019605604.jpg?_ex=128x128)

![おもしろいほど日常単語が身につく英語&日本語(バイリンガル)かるた newスマート [ 東京書籍 編集制作部 ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9110/9784487809110.jpg?_ex=128x128)

![新版 赤外線工学 基礎から応用まで [ 一般社団法人 日本赤外線学会 ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/8754/9784842918754_1_75.jpg?_ex=128x128)

![GQ JAPAN (ジーキュー ジャパン) 2026年 4月号 [雑誌] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0465/4912045910465.gif?_ex=128x128)