ニュース

NVIDIA、推論におけるコンテキスト処理に特化したGPU「Rubin CPX」

2025年9月10日 17:39

米NVIDIAは9月9日(現地時間)、AIの推論フェーズにおけるコンテキスト処理に特化したGPU「Rubin CPX」を発表した。

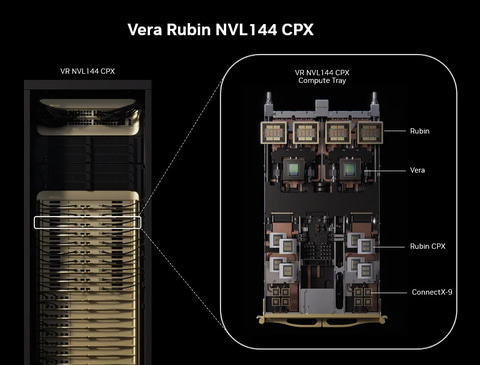

同社は2026年のAIデータセンター向けにCPUの「Vero」とGPUの「Rubin」を発表しているが、Rubin CPXはそのコンパニオンのGPUとして、VeroおよびRubinとともに「NVIDIA Vera Rubin NVL144 CPX プラットフォーム」の中に組み込むことができ、1ラックで8ExaFLPOSのAI性能、100TBの高速メモリを集約することを目指す。

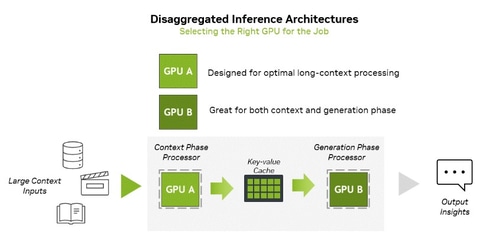

AIにおける推論処理は、コンテキストを処理するフェーズと、生成を行なうフェーズという2つのフェーズに分けることができるが、それぞれのフェーズにおいてインフラに対する要求が異なり、コンテキスト処理フェーズ演算性能に依存し、生成フェーズはメモリ帯域幅に依存するという。

そのため、NVIDIAではこれら2つのフェーズを分けて処理する「分離型推論」を提唱し、それぞれにおいて最適なリソースを提供することでスループット向上とレイテンシ削減、リソース利用率向上を目指そうとしている。そして今回が発表されたたのが、コンテキスト処理フェーズに特化してアクセラレーションを行なうRubin CPXとなる。

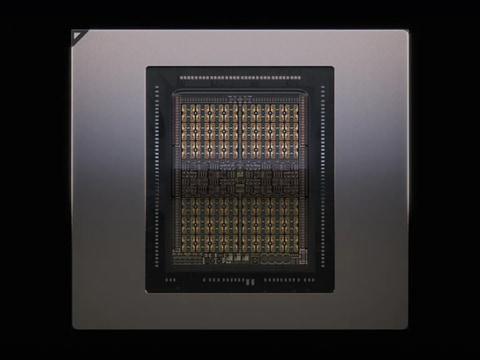

Rubin CPXではRubin GPUアーキテクチャを継承しながら、30PFLOPSのNVFP4演算性能、128GBのGDDR7メモリ、ハードウェアのビデオデコード/エンコードサポートを実装。従来のNVIDIA GB300 NVL72と比較して、3倍のアテンションアクセラレーションを実現。これにより長いコンテキストを効率的に処理できるという。

これにより、Rubin CPXを144基、Rubin GPUを144基、Vera CPUを36基統合したNVIDIA Vera Rubin NVL144 CPXラックでは、8ExaFLPOSのAI性能、100TBの高速メモリ、1.7PB/sのメモリ帯域を1ラックに集約できるとしている。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:2位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![フィリップス(ディスプレイ) 221S9A/11 [21.5型液晶ディスプレイ/1920×1080/HDMI、D-Sub/スピーカー:あり/5年間フル保証] 製品画像:13位](https://thumbnail.image.rakuten.co.jp/@0_mall/etre/cabinet/itemimage28/1267245.jpg?_ex=128x128)

![お気楽領主の楽しい領地防衛 8【電子書籍】[ 青色まろ ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/3480/2000019753480.jpg?_ex=128x128)

![ビバリウム Adoと私 [ Ado ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/6602/9784048976602_1_16.jpg?_ex=128x128)

![今日からモノ知りシリーズ トコトンやさしい水道の本(第2版) [ 高堂 彰二 ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1897/9784526081897_1_2.jpg?_ex=128x128)

![図解入門よくわかる最新水処理技術の基本と仕組み [第3版] [ 和田洋六 ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2243/9784798052243.jpg?_ex=128x128)

![JISハンドブック 32 紙・パルプ(2026) [ 日本規格協会 ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1761/9784542191761_1_2.jpg?_ex=128x128)

![【楽天ブックス限定特典】乃木坂46川崎桜 1st写真集『エチュード』(限定カバー) [ 川崎桜 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1009/2100014821009_1_3.jpg?_ex=128x128)

![松本清張の昭和 (講談社現代新書) [ 酒井 信 ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2304/9784065422304_1_2.jpg?_ex=128x128)

![大ピンチずかん 3冊セット [ 鈴木 のりたけ ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1858/2100014421858.jpg?_ex=128x128)

![テレビマガジン特別編集 仮面ライダー 昭和46年~48年 講談社所蔵写真集 究極 [ 講談社 ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1309/9784065401309.gif?_ex=128x128)