イベントレポート

NVIDIA、従来比性能5倍のAI GPU「Rubin」正式発表。2026年後半に登場

2026年1月6日 07:50

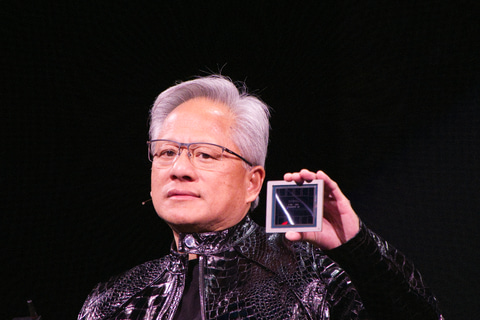

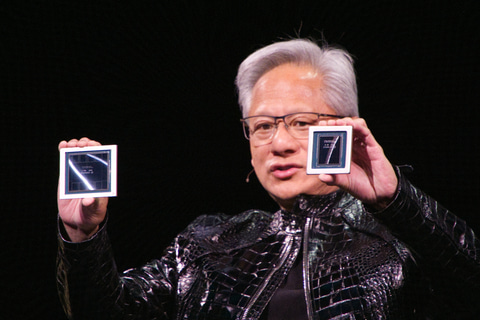

NVIDIAは、AIデータセンター向けの新型CPUおよびGPUになる「Vera」と「Rubin」を正式発表した。以前から計画は明かしていたが、1月5日にラスベガスで開催した同社CEO ジェンスン・フアン氏の基調講演の中で正式にお披露目となったかたちだ。

さらにVeraとRubinなどを利用してラック内でスケールアップするための「NVLink 6 Switch」、データセンター内でそうしたラックをスケールアウトするための「ConnectX-9 SuperNIC」「BlueField-4 DPU」「Spectrum-6 Ethernet Switch」といった高速ネットワーク製品を発表した。

現行世代GPU「Blackwell」(NVIDIA B300/B200/B100)の後継となるRubinは、新しいGPUアーキテクチャとHBM4メモリを採用していることが特徴だ。NVFP4で演算した場合、BlackwellではAI推論性能、学習性能のいずれも10PFLOPSだが、Rubinでは推論時が5倍の50PFLOPS、学習時には3.5倍の35PFLOPSに達する。

従来と比べてトークンあたりのコストは推論で10分の1、学習で4分の1に

今回NVIDIAが正式に発表したVeraは、NVIDIAがカスタム設計したOlympusコアを88基搭載するArmアーキテクチャCPU。Rubinは現行製品であるBlackwell(B300/B200/B100)の後継となるAIデータセンター向けのGPUだ。

GPUのRubinは、米国の有名な科学者クーパー・ルービンの名前からとったコードネームで、Rubin世代のGPUアーキテクチャを採用している。Blackwell世代よりも高効率にAI演算が可能。また、新しいメモリ技術であるHBM4を採用し、第6世代のNVLink、Confidential Computing、RASエンジンに対応するなど、プラットフォームレベルでの性能やセキュリティも強化している。

そうした改良により、NVIDIAが提供しているエージェンティックAIを実現する先進的な推論モデルやMoE(Mixture of experts)モデルなどを利用した場合、推論でのトークンあたりのコストが最大10分の1、学習でのトークンあたりのコストが4分の1になるという。

Rubinと従来世代のBlackwell(GB200に搭載されているB200のことだと思われる)を比較すると、NVFP4で推論した場合は5倍の50PFLOPS、NVFP4で学習した場合は3.5倍の35PFLOPSという性能を実現する(いずれもBlackwell世代では10PFLOPS)。HBM4のメモリ帯域幅は22TB/sでBlackwellの2.8倍、GPUあたりのNVLinkによる帯域幅は3.6TB/sで同2倍の性能を発揮する。

| Rubin | Blackwell | 性能の上がり幅 | |

|---|---|---|---|

| NVFP4推論 | 50PFLOPS | 10PFLOPS | 5倍 |

| NVFP4学習 | 35PFLOPS | 10PFLOPS | 3.5倍 |

| HBM4帯域幅 | 22TB/s | 8TB/s | 2.8倍 |

| GPUあたりのNVLink帯域幅 | 3.6TB/s | 1.8TB/s | 2倍 |

Veraは、NVIDIAがカスタム設計したOlympusコアを88基搭載。独自開発した仮想マルチスレッディング(SMT)技術「NVIDIA Spatial Multi-threading」に対応しており、有効にした場合は176スレッドのCPUとして利用できる。データセンター向けのメモリモジュール規格「SOCAMM」のLPDDR5Xのメモリを1.5TB(従来のGraceと比べて3倍の容量)搭載でき、メモリ帯域幅は1.2TB/sに達する。

なお、今回もBlackwell世代と同じように、1つのモジュールにVera 1基とRubin 2基を搭載した「Vera Rubin」、そして36枚のVera Rubinを1つのラックに集約したスケールアップソリューション「Vera Rubin NVL72」も用意される。Vera Rubin NVL72では、第6世代のNVLinkに対応した「NVLink 6 Switch」が組み合わされて、36基のVera CPU、72基のRubin GPUが1つのラックに搭載される。

| Vera Rubin NVL72 | GB200 NVL72 | 性能の上がり幅 | |

|---|---|---|---|

| NVFP4推論 | 3.6EFLOPS | 0.72EFLOPS | 5倍 |

| NVFP4学習 | 2.5EFLOPS | 0.71EFLOPS | 3.5倍 |

| LPDDR5X容量(CPUメモリ) | 54TB | 21.6TB | 2.5倍 |

| HBM4容量(GPUメモリ) | 20.7TB | 13.8TB | 1.5倍 |

| HBM4帯域幅 | 1.6PB/s | 0.57PB/s | 2.8倍 |

| スケールアップ帯域幅 | 260TB/s | 130TB/s | 2倍 |

x86プロセッサ向けのデザインとしてOEMメーカー向けに、8枚のRubinを1つのサーバー機器に収めた「HGX Rubin NVL8」や、NVIDIA自身のサーバーとして「DGX Rubin NVL8」も提供される計画だ。顧客はNVIDIAのArm CPUでも、x86 CPUでも好みのCPUを選択して、Rubinを利用できる。

Vera Rubinは2026年後半に登場。4大CSPやOEMメーカーなどから提供予定

NVIDIAは、今回同時にスケールアウト向けの高速ネットワークに関しても新製品を発表した。ConnectX-9 SuperNIC、BlueField-4 DPU、Spectrum-6 Ethernet Switchなどがそれで、前述のVera Rubin NVL72、HGX Rubin NVL8などと組み合わせてスケールアウトできる。

今回同社では、AIスーパーコンピュータのレファレンスデザインとなる、Vera Rubin NVL72を8つスケールアウトした「DGX SuperPOD With DGX Vera Rubin NVL72」も発表。CUDAなどのソフトウェアソリューションを活用することで、256基のVera CPUと512基のRubin GPUを1つのスーパーコンピュータとして活用できる。

同社によれば、今回の新製品は2026年の後半に登場する予定で、4大CSP(AWS、Google Cloud、Microsoft Azure、Oracle Cloud Infrastructure)や、Dell Technologies、HPE、Lenovo、SupermicroなどのOEMメーカーなどを経由して提供される。OpenAIやAnthropic、MetaといったAIモデルを開発している企業などが採用計画を明らかにしている。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:4位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![レノボジャパン Lenovo ノートパソコン Chromebook Duet Gen9 [ 10.95型 / Chrome OS / MediaTek / メモリ4GB / eMMC128GB ] ルナグレー 83HH000UJP 製品画像:8位](https://thumbnail.image.rakuten.co.jp/@0_mall/r-kojima/cabinet/n0000001243/4582763801897_1.jpg?_ex=128x128)

![よくわからないけれど異世界に転生していたようです(30)【電子書籍】[ 内々けやき ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/9869/2000019809869.jpg?_ex=128x128)

![めくって学べるずかん 既6巻 [ 小峯龍男 ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/6739/9784058116739_1_4.jpg?_ex=128x128)

![[3月中旬より発送予定][新品]呪術廻戦 (0-30巻 全巻) 全巻セット [入荷予約] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/mangazenkan/cabinet/syncip_0024/set-jyujyutsu_01.jpg?_ex=128x128)

![例解学習国語辞典 第十二版 オールカラー [ 金田一 京助 ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/7129/9784095017129_1_14.jpg?_ex=128x128)

![監禁王 7【電子書籍】[ あしもと☆よいか ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/4129/2000019774129.jpg?_ex=128x128)

![勇者パーティを追い出された器用貧乏 〜パーティ事情で付与術士をやっていた剣士、万能へと至る〜(18)【電子書籍】[ よねぞう ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/4315/2000019794315.jpg?_ex=128x128)

![いちねんせいえほん はじめての「よのなかルールブック」 [ 高濱正伸 ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1205/9784284001205_1_3.jpg?_ex=128x128)