ニュース

Panther Lakeの「Xe3 GPU」と「第5世代NPU」はどのぐらい性能が向上したのか

2025年10月9日 22:00

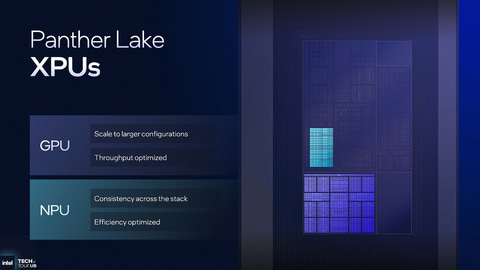

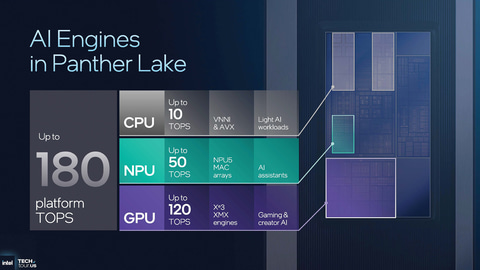

Intelは次世代Core UltraとなるPanther Lakeの技術的な詳細に関しての発表を行なった。その中でIntelは、Panther Lakeに採用されているGPU「Xe3」、NPUの「第5世代NPU」、ISPとなる「IPU7.5」の技術的な概要や詳細を明らかにした。

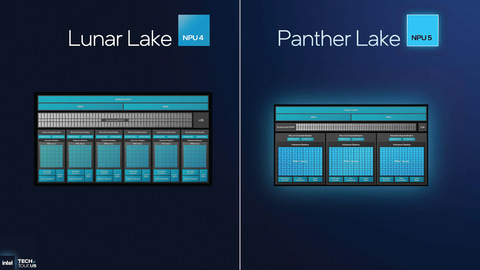

注目のGPUはIntelの内蔵/単体GPUアーキテクチャ「Xe」の第3世代となる「Xe3」へと進化し、製品のブランド名は「Intel Arc Bシリーズ」になることが明らかにされた。また、第5世代NPUは内部構造が改良され、Core Ultra 200V(Lunar Lake)に内蔵されていた第4世代NPUとほぼ同じ50TOPSの性能を実現しながら、性能あたりのダイ面積が40%小さくなるなど効率が大きく改善されている。

2020年のXe導入以降着実に進化してきたIntel GPU、内蔵GPUだけでなく外付けGPUにも発展

今回のPanther Lakeに搭載されているGPUは、Intelが「Xe3」と呼んでいる第3世代のXeアーキテクチャのGPUが採用されている。Intelは、2020年に発表した第11世代Core(Tiger Lake)世代で、新しいGPUアーキテクチャとしてXeを導入した。

従来のIntel GPUは内蔵GPUだけに特化しており、より大規模なGPUへの展開には適していなかった。そこで、Xeでは、内蔵GPUから単体GPUまでスケーラブルなアーキテクチャとして設計され、最初のXeとなったXe-LPはTiger Lakeの内蔵GPUに、そしてDG1と呼ばれる単体型はIris Xe Maxとして単体GPUとして投入された。

| Xe-LP/DG1 | Alchemist(Xe-HPG) | Xe-LPG(XMXなし) | Xe-LPG | Xe2 | Battlemage | Xe3(12Xeコア版) | Xe3(4Xeコア版) | |

|---|---|---|---|---|---|---|---|---|

| 採用されたSoC/dGPU | Tiger Lake/Alder Lake/Raptor Lake | Arc/Arc Pro Aシリーズ(dGPU) | Meteor Lake/Arrow Lake(H以外) | Arrow Lake-H | Lunar Lake | Arc/Arc Pro Bシリーズ(dGPU) | Panther Lake | Panther Lake |

| 導入年 | 2020年 | 2022年 | 2023年 | 2025年 | 2024年 | 2024年 | 2025年 | 2025年 |

| アーキテクチャ世代 | Xe | Xe(xxG版) | Xe(xxG版) | Xe(xxG版) | Xe2 | Xe2 | Xe3 | Xe3 |

| Xeコア/レンダースライス | 6コア | 4コア | 4コア | 4コア | 4コア | 4コア | 6コア | 2コア |

| レンダースライス/GPU全体 | 1 | 8 | 2 | 2 | 2 | 5 | 2 | 2 |

| Xeコア/GPU全体 | 6コア | 32 | 8コア | 8コア | 8コア | 20コア | 12コア | 4コア |

| HWレイトレーシング/レンダースライス | - | 4基 | 4基 | 4基 | 4基 | 4基 | 6基 | 2基 |

| HWレイトレーシング/GPU全体 | - | 32基 | 8基 | 8基 | 8基 | 20基 | 12基 | 4基 |

| ベクターエンジン(XeはEU)/Xeコア | 16 | 16 | 16 | 16 | 8 | 8 | 8 | 8 |

| ベクターエンジン(XeはEU)/GPU全体 | 96 | 512 | 128 | 128 | 64 | 160 | 96 | 32 |

| ベクターエンジンbit長 | 256bit | 256bit | 256bit | 256bit | 512bit | 512bit | 512bit | 512bit |

| ベクターエンジンALUネイティブSIMD型 | SIMD8 | SIMD8 | SIMD8 | SIMD8 | SIMD16 | SIMD16 | SIMD16 | SIMD16 |

| FP ALU・INT ALU/ベクターエンジン | 8 | 8 | 8 | 8 | 16 | 16 | 16 | 16 |

| FP ALU・INT ALU/GPU全体 | 768 | 4,096 | 1,024 | 1,024 | 1,024 | 2,560 | 1,536 | 512 |

| XMX/Xeコア | - | 16 | - | 16 | 8 | 8 | 8 | 8 |

| XMX/GPU全体 | - | 512 | - | 128 | 64 | 160 | 96 | 32 |

| ピークAI推論性能(INT8) | 非公開 | 275TOPS | 非公開 | 77TOPS | 67TOPS | 197TOPS | 120TOPS | 非公開 |

| シェアードL1/Xeコア | 128KB | 192KB | 192KB | 192KB | 192KB | 256KB | 256KB | 256KB |

| L2キャッシュ(最大) | 3.8MB | 16MB | 8MB | 8MB | 8MB | 18MB | 16MB | 4MB |

そのXe世代の改良版として投入されたのがAlchemist(ないしはXe-HPG)の開発コードネームで知られたGPUで、2022年に「Intel Arc Aシリーズ」として単体GPUとして投入された。そのAlchemistの内蔵GPU版として用意されたのがXe-LPGで、2023年に登場した初代Core Ultra(Meteor Lake)に、AI処理用のXMXなし版のXe-LPGが内蔵された。そして今年の1月に登場したCore Ultraシリーズ2のCore Ultra 200H(Arrow Lake-H)では、XMX機能を搭載したXe-LPGが採用されている。

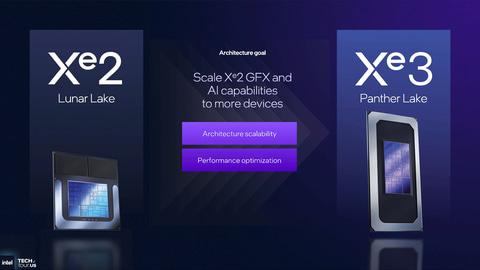

Xeの第2世代として投入されたのがXe2で、昨年(2024年)の9月に発表されたCore Ultra 200V(Lunar Lake)において、内蔵GPUとして採用されている。その後、昨年末にそのXe2のアーキテクチャを採用した単体GPU版として開発コードネームBattlemageが「Arc Bシリーズ」として発表され現在に至っている。

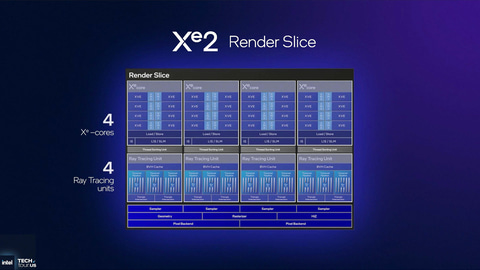

Xe2では、ベクターエンジンと呼ばれる内蔵エンジンのALUが、初代Xe世代のSIMD8からSIMD16に強化されており、初代XeではSIMD16で実行する場合には2つのXeコアを束ねて実行する必要があったが、Xe2ではSIMD16を1つのXeコアだけで処理することが可能になっており、処理効率が向上している。

Lunar Lakeに内蔵されていたXe2からエンジン数などが増やされているXe3

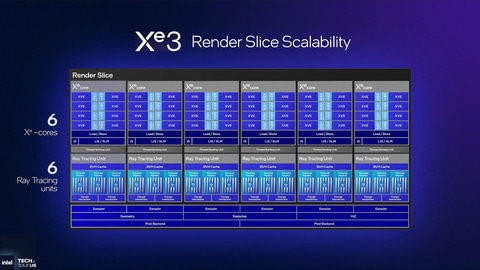

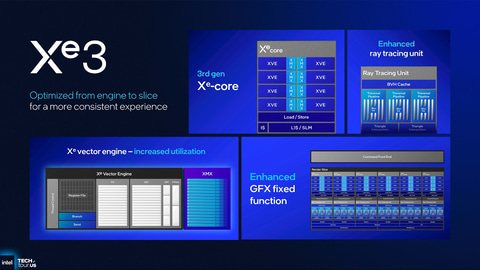

そのXe2の次の世代として用意されたのが今回のPanther Lakeで採用されているXe3となる。従来のXe2では、1つのレンダースライス(IntelではGPUを階層的に構築しているが、レンダースライス単位で増減したりすることが可能)に内蔵されているXeコアは最大4つになっていた。それに対して、Xe3ではそれが最大6つに増やされている。今回のXe3では最大構成として2レンダースライスの構成が用意されており、XeコアはGPU全体で最大12と、Lunar Lakeの最大8から強化されている。

| Xe2 | Xe3(12Xeコア版) | Xe3(4Xeコア版) | |

|---|---|---|---|

| 採用されたSoC/dGPU | Lunar Lake | Panther Lake | Panther Lake |

| アーキテクチャ世代 | Xe2 | Xe3 | Xe3 |

| Xeコア/レンダースライス | 4コア | 6コア | 2コア |

| レンダースライス/GPU全体 | 2 | 2 | 2 |

| Xeコア/GPU全体 | 8コア | 12コア | 4コア |

| HWレイトレーシング/レンダースライス | 4基 | 6基 | 2基 |

| HWレイトレーシング/GPU全体 | 8基 | 12基 | 4基 |

| ベクターエンジン(XeはEU)/Xeコア | 8 | 8 | 8 |

| ベクターエンジン(XeはEU)/GPU全体 | 64 | 96 | 32 |

| FP ALU、INT ALU/GPU全体 | 1,024 | 1,536 | 512 |

| XMX/GPU全体 | 64 | 96 | 32 |

| ピークAI推論性能(INT8) | 67TOPS | 120TOPS | 非公開 |

| シェアードL1/Xeコア | 192KB | 256KB | 256KB |

| L2キャッシュ(最大) | 8MB | 16MB | 4MB |

| 製造プロセスノード | TSMC N3B | TSMC N3E | Intel 3 |

また、Lunar LakeのXe2世代では192KBだったXeコア1つあたりの共有L1(要するにローカルメモリのこと)は、BattlemageのXe2コアと同様量の256KBに増やされている。また、L2キャッシュもLunar LakeのXe2の8MBと比較して最大16MBと倍増した。こうしたキャッシュ階層の改良は、メモリレイテンシの改善、さらにはメモリ帯域幅への圧迫を減らすという意味で大きな効果がある。

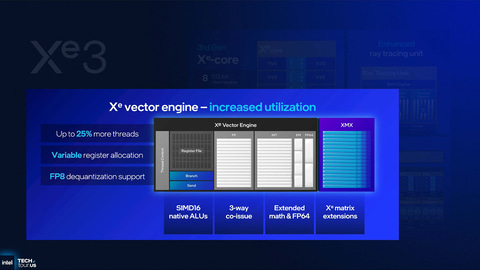

ただし、内部の演算器そのものの構造は、基本的にXe2世代と同じだ。具体的にはXe2で導入された512bitのベクターエンジンが8つある形になっており、内部ではSIMD16をネイティブでサポートするFP(浮動小数点)のALUとINT8(整数)のALU、XMXエンジンが1つ内蔵されているなどの構造は共通だ。

ただし、Xe2に比べて25%ほどより多くのスレッドが処理できるようになっていること、複数のレジスタアロケーションに対応すること、FP8への脱量子化などの改良が加えられており、実行処理の最適化が行なわれていると理解することができる。

また、グラフィックス関連の固定機能(新しいURBマネージャ、2倍の異方形フィルタリングエンジン、2倍のステンシルテストバッファ)の強化も行なわれており、演算器の強化に合わせてグラフィックス性能が向上する。

Xeコア数が最大で12コアになったことに伴い、XMXのユニット数も増えている。具体的にはLunar LakeのXe2の64に比べて96に増加しており、それに合わせてINT8を利用した場合のAI推論性能は120TOPSへと高速化されている。サポートされる精度はXe2と同じTF32、FP16/BF16、INT8、INT4、INT2となる。

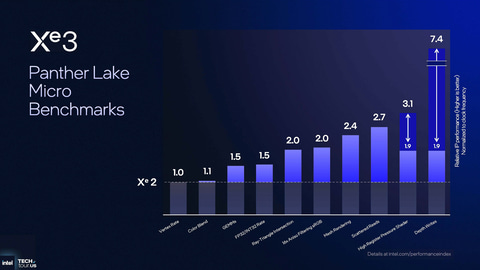

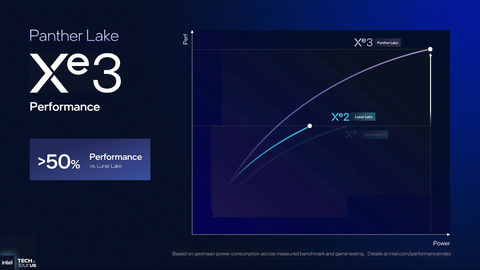

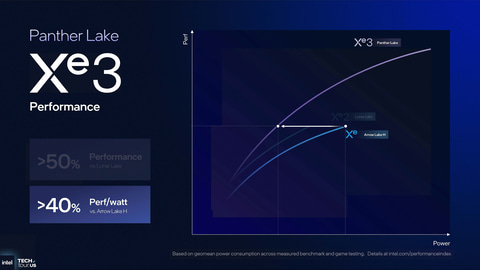

Intelは、Lunar LakeのXe2 GPUと比較して、シェーダの細かな処理能力が処理によっては最大で7.4倍になり、ゲームベンチなどによる性能が最大50%アップし、Arrow Lake-H(Xe-LPG)と同じ性能であれば電力が40%減るという性能になっていると説明している。

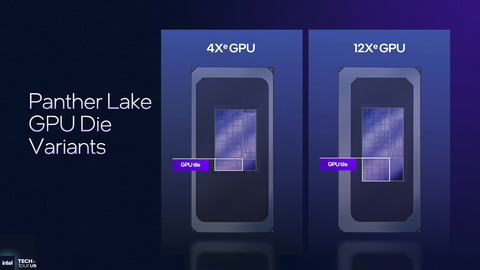

なお、今回IntelはPanther Lake向けのGPUを、グラフィックスタイルという単体のダイで製造し、Foverosを利用してパッケージ上で1つのSoCに統合している。

GPUのタイル(ダイ)は2種類用意されており、Xeコアが4基のタイルとXeコアが12基のタイルという2つが用意されている。前者はIntel 3で製造され、後者はTSMC N3Eというプロセスノードで製造されている。

第5世代NPUでは、内部構造の大幅変更により同じ性能を実現しつつ、より小さいダイ面積に

IntelのNPUは、元々は2016年にIntelが買収した「Movidius」のVPU(Visual Processing Unit)がベースになっている。MovidiusのVPUは、画像認識を低消費電力で行なうために開発したプロセッサで、Intelでは最初の世代(Myraid-X)、第2世代(Keem Bay)の2世代にわたって製品が投入された。

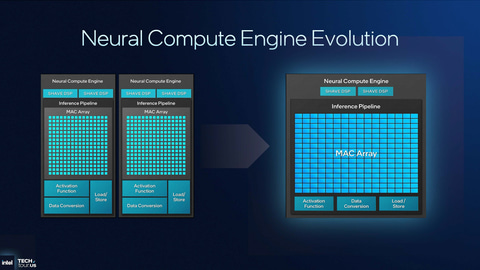

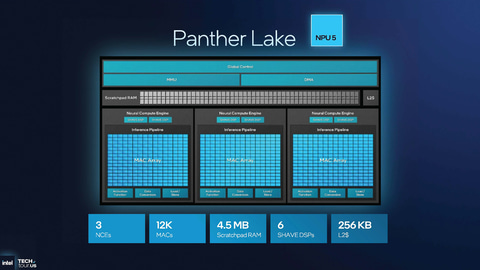

VPUは内部に行列乗法を効率よく行なうSHAVE DSPと多くのMAC(浮動小数点演算器と整数演算器を内蔵した演算器)から構成されているニューラルコンピュートエンジンなどを内部に備えており、Scratchpad RAMと呼ばれるローカルメモリ上にデータを展開することで、メモリアクセスを極限まで減らすことで低消費電力を実現する仕組みになっていた。

| 第3世代NPU | 第4世代NPU | 第5世代NPU | |

|---|---|---|---|

| ニューラルコンピュートエンジン | 2 | 6 | 3 |

| SHAVE DSP/ニューラルコンピュートエンジン | 2 | 2 | 2 |

| SHAVE DSP/NPU | 4 | 12 | 6 |

| MAC/ニューラルコンピュートエンジン | 2,000 | 2,000 | 4,000 |

| MAC/NPU | 4,000 | 1万2,000 | 1万2,000 |

| L2キャッシュ | 非公表 | 非公表 | 256KB |

| Scratchpad RAM | 4MB | 9MB | 4.5MB |

| 性能 | 11/13TOPS | 48TOPS | 50TOPS |

Intelが2023年に投入した初代Core Ultra(Meteor Lake)で採用した第3世代NPU(IntelのCPUに統合されるNPUとしては初めてだが、VPUの2世代から数えるとIntel NPUとしては第3世代になるため、第3世代NPUと呼ばれた)では、2基のニューラルコンピュートエンジンから構成されており、ピーク時の性能(INT8を利用しての演算時)がMeteor Lake用では11TOPS、24年に投入されたCore Ultraシリーズ2(Arrow Lake)では13TOPSの性能を実現した。

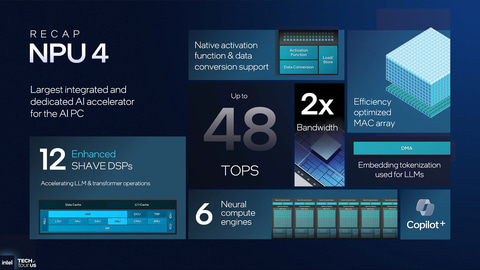

2024年に投入されたCore Ultraシリーズ2(Lunar Lake)では、第4世代NPUが投入された。この第4世代NPUではニューラルコンピュートエンジンが3倍の6基に増やされており、INT8を利用してのピーク性能が48TOPSと第3世代NPUの約4倍に強化されている。これによりMicrosoftのCopilot+ PCの要件(40TOPS以上の性能を持つNPU)を満たすことになった。

Panther LakeにはそのIntel NPUの最新世代となる第5世代NPUに強化されている。性能は50TOPSと、Lunar Lakeの48TOPSに比べて2TOPSしか増えていないように見えるが、内部のアーキテクチャに大きな手を入れることで、NPUとしての効率が向上している。

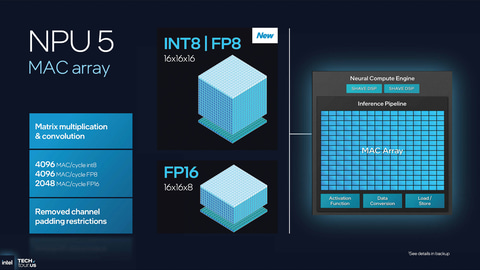

具体的には、今回の第5世代NPUでは、ニューラルコンピュートエンジンが第4世代の6基から3基へと半減されている。その代わりに、それぞれのニューラルコンピュートエンジンに内蔵されているMAC(FP/INTの演算器)は倍増されており、NPU全体でのMAC数は1万2,000基と同等だ。つまり、MACの切り方を変えたということになる。

それにより、行列演算を行なうSHAVE DSPの数は減っている。というのも、Intel NPUでは1つのニューラルコンピュートエンジンにつき2基のSHAVE DSPを内蔵していることになっているため、第4世代では12基だったDSPは、第5世代では6基と半減している。

また、それに合わせてローカルメモリとなるScratchpad RAMも半分の4.5MBに減らされている。それでも性能が向上していることからも分かるように、要するに第4世代の12基のDSPや9MBのScratchpad RAMは多すぎたということだろう。そのバランスをとったデザインになったのが第5世代NPUとなる。

無駄を削ぎ落としたことで、ダイ面積あたりのNPUの性能は40%向上している。つまりほぼ同じ性能を実現していながら、ダイサイズは40%小さいということを意味し、高効率なNPUになっている。

なお、Meteor LakeやArrow Lake世代では、第3世代NPUはTSMC N6(6nm)で製造されるSoCダイに置かれていたが、今回の第5世代NPUは、CPUと同じコンピュートタイルに置かれており、Intelの最新プロセスノードになるIntel 18Aで製造される。そうしたCPU用の最新ノードで製造されることも、電力効率の改善に大きな効果を与えていると考えられるし、Panther Lakeのすべての構成でCopilot+ PCの要件を満たすことになる。

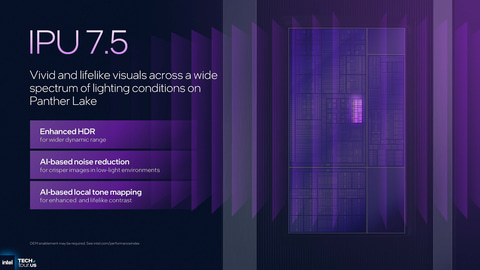

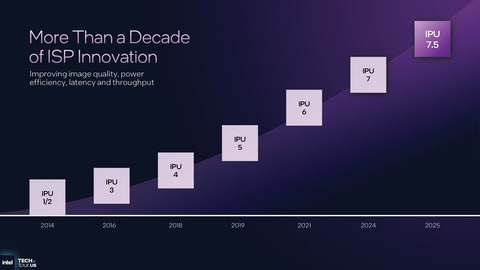

Lunar Lakeで導入されたISP「IPU7」がマイナーバージョンアップされてIPU7.5に

今回IntelはLunar Lakeで導入したISP(Image Signal Processor、IntelではISPのことをIPU=Image Processing Unitと呼んでいる)となるIPU7のマイナーバージョンアップを行なっている。

IntelのIPUはMicrosoftのSurfaceシリーズや、LenovoのThinkPadシリーズの一部モデルでISPとして利用されている。MIPI-CSI2という高速なシリアルバスでカメラ/CMOSセンサーと接続され、高画質な後処理を行なうのがISPの役割だ。

SoCに内蔵されているISPを利用しない場合には、通常カメラ側に単体型ISPが搭載され、それによりカメラのCMOSセンサーから入力されるRAWデータの後処理(RAWデータの色補正やJPEGやmp4などの圧縮形式へのリアルタイム変換)が行なわれる。

単体型ISPは、容量や速度が十分ではないローカルメモリや、そもそも内蔵されているDSP自体の性能が低いなどの理由で、十分な後処理が行なわれないため画像品質が低い。それに対してSoC内蔵型ISPは、高速なSoCのローカルメモリが使えるし、処理能力も単体型ISPに比べて圧倒的に高いため、高品質な動画や静止画として後処理をすることが可能になる。なお、SoC内蔵ISPのメリットに関しては以下の記事をご参照いただきたい。

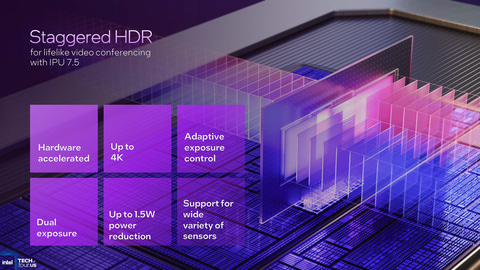

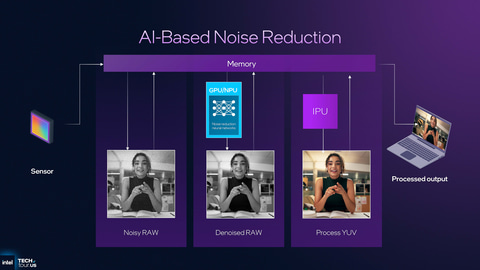

今回Panther Lakeに搭載されているIPU 7.5は、バージョンが浮動小数点以下のアップデートであることからも分かるように、IPU 7のマイナーバージョンアップ版となる。IPUのハードウェア(10bitの深度のIPUが3つ)の大枠は同じなのだが、HDRブレンダーエンジンが強化され、NPUやGPUなどを利用する機能が追加された小規模なアップデートとなる。

それによりHDRのダイナミックレンジがより広くなり、NPUやGPUなどを利用したAIベースのノイズリダクションやトーンマッピングが利用可能になっており、より高画質を実現することが可能になっている。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:2位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![ASUS エイスース 液晶ディスプレイ Eye Care [23.8型 / フルHD(1920×1080) / ワイド] VA249HG 製品画像:15位](https://thumbnail.image.rakuten.co.jp/@0_mall/r-kojima/cabinet/n0000001461/4711387795194_1.jpg?_ex=128x128)

![【エントリーで最大2万ポイント当たる|2/25まで】 ASUS|エイスース PCモニター Eye Care VA249HG [23.8型 /フルHD(1920×1080) /ワイド /120Hz] 製品画像:14位](https://thumbnail.image.rakuten.co.jp/@0_mall/biccamera/cabinet/product/12947/00000014147044_a01.jpg?_ex=128x128)

![棺桶まで歩こう (幻冬舎新書) [ 萬田緑平 ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/7937/9784344987937_1_3.jpg?_ex=128x128)

![SPY×FAMILY 17 (ジャンプコミックス) [ 遠藤 達哉 ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0092/9784088850092_1_6.jpg?_ex=128x128)

![[新品][全巻収納ダンボール本棚付]サザエさん (1-68巻 全巻) 全巻セット 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/mangazenkan/cabinet/syncip_0028/m5220421088_01.jpg?_ex=128x128)

![きのう何食べた?(25)【電子書籍】[ よしながふみ ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/0973/2000019710973.jpg?_ex=128x128)

![憤怒の人 母・佐藤愛子のカケラ [ 杉山 響子 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/8300/9784093898300_1_151.jpg?_ex=128x128)

![【楽天ブックス限定デジタル特典】レジンでつくる ときめき文具(3点セット(むぎまま直伝!BOOK未収録 作り方レシピ/ラブリーピンクのシール帳背景紙/うるつやシール用台紙)ダウンロード) (ガールズクラフト) [ Gakken ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9716/9784057509716_1_3.jpg?_ex=128x128)

![暁のヨナ YONA MEMORIAL イラスト集付き特装版 47 (マルチメディア商品) [ 草凪 みずほ ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/6494/9784592106494_1_2.jpg?_ex=128x128)

![木挽町のあだ討ち (新潮文庫) [ 永井 紗耶子 ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/8835/9784101028835_1_10.jpg?_ex=128x128)