笠原一輝のユビキタス情報局

「フィジカルAI」ってなんですか?iPhone/iPodに負けた日本の歴史を繰り返さないために

2026年1月22日 06:22

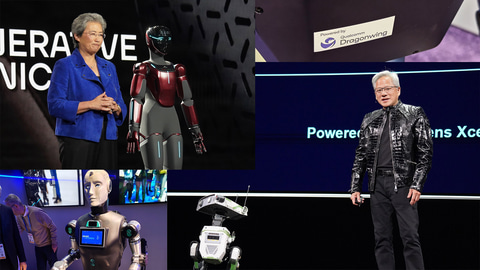

例年ITやデジタル業界がどこに向かおうとしているのか、CESはそのトレンドを指し示すものとして最も重要なイベントと言える。今年のCESの大きなテーマが「フィジカルAI」であったことは多くの人が指摘する通りだが、そのフィジカルAIは産業にとってどんな意味があり、自動車やロボットといった以前からある産業をどのように変えていこうとしているのだろうか?

そのキーワードになる言葉が2つある。1つは「Software Defined」(ソフトウェア定義)であり、もう1つが「AI Defined」(AI定義)だ。

フィジカルAIってどういう意味?

今回のCESで多くの人が「フィジカルAI、フィジカルAI」と叫んでいたが、そういう人に会うたびに「フィジカルAIってなんですか?」と問うと、「ヒューマノイドだ」とか「ロボットだ」とかいう答えが返ってくるのが定番だった。それは事の本質を何も示していない。

おのおのの回答を総合すると、以下の4つの特徴を、AIソフトウェアで実現しているもの、それを業界でフィジカルAIと呼んでいるのだ。

- 検知(Sense)

センサーを利用して周囲に何があるのか状況を把握する - 通信(Communicate)

セルラーやWi-Fi/BT、UWBなどを利用して周囲と通信して状況を相互に伝え合う - 考察(Think)

AIモデルのリーズニング機能を利用して、上記2つの情報を元に次に下す行動を決める - 行動(Act)

上記の行動決定に基づいて物理的な動作を行なう

「検知(Sense)」とはカメラやLiDAR、レーダーなどの各種のセンサーを利用して、自分の周囲の状況を把握することになる。

「通信(Communicate)」とは、セルラー(携帯電話網)通信、Wi-Fi/Bluetooth、UWBなどの各種のワイヤレス通信を利用して、周りにある別のデバイス(人間が持っているスマートフォンやほかのフィジカルAIデバイス)と通信して、お互いの状況(位置情報や今後の行動計画など)を相互に伝え合うことだ。

「考察(Think)」とは、検知や通信で集めた情報を元に、どういう動作をしたらよいのかを検討し、次に行なう行動計画を決定することだ。

そして最後の「行動(Act)」とは、その行動計画を具体的に実行することになる。この(1)~(4)を、非常に短い時間で何度も何度も低遅延で繰り返して実行していくことが、我々がフィジカルAIと呼んでいるデバイスの特徴になる。

たとえば、自動車の自動運転なら、カメラやLiDARなどの、センサーからの周辺の位置情報などを検知し、V2PやV2Vと呼ばれる通信プロトコルで歩行者のスマートフォンや車両と通信してお互いの情報を交換し、その情報をもとにどちらにハンドルを切るか、アクセルやブレーキを踏むかを考えて行動計画を作り、それを元にハンドルやアクセル、ブレーキを操作する……こうした一連の作業が行なわれる。

ロボットも同様で、カメラやLiDARなどのセンサーから周辺の位置情報を検知し、ほかのロボットと通信して自分の位置を把握し、その情報を元に二足歩行であれば足を動かす方向を決め、最後にその行動を実行する……。

フィジカルAIのCPUアーキテクチャで大きなシェアを持つArmで上席副社長兼フィジカルAI事業部事業部長を務めるドルゥー・ヘンリー氏は「自動車であろうが、ロボットであろうが、飛行機であろうが、演算装置から見たフィジカルAIデバイスはみな等価だ」と指摘している。だから、なんでもAIを使って自律的に動くモノはすべてフィジカルAIと呼んでいいということになる。

ここ数年のCESを象徴してきた「Software Defined」によるイノベーションの加速

多くの人は「そうは言うけれど、これまでだって自動運転の自動車も、ロボットもあったじゃん。何が違うの?」と思われるだろう。たとえば、レベル2(最近はレベル2+とかレベル2++とかも登場してわけが分からないことになっているが)の自動運転(いわゆるADAS)などは、実際のところ前述した4つのことを実現している。工場で使われている産業用ロボットなどもそうだ。

では、今ブームになっているフィジカルAIとそれらの自動運転自動車やロボットとは何が違うのだろうか?もうここまで来ればお分かりだと思うが、その鍵になるのが生成AIに代表されるようなモダンなAIモデルにより、特に(3)考慮の質が格段に向上し、それに伴って(4)行動も正確になる、このため自動運転が本格的に実現し、人間のような動きをするヒューマノイドロボットが現実的になってきているからだ。

こうしたAIの導入の前、自動車業界やロボット業界は、英語でいうとSoftware Defined、日本語にするとソフトウェア定義と呼ばれる環境に移行を進めてきた。自動車であれば、それがSDV(Software Defined Vehicle)と呼ばれるもので、簡単にいうと、PCやスマートフォンで採用されているようなSoCとソフトウェアを組み合わせることで、自動車を実現しようという取り組みだ。

SDV以前の自動車は、それぞれの部位において、マイクロコントローラユニット(MCU)とアナログ回路の組み合わせで実現されてきた。このMCUはデジタル回路で、ソフトウェアで動作しているが、ソフトウェアといってもファームウェアに近いモノだと考えてよい。

しかし、SDVでは、PCやスマートフォンで採用されているような、強力なSoCの車載版(具体的には耐用年数や稼働保証温度などを自動車向けに拡張したバージョン)が1つないしは複数搭載され、それをPCやスマートフォンに近いOS(こちらも車載版にカスタマイズしたもの)やアプリケーションを走らせ、車両のほぼすべてをこのSoCとソフトウェア(OS+アプリケーション)で制御する形になる。誤解を恐れずにいえば、スマートフォンのアーキテクチャがそのまま自動車の制御に使われているもの、それがSDVだといっても過言ではない。

こうしたSDVに進化するメリットは、従来のハードウェアだけで構成されている自動車に比べるとイノベーションの頻度が上がることだ。ハードウェアだけで構成されている自動車の場合、ハードウェアを更新しなければ新しい機能やユーザー体験は提供できない。

つまり、自動車の製品としてのライフサイクル(4年~6年、場合によっては10年)の間に一度(フルモデルチェンジの時)しかイノベーションは起こらない。しかし、SDVではスマートフォンやPCのOSがそうであるように、1年に1度OSが更新されて新しい機能が追加される。また、アプリケーションを追加すれば、それこそ数日のうちに新しいイノベーションが起こる……それが自動車がSDVに進化するときのメリットといえる。

ここ数年のCESで起きていた既存の産業がイノベーションを紹介するというトレンドの本質はまさにこの「Software Defined」にある。

伝統的な農機メーカーのジョンディアやクボタなどが農機をCESに出展したり、化粧品メーカーのロレアルが基調講演に登場したり、というこれまでデジタルに関係のなかった産業がCESに進出してきているのはこうしたSoftware Definedの応用例なのだ(クラウドベースかローカルかという違いはあるが……)。

Software DefinedがAI Definedに進化。NVIDIAは多数の発表とデモを行なう

そのSoftware Definedの延長線上にあるのが、今のAIベースのフィジカルAIということになる。

Armのヘンリー氏は「今やフィジカルAIはSoftware Definedからさらに進化してAI Definedになっていることがその最大の特徴だ」と指摘する。Software DefinedからAI Definedへ、そうした大きな流れがあることで、フィジカルAIによる自動運転自動車、ロボット、自動運転飛行機、自動運転農機……そうしたものが何もかも現実になりつつある、それがフィジカルAIブームの本質だ。

従来のソフトウェアにも、CV(Computer Vision、画像認識)などのAIは使われていた。しかし、(3)考慮や(4)行動といった部分にはAIはほとんど使われてこなかった。というよりも、AIソフトウェアの機能がまだまだ十分でなく、半導体の性能も十分ではないため、なかなか実現が難しかったという側面が強かったのだ。

だが、今ソフトウェアがトランスフォーマーモデルのような強力なAIモデルで大きく進化したのとタイミングを合わせるかのように、SoC側の処理能力も上がり続けている。

たとえば、NVIDIAが出荷を明らかにしたNVIDIA AGX ThorはINT8で1,000TOPS、FP4を利用した場合には2,000TOPSという性能を実現している(Thorにはロボットや組み込み向けのJetson Thorも用意されており、そちらも同性能を発揮する)。

NVIDIAは言うまでもなくこうしたAI向けの半導体のリーダーで、Software Definedな自動車やロボットで多くの採用事例がある。NVIDIAの強みは、CUDAだといわれることが多いが、こうした組み込み向けでは半分は正しくて半分は正しくない。

NVIDIAの組み込み市場での強みは、CUDAはCUDAでもCUDA-Xと呼ばれるドメインスペシフィック(領域特化)のソフトウェア開発キットを用意していることだ。自動車向けであれば「Drive」だし、ロボットであれば「Isaac」になる。そうした領域に特化したソフトウェア開発キットを産業別に用意しており、それを使えばソフトウェアの経験があまりないような伝統企業でも、AIを利用したデバイスの開発ができる、これがNVIDIAの強みだし、多くの事業会社がNVIDIAを選択する理由になっている。

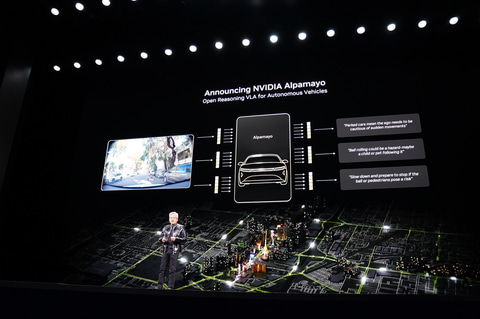

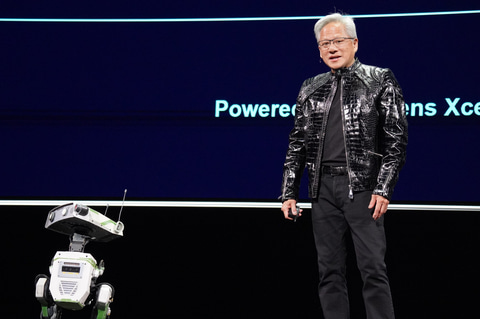

今回NVIDIAは、同社CEOのジェンスン・フアン氏が行なった講演の中で、自動車向けの領域特化型のフィジカルAIモデルとなる「Alpamayo」(アルパマイヨ)を発表している。

Alpamayoは自動車に特化したリーズニングAIモデルで、筆者のフィジカルAIの定義でいうところの(3)考慮の部分を強化するAIモデルだ。自動車メーカーはAlpamayoを利用することで、より適切に判断することが可能なAIソフトウェアを構築することが可能になる。

こうした領域特化の開発ソフトウェア、さらにはAIモデルそのものをリリースするというところがNVIDIAのAIソリューションの強みであることは明白で、多くの事業会社がNVIDIAの門をたたいているという現状もさもありなんとしか言いようがないのが現状だ。

NVIDIAを追いかけるAMD、Intel、QualcommはいずれもフィジカルAI向けの新製品を展示

もちろん、NVIDIAに対抗するAMD、Intel、Qualcommなども黙って指をくわえているわけではない。AMDは、CEO リサ・スー氏が行なった前日基調講演の中で、「AMD Ryzen AI Embedded P100」「AMD Ryzen AI Embedded X100」を発表している。いずれもZen 5 CPU、RDNA 3.5のGPU、XDNA2 NPUを搭載とされており、平たくいえば「Ryzen AI 300/400シリーズ」の組み込み版という製品になる。

P100が自動車向けで、X100がロボットなどのフィジカルAI向けとなる。実はAMDの組み込み向け製品は自動車向けで採用が進んでおり、その代表的なOEMメーカーは米国のEVメーカー「Tesla」になる。

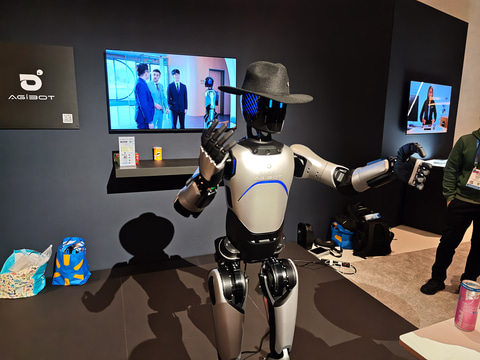

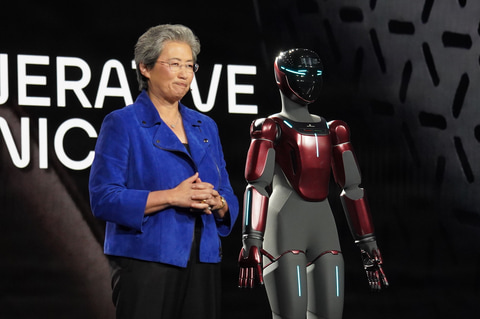

今回スーCEOは、基調講演の中でこうしたAMDのx86プロセッサを利用したフィジカルAIの具体例として米国のメーカー「Generative Bionics」社のヒューマノイド型ロボット「GENE.01」を紹介し、注目を集めた。

Intelは、同社がCES 2026で正式に発表したCore Ultraシリーズ3(開発コードネーム: Panther Lake)の組み込み向け版となる「Core Ultraシリーズ3 for Edge」を発表した。

Core Ultraシリーズ3は、電力効率に優れたCPUとGPU、さらにはNPUを搭載しており、(あくまでPC向けの最高スペックではあるが)GPUが最大122TOPS、NPUが最大50TOPSとなる。両方を合わせて使うことにより高いAI推論性能を実現している。

そうした特徴を受け継いでいるCore Ultraシリーズ3 for Edgeは、たとえばバッテリで動作するロボットなど、ピーク性能と同時に電力効率が求められるアプリケーションに向いていると考えられる。

今回Intelは同社ブースで、Oversonic Robotics が試作した「RoBee」と呼ばれるCore Ultraシリーズ3 for Edgeを搭載したロボットを公開して注目を集めた。

Qualcommは、CESに合わせてDragonwing IQ9の後継となるDragonwing IQ10を発表している。

Dragonwing IQ10は、第3世代Oryon CPU(18コアCPU)、Adreno GPU、700TOPS(INT8)のNPUというスペックで、PC向けのSnapdragonに採用されている第3世代Oryonなどを受け継ぎながら、NPUが強化されており、700TOPSのピーク性能を実現することが特徴だ。

。

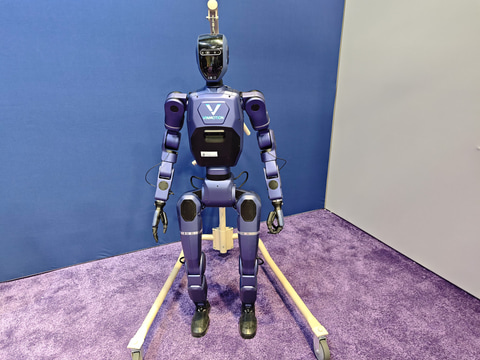

今回Qualcommは同社のブースでDragonwing IQ9を搭載したVinMotion社のヒューマノイドロボットや、Dragonwing IQ10の開発キットを利用したロボットアームなどの展示を行なった。

これらNVIDIAを追いかける3社にとっての課題は、NVIDIAの強みの逆になる。つまり、特定領域のAIソフトウェア開発キットをいかにして充実させるかだ。すでにNVIDIAはこの領域で5年~10年は先行しており、そこにしっかりと投資をして追い付けるか、それが今後各社に問われることになる。

いつか見てきた敗戦のパターンを繰り返さないために

このように、CESでのフィジカルAIを見ていると、筆者は「いつか見てきた光景」を思いださざるをえなかった。それは、こうしたSoftware Definedで産業が転換していくときに、日本のブランドが海外のブランドに置きかえられてきた光景だ。というのも、AFEERAの発売をアピールしたソニー・ホンダモビリティを除けば、日本のロボットメーカーや自動車メーカーの存在感は今回ほとんどなかったからだ。

それこそ古くはポータブルオーディオプレイヤーで一世を風靡した日本のオーディオメーカーが、Software DefinedのデバイスであるiPodに置きかえられていった歴史もそうだし、いわゆるガラケー(フィーチャーフォン)で一世を風靡した日本の携帯電話メーカーが、スマートフォンでAppleとSamsungに置きかえられて消えていった歴史などを振り返るまでもなく、Software Definedになるということは、参入障壁が下がることと同義でもあり、ブランドが入れ替わるタイミングにもなってきたのがデジタル産業の歴史だ。

そうした時代に生き残れるのはAppleのようにiPhoneのような革新的な製品を出して自らイノベーションを起こしにいくか、Samsungのように規模に焦点を当てるか、あるいはMicrosoftやGoogleのようにプラットフォームに特化するか、そのいずれかでしかない。

今わが国の自動車やロボットは競争力がある産業となっているが、仮にそこがSoftware Definedに、さらにこれからはAI Definedになっていくのだとすれば、普通の戦い方をしているだけだと、後から来た人に追い越されていくことになりかねないのではないかという懸念をCESで感じた。

筆者個人としては、日本の自動車メーカーやロボットのメーカーにはAI Defined時代にも生き残っていけるだけの体力も、技術もあると感じている。そこに付け加えて必要なことは、昨日までのしがらみは忘れて、AIファーストな開発体制を作ることだ。そしてAppleのiPhoneがそうであったように、過去を否定するような新しいイノベーションを産業にもたらすことだ。

その意味では、日本の自動車メーカーも、ロボットメーカーも、主役になれるような発表をぜひ来年のCESで行なってほしい、そう感じたことを最後に付け加えて、この記事のまとめとしたい。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:4位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![DELL Inspiron 24 5420 AI57-DNHBW [ 23.8in | FHD | Core i5-1335U | 8GB | 512GB | Win11 Home | Office | パールホワイト ] 製品画像:5位](https://thumbnail.image.rakuten.co.jp/@0_mall/rikusyouya/cabinet/08374965/10304062/11890408/01.jpg?_ex=128x128)

![【中古】BENQ◆液晶モニタ・液晶ディスプレイ GW2265HM [21.5インチ グロッシーブラック]【パソコン】 製品画像:17位](https://thumbnail.image.rakuten.co.jp/@0_mall/jumblestore/cabinet/74747/2320423374747-01.jpg?_ex=128x128)

![WINTEN モバイルモニター 15.6インチ テレワーク/デュアルモニター/サブモニターに最適!ゲーミング 1080P FHD IPSパネル 軽量 薄型 非光沢 カバー付 ミニPC Switch iPhone Type-C/HDMI接続 [1年保証] WT-156H2-BS 5523 製品画像:13位](https://thumbnail.image.rakuten.co.jp/@0_mall/win10/cabinet/monitor/imgrc0112809238.jpg?_ex=128x128)

![日経エンタテインメント! 2026年4月号 [雑誌]【電子書籍】 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/6809/2000019876809.jpg?_ex=128x128)

![デコピンのとくべつないちにち (単行本 608) [ 大谷 翔平 ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9368/9784591189368.jpg?_ex=128x128)

![魔男のイチ 7【電子書籍】[ 西修 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/1602/2000019641602.jpg?_ex=128x128)

![小学一年生 2026年 4月号 [雑誌] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0466/4912010010466_1_2.jpg?_ex=128x128)

![赤本手帳(2027年度受験用)コンパクト[ネイビー] [ 教学社編集部 ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2915/9784325272915_1_2.jpg?_ex=128x128)

![Mono Max 2026年 4月号 [雑誌] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0467/4912187490467.gif?_ex=128x128)

![ハイキュー!! 全巻セット(1-45巻) (ジャンプコミックス) [ 古舘春一 ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9450/2100012429450.jpg?_ex=128x128)