西川和久の不定期コラム

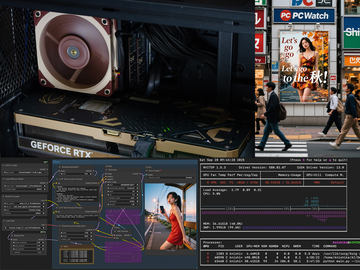

やってしまった。職人にお願いして「GeForce RTX 4090」を48GBへ魔改造!

2025年11月12日 06:04

9月に記事にしたGeForce RTX 5090(32GB)AIPCの調子が良く、GeForce RTX 4090(24GB)AIPCの出番が減ったこともあり、思い切って48GBへ改造することにした。今回はその話を書いてみたい。

元々GeForce RTX 4090(24GB)AIPCの用途は!?

9月に掲載したGeForce RTX 5090(32GB)AIPCのマザーボード入替記事、その後調子よく動いており、生成AI画像/動画についてはこればかり使うようになってしまった。やはり本気を出したGeForce RTX 5090(32GB)は速い!このようなこともあり、記事の最後に書いた、

“こうなるとGeForce RTX 4090の出番が減っており、VRAM 24GBを48GBに改造する職人を国内で見つけたのでやってみようかな!?と思ってみたり”

を真剣に考えるように……。

このGeForce RTX 4090(24GB)を搭載したAIPCの用途なのだが、実はUSB4接続のGeForce RTX 3090(24GB)もあり、デュアルGPU構成になっている。GeForce RTX 4090(24GB)側を生成AI画像/動画、GeForce RTX 3090(24GB)側をLM Studio(主にgpt-oss-20b)でと、同じPC内にありながら分けて使っていた。

というのも、生成AI画像/動画に関してはマルチGPUをうまく活用する手段がなく、また仮に動いたとしても遅い方=GeForce RTX 3090(24GB)に速度が引っ張られるため、メリットがないのだ。

逆にLM StudioなどLLM系、そしてsd-scriptsなど学習系は、速度が遅い方に引っ張られるのは変わらないものの、VRAMに関しては合算して使用可能になり、特に前者は、パラメータ数のより大きいLLMがVRAMに収まるためメリットが大きい。

今ならGeForce RTX 4090(24GB)を中古で売りに出しても結構な価格になるため、あまり使わないならいっそ……とも考えたが、思い切って48GB化する改造に出すことにした。

製品の改造をどう思うか?は個人差があると思うが、筆者は昔からアンプなどのコンデンサ、DAC、電源を付け替えるという改造を頻繁にやってたこともあり、あまり抵抗がなかったりする。

GeForce RTX 4090(24GB)を48GBにする方法

初めてXでGeForce RTX 4090(24GB)を48GBに改造する投稿を見かけたのは、GeForce RTX 5090(32GB)の出荷前辺りだろうか?(つまり2025年初)。内容的には高価なGeForce RTX 5090(32GB)よりGeForce RTX 4090(24GB)を48GBにした方がいいよ!(笑)的な内容。中国で改造可能なようだった。

当初は本当なのか?も含め半信半疑で眺めていたし、本当に可能だとしても、さすがにGeForce RTX 4090(24GB)を中国に送る勇気もない。

このような前ぶりがあったところに夏頃、Xで見かけたのが同じくGeForce RTX 4090(24GB)の48GB化の投稿。しかも場所は東京近郊。であればできるな!と思ったのが先の記事を書いた9月末頃の話となる。アカウントは以下の通り。

投稿を眺めていると主にGPUボードの修理がメイン。いろいろ故障したGPUとその対処方法が掲載されており、これはこれで興味深い。

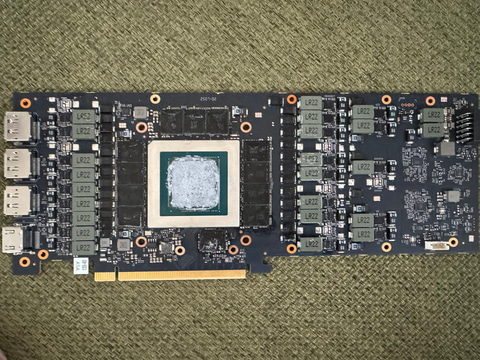

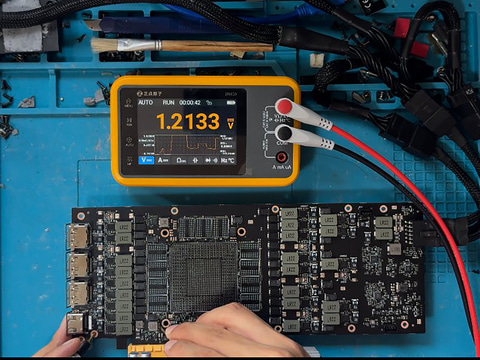

48GB化に関しては、元の基板からGPUとVRAM、EEPROMを外し、48GBに対応している別の基板へ乗せ替える……っといった荒技だ。内容的にとても素人ができるものではなく、職人という言葉がピッタリだったりする。

早速DMして価格を尋ねると、基板、+24GB VRAM、ブロワー型のクーラー、改造費……含めて10万円(送料着払い/1カ月補償あり)。それなら!ということで発送、記事にする許諾を頂き、作業中の写真を何枚か送ってもらえることにもなった。

通常数日~1週間とのことだったが、たまたま先方が手狭で引越しする直前に送ったこともあり、2週間ほどかかったものの、無事、連休明けに到着した。

48GBになって戻ってきたGeForce RTX 4090は、元とは全く異なる形状でサーバー用っぽい雰囲気になっている。また幅も2スロットと狭く、3つあったファンが1つに。周囲の艶消し黒フレームが金属製でズッシリ重い。個人的にはこちらの方がカッコよく好みだったりする(笑)。

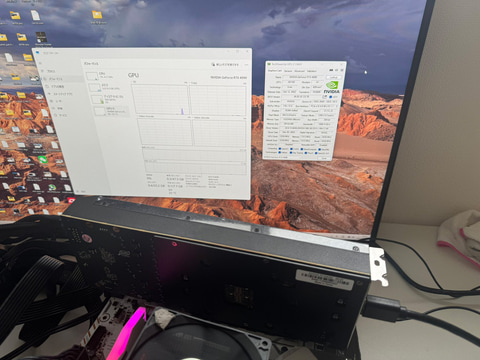

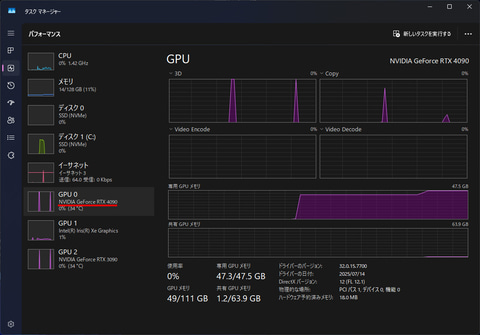

まず作動確認でnvidia-smiとタスクマネージャー。確かに48GBに!発熱、ファンの音、安定性などはこの時点では不明だが、問題なく動いている。さっそく主な用途と思われる2つのパターンを試してみた。

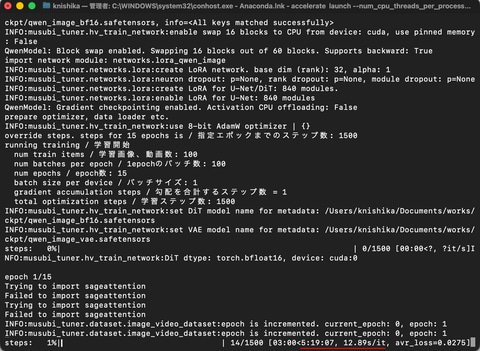

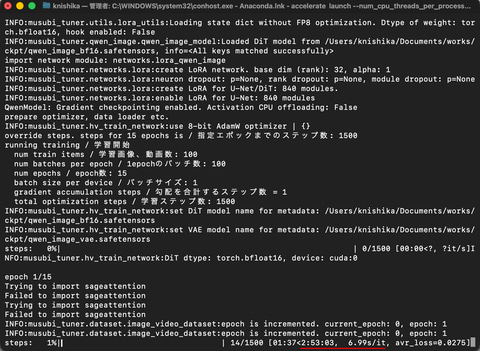

単独GPU。48GBでkohya-ss/musubi-tunerを使ったLoRA学習のかかる時間差

Qwen-ImageのLoRAを学習する時に使うのがこのmusubi-tuner。少ないVRAMでも学習できるよう、Block to Swapというオプションがあり、VRAM容量との関係は以下の通り。

options VRAM Usage

no 42GB

--fp8_base --fp8_scaled 30GB

+ --blocks_to_swap 16 24GB

+ --blocks_to_swap 45 12GB

つまり、24GBの時には--fp8_base --fp8_scaled --blocks_to_swap 16とする必要があったが、48GBになるとなしでOKということだ。仕掛け的に、不足部分はメインメモリを使っているため、このBlock to Swapがなしだと速度向上が見込まれる。

実際このオプションの有無で比較すると、ご覧のように、ありだと5時間19分かかるところが(1,024×1,024の画像10枚、1,500steps)、なしだと2時間53分へと学習時間が大幅に短縮されているのが分かる。予想通り効果てきめん!これでLoRA学習の効率が上がる。

欠点としては、GPUの温度は60℃ほどで収まっているものの、小型のファンが思いっきり回るため、かなり煩くなることだろうか。

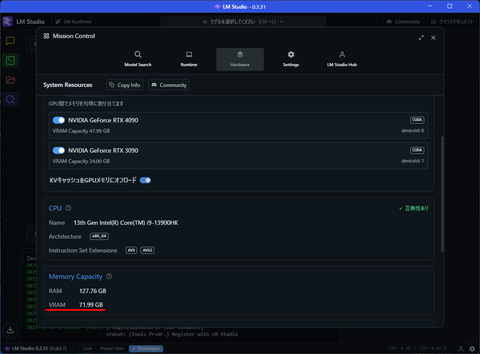

デュアルGPU。LM Studio + gpt-oss-120bが120.47tok/s!?

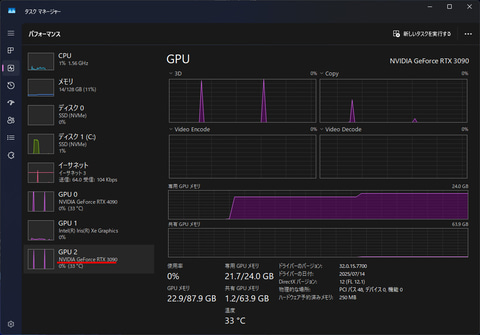

冒頭で書いた通り、このAIPCはUSB4接続だがGeForce RTX 3090(24GB)も接続されており、GeForce RTX 4090(48GB)とのデュアルGPU構成となっている。この場合、LM StudioなどLLM系に関しては合算して72GBとして使用可能となる(速度は遅いGPU側に引っ張られる)。

LM Studioの設定→ハードウェアを見ると、GeForce RTX 3090とGeForce RTX 4090が認識されVRAMは合計71.99GB使用可能に。

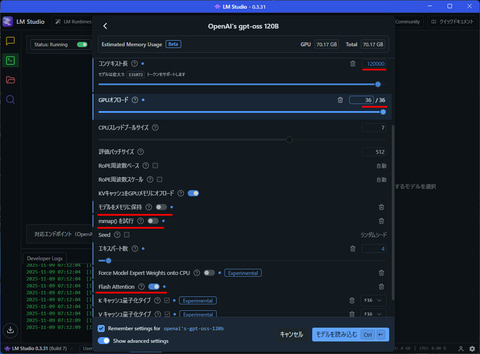

gpt-oss-120b ロード時の設定で変更するところは、

- コンテキスト長: 120000(最大ではVRAMを溢れるため)

- GPUオフロード: 36/36

- モデルをメモリに保持: OFF

- mmap()を試行: OFF

- Flash Attention: ON(以下2つも)

となる。コンテキスト長に関しては、あと少しVRAMがあれば最大で行けそうなだけにこの点だけは残念。とは言え、131,072と120,000なので大差ないと言えば大差ない。ロードが終わると、

GeForce RTX 4090は47.3GB使用、GeForce RTX 3090は21.7GB使用していることが確認できる。ほぼギリギリVRAMへ収まっているのが分かる。

さて肝心の速度であるが、何と120.47tok/s!!! M4 Max 128GBの70tok/sを軽く超えてしまった。動画からも分かるように爆速♪これだけのために10万円は価値があると言える(笑)。

参考までに、RTX PRO 6000 Blackwell(96GB)だと170tok/s以上出るとのこと。さすがに価格だけのことはある。

ファンのノイズに関しては、LLMや1枚程度の画像生成であればGPUへの負荷も少なく全く気にならないレベル。動画生成だと連続作動になるためやはり煩くなる印象。

既にGeForce RTX 3090とGeForce RTX 4090(24GB)を所有しており、加えて+10万円なら何とか……とは思うが、新たに購入しての改造となると約40万円(30万円+10万円)。一気だとかなりの出費になるため、内容の割に安いか?高いか?は状況にもよるといったところか。それ以前に新規の場合、GeForce RTX 4090(24GB)を入手できるのか!? という問題もあるだろう。

以上、24GBのGeForce RTX 4090を48GBに改造した結果などをご紹介した。予想通りLoRAの学習が速くなり、gpt-oss-120bは爆速へ。非常に満足度の高いものとなった。

とはいえこの件については当然メーカー保証は効かなくなり、中古で売れない、ドライバのアップデートで動かなくなる可能性、最悪何かの事故に繋がるパターンもあるだろう。ウルトラハイリスクだが、ハイリターンと言うのが今回の改造となる。筆者も編集部も保証しないので自己責任でお願いしたい。

一時、RTX PRO 6000 Blackwell(約150万円)やRTX PRO 5000 Blackwell(約80万円)も考えたのだが、VRAMは96GBか48GBだ。生成AI画像/動画ではめったに48GB超えは必要ない。LLMだとさらに多い128/256/512GBが欲しくなるところで、それならMac Studio/M3 Ultraで約60/90/150万円という選択肢が生まれるが、今はApple M5 Ultra登場の噂があり、今からApple M3 Ultraを買うのか?という悩みも生まれる。

とは言え、いずれにしても安易に手が出せる価格帯ではなく、これでいったん筆者のGPU増強計画は終わりとしたい。のだが、DGX Spark(互換機)をどうするか……(笑)!?

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:2位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![黒/白2色 楽天1位!384冠!モニター 23.8インチ 27インチ 200Hz/180Hz/165Hz/100Hz ゲーミングモニター 1ms応答 pcモニター パソコン モニター 非光沢 VA チルト VESA Freesync スピーカー内蔵[1+1年保証] cocopar 製品画像:7位](https://thumbnail.image.rakuten.co.jp/@0_mall/qifeng/cabinet/09826274/09826275/imgrc0105783334.jpg?_ex=128x128)

![ONE PIECE 114 (ジャンプコミックス) [ 尾田 栄一郎 ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0191/9784088850191.gif?_ex=128x128)

![【初回出荷特典付】刀剣乱舞ONLINE十周年記念 本丸録 [ 小学館集英社プロダクション ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/4731/9784796874731_1_3.jpg?_ex=128x128)

![2025-2026年版 1級FP技能士(学科)合格テキスト (2025-2026年版 国家資格ファイナンシャル・プランニング技能検定1級受検対策シリーズ) [ ファイナンシャル・プランニング技能検定研究会 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1302/9784828311302_1_65.jpg?_ex=128x128)

![暁のヨナ【通常版】 47【電子書籍】[ 草凪みずほ ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/7161/2000019737161.jpg?_ex=128x128)

![新書太閤記全十一冊合本版【電子書籍】[ 吉川英治 ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/1920/2000001641920.jpg?_ex=128x128)

![対訳J.S.バッハ声楽全集新装版 [ 若林敦盛 ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0217/9784863300217.jpg?_ex=128x128)