イベントレポート

「AMDやIntelもNVLink Fusionを使いたいなら歓迎」フアンCEO

2025年5月28日 15:45

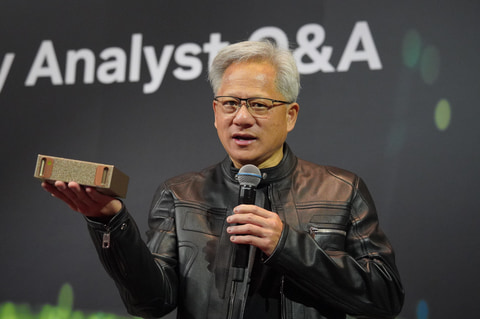

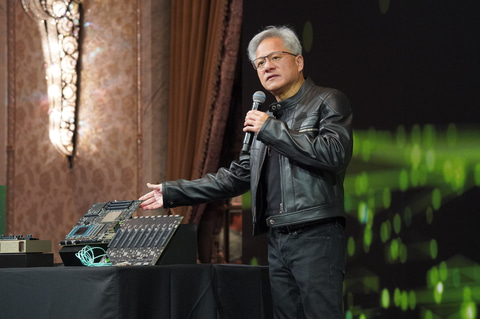

NVIDIAは、5月20日から台湾・台北市で開催された最大級のAI展示会COMPUTEX TAIPEI 2025に参加。そして21日からは、年次イベント「GTC」の台湾版を開催。それに並行する形で、報道関係者向けにはCEOのジェンスン・フアン氏による質疑応答が行なわれた。

AIデータセンターはNVIDIA GPUのアップグレードで電力効率を年々改善できる

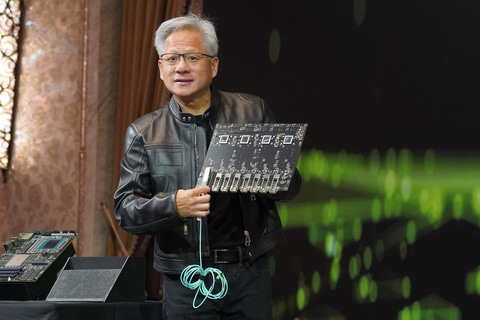

フアン (質疑応答の会場に展示されているNVIDIAのAIデータセンター向けハードウェアを示しながら)今回、AIファウンドリ向けのさまざまな製品を発表した。GB300、GB200、NVLink Switch、800Gb/sのネットワークなどなどをGTCで発表した。そして、このHGXではx86プロセッサも搭載しており、RedHat、VMwareのような今日企業が実行するソフトウェアがすべて動作する。

また今回は「RTX Pro Server」を発表した。これは8基のRTX Proを搭載しており、Omniverseでデジタルツインを実現したりできる。我々はこれらのハードウェアで、企業がAIクラウドやAIスーパーコンピュータを構築することを手助けしたいと考えている。

――エンタープライズ市場は非常に重要で、AI PCのようなエッジ市場も今は重要になりつつある。NVIDIAがそうした市場で実現しようとしていることは何か?

フアン 昨夜MicrosoftはWindows AI FoundryとWindows MLに関する構想を発表した。そして、彼らはそれがNVIDIAのハードウェアで動作すると明らかにしたのだ。Windows MLを利用すると、Windows上でAIのプログラムを実行することができる。NVIDIAのRTXにはCUDAコアとTensorコアがあり、それはどちらもAIを実行することができるからだ。

我々は既に、ゲーマーとPCユーザー、ワークステーションユーザーなど数億人のRTXユーザーを持っており、そうしたRTX PCでWindows MLが実行されAIアプリケーションを開発し、実行することが可能になるのだ。

開発者の場合には、DGX SparkやDGX Stationといった独自のAIスーパーコンピュータを提供している。これを利用すれば、クラウドサービスを利用して、利用が完了したらシャットダウンするなどという作業は必要なくなる。それらすべてをご自分の机の上で行なうことができるのだ。使われているPCがMacbookであろうが、Chromebookであろうが、Linuxであろうが、Windowsであろうが問題はない。すべての端末からWi-Fiや有線ネットワークを通じて利用できるのだ。

――DGX Sparkなどで追加の色を投入したりする計画はあるか?

フアン DGX Sparkは美しいデザインだと考えている。そしてこのスーパーコンピュータが必要になるのは、一貫性があり生産性の高いAI開発環境がいるからだ。

既存のコンピュータ、たとえばみなさんがお使いのモバイルノートPCなどが端的な例だが、AIスタックを実行するのに十分なメモリもないし、Tensorコアもない。そうした既存のコンピュータからネットワーク経由で接続してAIスタックを実行する、それがDGX Sparkだ。これにより従来はクラウドにしかなかったAIスーパーコンピュータが皆さんの部屋に置くことが可能になる。おそらくこれを6カ月も使っていただければ、投資を十分回収できるだろう。

これはASUSやMSIといった台湾のメーカーから入手できる。エンタープライズの開発者はもちろんこと、すべての開発者がこれを1つ手に入れてもらい、机の隣に置けば、そこだけで開発を完結できる。さらにそれをスケールアウトしたり、クラウドとつないでより大規模なデータセットでテストすることもできる。まさに理想的なAI開発の環境だ。

――NVIDIAは現在AIスーパーコンピュータで成功を収めているが、その一方破棄されたプロジェクトもある

フアン NVIDIAがプロジェクトを完全に殺してしまうことが希なことだ。しかし、場合によってはプロジェクトの途中で方針転換をする場合もある。

たとえば、Omniverseの初期の頃、プロジェクトの再構築になんどか直面した。しかし、それを続けてきて現在のような成功を収めたのは、物理世界を作るためにはデジタルの仮想世界が必要だというビジョンが正しかったからだ。

当初、Omniverseを複数のGPUを利用するソフトウェアとして構築したが、それは間違ったアプローチだった。それぞれ複数のGPUを搭載した複数のコンピュータで動作するように再構築した。そのOmniverseを動かす最適なハードウェアとして提供を開始したのが今回発表したRTX Pro Serverだ。

このRTX Pro Serverは8基のGPUを搭載した1台のコンピュータだが、それをさらに接続することでさらに大規模に利用することができる。このRTX Pro Serverは、完璧なOmniverseコンピュータでもあり、完璧なロボット用コンピュータでもあり、完璧なデジタルツインコンピュータでもあるのだ。この6、7年取り組んできた集大成がここにある。

――AIファクトリーやAIデータセンターの中には、AIサーバーが多数置かれることになる。それらの機器のアップグレードが将来焦点になってくると考えるが、そうしたデータセンター内機器の寿命についてどう考えるか?

フアン 機器のアップグレードはこれまでのデータセンターがそうだったように、AIファクトリーやAIデータセンターでも重要は変わらない。工場では性能がコストと等しく、同時に性能が収益に等しいからだ。たとえば工場の電力が制限されている場合、1Wあたりの性能が4倍優れている場合、収益は4倍に増加する。だから、1Wあたりの性能に優れた新しい世代の製品を導入すれば、工場全体のパフォーマンスがアップし、コストが下がるので収益は増加する。

この場合、NVIDIAのソリューションの利点は、アーキテクチャがすべての世代で互換性があるため、ソフトウェアを長期間利活用できることだ。現在、新しい製品をほぼ1年に1度投入しているが、新しい世代のGPUが古い世代のGPUに比べて電力効率が4倍になったら、同じCUDAソフトウェアを利用して性能を4倍にすることができる。これがCUDAの利点だと言える。それにより、AIデータセンターの寿命は長くすることができると考えている。

前政権の中国への輸出規制に関しては、その結果から見ると方針は間違っていたとフアン氏

――現在世界は貿易の緊張にさらされている。NVIDIAはグローバルサプライチェーン戦略についてどのように考えており、台湾はその中でどこに位置づけられているのだろうか?

フアン 第一に台湾は成長を続けるだろう。なぜかと言えば、今我々は新しい産業の始まりにいるからだ。この新しい産業は、AIファクトリーを構築し、世界の至る所にAIのインフラを持つことになる。インターネットのインフラが地球を覆ったように、AIのインフラは地球を覆うだろう。最終的にAIインフラは、世界中にあまねく存在するようになる。AIファクトリーやAIインフラの構築には、今後約10年がかかるだろう。

台湾には工場が至る所に建設されており、それは我々や台湾の皆さんがAIのためのインフラを構築し、AIのための製造の構築を目指しているからだ。それと同時に世界は製造業の安定性と多様化をもっと進めていく必要があり、その一部は世界中に分散していくだろう。米国でもいくつかの製造を行なう予定だ。国家安全保障にとって重要なことはできるだけ行ない、世界中で冗長性を備えた安定性を持つべきだと考えている。ともかく今は変革期で同時にAIインフラを構築していっている段階だ。

とにかくたくさんのAIインフラのための工場が必要になり、そうした工場に十分なエネルギーを供給する必要がある。社会が経済的に繁栄するには、エネルギーの供給が不可欠だ。水素、原子力、太陽光、風力など、これからもその事典で最も利用可能な新技術を訴求しながら、あらゆる種類のエネルギーをAIインフラに供給してもらうための政府の支援が必要になる。世界中の政府の関係者は、すべての企業を支援する必要があると思う。

――米国の中国に対する輸出規制についてどう考えるか?

フアン ご存じの通り、米国の輸出規制により「H20」の出荷を停止した。H20は現在中国への輸出が禁止されており、そうした規制により数十億ドルの償却を行なわなければいけなくなった。

NVIDIAが中国市場をどう考えているかと言うと、中国市場は重要だということだ。1つ目の理由は、世界のAI研究者の50%は中国に在住していて、そのAI研修者はNVIDIAを基盤に構築することを望んでいるためだ。実際、DeepSeekは、NVIDIAを活用して構築されている。そうしたDeepSeekの成果は我々へのギフトでもあり、世界にとってもギフトだ。

2つ目として中国市場は非常に大きな市場だからだ。コンピュータ市場全体から見て中国は2番目に大きな市場だ。そしてAI市場全体でも中国は来年には同じような地位を占めるようになると考えている。その潜在的な市場規模は500億ドルになると考えており、NVIDIAにとっても、米国にとってもその市場機会は重要だと考えている。その市場機会を得ることができれば、米国に税収をもたらし、雇用を創出し、業界を維持できるのにその機会を失うのは残念だ。

――その政策に腹を立てているか?

フアン いいえ、それについて動揺していないが、方針は間違っているとは思う。どういうことかを説明させてほしい。4年前にバイデン政権が始まった当初、中国におけるNVIDIAの市場シェアは95%近くあったが、今は50%に過ぎない。残りは中国の技術になる。米国政府の政策により、我々はより低い仕様のチップを販売する必要があり、ASP(平均販売価格)は低かったので、収益も低く、いいことはなかった。

今でも中国のAI開発者は開発を続けており、NVIDIAのチップが入手できる場合にはそれを利用し、それが入手できない場合には自分たちで開発したものを利用している。そして中国企業は非常に優秀で、強い決意をもってAI開発に取り組んでいる。米国の輸出管理は、中国の政府のそうした地元企業への支援を促してしまい、彼らの発展を加速させてしまったのだ。そうした事実を鑑みれば、全体として輸出管理は失敗だったと思う。

NVLink FusionにIntelとAMDが参入するなら歓迎

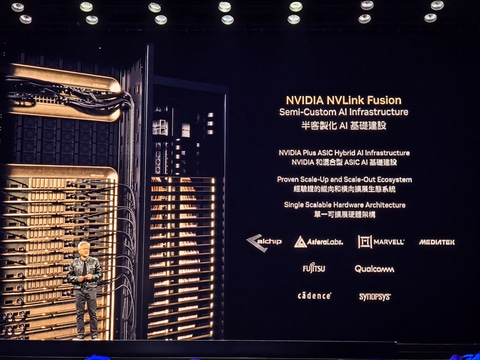

――NVLink Fusionについて、Broadcomがそのリストになかったが、今後彼らとそれについて話し合いをする計画はあるか?

フアン NVLinkは、現代第5世代で、長い間この技術を発展させることに注力してきた。AIデータセンターやAIファクトリーが高いパフォーマンスを発揮できるのも、高い効率を実現しているNVLinkがあるからだ。

そうした中で、NVIDIAには多数の顧客がいて、セミカスタムなAIインフラを開発されている顧客も少なくない。彼らが私のところにきて、「このNVLinkが使用できないか?」と尋ねられることは多かった。

確かに、我々の競合が集まって「UALink」という規格を作ったが、正直UALinkがうまくいっているとは言えない。そのため、顧客からNVLinkを解放してもらえないかと聞かれることが増えたのだ。我々からすれば、NVIDIAのネットワークやファブリックが有益であることが証明されたことを嬉しく思っている。

NVLink Fusionにより、NVIDIAの技術であろうと、カスタムソリューションであろうと、それらをデータセンターに統合でき、かつ市場における機会を拡大することができる。それはNVIDIAにとっても良いことだ。そしてパートナーとなるMediaTekやMarvellといった企業にとってもよいことだ。

そして、NVIDIAのCPUも選ぶことができるし、場合によっては富士通やQualcommといったパートナー企業から提供されるCPUを選ぶことができる。もちろんBroadcomも彼らがNVLink Fusionを使いたいと考えるなら前向きに検討するだろう。

――NVLink Fusionについて将来のビジョンを教えてほしい。

フアン パートナー企業のチップにNVLinkのIPデザインを組み込むのが1つの考え方で、もう1つ、より現実的なものはチップレットとして彼らのパッケージ上にNVLink Fusionを搭載するものだ。

ではパートナーにとってのメリットは何か?1つの例で考えてみよう。富士通はIBMと同じぐらい長い間コンピュータを提供してきた企業であり、世界中に富士通のシステムが大量にインストールされている。そしてそれらの多くは富士通のCPUをベースにして動作している。

彼らの顧客はそのシステムにAIを追加したいと考えている時に、富士通のCPUで動いているソフトウェアと、NVIDIAのGPUで動いているソフトウェアを融合させる必要がある。ではその融合とはどのように行なうのかと言えば、それがNVLink Fusionなのだ。まさに2つのエコシステムが融合する、それが理にかなっていると言えるのではないだろうか。

だからFusion(融合)なのだ。彼らはそうした2つのエコシステムを融合したがっており、彼のCPUがNVLinkに接続することでそれが可能になるのだ。

――IntelやAMDが同じことを望んでも可能か?

フアン 可能だ、もし彼らが我々のエコシステムに接続したいのなら。多くのユーザーが私たちのエコシステムとソフトウェアを欲しがっている。ほかのCPUベンダーがそれをしたいのであれば、NVLinkのチップやIPデザインをCadenceやSynopsysから提供を受けることが可能だ。

柔軟なソフトウェアを柔軟なハードウェアで走らせることが強み

――投資家などはAIブームが終わった後のNVIDIAの業績をもう心配し出しているが、NVLink Fusionやクラウドソリューションなど今回のCOMPUTEXで発表されたものの先にあるものは何か?

フアン 古いAIのモデルはワンショットと言われている。プロンプトに何かを入れてエンターを押すとAIがワンショットで答えを出すからだ。あなたの質問に答えると、それが事前トレーニングをして答えを出そうとするようなものだ。

じゃあ、次のステップは何かと言えば、それは推論だ。現在多くのAI開発者が数々の優れた推論モデルを利用しているが、とても優れておりワンショットの答えだけでなく、数百のショットを提供したり、インターネットにアクセスしてWebサイト読み込んできたり、PDFの内容を理解する。

現在の推論モデルは答えを出すまでに時間がかかったりするのが現状で、必要なコンピューティング量が100~1,000倍になっている。だから世界中でGPUがメルトダウンしているような状況が生じている。MicrosoftはOpenAIがGB200を使っており、今年中に数十万のGB200を構築する予定であると明らかにしている。これは過去数年にMicrosoftが構築してきた全データセンターのGPUよりも多くのGPUが1年だけで彼らのデータセンターに入るのだ。

こうした推論AI時代は今まだ始まったばかりだ。これから人と推論AIは非常に便利なアプリケーションを構築することを可能にする。次に会いインフラの構築が世界中で進んでいく。これが、今私が世界各地を訪れていることの理由の1つだ。世界中のすべての地域がAIインフラを構築する必要があることを認識しており、AIインフラは電気やインターネットのように社会/産業にとって不可欠なものになるだろう。それが、私も中東に行き、トランプ大統領が発表した内容になる。

――以前あなたは、NVIDIAがソフトウェア企業だとアピールされたことがあるが、今に至ってもまだNVIDIAはハードウェア企業に見える

フアン 私が言いったことは「NVIDIAはソフトウェアから始まった企業」だということ。実際、NVIDIAは常にアルゴリズムの開発から始める。それは古典的な量子アルゴリムかもしれないし、コンピュータアルゴリズムからもしれない。あるいは、チップを製造するためのコンピューティングリソグラフィーのアルゴリズムかもしれない。常にそうしたアルゴリズムを開発して、そこから上げたり下げたりしながら設計を試みている。アルゴリズムを理解しなければ、アルゴリズムを加速することができないからだ。

CPUはアルゴリムズを理解する必要はない。アルゴリズムはコンパイラ上にあるので、コンパイラがそれを理解すれば良いからだ。しかし、アクセラレーテッドコンピューティンはそれとは異なる。そのためNVIDIAはまずアルゴリズムを理解するところから始めている。そしてそれをフルスタックソフトウェアによりアルゴリズムの高速化を実現していった。その後、NVIDIAはシステムの企業になり、今はデータセンターにソリューションを提供する企業になり、今はAIインフラを提供する企業になろうとしている。

AIインフラ上で動作するソフトウェアは、PCのようなスタンドアローンのハードウェアとは大きく異なり、システムの構成、アーキテクチャ、ソフトウェアそのものも異なっている。システムの構成で言えば、電力、冷却、ネットワーク、ファブリック、セキュリティ、ストレージなどあらゆる事を一度に考えなければならない。そうしないとソフトウェアは最適化されず、スループットも最適化されない。そうして最適化されないと企業の収益は改善されないからだ。

――ソフトウェア産業は50年以上にも渡る長い歴史がある。最初はCPUから初めて、今はGPUへと中心が移ってはいるが、柔軟性のあるハードウェアと組み合わせてソフトウェアを実行していくということには変わりがない。そうした柔軟性があるハードウェアの重要性は今後どうなっていくだろうか?

フアン それは非常にいい質問だ。流体力学(Fluid Dynamics)、素粒子物理学(Particle Physics)、コンピュータグラフィックスなどがなくなるということは今後もない。これらのアルゴリズムは非常に優れており、長年利用されてきたことで、既に何兆ドルもの価値があるソフトウェアが書かれてきており、それを書き直す理由はどこにもない。

そのように柔軟なソフトウェア、柔軟なハードウェアには常に価値があるのだ。これが、CPUが60年に渡って非常に成功している理由だ。NVIDIAはCUDAを見出し、20年間にわたって大きな発展を遂げてきた。CUDAがこれほどの成功を収められたのは、ディープラーニングやマシンラーニングから始まり、非構造化データ処理、粒子・流体への構造化データ処理、量子物理学、量子化学など、非常に多くの応用領域があるからだ。そのために、柔軟性というメリットが必要なのであり、それと同時にGPUというNVIDIAの技術は非常に高速だ。それゆえに現在データセンターで活用され、多くの領域の応用事例で採用されている。

そしてその利用率が上がれば、コストは下がっていき、現状多くのユーザーが低コストで利用できるようになっている。汎用に利用できるというのは低コストを意味する。亡きスティーブ・ジョブス氏がiPhoneを発表した日に、彼はiPhoneを見せた後、音楽プレーヤーとカメラ、そしてPCを見せて、それが1つのiPhoneという汎用デバイスで利用できるのだと説明した。確かに汎用デバイスは、専用のデバイスに比べて高価だが、すべての専用デバイスを持っているよりも低コストだ。このように汎用というのは低コストと同義だ。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:5位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![「ほぼ新品」 2023モデル Lenovo 14型 14e Chromebook Gen 3 [82W7S09H00] (第14世代Intel N100/ メモリ4GB/ eMMC64GB/ 無線LAN/フルHD1920*1080/ 5G Softbank/ Webカメラ/ Chrome OS)超軽量 中古ノートパソコン 中古パソコン 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/pasoecostore/cabinet/12077002/12838764/12876274/chromebook.jpg?_ex=128x128)

![不徳のギルド 17巻【電子書籍】[ 河添太一 ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/9038/2000019629038.jpg?_ex=128x128)

![週刊TVガイド関西版2026年4月30日号増刊 TVガイドPERSON vol.163 2026年 4/30号 [雑誌] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0465/4912294570465.gif?_ex=128x128)

![ONE PIECE 114 (ジャンプコミックス) [ 尾田 栄一郎 ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0191/9784088850191_1_9.jpg?_ex=128x128)

![227日後の奇跡 こうして愛犬は生まれ変わって戻って来た [ 細見貴子 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/5498/9784344695498.jpg?_ex=128x128)

![an・an(アンアン)2489号増刊スペシャルエディション 2026年 4/1号 [雑誌] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/noimage_01.gif?_ex=128x128)

![100日後に英語がものになる1日10分 ネイティブ英語書き写し [ ブレット・リンゼイ ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2429/9784763142429_1_2.jpg?_ex=128x128)