笠原一輝のユビキタス情報局

NVIDIAを迎撃するAMDの策。AI向けGPU「Instinct MI325X」の強みとは?

2024年10月15日 06:08

AMDは10月10日(米国時間)、米カリフォルニア州において「AMD Advancing AI 2024」を開催し、同社CEOのリサ・スー氏などがAI向け最新製品を発表した。

この中で、GPU「Instinct MI325X」、CPU「5th Gen AMD EPYC processors」、DPU「AMD 3rd Generation P4 Engine」およびそれを搭載したUEC準拠の400GbEthernetアダプタ「AMD Pensando Pollara 400」などのデータセンター向け製品をラインナップしている。

これらは独立した製品発表に見えるかもしれないが、それぞれがデータセンター向けAI市場でNVIDIAからシェアを奪うために必要なコンポーネントとなる。それがどういうことなのか説明していこう。

着実にCSPやOEMメーカーなどの採用顧客事例を増やしてきたMI300X

NVIDIA GPUオルタナティブの座を確実に

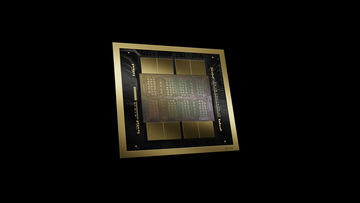

AMDは昨年の12月に「Instinct MI300X」を発表し、市場に投入してきた。MI300Xは、4つのIOD(I/O Die)と8つのXCD(GPUのダイのこと)、さらにHBM3メモリを、パッケージ上で2Dないしは3D方向に混載して搭載。いわゆるチップレット技術を採用したGPUになっている。

チップレットのメリットは、1つ1つのダイサイズが小さくて済むので、巨大なモノリシックなチップを製造するよりも歩留まりが上がること。低価格で製造できるため、価格競争力を維持する意味でも重要になってくる。

AMDはMI300Xが、AI向け半導体の王者であるNVIDIAの現行主力製品となる「NVIDIA H100 GPU」に匹敵すると説明している。

実際同社が公開した性能データでは、推論ではH100を上回り、学習では同じかやや上回るという結果になっている。その上で、価格がH100よりも安価と謳っており、性能と価格競争力でも優れた製品がMI300XだというのがAMDの主張だ。

そしてその主張は顧客に受け入れられ始めている。OEMメーカーではDell Technologies、Hewlett Packard Enterprise(HPE)、Lenovo、Supermicroなどがすでに製品を発表しており、提供が始まっている。

さらに、最近生成AIの利用基盤として企業などから注目を集めている、CSP(クラウドサービスプロバイダ)も、大手4社のうち2社がすでに採用を明らかにしている。

昨年の12月にAMDが開催したイベントで採用計画を明らかにしていたMicrosoftは、本年5月開催のBuildにおいて「Microsoft Azure ND MI300X virtual machines」と呼ばれるMI300Xのインスタンス(外部の企業が仮想的に利用できるハードウェアサービスのこと)の一般提供開始を発表している。

また、Oracle Cloud Infrastructure(OCI、Oracleが提供するクラウドサービス)も昨年のAMDの発表時点で採用意向表明を行なっていたが、9月にMI300Xを16,384基までスケールアウトしたスーパークラスタの運用を開始したことを明らかにしている。OCIはそれをインスタンスとして提供する計画で、顧客がLLMなどの学習や推論向けに活用できる。

このように、MI300XはCSP大手のうち2社がすでに運用している。CSPのイベントを取材すると担当者やその顧客が口を揃えて「とにかくGPUが足りない」と言うが、その「オルタナティブ」(別の選択肢)として考慮される存在になってきているのだ。

MI325XはNVIDIA H100→H200と同様のメモリ容量と帯域幅強化

推論・学習ともにH200を上回る

今回AMDは、そのMI300Xの後継として「Instinct MI325X」を発表している。MI325Xは、簡単に言ってしまえば、NVIDIAがH100からH200へのアップグレードで、メモリをHBM3からHBM3eへと変更し、メモリ容量(H100の80GBから141GB)とメモリ帯域(H100の3.35TB/sから4.8TB/s)を引き上げたのと同じような強化が施された製品だ。

MI325XでもメモリはHBM3からHBM3eへと変更され、容量は192GBから256GBに、メモリ帯域は5.3TB/sから6TB/sへと引き上げられている。

現状、AI学習や推論の現場ではメモリ容量と帯域がボトルネックの1つになっているので、性能がとにかく欲しいAIソフトウェア企業からすれば歓迎できるアップグレードと言える。

AMDはMI325XをNVIDIA H200の対抗製品と位置付けており、同社が公開した性能データびいずれもH200の比較データとなっている。

推論時の性能は、モデルにLlama 3.1 70Bを利用した場合でH200に比べて1.2倍、Mistral 7Bを利用して1.3倍、Mixtral 8x7Bを利用して1.4倍となっている。

学習に関してはLlama 2 7Bを利用しての1GPU同士の比較で1.1倍、Llama 2 70Bを利用しての8GPUの比較で互角といった結果だ。

つまり、MI325XとH200の性能比較を見る限り、推論に関してはやや優勢、学習に関してはほぼ同等という性能を持っている。それでいて、価格はAMD側のほうが同等ないしは安価である可能性が高い。

もちろん、AMDもNVIDIAも両製品のリストプライス(定価や参考価格)は公開していないので、マーケットプライス(市場価格)では一概にどちらが安いとか高いなどと言うことはできない。

だが、AMD 執行役員(GPUプラットフォーム担当) ブラッド・マクレディ氏は「我々のマルチチップ戦略は競合よりも低コストで製造できると考えている」とする。

MI325XはMI300Xの特徴である4つのIOD+8つのXCDというマルチチップ構成のチップレットになっている構造を引き継いでいるので、巨大な1つのダイになっているNVIDIAのHopper世代に比べて低コストで製造できる可能性が高い。

そのため、同じような性能であっても、NVIDIA H200に比べて低価格に設定可能であり、価格性能比が高いということになる。

実際、今回のAMD Advancing AI 2024において、ビデオ出演したMicrosoftのサティヤ・ナデラCEOはMI300X/MI325Xの特徴を価格性能比が高いことだと述べ、だからこそ同社のAzureユーザーにとって有益とした。

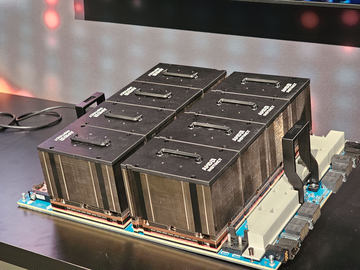

昨年のMI300Xの発表時と、今回のMI325X発表時の大きな違いは、OEMメーカーが展示するMI300シリーズ搭載製品の違いだ。

昨年の発表会では、AMDのリファレンスデザインと2、3製品程度が展示されている程度だったが、今回のAMD Advancing AI 2024では、Dell、HPE、Lenovo、GIGABYTE、SupermicroなどのOEMメーカーや、QCTなどのODMメーカーが複数のMI300X/MI325X(両製品はプラットフォームを共有している)製品を展示。すでに準備は整っているという印象を受けたのが大きな違いだと言える。

AMDはMI325Xの量産出荷を第4四半期中としており、OEMメーカーからの出荷は来年の初頭になる予定だと説明している。

NVIDIAの弱点はNVLinkに対応したx86 CPUが存在しないこと

だからAMDとIntelはUALinkを作った

今回AMDは、Instinct MI325Xだけでなくデータセンター向け「第5世代EPYC」、そしてDPU(Data Processing Unit、プログラマブルなネットワークプロセッサ)の「第3世代P4」を発表している。データセンターでのAIと言えばGPUだけに注目が集まりがちなのだが、実はより効率の良いAI演算のためには、この2つが死活的に重要なのだ。

AIの演算ではCPUの重要性は低いと思われがちだが、実際にはそんなことはない。GPUに対してこのデータを読み込んで演算をしろと指令を出すのはCPUなのだ。このため重要になるのは、CPUとGPUが高速なインターコネクトで接続されていることだ。

ところが、現状NVIDIAのGPUサーバーの多くは、GPUとGPUはNVLinkというPCI Expressよりも圧倒的に高速なインターコネクトで接続されているのに対し、GPUとCPUは低速なPCI Expressでの接続になってしまっている。

なぜかというと、現在データセンター向けに標準で利用されているx86 CPUは2つのメーカー(IntelとAMD)しかなく、IntelはQPI、AMDはInfinity Fabricといういずれも両社が開発した技術を利用したインターコネクトで接続されており、NVLinkはCPU側が対応していないからだ。

このため、NVIDIAはGraceというArmアーキテクチャのCPUを開発し、GraceはNVLinkをサポートしていて、CPUとGPU間がボトルネックになることを防ごうとしている。

しかし、現状多くのAIプログラムはCPUがx86アーキテクチャであることを前提に書かれており、Graceに対応させる場合、コードをArm向けに書き直す必要がある。

現代のCPU ISA(命令セットアーキテクチャ)の違いは、昔ほど大きなハードルではなくなってきているとはいえ、それでもプログラムを書く側からすれば、ハードルであることに違いはない。

だから、NVIDIAもHopper世代はGrace Hopper(GH200)、これから登場するBlackwell世代ではGrace Blackwell(GB200)といった製品を用意しているが、市場で売れているのはDGX-H100のような、IntelやAMDのx86 CPUを搭載したシステムのほうだ。

AMDはそうしたNVIDIAの弱点をよく理解している。そのため5月に「Ultra Accelerator Link(UALink)」というチップ間を高速に接続する標準規格を作る業界団体を、CPUでは直接の競合だが、AIではNVIDIAにともに後塵を拝しているIntelなど業界各社と立ち上げることを発表したのだ。

AMDはこのUALinkに、AMDのCPU・GPUのチップ間通信に使っているInfinity FabricのIPなどを寄贈する計画だと明らかにしている。つまり、将来的にIntelのCPUやGPUがUALinkに対応すると、CPUはIntelのXeon 6だが、GPUはAMDのInstinctという世界が実現されることになる。

今回のイベントではUALinkについて何も説明がなかったが、すでにAMDのCPUとGPUはInfinity Fabricに対応しているのだから、近い将来にこれがNVIDIAに対抗する上で大きな武器になる可能性は高い。

NVIDIAのもう1つの強みはMellanox由来のネットワークアダプタ

それに対抗するのがUltra Ethernet Consortium

NVLinkにせよ、Infinity Fabric(そして将来はUALink)にせよ、高速なインターコネクトは、サーバー機器の中でGPUをスケールアップするのに利用される。

それに対して、サーバー機器をラックの中で相互に接続し、最終的にはラックとラックを接続してGPUの数を増やしていくことをスケールアウトと呼んでいる。スケールアウトでGPUを数千、数万基へとクラスタ化していき、大規模なエンタープライズやCSPでは演算性能を引き上げている。

そのスケールアウト時に重要なことは、とにかく高効率にデータを異なる機器間でやり取りすることだ。具体的にはRDMA(Remote Direct Memory Access)と呼ばれる、CPUやGPUを介さずにメモリとメモリ間で直接にデータアクセスを行なう仕組みなどが活用される。

というのも、こうしたクラスタ構成では、GPUが処理するデータがほかの機器上にある場合などには、データが転送されてくるまでの間、待たないといけない時間が発生する。それを最小限に抑えてクラスタ全体の性能を上げるための仕組みがRDMAなどだ。

ネットワークアダプタ上でこうしたRDMAの仕組みを実現するには、たとえばEthernetがRoCE(RDMA over Converged Ethernet)と呼ばれるプロトコルが規定されており、現時点では第2世代のRoCE v2がプロトコルが利用されている。

NVIDIAの強みは、スケールアップのインターコネクトも、スケールアウト用のネットワークも、高性能なネットワーク製品を持っていることだ。前者はすでに説明したNVLinkおよびそのスイッチであるNVLink-Switchであり、後者は2019年にNVIDIAが買収したMellanox Technologies由来のネットワーク製品になる。

Mellanoxは、InfiniBandやEthernetなどの機器同士を接続するネットワークコントローラやスイッチなどを実現するチップを製造していたファブレス半導体ベンダーだった。NVIDIAはMellanoxを買収することでその資産を手に入れ、現在同社のデータセンター向けのソリューションとして販売している。

これをNVIDIAのGPUサーバー(DGXシリーズなど)に組み込んで販売することで、クラスタやデータセンター全体で高性能を実現しており、それがNVIDIAの強みの1つになっている。

もちろん、NVIDIAの競合たちはすでにそれに気付いており、AMD、Intel、BroadcomなどのCPU、GPU、ネットワークなどの半導体を製造するメーカーなどを中心に昨年結成されたのがUltra Ethernet Consortium(UEC)だ。

UECは、現在のEthernet上でRDMAを実現する規格(RoCE V2)よりも高効率なプロトコルを作り、それによりNVIDIAのMellanox由来のネットワーク製品に対抗していくという取り組みになる。

今回AMDが発表した第3世代P4エンジンはそうしたUECに対応したネットワークアダプタを構築する基盤になる。

第3世代P4エンジンを搭載した400GbEthernetアダプタ「AMD Pensando Pollara 400」は、来年の第1四半期に完成する予定のUEC Specification 1.0に準拠している。AMDはUEC準拠のRDMAはRoCE V2に比べて圧倒的に高効率になると説明しており、NVIDIAをインフラ方面から追撃する武器になる。

AMDは2025年後半にBlackwell対抗のMI355Xを投入

CPUとのインターコネクト、スケールアップ時のインターコネクト、そしてスケールアウト時のネットワークアダプタの強化ももちろん大事なのだが、それと平行してGPU自体の性能を引き上げることが必要なのは言うまでもない。

AMDが今回発表したMI325XがAMDの言う通りNVIDIA H200に匹敵するような性能を持っており、同時にH200よりも安価であるというのならそれは十分魅力的だが、NVIDIAだって同じところに止まっているわけではない。

既報の通り、NVIDIAは今年3月に開催したGTCで、次世代GPUとしてBlackwellをすでに発表しており、年内に出荷する計画だ(Blackwellの出荷時期には噂も含めてさまざまな説があるが、今のところの公式見解はNVIDIAが直近の四半期決算で語ったことがすべてだ)。

今回AMDがプレビューとして公開したInstinct MI350シリーズ最初の製品「Instinct MI355X」は、Blackwellキラーとなる。

すでに6月に開催されたCOMPUTEX TAIPEI 2024の段階で、次世代のGPUアーキテクチャとなる「CDNA 4」に変更されることが発表されたが、今回それに加えてFP4/FP6の精度に対応することが明らかになっている。

また、AMD 執行役員 兼 データセンターGPU事業部 事業部長 アンドリュー・ディックマン氏は、「MI355Xではチップレットのデザインも見直している。従来のMI300Xシリーズでは4つのIODと8つのXCDという構成になっていたが、MI350シリーズでは2つのIODと8つのXCDという構成になる」と述べ、効率改善を謳っている。

チップレットのダイはそれぞれを小さく作ったほうが1つあたりのダイの歩留まりは向上するが、今度はそのダイとダイの間を接続しているインターコネクトを通るデータ量が増え、データの渋滞により性能に影響が出ると考えられる。そのため、そのあたりの調整が行なわれるということだろう。

なお、AMDはMI355XのFP4/FP6時の性能を9.2PFLOPSだと明らかにしているが、それはNVIDIAのBlackwellのFP4/FP6の性能である20PFLOPSに比べて低いのではないかという疑問がある?

それについてマクレディ氏は、「我々の認識ではNVIDIAのBlackwellのFP4/FP6の性能はスパース性を利用して演算した場合の結果だと考えている。それに対して我々の9.7PFLOPSはスパース性を利用していない結果だ。そのことを考慮すれば、MI355XはBlackwellに対して十分競争力がある製品になると考えている。もちろんその詳細は今ここで話せないが、OEMメーカーやCSPにロードマップを説明する時に(FP4/FP6以外の性能も含めて)、競合と比較しても競争力がある製品だと興味を持ってもらえている」という。

AMDによれば、MI355Xは来年後半に正式発表、出荷される計画だという。筆者はMI355XがBlackwellに対抗できると考えており、GPU不足で悩んでいるAIデータセンターの関係者にとって良いニュースになるだろうと感じたことを付け加えておく。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![LG USB-C接続 PCモニター[27型 /4K(3840×2160) /ワイド] ブラック 27UQ850V-W 製品画像:1位](https://thumbnail.image.rakuten.co.jp/@0_mall/r-kojima/cabinet/n0000001062/4989027026292_1.jpg?_ex=128x128)

![異世界のんびり農家(16)【電子書籍】[ 剣 康之 ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/4152/2000019774152.jpg?_ex=128x128)

![太郎 DON’T ESCAPE!【特典ペーパー付】【電子書籍】[ mememe ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/2467/2000019272467.jpg?_ex=128x128)

![COCO'S LOVE BOOK 2026年 2月号 [雑誌] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0262/4912100300262_1_3.jpg?_ex=128x128)

![人生は気づかぬうちにすぎるから。 「自分第一」で生きるための時間術 [ クリス・ギレボー ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1993/9784478121993_1_2.jpg?_ex=128x128)

![社会人基礎力を鍛える 新人研修ワークブック 第2版 [ 山崎 紅 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0022/9784296070022.jpg?_ex=128x128)

![TOYOTA 2000GT [ いのうえ・こーいち ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/5481/9784802135481_1_4.jpg?_ex=128x128)

![魔導具師ダリヤはうつむかない 〜Dahliya Wilts No More〜/ 9【電子書籍】[ 住川惠 ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/9932/2000019809932.jpg?_ex=128x128)

![子どもとの関係が変わる 自分の親に読んでほしかった本 [ フィリッパ・ペリー ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/7673/9784296117673_1_12.jpg?_ex=128x128)

![anan (アンアン)2487号 2026年 3/18号 [雑誌] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0368/4912204830368_1_2.jpg?_ex=128x128)