ニュース

「その画像修正しておいて」と言うだけで叶う時代へ。Adobeが描くAIの未来

2025年10月29日 14:00

Adobeは、10月28日~10月30日(米国時間)に同社のクリエイター向け製品「Adobe Creative Cloud」の年次イベントとなる「Adobe MAX 2025」を、米国カリフォルニア州ロサンゼルス市のLACC(ロサンゼルス・コンベンション・センター)で開催している。初日となる10月28日午前には、同社CEOシャンタヌ・ナラヤン氏を筆頭に同社の幹部が登壇して、同社の新戦略や新製品を紹介する基調講演が行なわれた。

今回のAdobe MAXでは、昨年(2024年)までのAdobe MAXと同様にAIや生成AIが大きなテーマになっており、特に今年は「エージェント型AI」への対応が強く謳われており、従来からAdobeがアピールしてきた「クリエイターの仕事を助けるAI」という路線がさらに拡張されることを印象づける年次イベントになっている。

この中でAdobeはFirefly関連の各種発表を行なったほか、GoogleおよびGoogle Cloudとの提携、さらにはAIを利用することで、コンテンツ生成・編集を自動化するProject Moonlight、さらにクリエイターのワークフローを可視化するProject Graphのデモなどを行なった。

2016年のAdobe Senseiの登場から始まったAdobeのAI、クリエイターを助けるAIという哲学は変わらない

Adobe CEO シャンタヌ・ナラヤン氏は「クリエイティビティの重要性はかつてないほど高まっており、大きな変化を遂げている。それはもはや従来のコンテンツ業界の枠を超えて、イノベーションを推進し文化を形作るための普遍的な言語になりつつある。

Adobeはそうしたクリエイティビティの最前線に立ってきたことを誇りに思っており、Photoshopの黎明期から現在のような形になるまで進化を後押ししてきた。シーンのレイアウトを再考し、オブジェクトの追加や削除、1回の操作で選択範囲を指定できる機能など、クリエイターを助ける機能を実装するなどして、クリエイターを助けてきた。

こうした操作とコンテンツ生成の進化では、AIがタスクを実行するのではなく、AIとユーザーが協力して実現してきたのがCreative Cloudの歴史だ。そのために我々はAIに投資して、皆さんがお使いのアプリケーションで何かを実現させることを支援し、ツールや技術が進化する中でもクリエイターの主導権を確保し、クリエイターが考えていることを実現することを助けてきたのだ」と語った。

Adobeがクリエイター向けのAIを導入した歴史は、実は結構長い。まだ、マシンラーニング/ディープラーニングなどと呼ばれてきたトラディショナルなAIの普及期にあたる、2016年に開催したAdobe MAX 2016において、Adobeは「Adobe Sensei」というAI実行環境を発表している。

Adobe Senseiは、1つのアプリケーションというよりは、サービス・プラットフォームの総称。AdobeのCreative Cloudアプリケーションがクラウドと通信してAIの推論処理を行なう時に利用されるソフトウェアレイヤーになる。たとえばPhotoshopの機能である、「コンテンツに応じた補正(Contents Aware Fill)」、「空の置き換え(Sky Replacement)」などの機能がAdobe Senseiにより実現された。

近年のAdobeはそれに加えて、生成AIのモデルを自社で開発し、それを元にアプリケーションの機能を拡張している。たとえば、ここ数年のPhotoshopでは生成塗りつぶし(画像生成)、生成拡張(画像のない部分を生成する)、ディテールを向上(シャープネスの向上)、被写体を選択(AIが物体や人物などの指定を行なうこと)などの機能が追加されており、それらを利用して画像の編集にAIの力を借りて作業時間を短縮し、コンテンツを作り出すことが可能になっている。

これまでは、Adobeが自社開発した生成AIモデル(Firefly Image ModelやFirefly Video Model)などだけで提供されていたのだが、最近ではサードパーティの生成AIモデルも利用可能になっており、目的に応じて選択できるようになっているなど、機能拡張が続いている状況だ。

ナラヤン氏は「我々はクリエイターが自由に生成AIモデルを選べる環境を選択したいと考えている。そうしたAIモデルをクリエイターが有益に使えることが、より優れたコンテンツをクリエイターが作り出すことにつながると我々は考えている。今回はそうしたAIモデルとAdobeのクリエイターツールを組み合わせることで、より洗練された出力を行なえるようにしていく方針を紹介したい」と述べ、Photoshop、Lightroom、Premiereなどのツールとそうした各種のAIモデルを組み合わせることで、よりクリエイターの生産性を向上させることを今回のAdobe MAXで発表していくことアピールした。

1つの契約で複数の生成AIモデルを活用しながら、コンテンツの生成・編集ができることがAdobe 生成AIの特徴に

次いで登壇したAdobe デジタルメディア事業部門代表 デイビッド・ワドワーニ氏は「デジタルコンテンツへの需要は高まり続けており需要は5倍に、さらにデジタルコンテンツを作りマーケティングするチームの雇用は77%増している」と述べ、デジタルコンテンツそのものへの需要も、そしてそれを制作するクリエイターへの需要も上がり続けていることを指摘した。

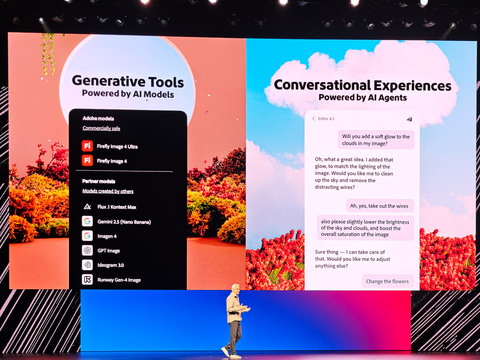

その上でワドワーニ氏は「現在クリエイター向けのツールには大きな2つのトレンドがある。1つは生成ツールの普及であり、もう1つが会話型のユーザー体験だ」と述べ、生成AIモデルとAIエージェントという生成AIモデル由来のAIツールを活用していくことが、クリエイター向けツールの大きなトレンドになっていると指摘した。

その上で生成AIツールの観点では「我々は商用利用が可能なコンテンツを生成できる生成AIモデル(Firefly Model)の提供を行なってきたが、現在ではGoogleなどのサードパーティが提供するパートナー・生成AIモデルも活用できるようにしている。もちろん、そうしたパートナー生成AIモデルでも商用利用を可能にしており、クリエイターは安心して利用することができる」と述べ、AdobeのクリエイターツールとGoogle GeminiなどのサードパーティのAIモデルを組み合わせてコンテンツ作成をできることが、Adobeのクリエイターツールの強みになっていると強調した。

Adobeは元々生成AIモデル(Firefly Model)を自社開発し、基本的にはそうした自社モデルとCreative Cloudの組み合わせで提供してきた。しかし、最近その方針を転換し、自社モデルだけでなくパートナー企業が提供する生成AIモデルも利用できるようにしている。

たとえば最新バージョンのPhotoshopでは自社モデルのほかに、Google Gemini 2.5 FlashとFLUX Kontext Proから選択が可能で、画像生成時に好みの生成AIモデルを指定して画像生成などが可能になっている。

ワドワーニ氏は「我々はユーザーとコミュニケーションしていて、多くのユーザーからもっと選択肢を用意してほしいという声をいただいた。その声に応えるためにパートナーAIモデルの提供を行なうことにしたのだ」と述べ、顧客からAdobeのモデルだけでなく、Googleなどの他社モデルも使えるようにしてほしいという声が多数寄せられたため、提供することにしたのだと強調した。

Adobeが自社モデルのみから、パートナーAIモデルも提供するという方向に方針を転換した背景には、AIモデルの競争激化により、画像生成1つをとっても複数の選択肢が出てきていることにある。Adobeとしては、Firefly Image Modelという自社のイメージ生成モデルを提供しているのだが、GoogleがGemini 2.5 Flash Imageを出して話題を呼ぶなど、Adobe以外の画像生成モデルの精度もどんどん上がっている状況だ。

Adobeとしては、AIモデルを開発することは本業ではなく、クリエイターツールであるCreative Cloudを提供することが本業であることを考えれば、他社のモデルを競合他社だとして排除するよりも、自社のサービスの1つとして取り組んだ方がクリエイターツールの競合他社(たとえばCanvaなど)との競争に有利だと考えたということだろう。

今回の基調講演中に、Adobeは何度も「1つのプランの契約で、1つの目的地で複数のAIモデルを利用できるとシンプルだ」と何度も強調し、Creative Cloud、特にその中でもFireflyのプランと契約するだけで、Gemini 2.5 Flashやその他の代表的なイメージ/動画生成モデルを利用できることを何度もアピールした。

Google、Google Cloudとの協業が発表され、Premiere MobileとYouTube Shortsとが連携する

ワドワーニ氏はそうしたAIモデルを提供するパートナー企業の代表としてGoogleを紹介し、Google DeepMindのエリ・コリンズ氏をゲストとして呼び入れ、AdobeがGoogleの開発した生成AIモデルである、Gemini 2.5 FlashやImagenなどのイメージ生成モデル、Veoなどの動画生成モデルを採用していることについて紹介した。

なお、今回AdobeはGoogleのクラウド部門であるGoogle Cloudとの提携も発表しており、AdobeとGoogle Cloudがエンタープライズの顧客向けのカスタマイゼーションサービス、共同マーケティングなどを行なっていくことも明らかにされている。

また、AdobeとGoogleの連携という点では、Premiere MobileとYouTube Shortsの連携が発表された。Premiere Mobileは現状、iPhone版の提供が開始されたPremiere(後述するが今回のAdobe MAXからProが取れてPremiereになった)のスマートフォン向けのバージョンとなる。

近日中にこのPremiere Mobileに、YouTube Shortsのタブが登場し、そこから直接YouTube Shortsに動画を投稿することが可能になる。YouTubeの配信者などがこれを使うと、スマートフォンで撮影、編集、投稿が完結することになり、生産性が向上する。今後も、こうした提携を深めていく計画で、YouTube配信者にとっての利便性が向上していくことになりそうだ。

エージェント型AIの走りになるExpressやPhotoshop Web版のAIアシスタント、将来はCCアプリにも波及

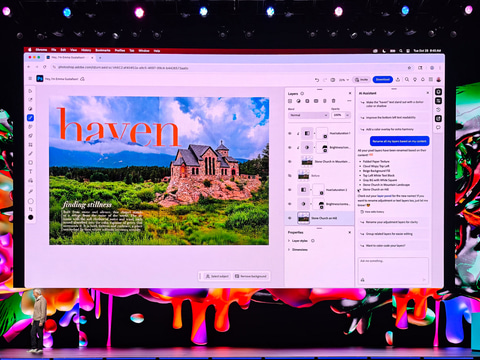

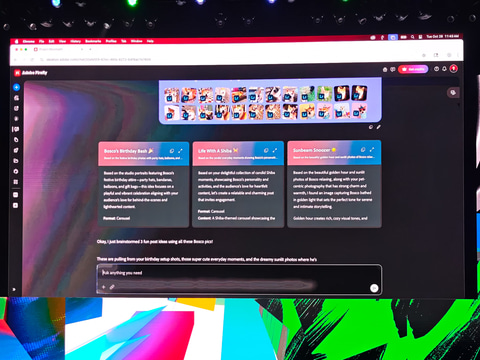

ワドワーニ氏はもう1つのトレンドとして指摘した「会話型ユーザー体験」に関しては、Adobeが今回のAdobe MAXで発表したExpressとPhotoshop Web版に搭載されたエージェント型AIのAIアシスタントに関して説明した。

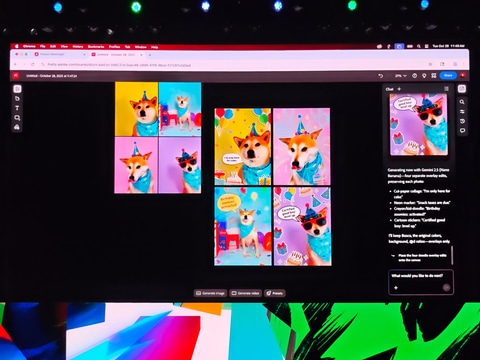

こうしたAIアシスタントは、ChatGPTのようなチャットボットがユーザーと対話しながらExpressやPhotoshopを操作するのを助ける機能になる。デモではPhotoshopやExpressでAIアシスタントと会話しながら、どのような処理をすべきかなどをAIが教えてくれ、それを元にPhotoshop Web版などの操作が行なわれた。

現時点ではExpress、Photoshop Web版ともにWebブラウザでのアプリケーションでのみの対応になっているが、基調講演終了後に記者の質問に答えたAdobe ジェネレーティブAI & Adobe Sensei担当副社長のアレクサンドル・コスティン氏は「Photoshop Web版と、デスクトップ版Photoshopのコードは基本一緒のものから派生している。従って、Web版のPhotoshopに実装された機能がデスクトップ版に搭載されるのは時間の問題だ。ただ、それがいつになるのかは現時点ではお答えできない」とし、近い将来にデスクトップ版のPhotoshopに、そして将来的にはほかのCreative CloudのWebアプリケーションに搭載される可能性はあると説明した。

このほかにも、Firefly Image Model 5、ChatGPTにおけるExpressサポート、Firefly BoardのデモなどFireflyの説明に多くの時間が割かれている。

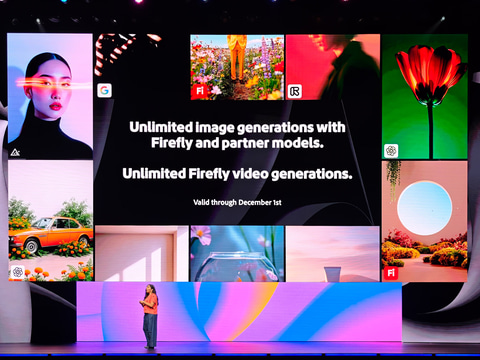

また、AdobeのFireflyでは、サブスクリプションの料金(年額/月額)と生成クレジットと呼ばれる、生成AIのサービスを利用するたびに減っていくクレジットの2本立ての料金プランになっている。しかし、12月1日までは、イメージ生成と動画生成は無制限で行なえることをAdobeは明らかにした。また、Adobe MAXの参加者にはFireflyを3カ月無償で試せるバウチャーが送られており、Adobeは、その多くがCreative Cloudのユーザーだと考えられるAdobe MAXの参加者にFireflyを試して見て欲しいと考えていることがうかがえた。

そうしたことなどから、従来はデスクトップ版のアプリケーションと連携して利用するという位置づけだと考えられてきたFireflyだが、文字通りAdobeのクリエイター向けツールのセンターど真ん中に位置づけが変わってきていることを参加者に印象づけた。

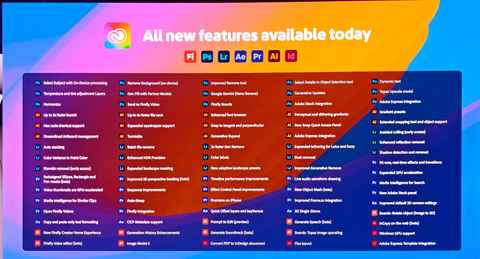

Creative CloudのアプリはPhotoshop、Illustrator、Lightroom(クラウドおよびClassic)がバージョンアップ

今回Adobeは、Adobe MAXの基調講演を3時間近くという近年にはなかった長時間の講演を行ない、その大部分をAIモデルの戦略やFireflyの説明、さらにはエージェント型AIなどのAI関連に多くの時間を割いた。

そのAIの説明が終わった後、通常のAdobe MAXではメインコンテンツとなっているCreative Cloudのデスクトップアプリの説明を行なった。今回Adobeは、Adobe MAXの開幕日にCreative Cloudのバージョンアップを実施し、Photoshop、Illustrator、Lightroom(クラウドおよびClassic)のバージョンアップを行ない、新機能の実装などを行なっている。

- Photoshop 2026(v27.0)

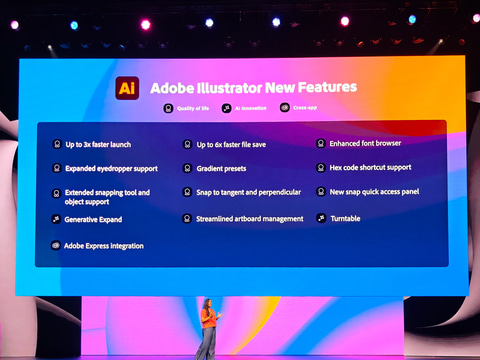

- Illustrator 2026(v30.0)

- Lightroom(v9.0)

- Lightroom Classic(v15.0)

Adobeのアプリケーションは通常、Adobe MAX合わせでバージョンが1つ上がり、1年をかけて小数点以下のマイナーバージョンが徐々に上がっていくという形でアップデートがかけられていく。その意味では上記のアプリケーションはその予定通りのアップデートがかかった形になる。

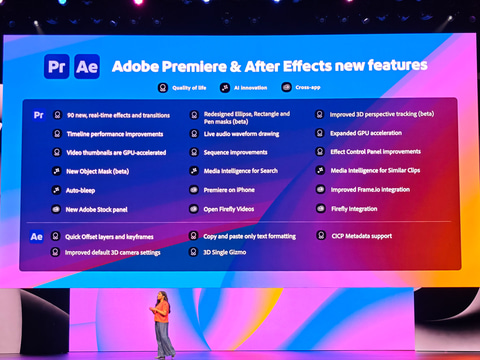

なお、動画編集のPremiere Pro(現行バージョンはv25.5)は、今回アップデートは公開されていないが、次のバージョン(v26.0)のベータ版がすでに公開されている。このv26からPremiere ProはProが取れ、「Premiere」となることが今回Adobe MAXで明らかにされた。

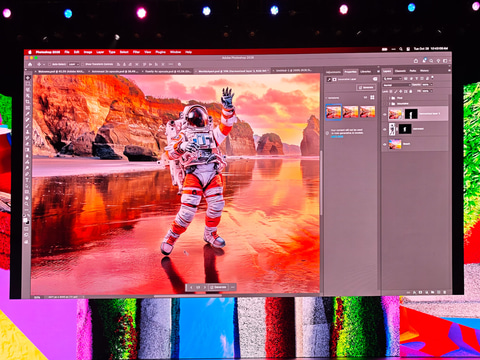

Photoshop 2026(v27.0)は、合成する物体や人物の影や光の当たり加減を背景と調和が取れるように合成する「調和」機能、Topazのパートナーモデルを利用したアップスケール機能などが実装されている。

Illustrator 2026(v30.0)はフォントメニューのアップデート、ベクターを生成、新モデルの追加、幾何学ガイドの新設、グラデーションとカラー機能の向上、アートボードの機能の向上、ターンテーブル(Beta版アプリで提供)などの新機能が追加され、MAXではそのデモが行なわれた。

Premiereに関しては、マスク機能が強化されている。Adobeによればマスク機能は完全に新設計になっており、たとえば顔のマスクなどを動画の動きに追従してかけることが可能になっており、従来のように1フレーム、1フレームかけるという作業を行なっていたのに比べて圧倒的に生産性が高まっている。

Lightroomに関しては新しい「アシスト選別」(Assisted Culling)が提供開始される。このアシスト選別は、AIが多くの写真の中からよりよい写真を選ぶのをアシストしてくれる機能。たとえば、目が開いている写真を選ぶなどの重み付けを行なって、それに応じた写真をAIが自動で選んでくれること、さらにはレンズについた汚れをAIが検出して消してくれる機能が大きなアップデートとなる。

コンテンツに特化したエージェント型AIになるProject Moonlight、ワークフローを可視化するProject Graph

最後にワドワーニ氏は、2つのAdobeが開発中の製品のデモを行なった。それがProject MoonlightとProject Graphの2つになる。

Project MoonlightはFireflyのAIエージェントのような機能で、今回Photoshop Web版やExpressに実装されることが明らかにされたAIアシスタント機能をさらに拡張したものとなる。Project MoonlightはAIとプロンプトでやりとりができるだけでなく、プロンプトでお願いした処理をAIが自動で行なってくれる。これにより、コンテンツの生成や編集などの自動化が可能になり、クリエイターがより手軽にコンテンツの生成や編集などを行なうことができるようになる。

これが発展すると、将来のPhotoshopやIllustratorなどで、クリエイターが仕上がりのイメージをプロンプトでAIに伝えるだけで目的のコンテンツが作られ、思い通りに編集することが可能になり、まさに夢のようなツールだと言える。

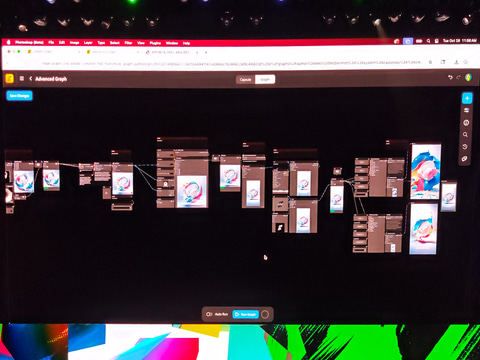

Project Graphは、クリエイターが自然にやっているプロセスを、グラフィック化するツールだ。Photoshopで、このノイズ除去フィルターとぼかしフィルターをかけて、解像度を引き上げる処理を加える……などをやっているが、そうしたプロセスをグラフィックにすることで、何をやっているのかが一目瞭然で分かるようになる。

このProject Graphを使うと、従来はその加工を担当したクリエイターでなければ画像にどんな処理をしているかが分からなかったのが、誰でも後からこういう処理を加えているのかということを確認でき、同じような処理を加えることが可能になる。

Adobeのワドワーニ氏によれば、Project Graphは現在開発中。今後数カ月でなんらかの形で提供される予定とのことだ。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:2位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![[A4] 一体型 デスクトップパソコン 最新 Windows11 富士通 ESPRIMO FH70/YD 第六世代 Corei7 メモリ8GB 高速 SSD256GB 23型 ワイド スノーホワイト 無線LAN USB3.0 タイプC DVDマルチ フルHD スピーカー内蔵 Bluetooth SDカード Office FUJITSU PC 本体 中古パソコン 中古 製品画像:16位](https://thumbnail.image.rakuten.co.jp/@0_mall/pc-shinjyo/cabinet/pc-desk/fujitsu-fh77yd_r.jpg?_ex=128x128)

![トレーディングPC4 本体 FX 株 デイトレ 仮想通貨 4画面出力モデル トレパソNEW Office Windows11 多画面 [Core i5 14400F メモリ16GB SSD500GB ] :新品 製品画像:3位](https://thumbnail.image.rakuten.co.jp/@0_mall/whatfun-pc/cabinet/31/torepasodake_r.jpg?_ex=128x128)

![フィリップス(ディスプレイ) 241S9A/11 [23.8型液晶ディスプレイ/1920×1080/HDMI、D-Sub/スピーカー:あり/5年間フル保証] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/etre/cabinet/itemimage26/1267243.jpg?_ex=128x128)

![黒/白2色 楽天1位!384冠!モニター 23.8インチ 27インチ 200Hz/180Hz/165Hz/100Hz ゲーミングモニター 1ms応答 pcモニター パソコン モニター 非光沢 VA チルト VESA Freesync スピーカー内蔵[1+1年保証] cocopar 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/qifeng/cabinet/09826274/09826275/imgrc0105783334.jpg?_ex=128x128)

![いちねんせいえほん はじめての「よのなかルールブック」 [ 高濱正伸 ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1205/9784284001205_1_3.jpg?_ex=128x128)

![浄土真宗本願寺派 日常勤行聖典 解説と聖典意訳 [ 豊原大成 ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/4043/9784910494043_1_4.jpg?_ex=128x128)

![外傷初期診療ガイドラインJATEC改訂第6版 [ 日本外傷学会 ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0142/9784867190142.jpg?_ex=128x128)

![配色事典 応用編 大正・昭和の色彩と商品デザイン (青幻舎ビジュアル文庫シリーズ) [ 和田三造 ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/7722/9784861527722_1_3.jpg?_ex=128x128)

![過去問題で学ぶQC検定 2級 2026年版 [ 仁科 健 ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/5407/9784542505407_1_4.jpg?_ex=128x128)

![落第忍者乱太郎 公式忍術・用術編 忍たま の友 人之巻 (あさひコミックス) [ 尼子騒兵衛 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1102/9784022751102.jpg?_ex=128x128)

![デコピンのとくべつないちにち (単行本 608) [ 大谷 翔平 ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9368/9784591189368.jpg?_ex=128x128)

![Eye-Ai 2026年4月号【表紙:七五三掛龍也(Travis Japan)】 [ Eye-Ai編集部 ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/4641/9784910694641_1_2.jpg?_ex=128x128)

![バック・トゥ・ザ・フューチャー タイムサーキットとタイムトラベル!BOX / (株)学研プラス[書籍] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/shimamura-gakufu/cabinet/g05269/g0526903.jpg?_ex=128x128)

![タッチペンで音が聞ける!はじめてずかん1000 英語つき [ 小学館 ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/6775/9784099416775_1_37.jpg?_ex=128x128)