笠原一輝のユビキタス情報局

生成AIをローカルで動かす。それはThreadripperか、Xeon 600か。生成AI需要でワークステーションが今熱い

2026年2月6日 12:23

高性能なCPU/GPUを搭載したワークステーションの成長が著しい。それには2つの理由がある。

1つは従来からある3D CADやCAMといった物理演算などのローカルでの実行ニーズは依然として強いこと、そしてもう1つは最新のAIモデルをローカルで実行したいというニーズの増加だ。

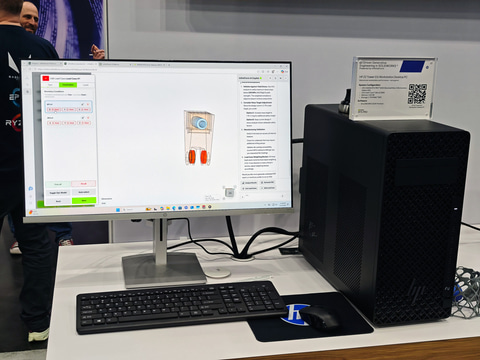

ワークステーションが3D CAD用に活用

ワークステーションとは、一般的なものよりも性能が高いCPU/GPUが採用された、プロフェッショナル向けのPCのことだ。

たとえば通常のビジネス向けノートPCでは、CPUやGPUが1チップのSoC(System on a Chip)になっており、消費電力も熱設計的にノートPCの筐体に収まる範囲に抑えられている。

それに対してHEDT(High-End DeskTop)やワークステーションでは、筐体はデスクトップのタワー、ノートPCでも大型になっており、熱設計の枠や供給電力に余裕があるため、単体のCPUやGPUが使われており、それゆえ高性能になっている。高性能なCPU/GPUであれば、処理時間を短縮でき、生産性は向上する。

AMDが昨年の6月にRyzen Threadripper 9000シリーズを発表したとき、IDCによるワークステーションの成長予測を示した。それによれば、2023年には600万台強だったワークステーションは、2029年には900万台超になるという。

PCの需要が景気動向によって増えたり減ったりすることを考えると、ワークステーションが年々増えていくという予想は、需要が年々増え続けていることを意味している。

そして冒頭からの続きだが、その成長の理由は2つある。

1つは、従来からあるプロフェッショナル向けの3D CADやCAMといったツールの需要が依然として強いことだ。

具体的には、自動車メーカーや航空機メーカーでは、自動車や航空機を仮想空間で設計する「デジタルツイン」と呼ばれる設計方法が取り入れられており、そうした製造業がワークステーションを購入しているのだ。

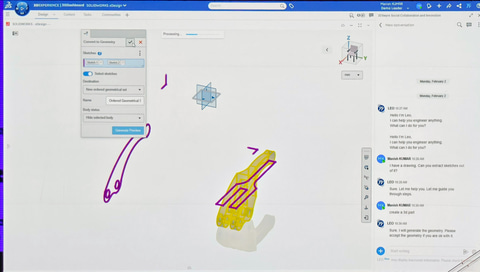

3D CADもAIによる支援機能の実装がはじまる

3D CADのソフトウェアベンダー最大手となるダッソー・システムズは、2月1日~2月4日に年次イベント「3DEXPERIENCE World 2026」を開催し、同社の戦略などに関して説明した。

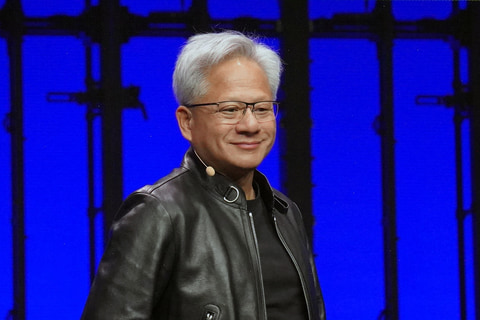

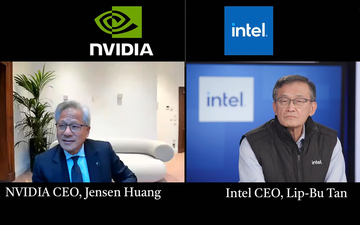

その中で目玉となったのは3日目に行なわれたGeneral Session(基調講演に相当)に、NVIDIAのジェンスン・フアンCEOが登壇し、NVIDIAがダッソー・システムズとの提携関係を強化するという発表を行なったことだ。

ダッソー・システムズは、3D CAD業界におけるMicrosoftやAdobeといったポジションに相当するトップシェアの企業だ。同社のCATIAやSOLIDWORKSは、3D CAD界のWordやPhotoshopといえるだろう。

実際、日本では永続ライセンスとして販売されている3D CADアプリケーションのシェアの半分がSOLIDWORKSになっており、現状もっとも使われている3D CADアプリケーションだ。

CATIAは自動車や航空機・ロケットなどの設計に、SOLIDWORKSは産業機械、PCやスマートフォン、医療機器、工場の製造装置の設計に利用されており、デジタル上で設計されたあと、試作機に落とし込まれて、製品化されるというのが現在の製品デザインのプロセスになる。今使われているスマートフォンやノートPCも、そうした3D CADアプリケーションで設計され、そのデータを元にして実機が作成されているのだ。

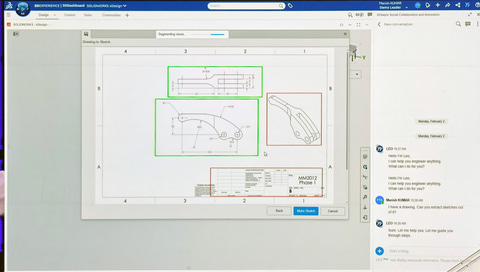

今回、ダッソー・システムズはCATIAやSOLIDWORKS向けの「生成3DモデルAI」とでも言うべきAIモデル/エージェントの構想を発表し、そのデモを行なった。簡単に言うと、PDFのファイル形式になっている2Dの設計図などから、生成AIが3Dモデルを作成し、数値もAIが入れてくれる。

クリエイターの世界でたとえれば、以前は人間が長い時間をかけて手作業しないといけなかったPhotoshopでの被写体の切り抜き作業が、AIの登場で一気に作業時間を省けるようになった。これと同じことが、今後は3D CADの世界でも起こるわけだ。

大規模な生成AIモデルをローカルで実行するためのワークステーション

ワークステーションが今注目されている理由の2つ目だ。

今回ダッソー・システムズが発表した「生成3DモデルAI」はクラウド側で作業しているが、すでに公開されているオープンソースのAIモデルをローカルのハードウェアでやりたいというニーズが最近激増しているのだ。

それに伴って高性能なCPUやGPUを搭載したワークステーションの価値が見直されている。たとえば画像生成を高速化・高品質化して、それをプロがコンテンツ作成に利用するといった具合だ。

現在のAIモデルはそれが可能になりつつあるので、オープンソースのAIモデルを利用して、すでにそうしたことはじめている先進的なユーザーも存在している。

とはいえ、パッケージソフトとしてAIモデルを含むものの登場が待たれている状況でもある。SOLIDWORKSの今回の発表はそうした道への第一歩といえる。

実際こうした状況を受けて、PCメーカーもワークステーションのラインナップ充実させはじめている。すでにワークステーションを展開しているDell、HP、Lenovoのようなトップ3メーカーがそうだ。

今回3社は3DEXPERIENCE World 2026の展示会場(Playground)に出展し、同時にイベントのスポンサーになり、SOLIDWORKSやCATIAのユーザーという「潜在顧客」に対して盛んにアピールしていた。

また、これまでワークステーションとは無縁の存在だったRazerも、1月に開催されたCES 2026でデスクトップタイプのワークステーションを発表し、それらを3台一組にするラックなども発表している。

このように、伝統的なPCベンダーだけでなく、Razerのようなどちらかといえば新興のメーカーもワークステーションに取り組んでいるところがトレンドの象徴といえる。

将来はデータセンター向けGPUもワークステーションに展開される可能性も

PCメーカーだけでなく、CPUやGPUを供給する半導体ベンダー側もワークステーション向けラインナップの拡充を図っている。

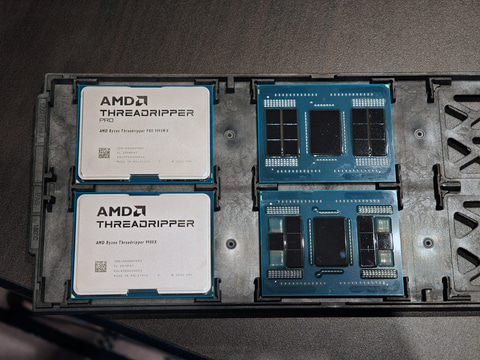

すでに述べた通り、AMDは昨年の6月にワークステーション向けのRyzen Threadripper 9000シリーズ(開発コードネーム: Shimada Peak)を発表している。

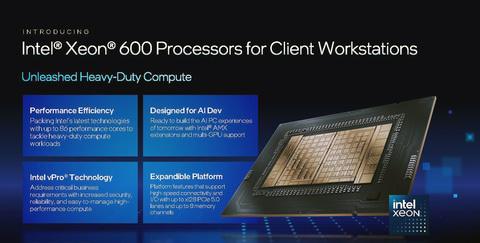

Intelは3DEXPERIENCE World 2026の実質的な初日となる2日目(2月2日)に、新しいワークステーション向けCPUとなるXeon 600シリーズプロセッサを発表した。開発コードネームはGranite Rapids-Wで、ざっくり言うとサーバー向けのXeon 6(Granite Rapids)のワークステーション版という位置づけだ。

なお、Granite Rapidsには、Granite Rapids-AP(CPUソケットがLGA7529)のXeon 6900シリーズと、Granite Rapids-SP(同LGA4170)のXeon 6700/6500シリーズのCPUソケットの違いで2製品があるが、Granite Rapids-Wは基本的にはGranite Rapids-SPのワークステーション版だ。

CPUコア数は最大86コアで、メモリのチャンネル数は8チャンネル。DDR5-6400のR-DIMMや2つのランクに対応することでメモリ帯域幅を倍にするMRDIMMを利用できる。

Xeon 600シリーズのSKUは以下の通りで、696X(64コア)、678X(48コア)、676X(32コア)、658X(24コア)、654(18コア)の製品がボックス版として提供され、それ以外はOEMメーカー向けのトレイになる。

| プロセッサナンバー | CPUコア数 | ターボブースト最大クロック | ターボブースト(全コア) | ベース周波数 | L3 Cache (MB) | ベースTDP | 倍率アンロック | メモリチャンネル | DDR5データレート | MRDIMMデータレート | vPro対応 | PCIe 5.0 レーン | ボックス製品 | 1000個ロット時価格 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 698X | 86 | 4.8GHz | 3GHz | 2GHz | 336MB | 350W | アンロック | 8 | 6400 | 8000 | 対応 | 128 | - | 7,699ドル |

| 696X | 64 | 4.8GHz | 3.5GHz | 2.4GHz | 336MB | 350W | アンロック | 8 | 6400 | 8000 | 対応 | 128 | あり | 5,599ドル |

| 678X | 48 | 4.9GHz | 3.8GHz | 2.4GHz | 192MB | 300W | アンロック | 8 | 6400 | 8000 | 対応 | 128 | あり | 3,749ドル |

| 676X | 32 | 4.9GHz | 4.3GHz | 2.8GHz | 144MB | 275W | アンロック | 8 | 6400 | 8000 | 対応 | 128 | あり | 2,499ドル |

| 674X | 28 | 4.9GHz | 4.3GHz | 3GHz | 144MB | 270W | アンロック | 8 | 6400 | 8000 | 対応 | 128 | - | 2,199ドル |

| 658X | 24 | 4.8GHz | 4.3GHz | 3GHz | 144MB | 250W | アンロック | 8 | 6400 | - | 対応 | 128 | あり | 1,699ドル |

| 656 | 20 | 4.8GHz | 4.5GHz | 2.9GHz | 72MB | 210W | - | 8 | 6400 | - | 対応 | 128 | - | 1,399ドル |

| 654 | 18 | 4.8GHz | 4.5GHz | 3.1GHz | 72MB | 200W | - | 8 | 6400 | - | 対応 | 128 | あり | 1,199ドル |

| 638 | 16 | 4.8GHz | 4.5GHz | 3.2GHz | 72MB | 180W | - | 4 | 6400 | - | 対応 | 80 | - | 899ドル |

| 636 | 12 | 4.7GHz | 4.5GHz | 3.5GHz | 48MB | 170W | - | 4 | 6400 | - | 対応 | 80 | - | 639ドル |

| 634 | 12 | 4.6GHz | 3.9GHz | 2.7GHz | 48MB | 150W | - | 4 | 6400 | - | 対応 | 80 | - | 499ドル |

GPUに関しては昨年の3月に開催されたGTC 25において、NVIDIAはBlackwellベースのRTXとなるRTX Proシリーズを発表している。現状のRTX/RTX Proは、基本的にゲーミング向けのGeForceをベースにして、それをワークステーション向けにリファインした製品となる。

このため、マルチGPU構成で利用する場合には、GPUとGPUを接続するバスは、データセンター向けのBlackwellで利用されているNVLinkではなくPCI Expressになる。IntelやAMDが、それぞれのGPUで実現しているAI推論用のマルチGPUソリューションでも、現状はPCI Expressがその接続バスとして利用されている。

現状、このことはあまり大きな問題にはなっていないが、将来的にはPCI Expressがボトルネックとなる可能性がある。

というのも、仮に複数のGPUをまとめて演算する場合、ほかのGPUにあるメモリのデータをDMA転送しなければ、CPUやGPUにかかる処理が増えて、本来の性能を引き出せない可能性があるからだ。

GPUとGPUを接続するインターコネクトであるNVLinkではそうしたことが最初から考慮されているので、仮に将来もっとGPUを並列に接続して利用するようなソリューションを考えた場合、ワークステーションでもNVLinkを利用できるようなハードウェア設計にしていく必要があるだろう。

すでにIntelはNVIDIAのデータセンター向け製品向けのカスタムCPUでNVLinkをサポートする計画を明らかにしている。そのため、近い将来に、そうした製品がデータセンター向けだけでなくワークステーション向けにも何らかの形で降りてくる可能性は十分にある。AIをローカルで実行したいプロフェッショナルユーザーは業界の動向に注意を払っておいた方がいいだろう。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:2位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【整備済み・本体のみ】2023モデル Lenovo 14型 14e Chromebook Gen 3 [82W7S09H00] (第14世代Intel N100/ メモリ4GB/ eMMC64GB/ 無線LAN/フルHD1920*1080/ 5G Softbank/ Webカメラ/ Chrome OS)超軽量SoftBank版 グレー【日曜日以外即日発送】【送料無料】 製品画像:19位](https://thumbnail.image.rakuten.co.jp/@0_mall/keitai-god2a/cabinet/11328061/aaaa.jpg?_ex=128x128)

![HP ProBook 450 G9 (Win11x64) 中古 Core i5-1.3GHz(1235U)/メモリ16GB/SSD256GB/フルHD15.6/Wi-Fi6対応/Webカメラ [B:良品] 2023年頃購入 製品画像:11位](https://thumbnail.image.rakuten.co.jp/@0_mall/usedpc/cabinet/url1/5726308b.jpg?_ex=128x128)

![JAPANNEXT|ジャパンネクスト PCモニター JN-215IPS120F-HSP [21.5型 /フルHD(1920×1080) /ワイド /120Hz] 製品画像:10位](https://thumbnail.image.rakuten.co.jp/@0_mall/biccamera/cabinet/product/16057/00000014845729_a01.jpg?_ex=128x128)

![小学6年生がおしえる 天国のくらし [ うみ ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1252/9784815641252_1_2.jpg?_ex=128x128)

![お気楽領主の楽しい領地防衛 8【電子書籍】[ 青色まろ ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/3480/2000019753480.jpg?_ex=128x128)

![【楽天ブックス限定特典】INI 2nd写真集 「Viva la vita」(限定カバー+ランダムトレカ1枚(全11種)) [ ISAC/Shuhei Tsunekawa ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1108/9784065431108_1_3.jpg?_ex=128x128)

![anuans Special Bag Book [ anuans ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/6007/9784299076007_1_3.jpg?_ex=128x128)

![[新品]オーイ!とんぼ (1-60巻 最新刊) 全巻セット 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/mangazenkan/cabinet/syncip_0059/m8277470511_01.jpg?_ex=128x128)

![勝利の女神:NIKKE 公式設定資料集 [ ファミ通書籍編集部 ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/7015/9784047337015_1_6.jpg?_ex=128x128)

![STAGE navi vol.109 [ 産経新聞出版 ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/noimage_01.gif?_ex=128x128)