笠原一輝のユビキタス情報局

Armの新しいCPU「C1」は2桁パーセントの性能アップ。電力効率も大幅改善

2025年9月10日 11:41

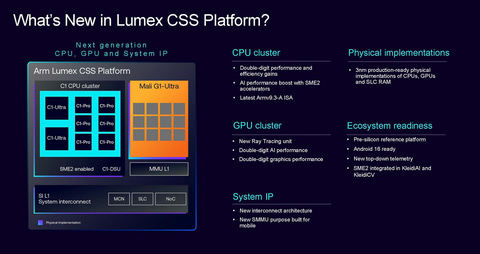

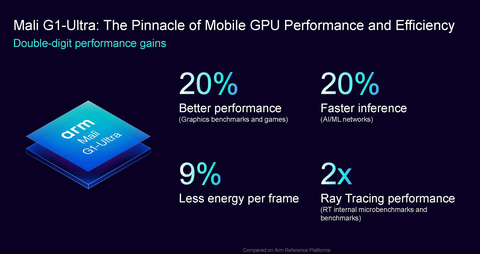

英Armは9月10日、同社のクライアントデバイス向けの新しいIPスイート群となる「Arm Lumex CSS Platform」(以下Lumex)を発表した。Lumexは新しいCPU「C1」、新しいGPU「Mali G1」などのIPデザインから構成されており、従来世代の製品と比較して2桁パーセント以上の性能向上を実現する。

今回Armは報道関係者を対象としたセミナーを開催し、詳細を説明した。本リポートではこれらのCPUやGPUについて解説していきたい。

単体のCPU/GPU提供から、それらをセットにしたCSSへと移行を進めるArm。ブランド名も刷新

今回のArmの発表では、プラットフォームのブランド名も、CPUおよびGPUのブランド名も変更されている。過去の世代も含めてそれぞれの変遷をまとめると以下のようになっている。

| プラットフォーム名称 | Lumex CSS Platform | CSS for Client | TCS23 | TCS22 | TCS21 |

|---|---|---|---|---|---|

| 発表年 | 2025年 | 2024年 | 2023年 | 2022年 | 2021年 |

| CPU命令セット | Armv9.3-A | Armv9.2-A | Armv9.2-A | Armv9-A | Armv9-A |

| 拡張命令(SVE/SVE2) | ○ | ○ | ○ | ○ | ○ |

| 拡張命令(SME2) | ○ | - | - | - | - |

| CPUプライムコア | C1-Ultra | Cortex-X925 | Cortex-X4 | Cortex-X3 | Cortex-X2 |

| CPUサブプライムコア | C1-Premium | - | - | - | - |

| CPU高性能コア | C1-Pro | Cortex-A725 | Cortex-A720 | Cortex-A715 | Cortex-A710 |

| CPU高効率コア | C1-Nano | Cortex-A520 | Cortex-A520 | Cortex-A510 | Cortex-A510 |

| DSU | C1-DSU | DSU-120 | DSU-120 | DSU-110 | DSU-110 |

| GPU(最高構成) | Mali G1-Ultra | Immortalis-G925 | Immortalis-G720 | Immortalis-G715 | Mali-G10 |

| プロセスノード最適化 | 3nm | 3nm | 4nm | 4nm | 5nm |

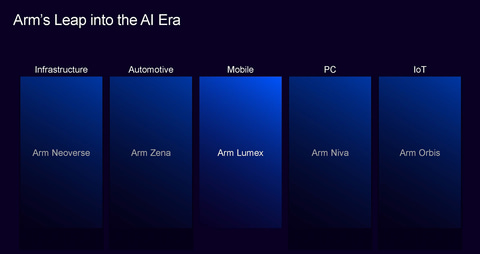

命名規則としては、まずプラットフォームに特定のブランド名が付けられ、CSSやTCSといった名称がその後ろに付けられる形になっている。これは、Armが5月に発表した新しいブランド戦略に基づくもので、サーバー向けはNeoverse、自動車向けはZena、PC向けはNiva、IoT向けはOrbisであると明らかにされている。Armは自動車向けのZenaをすでに発表しており、今回のモバイル向けのLumexはそれに続く第2弾ということになる。

なお余談になるが、PC Watchの読者としてはPC向けのブランドとしてNivaが用意されていることにも注目すべきだろう。これまでArmはモバイル向けの中にPC向けも含むと説明してきたが、今回のLumexではChromebookをサポートすると説明したものの、Windowsに関しては何も触れていなかった。

つまり、Nivaの発表がされると、現状QualcommのSnapdragon Xシリーズの1つしか選択肢のないArm版Windows(Windows on Arm、WoA)向けSoCが、そうではなくなる可能性が高いということだ。

話を本筋に戻すと、Armはそのようにプラットフォームレベルでのブランドを強化したが、逆にCPUとGPUに関しては簡素化した。CPUに関しては、長年モバイルユーザーに親しまれてきたCortexのブランド名が消滅し、単に「C」と世代を示す「1」を組み合わせて「C1」と呼ばれることになった。

これはGPUも同様で、前世代まではImmortalisのブランド名がフラグシップ向けに使われてきたが、今回は以前のMaliに戻され、同時に「G」と「1」という世代を示す数字が付けられ「Mali G1」というブランド名に変更されている。Armによれば、ユーザーなどに調査した結果、ImmortalisよりもMaliの方が、認知度が高くシンプルであるためこのような変更を行なったということだった。

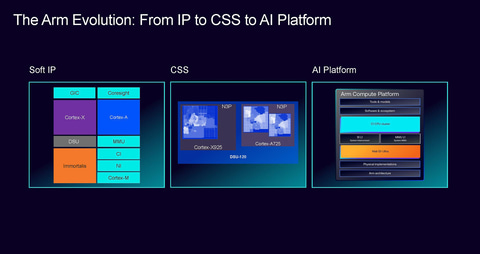

Armがこうしたプラットフォーム強化のブランド戦略をとるのは、それがArmとしてのビジネス戦略を象徴しているからだ。ArmのビジネスはCPUのISA(命令セットアーキテクチャ)を提供するビジネスから始まったが、そこからCPUのIPデザインを提供する形に発展。それをGPU、チップ間インターコネクト、メモリコントローラと、提供するIPデザインの種類を徐々に拡大していき、顧客がそれらを組み合わせてSoCをより簡単に設計できるようにしてきた。

さらにArmは、ファウンダリが提供するプロセスノード(たとえばTSMCの3nmなど)への落とし込みもデータとして提供してきた。これにより、顧客となる半導体メーカーは従来よりも迅速にSoCを設計し、実際の製造までより早くこぎ着けるようになっている。

従来Armは、こういったIPデザインをそれぞれ別のライセンスとして提供してきたが、CSS(当初はTCSだったがその後CSSに)という名称でIPスイートとしてセット提供を始めた。セットにすることで、単体で提供するよりも安価にでき、顧客にとって魅力的な価格になる一方、Armにとっても全体として売り上げが伸びるという仕組みだ。ハンバーガーチェーンがハンバーガー単体よりもセットメニューに力を入れるのと同じ理屈になる。

そのため、Armとしてはセット販売に力を入れており、Lumexのようなプラットフォームのブランドを強化し、逆にIPデザインの方はよりシンプルにするという戦略をとることになったのだ。

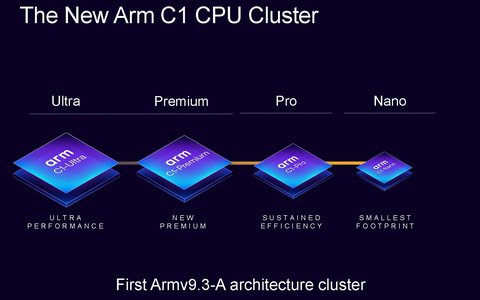

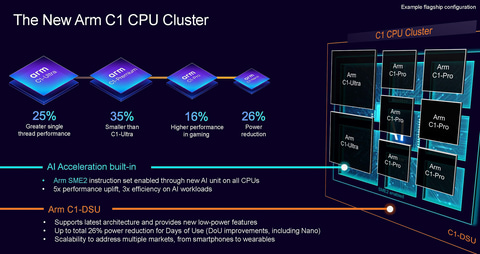

プライムコアのC1-Ultraは、フロント/バックエンドの改良でIPCが2桁向上

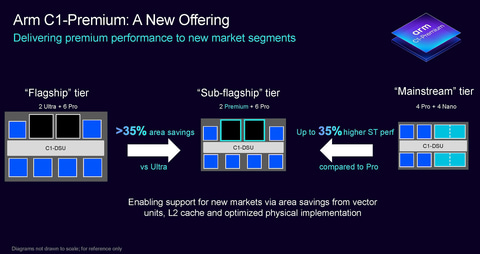

今回のLumexのCPUとして提供されるCortex改めC1には、「Ultra」「Premium」「Pro」「Nano」という4つのグレードが用意される。2024年版のCSS for Clientでは、プライムコアがCortex-X925、高性能コアがCortex-A725、高効率コアがCortex-A520という3つのグレードだったため、1つグレードが増えたことになる。

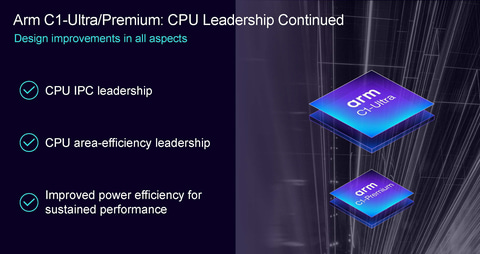

最上位のフラグシップコアあるいはプライムコアと呼ばれるC1-Ultraは、2024年のCSS for ClientのプライムコアだったCortex-X925の後継製品となる。近年のArm CPUのプライムコアは、IPCを引き上げ、クロック周波数を高める設計がなされるのが一般的で、それによりシングルスレッド時の性能向上を目指している。今回発表されたC1-Ultraもその延長線上にある製品だ。

Armのプライムコアはここ6年、以下のような形で進化してきた。

| プライムコア | C1-Ultra | Cortex-X925 | Cortex-X4 | Cortex-X3 | Cortex-X2 | Cortex-X1 |

|---|---|---|---|---|---|---|

| 登場年 | 2025 | 2024 | 2023 | 2022 | 2021 | 2020 |

| ISA | Armv9.3-A | Armv9.2-A | Armv9.2-A | Armv9-A | Armv9-A | Armv8.3-A |

| 拡張命令(SVE/SVE2) | ○ | ○ | ○ | ○ | ○ | - |

| 拡張命令(SME2) | ○ | - | - | - | - | - |

| ターゲットクロック周波数 | 4.1GHz以上 | 3.6GHz以上 | 3.3GHz | 3.2GHz | 3GHz | 3GHz |

| デコード長 | 10 | 10 | 10 | 6 | 5 | 5 |

| ディスパッチ/サイクル | 10 | 10 | 10 | 8 | 8 | 8 |

| ALU | 8 | 8 | 8 | 6 | 4 | 4 |

| FP/SIMD | 6 | 6 | 4 | 4 | 4 | 4 |

| L1データ | 128KB | 64KB | 64KB | 64KB | 64KB | 64KB |

| L1命令 | 64KB | 64KB | 64KB | 64KB | 64KB | 64KB |

| L2 | 2MB/3MB | 2MB/3MB | 512KB/1MB/2MB | 512KB/1MB | 512KB/1MB | 512KB/1MB |

| L3 | 0~32MB | 0~32MB | 0~32MB | 0~16MB | 0~16MB | 0~16MB |

ここ数年で一番大きな進化を見せたのは2023年のCortex-X4で、ALU(整数演算器)が6基から8基に増加し、大きく性能が向上したあたりだ。さらに2024年のCortex-X925では、FP/SIMDの演算器が4基から6基に増え、ターゲットクロック周波数も、Cortex-X4では3.3GHzだったのが、Cortex-X925では3.6GHz以上に引き上げられている。たとえばMediaTekのDimensity 9400+では、Cortex-X925は3.75GHzというクロック周波数を実現している。

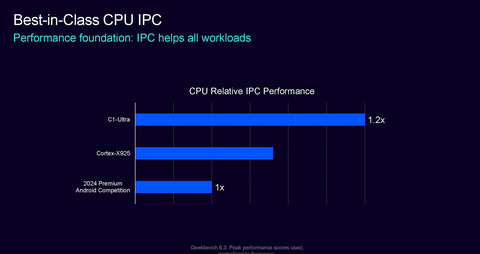

Armによれば「2024年の競合他社のプレミアムAndroidスマートフォン」に搭載されたSoC(おそらくSnapdragon 8 Gen 3のこと)と同じクロック周波数で比較すると、Cortex-X925の段階で性能が上回っており、C1-Ultraでは20%ほど上回っていると述べている。同じクロック周波数でという前提条件を取ると、Cortex-X925はQualcommのSnapdragon 8やApple Aシリーズに匹敵するようなシングルスレッド性能を実現しているということができるだろう。

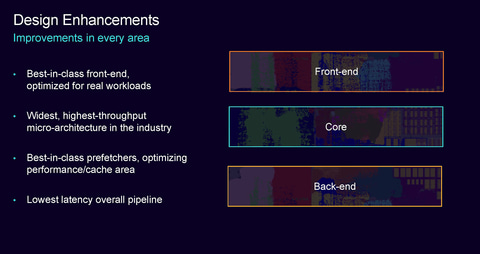

今回のC1-UltraはそうしたCortex-X925の成功を受け継いでいる。CPUの設計と言えば、フロントエンド(フェッチやデコーダ、分岐予測)、コア(ALUやFP/SMIDなどの実行ユニット)、バックエンド(ロード/ストアなどのデータの出し入れ)などから構成されているが、Armによれば今回のC1-Ultraのコアは、ほぼCortex-X925のそれを引き継いでいる。デコード長やクロック周波数あたりのディスパッチ、さらにALUやFP/SMIDなどの演算器に関しても同等だという。

今回ArmはC1-Ultraの内部構造のブロック図を公開しなかったため、ALUやFP/SMIDの演算器がそれぞれいくつあるのかは、Armが製品発表後に公開する「Software Optimization Guide」などを待つ必要があるが、説明をそのまま受け取れば、ALUやFP/SIMDの演算器はCortex-X925と同じだと考えていいだろう。

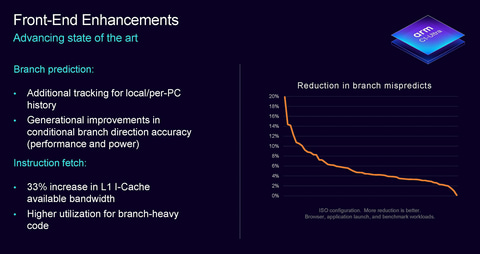

一方、C1-Ultraのフロントエンドでは主に分岐予測の精度を高める改良が加えられている。具体的には分岐予測の過去の履歴などをより詳細分析し、それにより正確性を上げることで性能や電力効率などを改善している。また、L1命令キャッシュの帯域幅が33%増加したことで、命令とのフェッチをより高速に行なうことが可能になる。

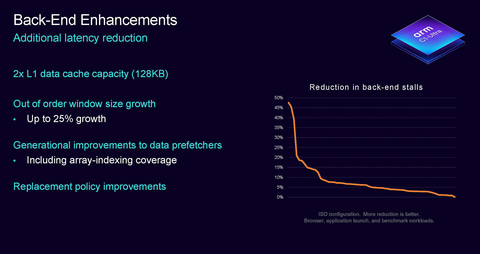

バックエンドでは、L1データキャッシュの容量が従来までの64KBから128KBに増えている。これまでキャッシュ容量はCortex-X1からCortex-X925までの5世代にわたって、データ64KB、命令64KBの合計128KBとなっていたが、C1 Ultraではデータが128KBに層化して、合計192KBになっている。

L1データキャッシュが増えるメリットは、シンプルにメモリレイテンシの削減だ。キャッシュは、CPUがメモリからのデータを待っている間、待機状態になることを防ぐために階層化しているものだ。そのためキャッシュサイズが増えることは、それだけメモリからデータが読み出されるまでの待ち時間が減ることにつながり、その効果は小さくない。

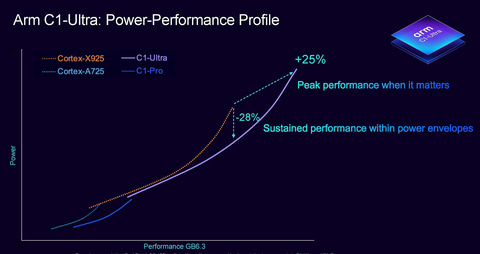

こうした改良により、従来世代と比較してピーク性能は25%向上し、同性能であれば消費電力は28%減少しているという。すなわち、電力効率が向上しているのがC1-Ultraのメリットとなる。

C1-UltraのFP/キャッシュ削減版となるC1-Premium。高性能コアC1-Proと高効率コアC1-Nanoも順当進化

今回新たに追加されたサブプライムコアとなるC1-Premiumは、基本的にはC1-Ultraの設計を利用しているが、FP/SMID演算器の数を減らしたことと、L2キャッシュのサイズを抑えたことにより、ダイ面積が35%削減されたのが特徴だ。Armは具体的にどの程度演算器やキャッシュ容量を減らしたのかを明らかにしていないが、ダイサイズが約3分の1減っているとなると、思い切ってFP/SIMD演算器、キャッシュのどちらも3分の1(ないしはそれ以上)減らしている可能性がある。

C1-UltraのFP/SIMD演算器は6基、L2キャッシュは2MB~3MBになっていると考えられるので、FP/SIMD演算器は4基、L2キャッシュは1MB~2MBあたりの設定になっていると考えるのが妥当なところだろう(このあたりもC1 PremiumのSoftware Optimization Guideなどの公開を待ちたいところだ)。こうした設計により、C1 Premiumはダイ面積を35%削減しながら、C1-ProとC1-Nanoで構成されている場合に比較して、35%性能が向上しているとArmでは説明している。

MediaTekのDimensity 9400シリーズでは、高クロックなCortex-X925が1コア、通常クロックのCortex-X925が3コアと、X925を合計4コア使ったプライムコア1基+サブプライムコア3基という構成になっていたが、仮に2025年もC1-UltraとC1-Premiumで4コア構成にするならば、C1-Ultra 1基とC1-Premium 3基という構成が可能になるだろう。それによりダイサイズを抑さえ、消費電力を削減しつつ、高性能化を実現できることになる。

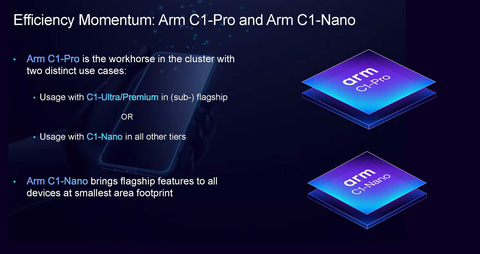

最後にC1-ProとC1-Nanoはそれぞれ、従来高性能コアとして提供されてきたCortex-A725、高効率コアとして提供されてきたCortex-A520の後継となるCPUだ。C1 Proは、C1-Nanoほどは性能が低くなく、C1-Ultra/Premiumほどはダイサイズが大きくならないという点で、通常使いができるCPUコアとなる。それによりコア数を稼いで、マルチスレッド処理を効率よく行なえる。

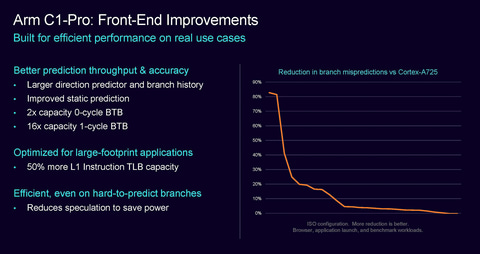

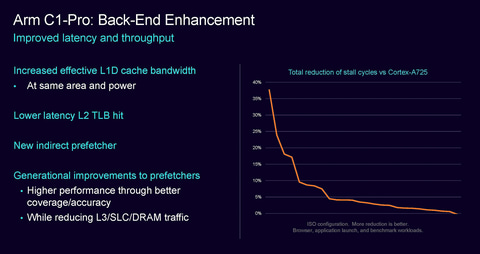

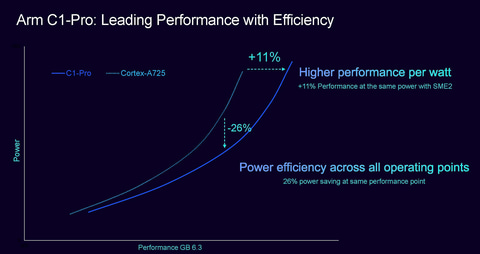

C1-Proも、フロントエンドとバックエンドの改良が顕著。フロントエンドでは分岐予測のスループットや正確性の向上、L1命令TLBの50%増量、さらには分岐予測時の電力削減などが実現されている。バックエンドではL1データキャッシュの帯域幅の増加、新しいインダイレクトプリフェッチャなどの導入より、L3キャッシュやDRAMとの混雑回避などが可能になっている。

こうした強化により、Cortex-A725と比較して性能では11%の向上、同じ性能であれば26%の消費電力削減を実現している。

C1-Nanoは、FP/SIMDユニットを拡張しているほか、L3/DRAMへのアクセス混雑を21%削減するなどして実行効率を高めており、電力効率をA520に比べて26%改善している。

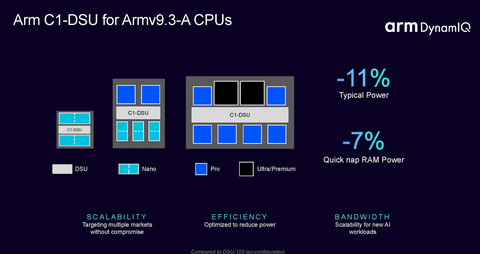

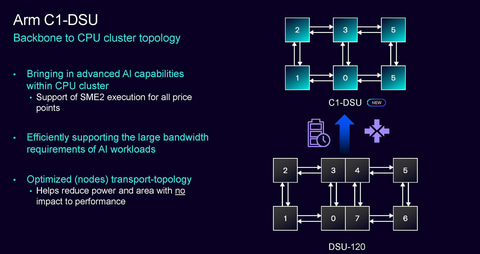

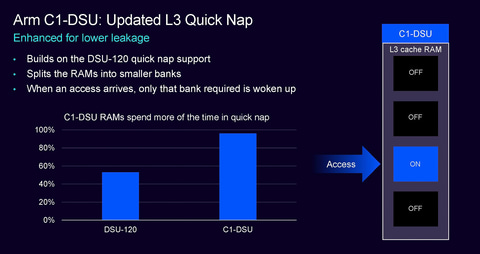

さらに、こうしたC1シリーズのチップ間インターコネクトとなる「C1-DSU」は、前世代のDSU-120と比較して、CPUのクラスタトポロジー(接続方法)やL3キャッシュの搭載方法を変更しており、性能に影響を与えずに消費電力を削減することに成功している。

なお、従来と同じように物理的なコア数の限界は最大14コアになっており、その範囲内でC1のそれぞれのグレードを利用してさまざまな組み合わせが可能になっている。

Armが示した例では、C1-Nanoの2コアという最小構成から、C1-Ultra 2コアとC1-Pro 6コアによる8コア構成など、さまざまな構成が紹介されており、伸縮可能なアーキテクチャになっていることも大きな特徴だ。この場合だと前者に比べて後者は17倍の性能を発揮できるという。

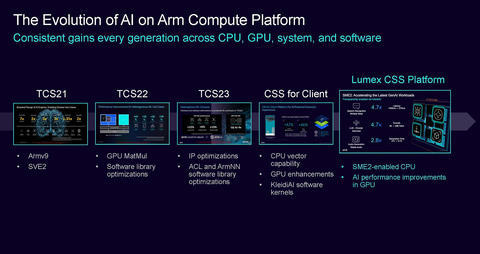

C1シリーズの全グレードがSME2に対応。ソフトウェアの対応で約5倍の性能向上を実現

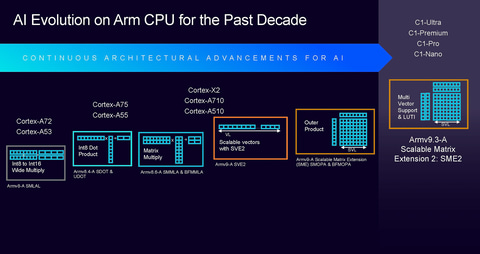

今回のLumexにおけるC1シリーズは、すべてのグレードのCPUがArmv9.3-Aの命令セット、そして拡張命令セットとなるSME2に対応している。特に大きな変化はSME2に対応したことになる。

Armは、ISAを世代ごとに定義しており、今回のC1シリーズではArmv9.3-Aで定義されているArmの64bit命令セットに対応している。拡張命令セットは、このISAの枠外として定義されているもので、Neon、SVE/SVE2、そして今回のC1で対応が明らかにされたSME/SME2などが用意されている。

一般的なPCで採用されているx86命令セットでも、64bitの命令セットがAMD64(Intelの言い方ではIntel 64)として定義されており、それとは別にSIMD系の拡張命令としてSSE、AVX、AMXと定義されている。Neon、SVE、SMEはそれと同じようなものだと理解すれば分かりやすいだろう。

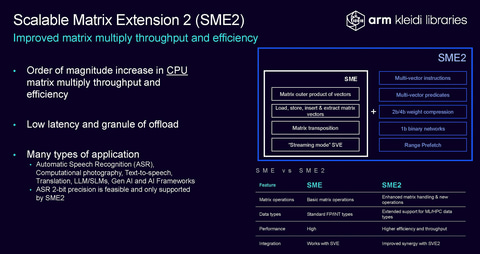

C1シリーズが対応したSME2は、そうしたArmのSIMD系拡張命令の最新版で、最大の特徴はいわゆる行列乗法と呼ばれる、複数の行列をまとめて一度に演算できることになる。

SME2はその名称からも分かるようにSMEの第2世代になる。初代のSMEはApple M4など、他社の自社設計CPUで採用例があったが、実はこれまでArmのCortex系のCPUでは対応してこなかった。このため、今回C1シリーズのSME2対応は、ArmデザインのCPUとしては初めての取り組みになる。

ではなぜArmのCortexでは、第1世代のSMEに対応してこなかったのだろうか。Armによれば「SMEはどちらかと言えばHPC/AI学習に特化したような拡張命令になっており、クライアント向けのCortexには必要ないと判断してきた。しかし、SME2ではAI推論に対応した命令セットが追加されており、クライアント向けのCシリーズに実装する意味があると判断した」と説明する。

SMEはHPCやAI学習向け、つまりサーバー向けのCPUで効果がある命令セットとして定義されていたが、SME2はいくつかの機能追加によりAI推論にも利用できるようになったため、今回のC1シリーズに採用したということになる。

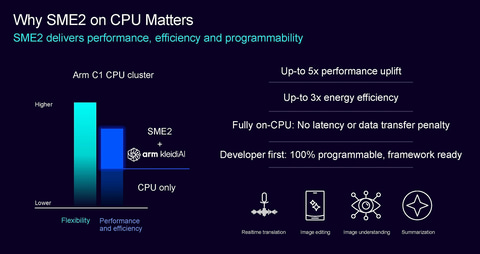

SME2は、SMEで実現された機能に加えて、複数の浮動小数点の行列を処理できるような命令などが加わっており、一度により多くの行列を処理することが可能。これにより性能を向上させながら、同時に電力効率を改善できるところが特徴となっている。Armによれば最大5倍の性能を実現しながら、同時に3倍の電力効率を実現するという。特にAIではこうした行列演算を行なうことが多いため、AIアプリケーションで大きな効果があると説明している。

ただし、SME2を活用するには、ソフトウェア側で明示的にSME2に対応する必要があり、つまりその5倍の性能向上を実現するには、アプリケーション側の対応が求められることになる。

しかしArmによれば、Androidアプリケーションの中には、Armが提供するAIアプリケーション実現のためのミドルウェアである「KleidiAI」を組み込んでAI処理を行なっている例が多いという。この場合、ソフトウェアベンダーがKleidiAIをSME2に対応したバージョンにアップデートするだけで、アプリケーションはAI演算をSME2で実行できるようになる。それにより、最小限の改良だけでSME2のメリットを享受できると説明している。

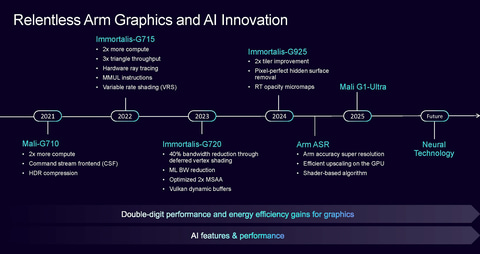

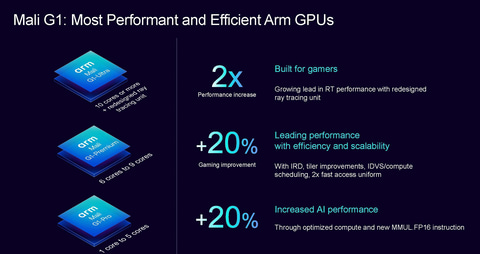

Mali G1はG720、G925に引き続き第5世代GPUベース。レイトレ性能は2倍に

今回Mali G1に名称が変更されたGPUだが、基本的なアーキテクチャは2023年に導入されたImmortalis-G720、24年に導入されたImmortalis-G925で採用されてきた、Armの第5世代GPUの進化版となる。第5世代GPUでは、タイル型のシェーダーエンジンを最大24コア構成にできるような伸縮可能な設計となっており、それは今回のMali G1でも変わっていない。

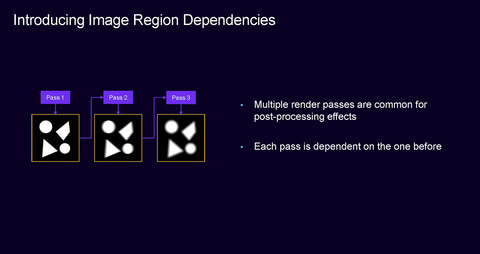

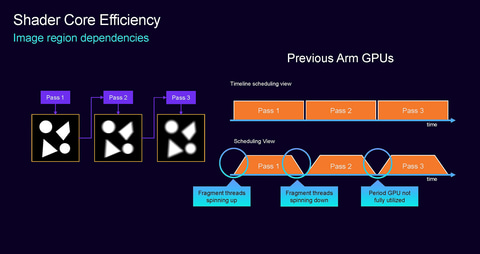

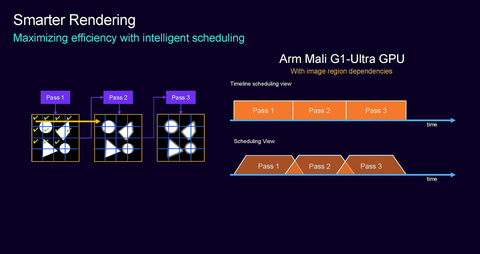

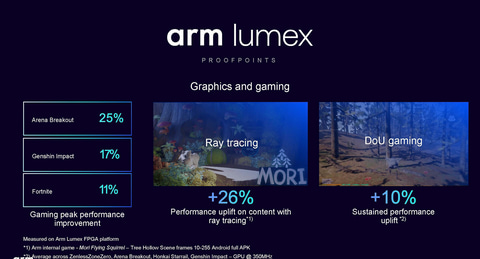

ただし、シェーダー内部の実行効率を高める最適化は続けられており、新しく導入された「Image Region Dependencies」により、レンダリング時の処理効率が上がり、同じ処理をより短い時間で実行できるようになっている。こうした改良により、前世代に比べて20%ほどGPU全体の性能が向上しているとArmは説明している。

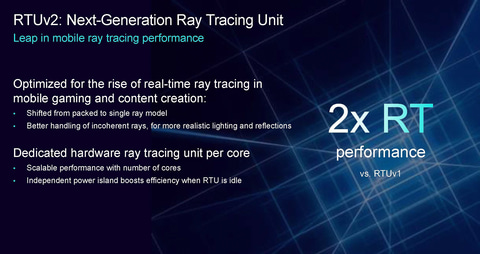

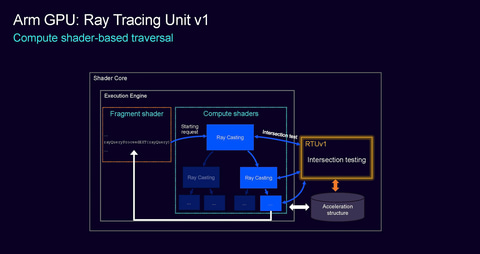

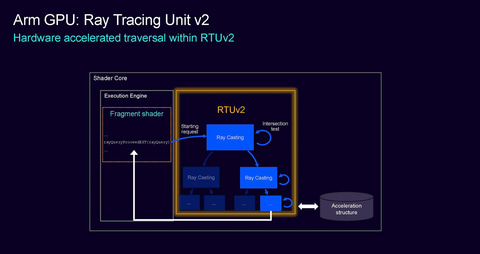

では、大きな強化点はどこなのかと言えば、それがImmortalis-G925で導入されたハードウェア・レイトレーシングユニット(RTU)が第2世代に進化していることだ。Armの従来のRTUでは、レイトレーシングの処理を行なう時にシェーダーエンジンの外側に用意されているRTUを利用して処理を実行し、その結果をシェーダーエンジンに返す仕組みになっていた。しかし、第2世代RTUではシェーダーエンジンの内部でレイトレーシング処理ができるようになり、同じレイトレーシングの処理でも実行効率が高まっている。これにより、RTUの性能は2倍に高まっている。

この進化はRTUの内部での進化であって、ソフトウェア側の対応は必要ない。ソフトウェア側ではレイトレーシングの一般的なAPI(Android OSの場合はVulkan)に対応していれば活用できるため、特に改修する必要はない。つまり、既にImmortalis-G925のRTUに対応したゲームで遊んでいるユーザーは、Mali G1を搭載したSoCに乗り換えるだけでその恩恵を得ることができる。

なお、Mali G1では、既にArmが発表しているGPUへのニューラルアクセラレータの導入は見送られている。今回、次世代以降にこの導入を予定しているが明らかとなっており、2026年版のLumexでの対応が見込まれる。

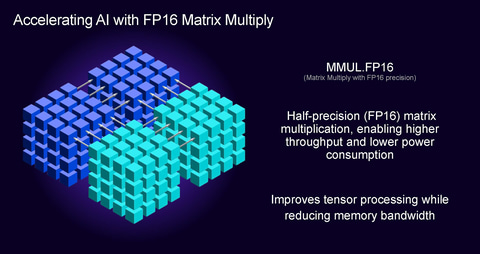

ただし、従来はFP32を利用したAI処理だけがサポートされてきたが、今回の世代ではFP16を利用したAIの処理が可能になった。アプリケーションがそれを活用することで、AI処理時にメモリ帯域を削減してスループットと電力効率を引き上げられる。

Mali G1には、シェーダーエンジンが10コアから24コアのMali G1-Ultra、6コアから9コアのMali G1-Premium、そして5コア以下のMali G1-Proという3つのグレードが用意されており、顧客となる半導体メーカーは自社製品のニーズに応じてグレードを選択することが可能だ。

FPGAでの世代間テストでは大きな性能向上を実現しているLumex

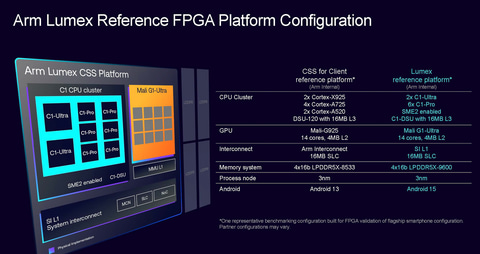

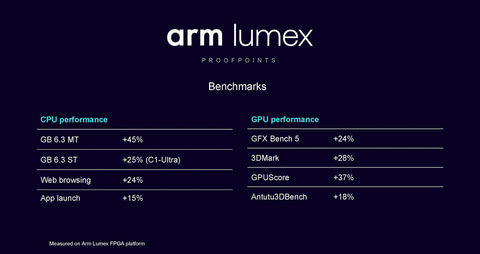

こうした設計を施した結果、Lumexの性能は従来のCSS for Clientに比較して大きく引き上げられている。Armでは、3nmのFPGAを利用して、仮想的にLumexとCSS for Clientを構成した場合のベンチマーク結果を公開している。

FPGAはソフトウェアによりさまざまな半導体を定義できるデバイスで、それを利用してLumexやCSS for Clientを仮想的にFPGA上に構築することで、世代間の違いを見るというのが目的だ。FPGAでこうしたデバイスを構成しても実際のリアルチップの性能が再現できるわけではなく、あくまでIPデザインの設計レベルでの違いを見るという意味での比較になる。

Lumexは、CPUクラスタがC1-Ultra(2コア)+C1-Pro(6コア)の8コア、GPUはMali G1-Ultra(14コア)、L3キャッシュ(SLC)は16MBとなる。それに対してCSS for Clientの方はCPUクラスタがCortex-X925(2コア)+Cortex-A725(4コア)+Cortex-A520(2コア)の8コア、GPUはImmortalis G925(14コア)、L3キャッシュ(SLC)は16MBという構成になっている。

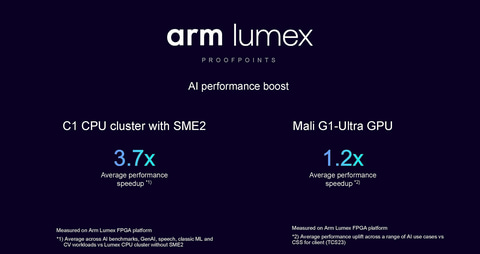

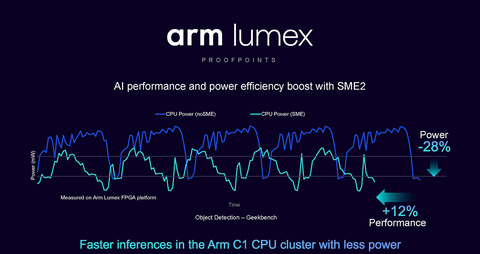

CPUの性能は、アプリ起動が15%アップで、Geekbench 6.3のマルチスレッド性能では45%と、大きな性能向上を実現している。これは、プライムコア以外のCPUコアがC1-Pro 6基となっている効果だと考えられる。また、SME2を利用した場合のCPUクラスタ全体の性能は平均して3.7倍となっており、SME2を利用した場合の性能向上幅が大きいことを示している。また、SME2を利用すると、消費電力を削減できることも特徴で、12%性能が向上しているのに対し、消費電力は28%削減されている。

このように、LumexではCPUもGPUも、改良の効果で2桁パーセント以上の性能向上を実現しており、CPU/GPUの世代間進化としては十分な向上幅を実現している。さらに、CPUはSME2という新しい拡張命令セットに対応することで、最大5倍、平均して3.7倍の性能向上を達成し、かつ電力効率は3倍になっている。特にSME2を利用できるとその性能向上幅は大きなものがあると言えると思う。

今後こうしたLumexが、MediaTekのようなArmの顧客が提供する製品に採用されることになる。市場にはAppleが設計したAシリーズ、Qualcommが設計したOryon CPU採用のSnapdragon 8シリーズなど、Armアーキテクチャを採用したオリジナル設計のArmプロセッサが既にあり、そうした製品との競争がどうなっていくかも今後の焦点と言えるだろう。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:4位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![Microsoft|マイクロソフト ノートパソコン Surface Pro 12 インチ プラチナ EP2-27651 [Copilot+ PC /12.0型 /Windows11 Home(Arm版) /Snapdragon X Plus /メモリ:16GB /UFS:256GB /M365 (24か月) or Office 選択可能 /2025年6月モデル] 製品画像:8位](https://thumbnail.image.rakuten.co.jp/@0_mall/biccamera/cabinet/product/12297/00000014074074_a01.jpg?_ex=128x128)

![超かぐや姫!(1) (ファミ通文庫) [ スタジオクロマト・スタジオコロリド ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/7348/9784047387348_1_23.jpg?_ex=128x128)

![ウィッチウォッチ 25【電子書籍】[ 篠原健太 ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/1488/2000019641488.jpg?_ex=128x128)

![4大特典つき!講談社学習まんが日本の歴史全20巻セット 22年度版 (講談社 学習まんが) [ 講談社 ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/4116/9784069494116_1_7.jpg?_ex=128x128)

![広辞苑 第7版(机上版) [ 新村 出 ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1324/9784000801324.jpg?_ex=128x128)

![小学館版学習まんが日本の歴史全20巻セット (小学館 学習まんがシリーズ) [ 小学館 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9313/9784092989313_1_3.jpg?_ex=128x128)

![ふつうの軽音部 10【電子書籍】[ クワハリ ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/1604/2000019641604.jpg?_ex=128x128)

![あっという間にお金はなくなるから 「足りない病」の原因と治し方 [ 佐藤 舞(サトマイ) ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/7837/9784046077837_1_17.jpg?_ex=128x128)