西川和久の不定期コラム

メインAI PCの2TB SSDが故障……ならばマザーボードごと交換だ!? ~2025年夏休みの工作

2025年9月3日 06:00

今年(2025年)の7月と8月は猛暑だった。その関係で熱いGeForce RTX 5090を搭載した“メインAI PC”は使わず、GeForce RTX 4090搭載の“サブAI PC”ばかり使っていた。先日久々にメインAI PCを起動すると、モデルデータが大量に入った2TB SSDの調子が悪い。そこでいろいろ気になっていた部分もあり、マザーボードごと交換した話をしてみたい。

2025年夏休みの工作

筆者が使っているメインAI PCは2023年に自作し、現在GeForce RTX 5090を搭載している。元々SSDは512GB+1TBだったが、容量不足になり2TBを後から追加(これでもギリギリ)。しかしこの夏は暑く、GeForce RTX 5090はかなり熱を持ち足元が暑くなるため、最近はGeForce RTX 3090(USB4)+RTX 4090搭載サブAI PCばかりを使っていた。ちなみにGPUモニターを見ていると、GeForce RTX 5090は80℃前後/550Wで、GeForce RTX 4090は70℃前後/450Wと、明らかにGeForce RTX 5090の方が熱を出す。

そんなある日、メインAI PCの機嫌を損ねたのか、2TB SSDの調子が悪くなった(起動直後は認識するが、少し経つと認識しなくなる)。既に容量が不足しているので4TBへ交換……と一瞬思ったのだが、考えてみれば……。

- M.2がPCIe 4.0。モデルファイルは10GB以上のことが多く、できればGen5にしたい

- メモリ最大64GB。加えてDDR4-3200。ギリギリで動くことも多く96/128GBにしたい

- PCIeが4.0。GeForce RTX 5090で最大パフォーマンスを引き出すには5.0が必要

と、いろいろ改善ポイントが脳内を駆け巡り(笑)、マザーボードごと交換することにした。選んだのはMINISFORUMの「BD790i X3D」だ。

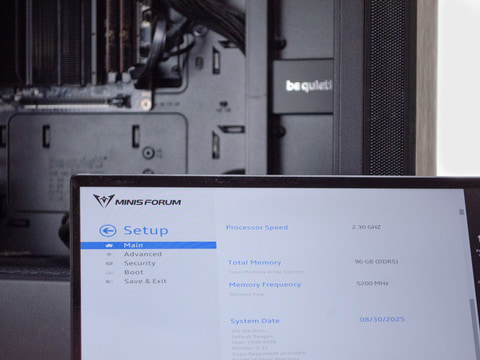

Mini-ITXマザーボード+CPUの組み合わせは、天文学的な組み合わせがあり、考えるのが大変(面倒)だったのと、上記レビューもあったため、ちょっと高いものの(10万円少し切る程度)これに決定。電源とケースはそのまま流用。メモリはDDR5-5200 SO-DIMM 48GB 2枚の96GB。これで②はクリア。

次にPCIe 5.0で4TB SSDを探したところ、かなり高額で、マザーボードに迫る価格だ。さすがに厳しいな……と思っていた頃、ドスパラ限定モデル「XPG MARS 980 BLADE SMAR-980B-4TCS-DP (M.2 2280 4TB)」が安かったのでこれにした。従ってこれで①もクリア。

③に関しては、BD790i X3Dにした時点でクリアしているのでオールクリア。改善点をまとめると以下のようになる。

| 中華マザー | BD790i X3D | |

|---|---|---|

| CPU | Core i7-12650H | Ryzen 9 7945HX3D |

| CPU仕様 | 10コア(6P+4E)/16スレッド/最大4.7GHz | 16コア/32スレッド/最大5.4GHz |

| メモリ | DIMM DDR4-3200 64GB | SO-DIMM DDR5-5200 96GB |

| M.2 SSD | 512GB+1TB+2TB/PCIe 4.0 | 4TB/PCIe 5.0 |

| PCIe | 4.0 | 5.0 |

これからも分かるように、dGPUとは無関係な部分だけでも結構なパワーアップとなる。かかった費用は18万円ちょっと。PCIe 4.0の4TBにするだけなら4万円前後なのに……と編集担当からは笑われてしまった(笑)。こうして2025年夏休みの工作開始!

マザーボードの入れ替え。起動用SSDをどうする!?

マザーボードの入れ替え自体は簡単なのだが、この時悩んだのが起動用のSSD 512GBを流用するかどうか。これにはBoot/Ubuntuも含め一式環境が入っているため、4TBはモデル/データ専用にできる。PCIe 4.0だが、爆速の必要もなく、セットアップもほとんど不要。モデルさえ4TB側にコピーすれば即利用可能だ。

とは言え、2年近く使っているため、余計なものやゴミも多く整理も含め、4TBのみで行くことにした。この場合、Ubuntu 22.04.5 LTSのインストール、サーバーの設定、Pythonなど言語/ツール系をインストールするなど、それなりに手間がかかるが仕方ないところ。

まずdGPUなしでBIOS起動。

- メモリ/ストレージを認識しているのを確認

ここであったトラブルは、なぜかCPU側のM.2スロット(2nd)ではSSDを認識せず、1stの方へ入れ替える必要があったこと。たまたま適当に挿した結果、2nd側だったので、これはこれである意味怪我の功名なのだが……。後から気付いたのだがマザーボードのマニュアルはここにある。

なお、PCIe 5.0対応のSSDは結構熱を持つらしく、購入したSSDには標準でプレートが付いていた。ただこれを付けてしまうと、BD790i X3D標準装備のファン付きヒートシンクと当たってしまうため、写真のように素のままでセット。その後、ヒートシンクをねじ止めする。これだけサイズが大きければ、もしファンが傷んで止まっても、結構効果あると思われ安心だ。

しかしCPU上も含め、見るとこのマザーボードはヒートシンクの塊だったりする。CPU側は後述するが、AI生成画像/動画に関してはGPUほど使わず動作してしまうため、テスト時はとりあえずこのままで、ファンを後付けすることにしたい。

次にOS。AI関連はUbuntu 22.04.5 LTSがメジャーなのでこれを使う。サブAI PCはWindows 11 Pro+WSL2なのだが、やはり使い勝手が悪く、AI関連でしか使わないPCはUbuntuとしたい。

- Ubuntu 22.04.5 LTSをダウンロードしてUSBメモリへ書き込み。USB Bootしてインストール

- openssh-serverとリモートデスクトップ環境設定。これでmacOSから操作可能へ

そしていきなりGeForce RTX 5090ではなく、とりあえずGeForce RTX 4060 Ti(16GB)で環境構築。ドライバが比較的新しく、CUDA 12.8以上であれば、GeForce RTX 40系、GeForce RTX 50系どちらでも動作する。

- gitなどをsudo apt install、mini conda環境の構築

- NVIDIAドライバ(nvidia-driver-575)、CUDA Toolkit(cu128)などをインストール

- ComfyUIインストール/動作確認

- モデルのコピー(1.5TB!)/生成確認

- SwarmUIをインストール/動作確認

ここでもトラブル。NVIDIAのドライバをインストールしようとすると、途中で何やらパネルを表示して入らない。見ると原因は、BIOSのSecure Bootがオン(デフォルト)だったこと。オフにして無事ドライバをインストールできた。

次にComfyUIをインストール。起動するのを確認して、後はサブAI PCからもう使わないものは除外しつつモデルなどのコピー。元々2TBがほぼ一杯だったので、GbEでの転送は時間かかるな……っと思っていたが、結局、この後のSwarmUIのセットアップまで含め8月30日、まるまる1日かかってしまった。

この状態でちょっとComfyUIを使ったところ、Qwen-Image/1,024x1,536px(8steps LoRA使用、bilinear使った1,280x1,920pxへのUpscaleあり)の画像生成速度は、

- RTX 4090 14.4秒に対してRTX 4060Ti(16GB) 49.2秒

と、約3.5倍の差が出ている。AI生成画像に関してはGPU性能が支配的なため、価格差なりと言ったところか。ただしcheckpointのロードは(正確には測ってないが)目に見えて本機の方が速い。PCIe 5.0の効果はあったようだ。

朝から一気にここまで作り込んで、さすがに疲れたので、GeForce RTX 5090への乗せ替えは後日に(笑)。

gpt-oss-120bはどのぐらい動く?

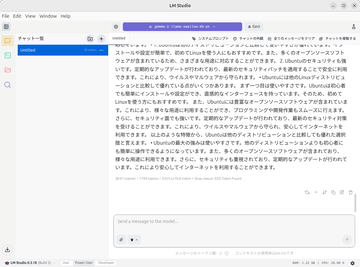

メインAI PCは、基本画像と動画、学習用なので、LLMを動かす予定はないのだが、先月はこの辺りいろいろ遊んでいたこともあり試しにやってみた。

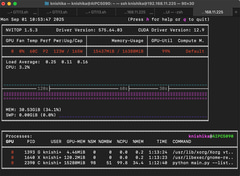

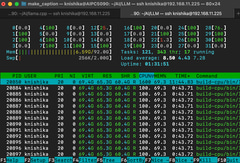

Linux版のLM StudioはAppImage形式なのでパスして、以下を参考にCPU版とCUDA版をbuildした(プロセッサが32スレッドなので8から32へ変更)。CPU版はすぐにできるが、CUDA版は結構時間がかかる。

まずCPU版から。事前にexport LLAMA_ARG_FLASH_ATTN=onとして実行。DDR5-5200なのであまり期待していなかったが予想通り。コンテキストが長くなると徐々に遅くなる。10-15tok/s程度だろうか。

build-cpu/bin/llama-server --model ../LLM/gpt-oss-120b-GGUF/gpt-oss-120b-MXFP4-00001-of-00002.gguf --ctx-size 131072 --jinja -ub 4096 -b 4096 -ngl 99 --host 0.0.0.0 --port 8080

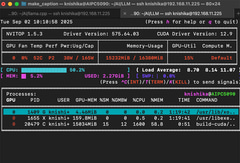

次にGeForce RTX 4060 Ti(16GB)を使ったCUDA版。こちらは15-20tok/sと一段ギアが上がる。ただコンテキスト長を最大にするとOOM(メモリ超過)だったので、--ctx-size 98304とした。GeForce RTX 5090にすればコンテキスト長最大でもOOMにはならないと思うが、速度はDDR5-5200縛りがあるため、さほど変わらないだろう。

build-cuda/bin/llama-server --model ../LLM/gpt-oss-120b-GGUF/gpt-oss-120b-MXFP4-00001-of-00002.gguf --ctx-size 98304 --jinja -ub 4096 -b 4096 -ngl 99 --n-cpu-moe 32 --host 0.0.0.0 --port 8080

以上、簡単に済ますなら壊れたSSDの交換だけで良かったのだが、元々気になっていた部分も一気に対応し、CPUとマザーボードごと交換、メモリも新調となってしまった。とは言え、スペック的にもSSDの読み込み速度的にも効果があって満足!

次回はGeForce RTX 5090に乗せ替え、この夏、いろいろリリースされたAI生成画像系モデルとともにご紹介したい。つづく……。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:5位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![[五年保証] モニター 27インチ IPS (1920×1080/120Hz)|USB Type-C・HDMI接続対応|目疲れ配慮|スピーカー内蔵|Adaptive Sync|HDR10|sRGB110%|VESA対応|フレームレス |USB-Cケーブル付き (MF27X3A・ケーブル付属) Minifire 製品画像:2位](https://thumbnail.image.rakuten.co.jp/@0_mall/minifire-direct/cabinet/120.jpg?_ex=128x128)

![【楽天ブックス限定特典】MGA MAGICAL 10 YEARS ANNIVERSARY BOOK -OUR STORY-(限定絵柄ポストカード1枚) [ Mrs. GREEN APPLE ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2004/2100014772004_1_2.jpg?_ex=128x128)

![遺産分割における「介護」の取扱い -寄与分・特別寄与料・使途不明金・介護負担の不履行等ー [ 武内 優宏 ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/4653/9784788294653.jpg?_ex=128x128)

![M!LK 10th ANNIVERSARY PHOTOBOOK ~パリじゃん~ [ M!LK ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/5876/9784391165876_1_3.gif?_ex=128x128)

![福祉住環境コーディネーター検定試験Ⓡ2級公式テキスト〈改訂7版〉 [ 東京商工会議所 ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/4218/9784502534218_1_7.jpg?_ex=128x128)

![anan2487号増刊 スペシャルエディション 2026年 3/18号 [雑誌] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0364/4912204870364.gif?_ex=128x128)

![王都の外れの錬金術師 7 〜ハズレ職業だったので、のんびりお店経営します〜【電子書籍】[ あさなや ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/0321/2000019730321.jpg?_ex=128x128)

![NHKラジオ ラジオ英会話 2026年3月号[雑誌]【電子書籍】 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/7519/2000019717519.jpg?_ex=128x128)