西川和久の不定期コラム

動画生成AIを画像生成AIとして使ってみたら想像以上に優秀だった「Wan 2.1」

2025年7月29日 06:00

去年(2024年)は「FLUX.1 [dev]」を代表として、いろいろな画像生成AIモデルがリリースされ盛り上がった1年だった。しかし今年(2025年)は高性能モデルだと「HiDream-I1」程度しか登場していない。面白くないな……と思っていたところ、思わぬところから高性能モデルが登場した。今回はこの辺りの話を書いてみたい。

今年2025年の生成AI画像動向

今年の話をする前に、去年の画像生成AIのオープン系は(アニメ/イラスト専用を除くと)以下のような感じとなる。

- 6月: Stable Diffusion 3 Medium (以降、SD3M)

- 7月: Kolors 1.0 (以降のバージョンはKLING AIのみで使用可能)

- 8月: FLUX.1 [pro][dev][schnell] ([pro]、1.1に関してはBFLのAPI)

- 10月: Stable Diffusion 3.5 LargeとLarge Turbo、少し遅れてMedium (以降SD3.5L/M)

ほかにもいくつか出ているが、主要どころだとこの辺りだろうか。つまり、ローカルPCで生成可能なものだけでも7種類も登場している(FLUX.1 [pro]のみAPI経由)。

以前の主流はSDXLだったので(かろうじてSD 1.5も)、一気にこれだけ増え、どれがSDXLより上のなのか?それぞれの性能は?……と、調べるだけでも(嬉しい悲鳴だが)大変だった。いずれにしても2024年は生成AI画像の当たり年となった。

さて話戻って2025年は?と言うと、これが全然新しいのが出てこない。正確には、出るには出るが、そのほとんどがGoogleやKLING AI、そのほかサービス系の中(もしくはAPI)のみで使用可能なものだ。ローカルPCで生成可能なオープンモデルが全くリリースされないのだ。

理由としては、おそらく2024年の動向を見て、オープンにしてしまうと開発者が儲からない、と言うのが本音だろう。開発には膨大な費用がかかるのに、それを回収できないとなると、普通の企業ならクローズドにして1円でも稼げる道を選ぶだろう。

加えて、SD 1.5、SDXLはある意味テスト、FLUX.1、SD3M/SD3.5L(M)はプレ本番で、まだ人物の指や体が崩れやすく、その次の世代=2025年モデルだとほぼ問題なく生成可能。であればサービス化と考えるのも道理だ。

このような中、2025年オープンでリリースされた主なものが、

- Lumina-Image 2.0

- HiDream-I1 Full/Dev/Fast

と2モデル程度。「Lumina-Image 2.0」はSDXLより気持ち上、HiDream-I1はFLUX.1といい勝負以上なのだが、テキストエンコーダに「Meta-Llama-3.1-8B-Instruct」がまんま入っていることもあり、GeForce RTX 4090および5090クラスでも生成が遅く(使うモデルによるが、感覚的にはFLUX.1 [dev]の倍以上かかる)、LoRAを作るのも「ai-toolkit」を使った場合VRAMが48GBが必要、時間もFLUX.1 [dev]用より倍以上……といった状況で、これでは一瞬流行るものの、長続きはしない状態だった。

つまり、真のFLUX.1 [dev]を超えるモデルは、まだオープンでは登場していないのだ。執筆しているのは7月末近く。少なくともこの段階で何の噂も出ていない。

おそらく普通の人、普通の使い方ならChatGPT、Google Imagen 3/4、KLING AIなど、各社動画生成メインのサービス内で画像生成すればこと足りるため、「で?」という感じになっているのだろう。しかし、これらはセンシティブ系(と言っても度の超えたものではなく、日本人的感覚だと普通)が出せず、グラビア的(Eコマース系でも下着や水着はある)なのを出して遊んでいる筆者の用途には合わない。

「もう2025年はオープンで高性能モデルは期待できないか」と思っていたところに、面白い話が飛び込んできた。それが動画生成AIモデルの「Wan 2.1」のtxt2vidを使って、txt2img=画像生成もできる!という話だ。

Wan 2.1とは?

現在ローカルPCで生成可能のオープンな動画用モデルとなると、「HunyuanVideo」「Wan 2.1」「LTXVideo」……辺りだろうか。

Wan 2.1 txt2vidは、アリババグループが開発したテキストから動画を生成するモデルだ。img2vid=画像から動画を生成するモデルも当然ある。Hugging Faceのここに一覧があり、

- Wan-AI/Wan2.1-T2V-1.3B-Diffusers

- Wan-AI/Wan2.1-T2V-14B-Diffusers

- Wan-AI/Wan2.1-I2V-14B-480P-Diffusers

- Wan-AI/Wan2.1-I2V-14B-720P-Diffusers

以上4つがメインどころとなる。上2つはtxt2vidのパラメータ違い、下2つはimg2vidで解像度違いとなる。

ざっくりtxt2vidとimg2vid(720p)のWorkflowと作例を挙げると以下のような感じだ。WorkflowはComfyUIのテンプレートからほぼそのまま使ってみた。

ただし、出力がWebPだったのでMP4になるよう、最後のNodeだけ変更。出力は832x480/16fpsで2秒。加えてtxt2vidは3Bパラメータだったので、14Bパラメータに変えている。

どちらも、動画と言ってもたとえば16fpsだと少しずつ変化する静止画を2秒で32枚生成し(実際は+1)、それらをつないで動画にしている。

この2つの結果を見る限り、明らかにimg2vidの方が綺麗だ。本当にtxt2vidをtxt2imgで使って綺麗な画像が出るのだろうか!?

Wan 2.1 txt2vidをtxt2imgで使ってみる!

上記の説明から、txt2vidの初めの1枚だけ生成し、そこで終わればtxt2img=生成AI画像になるという理屈が、Wan 2.1 txt2vidでtxt2imgも行ける、という仕掛けになる。

ただ、それができるのならHunyuanVideoやLTXVideoでも同じ理屈で行けそうだが、そんな話は全く上がっていない。「本当か!?」と当初、半信半疑だった。

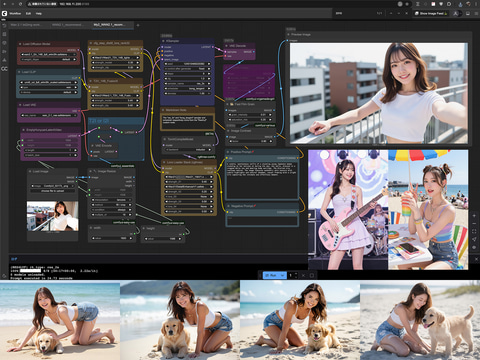

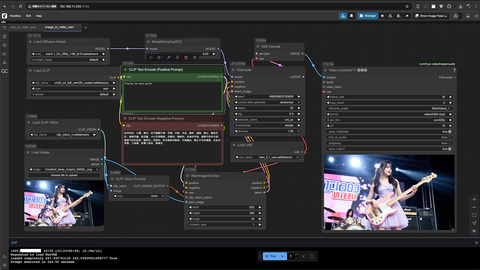

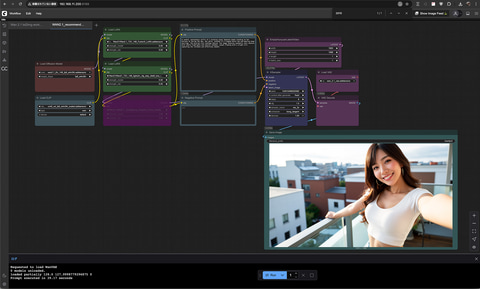

まず最初に上がったtxt2imgのWorkflowはこんな感じだ。Film Grainはそのままだとキツ過ぎたため、少し弱くしている。

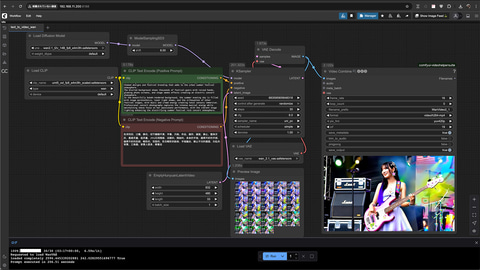

出るには出たが、FLUX.1 [dev]相当には見えず、「この程度か……」と、落胆していたところに、改良型Workflowが登場。

プロンプトとシード(Seed)は同じ。iPhoneで撮った写真っぽくするLoRAはBypassした。実行するとそれなりに良くなっている。

- wan2.1_t2v_14B_fp8_e4m3fn.safetensors

- umt5_xxl_fp8_e4m3fn_scaled.safetensors

- KSamplerのres_2s/bong_tangentはRes4Lyf Custom Nodeに含まれる

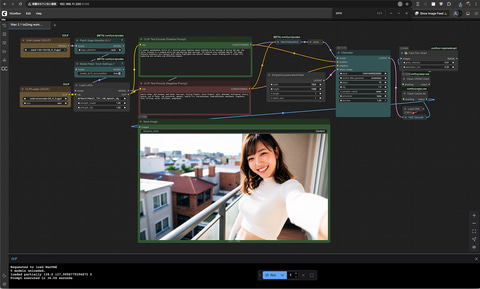

画質もなかなかだが、驚くことに解像度は1,920×1,088ドット、つまりフルHDの画像がいきなり出ている。これに関してはアップスケールが必要なFLUX.1やHiDream-I1、SD3M/SD3.5L(M)には真似できない芸当だ。さらにに生成速度もFLUX.1 [dev]+Upscaleよりはずいぶん速い。

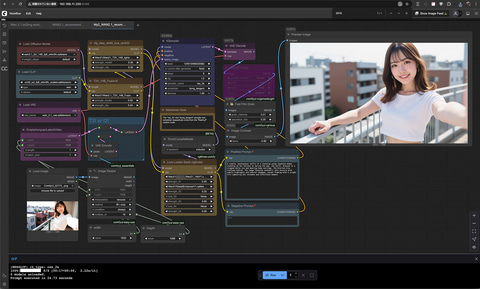

その後、筆者的に少し手を加え、今使用中のWorkflowはこんな感じだ。手を加えたと言っても先の改造版とほぼ同じ。まず必ず使うWan21_T2V_14B_lightx2v_cfg_step_distill_lora_rank32.safetensorsと、Wan2.1_T2V_14B_FusionX_LoRA.safetensorsは左側に固定。ただし、前者の重みは0.3となっている。

次に真ん中にあるLoRA Stackは、出したい絵柄などで適時セットするLoRA用。一番上の重み0.4となっているのが顔LoRAなのだが(ai-toolkitで作成可能)、0.4なので似ずに、肌色LoRAとして使っている。

また今回はいきなり1,920×1,088ドットを出した関係で、Bypassしたのが単純な拡大補完(biliner)。普段は1,024×1,536ドットで生成、これを使って1,280×1,920ドットにしている。たった1.25倍なので、アップスケールするまでもないだろうとの判断からだ。

その後ろのFilm Grainは名前の通りフィルムの粒状ノイズを等倍で見ないと分からないレベルで軽く加え、コントラスト少し浅め。この辺りはお好みでと言う感じだろうか。

TorchCompileModelは初回だけ時間がかかるが、2回目以降は速くなる(あり19.16秒、なし26.27秒)。

左側にあるT2IとI2Iの切り替えは、簡易的なもので、T2Iの時は空のLatent、I2Iの時は、設定した画像をLatentに入れ、KSamplerのlatent_imageへセット。前者はdenoize: 1、後者はdenoize: 0.6前後にすると設定した画像とプロンプトから生成した画像がミックスされ、img2imgの動作となる。

作例もいろいろ並べたので参考にしてほしい。ここまで出ると、FLUX.1 [dev]やHiDream-I1、SD3.5Lなどといい勝負ではないだろうか!?

特に体や指が破綻してないのが印象的なのと、プロンプトは載せられないものの、忠実に再現しているように思える。

なお、誰もが顔LoRAを持っているはずもなく、その代替えLoRAだと

これがお勧め。六本木の夜的美人(笑)が生成でき、重み0.2~0.4程度で使えば、肌LoRA替わりになる(もちろんもっと強くしてまんま生成しても良い)。

さて、ではFLUX.1 [dev]、HiDream-I1 Dev、SD3.5L、どれだけ違うかを試してみた。当然すべて同じプロンプト。加えて公平を期すため、同じ子の顔LoRAをすべて0.4で当てている。

ポーズは生成AI画像が苦手な“四つん這い”(On all fours)。実際試したことがある人なら分かると思うが、逃げでなるべく正面もしくはちょい横。真横にはまず出ないのだ。また腕や足が半端だったり崩れたり……。筆者の経験上プロンプトだけで綺麗に出た試しがない(ControlNetで構図を固める必要がある)。結果はご覧の通り。

発色や細かい描写などはそれぞれ好みもあるだろうが、綺麗に再現していると言う点ではWan 2.1 txt2imgの圧勝。ほかは誤魔化しているのが分かる。なおそれぞれの画像は20~30回ガチャって比較的横を向き絵的にもマシなのを掲載している。わざと酷いのを掲載しているわけではない(笑)。

このようにかなりGoodなWan 2.1 txt2imgだが、欠点もあるにはある。まず顔や肌が綺麗に光を回し撮影した感じで、フラットに出る。ハイコントラストや光と影と言った表現は出なくはないが、ほかのモデルと比較して苦手だ。加えてあまり、細かく出ない感じだろうか。

もう1つ、これも同じ話なのだが、暗い部屋にポツンと一人……的なダークな感じの絵も苦手だ。いくらdim/dark roomとかいてもちっとも暗い感じにならない(書き方があるかも知れないが)。

ただこの辺りに関してはWan Lighting LoRAを使えば改善でき、実際作例の夜景&赤ワインのシーンはこのLoRAを使用している。

動画モデルで静止画を作った時、考えられる利点と欠点は、

- 体や(足も含め)指が崩れにくい。動画は連続的に画像を生成する関係から何か崩れると一貫性が保てなくなる

- 表情や光などが自然。画像モデルでは1枚で完結、前後は学習できないため、動画モデルの様に連続して学習した方が自然になる

利点:

- (気持ち)ディテール不足。動画モデルの学習だとあまり細部などは学習せず、動き中心になるため

欠点:

利点に関しては作例通り。いろいろな意味で自然に生成されている。欠点については、現在480p/720p/1080p程度の解像度なので細部は……となるが、これが4K対応のレベルになるとまた話は変わってくる。ただ仮に出てもローカルPCで生成できるのか?問題は残る(笑)。

あくまでも筆者の推測だが、当たらずも遠からずと言った感じではないだろうか!?

以上のようにWan 2.1 txt2imgは、FLUX.1 [dev]など、高性能画像生成AIモデルの替わりになり得る新型?画像生成AIモデルだ。プロンプトの追従性、体や指が崩れにくいなど、ほかにはないと特徴を持つ。

実はこの週末(7月25から7月27日)辺りにWan 2.2が出そう(アナウンス済み)だったので、それを待ってこの記事を書きたかったのだが、リリースされず。Wan 2.1での見切り発車となってしまった。そのあと公式に発表があり、Wan 2.2は7月28日の21時(日本時間)リリースとのこと。Wan 2.2が無事リリースされ、txt2imgがさらに向上した場合、8月にでも続編を書いてみたいと思っている。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:5位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![I-O DATA|アイ・オー・データ ゲーミングモニター GigaCrysta 3年保証 ブラック KH-GD254U [24.5型 /フルHD(1920×1080) /ワイド /320Hz] 製品画像:1位](https://thumbnail.image.rakuten.co.jp/@0_mall/biccamera/cabinet/product/14752/00000014570246_a01.jpg?_ex=128x128)

![ブラック企業の社員が猫になって人生が変わった話8 猫兄弟の場合【電子書籍】[ 清水 めりぃ ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/0535/2000019730535.jpg?_ex=128x128)

![家を追放された魔法薬師は、薬獣や妖精に囲まれて秘密の薬草園で第二の人生を謳歌する 1【電子書籍】[ nouc ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/0462/2000019730462.jpg?_ex=128x128)

![WPB 永尾まりやデジタル写真集〜特装合本版〜【電子書籍】[ 永尾まりや ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/7922/2000008707922.jpg?_ex=128x128)

![オタク同僚と偽装結婚した結果、毎日がメッチャ楽しいんだけど!(4)【電子書籍】[ 七十 ななそ ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/0656/2000019730656.jpg?_ex=128x128)

![異世界のんびり農家 20 [ 内藤 騎之介 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/7157/9784047387157_1_6.jpg?_ex=128x128)

![まんがグリム童話 2026年4月号【電子書籍】[ 安武わたる ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/5207/2000019845207.jpg?_ex=128x128)

![お気楽領主の楽しい領地防衛 8【電子書籍】[ 青色まろ ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/3480/2000019753480.jpg?_ex=128x128)