ニュース

NVIDIA、Google、Metaが集結!Hot Chipsで語るAIラック構築とカーネルプログラミング

2025年8月25日 10:59

午前と午後で別テーマの技術講座を予定

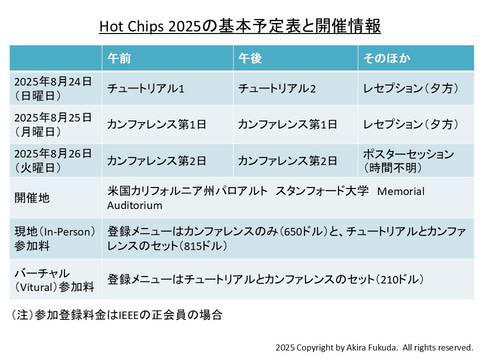

高性能プロセッサの最新技術を披露する国際学会「Hot Chips」が今年も始まった。すでに本誌でご紹介したように、今回もリアル開催とバーチャル開催のハイブリッドイベントとして開催される。開催期間(米国時間)は8月24日~8月27日、リアル開催の場所は米国カリフォルニア州パロアルトのスタンフォード大学である。

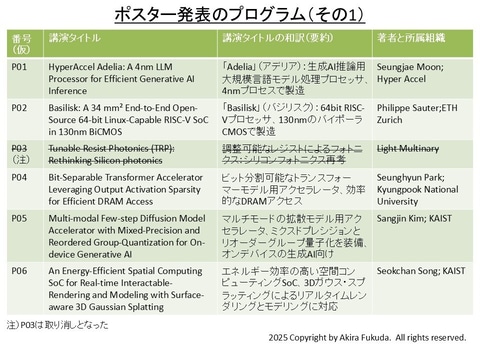

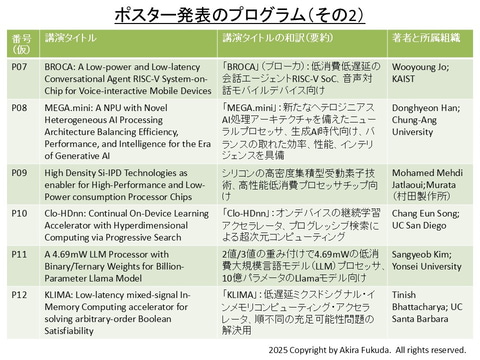

基本的なスケジュールは初日がチュートリアル(技術講座)、中日と最終日はカンファレンス(技術講演)と基調講演、ポスター発表となっている。本コラムの前回では概要のみとなっていた、チュートリアル(技術講座)の詳細が公開されたのでご紹介したい。またポスター発表のプログラムに著者名が加えられたので、改めて一覧をお届けする。

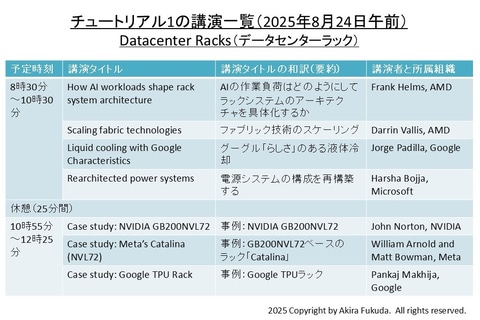

午前の技術講座「データセンターラック」

Hot Chipsのチュートリアルは、共通テーマに沿った5件前後の講義(講演)で構成される。共通テーマは2つあり、午前と午後で異なるテーマを扱う。

午前の共通テーマは「Datacenter Racks(データセンターラック)」である。7件と数多くの講演を予定する。始めにAMDが2件の講演を続けて実施する。最初の講演タイトルは「How AI workloads shape rack system architecture(AIの作業負荷はどのようにしてラックシステムのアーキテクチャを具体化するか)」だ。AI特有の課題に対処するデータセンターラックの姿を述べるとみられる。次の講演タイトルは「Scaling fabric technologies(ファブリック技術のスケーリング)」である。水平な相互接続技術であるネットワークファブリックの拡張性を論じるとみられる。

それからGoogleが「Liquid cooling with Google Characteristics(グーグル「らしさ」のある液体冷却)」のタイトルで講演する。グーグルのAIコンピューティングプラットフォームは他社に先駆けて2018年に液体冷却技術を採用していることから、冷却技術の進化が説明されることを期待する。

次にMicrosoftが「Rearchitected power systems(電源システムの構成を再構築する)」のタイトルで講演する。ラックシステムの消費電力が急速に増加していることから、電源システムの構成を見直すテーマは時機にかなう。

休憩を挟んで午前(チュートリアル1)の後半が始まる。後半ではAI向けデータセンターラックのケーススタディが3件続く。まず、NIVIDAがラックシステム「NVIDIA GB200NVL72」の概要を述べる。同システムは36個のGrace CPUと72個のBlackwell GPUで構成(基本構成は1個のCPUと2個のGPUで構成する「Superchip」と呼ぶモジュール)される。次にMetaが「NVIDIA GB200NVL72」をベースとするAI向けラックシステム「Catalina」の概要を説明する。最後にGoogleが、自社開発のTPU(Tensor Processing Unit)によるラックシステムの概要を述べる。

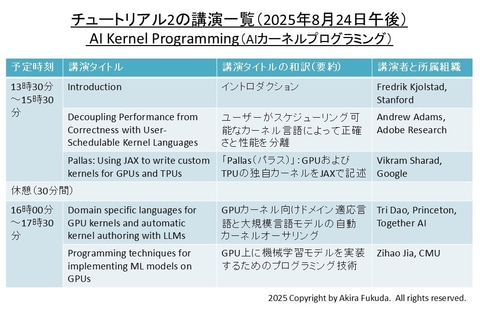

午後の技術講座「AIカーネルプログラミング」

昼食休憩を挟んで午後(チュートリアル2)の技術講座が始まる。共通テーマは「AI Kernel Programming(AIカーネルプログラミング)」である。始まりの「イントロダクション」(共通テーマの意義を解説するとみられる)のほか、4件の講演を予定する。

イントロダクションに続いて最初の講演は、Adobe Researchが担う。タイトルは「Decoupling Performance from Correctness with User-Schedulable Kernel Languages(ユーザーがスケジューリング可能なカーネル言語によって正確さと性能を分離)」である。次にGoogleが「Pallas: Using JAX to write custom kernels for GPUs and TPUs(「Pallas(パラス)」: GPUおよびTPUの独自カーネルをJAXで記述)」のタイトルで講演する。ここでJAXはマシンラーニングの計算処理を高速実行する数値計算ライブラリであり、Pallasはカーネルをカスタマイズする機能(JAXの拡張機能)である。

休憩を挟んで午後の後半は、Together AI(中小企業向けAIプラットフォームの開発企業)が「Domain specific languages for GPU kernels and automatic kernel authoring with LLMs(GPUカーネル向けドメイン適応言語と大規模言語モデルの自動カーネルオーサリング)」と題して講演する。続いてCMUが「Programming techniques for implementing ML models on GPUs(GPU上にマシンラーニングモデルを実装するためのプログラミング技術)」のタイトルで講演する。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:4位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![シャングリラ・フロンティア(26)エキスパンションパス ~クソゲーハンター、神ゲーに挑まんとす~ (講談社キャラクターズA) [ 硬梨菜 ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/3249/9784065433249_1_3.jpg?_ex=128x128)

![NYLON JAPAN GLOBAL ISSUE 07 [ NYLON JAPAN編集部 ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1027/9784911631027_1_2.jpg?_ex=128x128)

![こども語彙力クイズ366 1日3分で頭がよくなる! [ 高濱正伸 ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1519/9784284001519_1_3.jpg?_ex=128x128)