ニュース

AMD、推論特化の完全オープンな言語モデル「Instella-Math」

2025年8月13日 12:54

AMDは8月9日、推論に特化したオープンな言語モデル「Instella-Math」を発表した。同社が3月に発表した30億パラメータのオープンモデル「Instella-3B-Instruct」をベースに、5段階のトレーニングを通じて機能を拡張したモデルとなる。

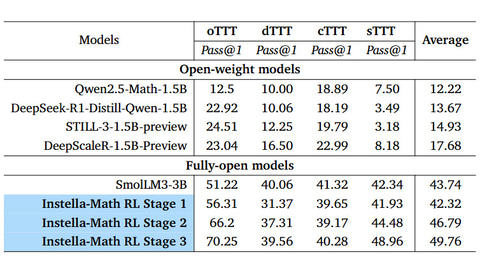

Instella-Mathは、30億パラメータを持つ推論中心型言語モデル。アーキテクチャやトレーニングコード、ウェイト、データセットに加え、教師ありファインチューニング(SFT)のデータも公開しており、完全にオープンなモデルだと説明している。Instella-3B-Instructをベースに2段階の教師ありファインチューニングと、3段階の強化学習を行ない、多段階の論理的推論や数学的な問題解決、思考連鎖といったタスクに向けて最適化を図った。

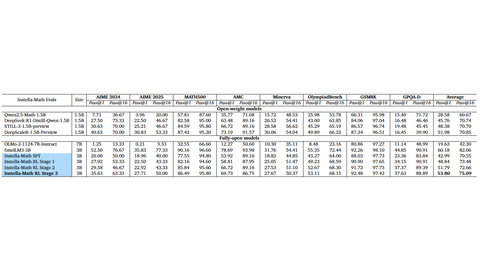

同社が実施したベンチマークによれば、DeepSeek-R1-Distilled-Qwen-1.5BやDeepScaleR-1.5Bといった小規模なオープンウェイトモデルに対し、競争力のある性能を発揮できるとしている。加えて、競合モデルのオープンウェイトモデルと比べ、トレーニングデータがすべて公開されている点も強みだと説明している。

なお、Instella-Mathのトレーニングは同社製GPUであるInstinct MI300X上で行なわれ、ソフトウェアスタックのROCmも活用。4つのMI300Xノードで効率的な分散トレーニングを実施したという(各ノード8基のMI300Xで構築)。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:4位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![【中古】 HP Z200 SFF Core i3 540 Windows7世代のPC 均一 スリム型 電源投入可 ジャンクPC 送料無料 [95048] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/risemark/cabinet/pic/950a/95048.jpg?_ex=128x128)

![【★東証上場の安心企業】ASUS/エイスース アイケア液晶ディスプレイ フルHD(1920x1080) IPSパネル VA249QGZ [23.8インチ] メーカー5年保証【送料無料】【smtb-u】【送料無料!(沖縄、離島除く)】 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/mitenekakakubamboo/cabinet/01113290/imgrc0097722195.jpg?_ex=128x128)

![DELL デル Dell 24 Plus [23.8型 / フルHD(1920×1080) / ワイド / 144Hz] ホワイト S2425HSM-R 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/r-kojima/cabinet/n0000001618/4573661274708_1.jpg?_ex=128x128)

![[期間限定★25,701円で購入!] 32インチ モニター 2K 180Hz WQHD2560*1440 ゲーム用 ゲーミングモニター モニター HDR ノングレア pcモニター 液晶ディスプレイ ブルーライト軽減 VESA対応 コントラスト3500:1 ps5 1500Rの湾曲率 フレームレス ケーブル付き AMZG32C1Q 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/minifire-direct/cabinet/13034963/imgrc0249539754.jpg?_ex=128x128)

![IOデータ 275Hz&WQHD対応ゲーミングモニター KH-GDQ271UA GigaCrysta [27型 / WQHD(2560×1440) / ワイド] ブラック 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/r-kojima/cabinet/n0000001586/4957180185699_1.jpg?_ex=128x128)

![[7%OFFクーポン 11日朝まで]プリンストン 13.3インチ モバイルディスプレイ ブラック フルHD タッチ機能付 USB-C入力対応 PTF-M133T 液晶モニター 13.3型 モバイルモニター HDMI IPSパネル スピーカー内蔵 PS4 Switch カバー付き 光沢 タッチパネル ディスプレイ モニター 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/princeton/cabinet/260304/ptfm133t.jpg?_ex=128x128)

![今日の治療薬2026 解説と便覧 [ 伊豆津宏二 ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/3386/9784524273386_1_2.jpg?_ex=128x128)

![2億円を売り上げたプロが教える note×AI 最強の副業 [ らっこ ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/7738/9784046077738_1_26.jpg?_ex=128x128)

![ワンパンマン 36 (ジャンプコミックス) [ ONE ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/8914/9784088848914_1_9.jpg?_ex=128x128)

![別冊 会社四季報 プロ500銘柄 2026年 4月号 [雑誌] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0466/4912022750466_1_2.jpg?_ex=128x128)

![タッチペンで音が聞ける!はじめてずかん1000 英語つき [ 小学館 ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/6775/9784099416775_1_37.jpg?_ex=128x128)

![デコピンのとくべつないちにち (単行本 608) [ 大谷 翔平 ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9368/9784591189368.jpg?_ex=128x128)

![呪術廻戦≡(モジュロ) 2【電子書籍】[ 芥見下々 ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/1612/2000019641612.jpg?_ex=128x128)