ニュース

今後、AIの主戦場は学習から推論へ。そこで勝つためのAMDの戦略とは

2025年6月13日 12:44

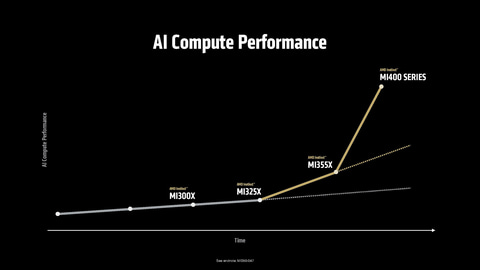

米AMDは12日(現地時間)、米国カリフォルニア州サンノゼ市にあるサンノゼコンベンションセンターにおいてAI向け半導体ソリューションを説明するイベント「Advancing AI 2025」を開催した。午前中にはAMD 会長 兼 CEO リサ・スー氏など同社幹部などが登壇した基調講演が行なわれ、次世代データセンターAI向けGPU「AMD Instinct MI350」シリーズ(以下MI350)が発表された。

また、スー氏の基調講演には、OpenAI 創始者・CEO サム・アルトマン氏が登壇してInstinct MI350/MI400への期待を語ったほか、夕方にはAI研究者として知られるDeepLearning.AI 創始者 兼 Landing AI 上席会長 アンドリュー・ンー氏とスー氏の対談形式のクロージング基調講演が行なわれ、AI業界のスターが多数登壇したイベントとなった。

データセンター向けGPUが発表されるAdvancing AI、今回はMI350シリーズが発表される

AMDは、AIに関するイベント「Advancing AI」を、2023年12月、2024年の10月と2回開催してきた。2023年の時には、同社のCDNA 3アーキテクチャを採用した最初のデータセンター向けGPU「Instinct MI300」シリーズ(製品としてはMI300XとMI300A)を発表し、昨年はMI300Xのメモリ容量を増やしたバージョンとなる「Instinct MI325X」を発表した(同時にデータセンター向けの第5世代EPYCも発表されている)。

今回のAdvancing AI 2025は3回目となり、AMDの年次イベントとしてすっかり定着しつつある。

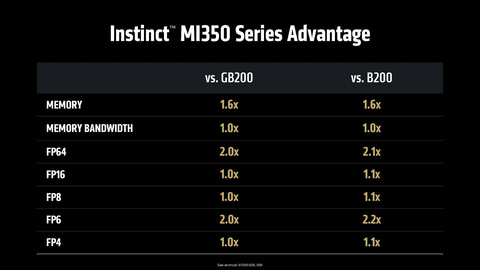

今回のAdvancing AI 2025も新しいAIソリューションを発表し、それに関連するソフトウェアの開発環境などについて説明が行なわれた。今回発表されたのは別記事でも紹介しているInstinct MI350シリーズで、NVIDIAのBlackwell(GB200やB200など)に匹敵する性能を発揮するデータセンター向けのGPUとなる。

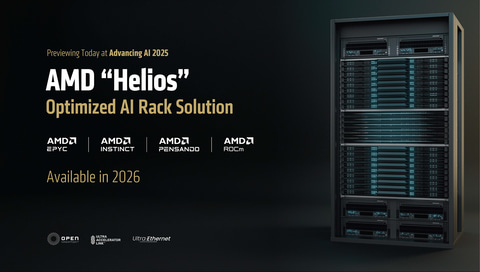

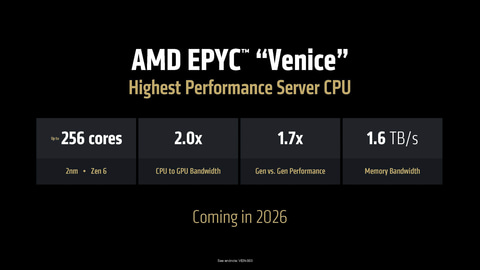

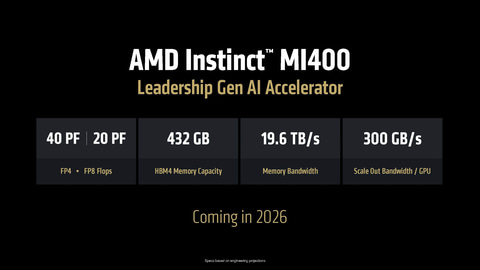

また、それに合わせて来年投入する計画のMI400X、そしてMI400X、Zen 6コアを採用した次世代EPYC(開発コードネーム:Venice)、そして次世代DPU「Vulcano」の3つのコンポーネントから構成されているラックサーバー「Helios」の概要や、同社のAIソフトウェア開発環境となるROCmの最新版ROCm 7などを発表したことを明らかにしている。

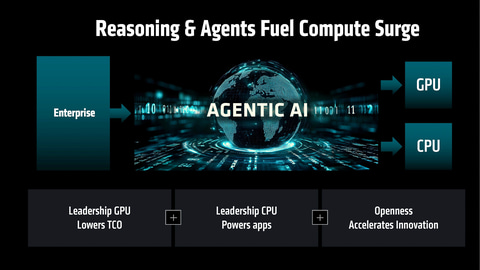

AIのこれからは推論が中心になって5,000億ドル市場に成長する

基調講演に登壇したAMD 会長 兼 CEO リサ・スー氏は「ChatGPTがリリースされて以降、AIの成長は、私のキャリアでも見たことがないぐらい急速なものだ。特にここ最近の大きな変化が、推論の需要が強くなっていること。これからAIエージェント、そしてエージェンティックAIが普及していくことで、推論の演算ニーズは増えていくと考えられている」と述べ、依然としてAIへの注目度は高く、業界の関係者が驚くような成長を遂げていると強調した。

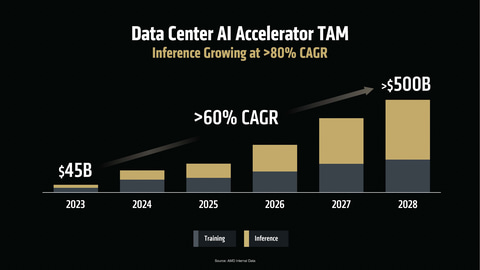

そうしたAIの成長に関してスー氏は、AIアクセラレータの市場は2023年~2028年のCAGR(年平均成長率)が60%という成長率で成長を続けており、2028年には5,000億ドル(1ドル=143円換算で、日本円で71兆5,000億円)のTAM(潜在市場規模、実現可能と考えられる市場規模のこと)が期待できると説明。そして学習よりも推論が今後大きく成長していくだろうという見通しを明らかにした。

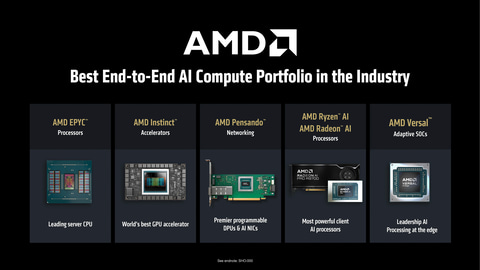

その上で「そうした学習や推論などに柔軟に対応するために、よりプログラマブルなソリューションが必要だ」と述べ、CPUのEPYC、GPUのInstinct、DPUのPensandoなどのプログラム可能なデータセンター向けのソリューションをAMDが提供していることを強調した。

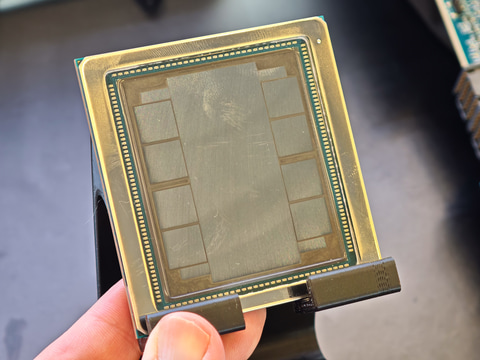

スー氏は、今回のAdvancing AIでAMDが正式に発表したInstinct MI350シリーズのパッケージを紹介し、同社がInstinct MI350シリーズを第3四半期に、OEMメーカーやクラウドサービス事業者などから提供開始することを明らかにした。

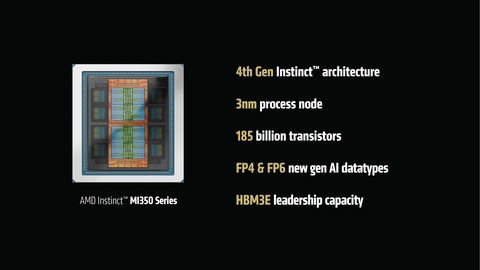

Instinct MI350シリーズでは、アーキテクチャがCDNA 4に強化され、メモリは288GBに増やされるなど、性能が引き上げられており、MI355X(1,400W)とMI350X(,1000W)という2つのグレードの製品が用意される。前者向けには液冷の熱設計ソリューションが用意され、後者に関しては空冷のソリューションが提供される。性能に関しては、NVIDIAのGB200とほぼ同等、B200からは10%程度、浮動小数点演算時のスループットが向上していると説明された。

UALinkやUECがバージョン1.0になり、データセンター向けGPUの足元を支える

AIデータセンターの構成要素として注目を集める、スケールアップ(GPUの内部バスの延長線上にある高速なインターコネクトで接続すること)用のUALink(Ultra Accelerator Link)とUEC(Ultra Ethernet Consortium)に関してもアップデートが行なわれた。

UALinkは、NVIDIAのプロプライエタリのインターコネクトとなるNVLinkへの対抗として、オープンな仕様のインターコネクトとして規格策定が行なわれたものになる。AMDはそのベースとなる技術として、Infinity Fabricの知的所有権をコンソーシアムに寄贈しており、それをベースにしてバージョン1.0の仕様が策定された。

今回AMDは、2026年に投入するInstinct MI400を利用したラックアーキテクチャ「Helios」の計画を明らかにしたが、そのHeliosはUALinkを利用してスケールアップできるようになっていることを明らかにしている。つまり、MI400がUALinkに対応していることになる。

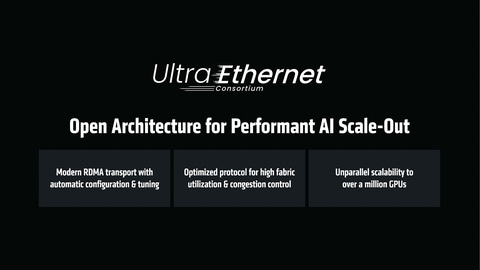

さらに、AMD 上席副社長 兼 データセンターソリューション事業本部 事業本部長 フォレスト・ノルド氏は「昨日、UECのバージョン1.0規格が完成して公開された」と述べ、スケールアウト用の高速Ethernetの規格となるUECがバージョン1.0になったと明らかにした。

このUECは、NVIDIAが2019年に買収を完了したMellanox Technologies由来のNVIDIAネットワーク製品(InfiniBandやEthernetなど)に対抗するオープンな規格としてAMDなどが中心になって策定された規格。AMDは既に昨年の10月に行なったAdvancing AI 2024において、400GbのUECに対応したPensandoを発表しており、今回仕様が正式に決まったことで、UECに対応したネットワーク製品として出荷することが可能になる。

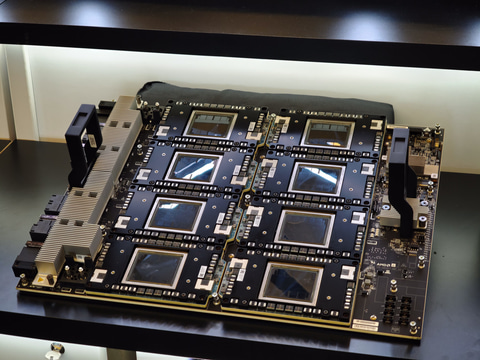

基調講演の最後に戻ってきたスー氏は、AMDがInstinct MI350シリーズの後継として来年投入を計画しているInstinct MI400およびそのラックアーキテクチャとなる「Helios」に関して説明を行なった。

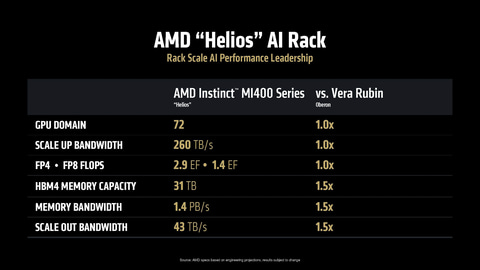

Heliosは、GPUにInstinct MI400、CPUには次世代EPYCとなるVenice、DPUに次世代PensandoとなるVulcanoから構成されており、ラック全体で72GPU構成を実現可能。NVIDIAが提供しているNVL72のVera Rubin版と比較して、FP4(スパース)時の処理能力では同等で、ラックあたりのメモリ容量、メモリ帯域、スケールアウト時帯域がそれぞれ1.5倍となる。

スー氏はVeniceが2nmで製造され、最大で256CPUコア、第5世代EPYCに比べてピーク性能が1.7倍、メモリ帯域幅は1.6TB/sに達すると説明し、さらにVulcanoに関しては3nmで製造される800GbのUECに対応したEthernetアダプタになることなどを説明した。MI400、Venice、Vulcanoのいずれも2026年に投入が予定されていることは既報の通りだ。

スー氏の基調講演の最後には、OpenAIの創始者でCEO サム・アルトマン氏が登壇し、OpenAIがAIの学習や推論環境の構築に、AMDのInstinct MI350シリーズや、2026年に登場するInstinct MI400シリーズへの期待などについて語った。

AIアプリ開発にとって重要なのはオープンであること

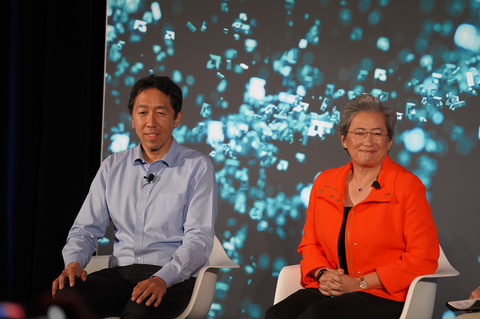

夕方には、AIソフトウェア開発者などを対象にしたクロージング基調講演として、AI研究者の第一人者の一人として知られているDeepLearning.AI 創始者 兼 Landing AI 上席会長 アンドリュー・ンー氏とスー氏の対談形式の基調講演が行なわれた。

ンー氏は「AIの開発で、一番重要なレイヤーはアプリケーションレイヤーだ。アプリケーションレイヤーこそが利益を生んでいるからだ。ではアプリケーションレイヤーで成功するには何が必要かと言えば、それはオープンであることだ。

それはモバイルのプラットホームを見れば明らかである。AndroidとiOSと2つのプラットホームがあるが、成功しているのはどちらかということを見れば明らかだろう。私はAIを実行する半導体もオープンで開発者に選択肢を提供するべきだと考えており、リサとそのチームは非常に良い仕事をしていると思う」と述べ、今後のAIで発展していくためには、オープンであることが重要になると考えていると強調した。

スー氏は「AMDはAI Everywhereを掲げている。すべての仕事がAIによって変わっていくと考えており、たとえば製品開発もAIを使うと、従来は3年かかっていたものが6カ月になったりする。つまりAIを利用すると生産性が高くなることだ。重要なことは、学び続けることで、常に新しくなっているAIの情報を学習していくことだ」と、AIを活用することで開発者やエンジニア、さらにはビジネスパーソンも含めて生産性を向上させていくことで進化について行くことが重要だと述べた。

ンー氏が「今はAIを利用してコーディングができる。新しいアイディアがあればそれをアプリケーションという形にすることが容易だ。一番大事なことはビルド、ビルド、ビルドだ」と述べたことを受けて、スー氏が「ビルド、ビルド、ビルドだが、最後にビルドAMDだ」とし、AMDの半導体を利用してAIアプリケーションの開発をしてほしいと述べると、会場に詰めかけたAI開発者からは大きな拍手が送られた。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:2位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【中古】送料無料[良品]Apple MacBook Air(M1, 2020)/ Apple M1 / メモリ8GB / SSD256GB / Windows11 / Office 2024品質保証あり 初期設定不要 無料サポート 製品画像:5位](https://thumbnail.image.rakuten.co.jp/@0_mall/maclife/cabinet/10217568/imgrc0137080231.jpg?_ex=128x128)

![【中古】 SONY VAIO VPCL128FJ 大容量HDD搭載 Core 2 Quad Windows10 Home ブルーレイ 液晶一体型 保証付 [93773] 製品画像:6位](https://thumbnail.image.rakuten.co.jp/@0_mall/risemark/cabinet/pic/937b/93773.jpg?_ex=128x128)

![【20%OFFクーポンあり!】[五年保証] モニター 27インチ IPS (1920×1080/120Hz)|USB Type-C・HDMI接続対応|目疲れ配慮|スピーカー内蔵|Adaptive Sync|HDR10|sRGB110%|VESA対応|フレームレス |USB-Cケーブル付き (MF27X3A・ケーブル付属) Minifire 製品画像:4位](https://thumbnail.image.rakuten.co.jp/@0_mall/minifire-direct/cabinet/120.jpg?_ex=128x128)

【ECセンター】保証期間1週間 製品画像:2位](https://thumbnail.image.rakuten.co.jp/@0_mall/janpara/cabinet/itemimg_tempostar/shop222_39/108159430-222_1.jpg?_ex=128x128)

![1冊ですべて身につくWordPress入門講座 [ Mana ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9405/9784815609405_1_6.jpg?_ex=128x128)

![青天【電子書籍】[ 若林正恭 ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/0144/2000019330144.jpg?_ex=128x128)

![Illustrator しっかり入門 増補改訂 第3版 [Mac & Windows対応] [ 高野 雅弘 ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/4286/9784815624286_1_13.jpg?_ex=128x128)

![Photoshop しっかり入門 増補改訂 第3版 [Mac & Windows対応] [ まきの ゆみ ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/4293/9784815624293_1_5.jpg?_ex=128x128)

![きらめきかわいいブック システムシール手帳特大号 (扶桑社ムック) [ サンリオ ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/4392/9784594624392_1_3.jpg?_ex=128x128)

![1冊ですべて身につくHTML & CSSとWebデザイン入門講座[第2版] [ Mana ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/8469/9784815618469_1_7.jpg?_ex=128x128)