ニュース

2026年投入「Instinct MI400」は性能2倍。AI開発環境「ROCm 7」も発表

2025年6月13日 03:30

米AMDは、6月12日(現地時間)に米国カリフォルニア州サンノゼ市にあるサンノゼコンベンションセンターにおいて同社のAI向け半導体ソリューションを説明するイベント「Advancing AI 2025」を開催している。

午前中にはAMD 会長 兼 CEO リサ・スー氏など同社幹部などが登壇した基調講演が行なわれ、今後のロードマップやAIソフトウェア開発ソリューションに関しても言及。来年(2026年)AMDが導入を計画している次世代製品となる「Instinct MI400」シリーズ(以下MI400)や、AIソフトウェア開発環境となるROCmの最新バージョンを発表した。

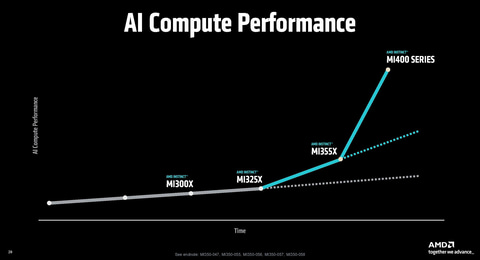

2026年にMI400シリーズを投入、現行製品の2倍のFP4スループットを実現

AMDは今回のイベントにおいて、次世代データセンターAI向けGPUとなる「AMD Instinct MI350シリーズ」(以下MI350)を発表。上位グレードとなる「MI355X」は、NVIDIAのGB200と同等、そしてB200に対しては10%高いFP4(スパース性)のスループットを実現すると説明しており、競争力がある性能をアピールしている。

そしてプレビューとして明らかにしたのは、MI350の後継として2026年に投入を計画しているMI400に関する情報だ。

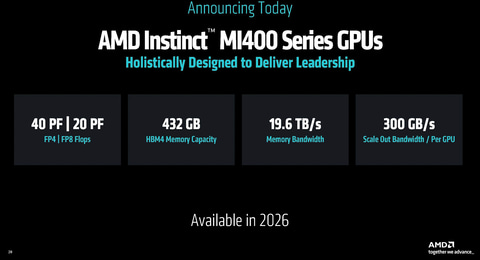

MI400シリーズは、432GBのHBM4をパッケージ上に実装しており、パッケージあたりのメモリの帯域幅は19.6TB/sに達する。驚異的なのはFP4/スパース性利用時のスループットで、40PFLOPSと、MI355Xの20PFLOPSの2倍となっている。スケールアウト時のGPUあたりの帯域も300GB/sに達し、効率が改善される。

また、スケールアップ用のインターコネクトとして「UALink」にも対応。現状のInfinity Fabricでは8基までのスケールアップに対応しているが、それを超えてスケールアップすることが可能になる。ドメインで260TB/sの帯域幅を実現する。

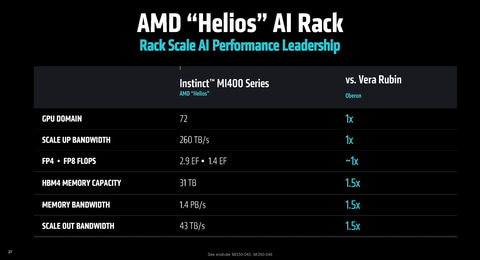

2026年には高効率ラック「Helios」も導入

MI400シリーズを利用したラックサーバーとして「Helios」(開発コードネーム)を計画しており、NVIDIAの「NVL72(Oberon)」と同じ1ラックで72GPUをスケールアップできる。性能に関しては、NVIDIAがVera RubinをOberonで構成した場合の理論値(FP4/スパース性で2.9EFLOPS)と同等の性能が実現できると説明している。

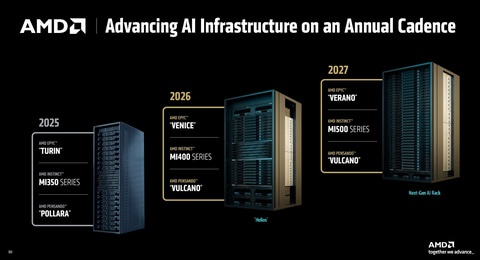

このHeliosは、Instinct MI400Xシリーズに加え、AMDの次世代サーバーCPUとなる「Venice」(開発コードネーム)を採用し、DPUにはAMDの次世代製品となる「Vulcano」(開発コードネーム)を搭載。スケールアップだけでなく、スケールアウト時の性能も拡張される見通しだ。

さらに2027年には、次々世代EPYCとなる「Verano」(開発コードネーム)、「Instinct MI500」シリーズ、Vulcanoと組み合わせ、さらに強力なAIラックが実現できるという。

こうしたGPUの強化だけでなく、CPU/DPUなども合わせて強化していくことで、1ラックで処理できるAI演算時の性能を強化していく取り組みを行なっていく。

AMDは、2030年には1台のAIラックで2025年のAIラックの275台分に相当する処理能力を代替できるようにしていくことを掲げている。今回発表されたInstinct MI350シリーズ、そして来年登場するInstinct MI400シリーズは、その第1歩となる。

ROCmの最新版ROCm 7を発表、最適化により推論で3.5倍、学習で3倍性能が向上

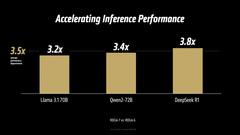

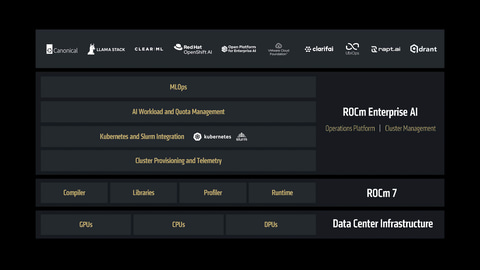

同時に、ROCmの最新版となるROCm 7も発表した。ROCmは、AMD GPU向けのオープンソースのAIソフトウェアスタックで、AIソフトウェアを開発する開発者を対象に提供している。これまではROCm 6(最新バージョンは6.4.1)が最新版として提供されてきた。ROCm 7はその後継となるバージョンで、最新GPUとなるMI350シリーズをサポートし、ROCm 7で最適化した場合、推論で平均して3.5倍、学習で3倍性能が向上するという。

また、大企業向けのAI開発環境として「ROCm for Enterprise AI」の導入も明らかにされており、AIソリューションの拡充を図りたい時にROCm for Enterpriseを利用することで、AIの開発から導入までをこれまでよりも容易に行なえるという。

さらに、AMD GPUでAIの開発を行なう開発者向けには、「AMD Developer Cloud」が提供開始される。これを活用することで、AIの開発をクラウドのマネージドサービス上で行なうことができる。Hugging Face、OpenAI、Grokなどとの連携も行なわれる計画で、企業が提供するファウンデーションモデルを利用して、AMD GPU上で動作するAIアプリケーションの開発が可能になる。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:2位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![フィリップス(ディスプレイ) 221S9A/11 [21.5型液晶ディスプレイ/1920×1080/HDMI、D-Sub/スピーカー:あり/5年間フル保証] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/etre/cabinet/itemimage28/1267245.jpg?_ex=128x128)

![週刊少年マガジン 2026年13号[2026年2月25日発売]【電子書籍】[ 久世蘭 ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/6646/2000019776646.jpg?_ex=128x128)

![異世界クラフトぐらし〜自由気ままな生産職のほのぼのスローライフ〜(コミック) : 9【電子書籍】[ 立山鈴 ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/5710/2000019775710.jpg?_ex=128x128)

![大河の一滴 最終章 [ 五木 寛之 ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/5293/9784344045293_1_3.jpg?_ex=128x128)

![GQ JAPAN(ジーキュー ジャパン)特別表紙版 2026年 4月号 [雑誌] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0464/4912045920464.gif?_ex=128x128)

![こうやって、僕は戦い続けてきた。 「理想の自分」に近づくための77の習慣 [ 菊池 雄星 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0602/9784569860602_1_6.jpg?_ex=128x128)

![夏目友人帳 33 (花とゆめコミックス) [ 緑川 ゆき ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2033/9784592222033.gif?_ex=128x128)

![イラストでわかる建築設備 [ 山田信亮 ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/3482/9784816353482.jpg?_ex=128x128)

![医者が考案した たんぱく質をたっぷりとる長生きスープ [ 土田隆 ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/4168/9784776214168_1_3.jpg?_ex=128x128)