ニュース

「AMDにとってAIはトッププライオリティだ」AMDリサ・スーCEO、AI分野への本気の姿勢をアピール

2023年12月8日 11:39

AMDは米国カリフォルニア州サンノゼ市において12月6日(米国時間)、「AMD Advancing AI」と題した発表会を開催した。午前中には、CEOのリサ・スー氏など同社幹部による基調講演が行なわれ、生成AI向け新半導体製品や、AI PC向けの新しいSoCなどが発表された。

この中でAMDのスーCEOは「50年になるIT業界の歴史の中でAIは最大の技術変革だ。2027年にはデータセンター向けのAIアクセラレータの市場規模は4,000億ドル(日本円で58兆8,000億円)に達し、年成長率75%で成長する見通しだ。今後AMDはAIを最優先にしていくことになる」と述べ、AMDがAI向け半導体の開発や販売などを最優先に取り組み、直接の競合となるNVIDIAと本気で競っていくという意向を表明した。

Instinct MI300シリーズを正式発表。すでにOEMメーカーなどには出荷済み

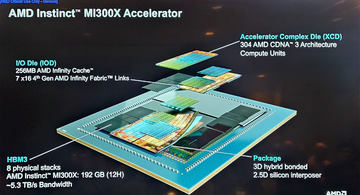

今回AMDが「AMD Advancing AI」と銘打って開催したイベントは、6月にサンフランシスコで行なわれた「Data Center and AI Technology Premiere」に次ぐもので、そこで概要を明らかにしていたGPUおよびAPU(CPU+GPU)と2つの「Instinct MI300シリーズ」を正式に発表した。

スー氏はGPUのInstinct MI300X(以下MI300X)、APUのInstinct MI300A(以下MI300A)の2製品を紹介し、それと同時にその2製品を採用したOEMメーカーや開発パートナーを紹介し、Instinct MI3000シリーズがいわゆるペーパーローンチ(プレスリリースを出すだけで実際には製品が流通していない状態)ではなく、すでに顧客が利用できるような状態であることを詰めかけた聴衆に印象づけた。

こうした発表会でスー氏が何度も強調したのが、データセンター向けのAIアクセラレータで最も大きな市場シェアをもっているNVIDIAとの比較だ(ここでのAIアクセラレータとはより広義の意味で、GPUとGoogleのTPUやIntel GaudiなどASICの専用アクセラレータ、その両方を含む)。現在AI学習の現場で最も使われている、NVIDIAの最新製品であるNVIDIA H100 GPU(以下H100)との比較データをスー氏は見せた(なお、NVIDIAはすでにH200やGH200を発表しているが、両製品とも投入は来年になるため今回は対象にされていない)。

スー氏は「今回我々が発表するMI300Xは、競合他社のH100と比較して、FP64やFP32のピーク性能で上回っており、メモリ容量は2倍に、メモリ帯域も1.6倍になっている。大きなメモリやメモリ帯域は、顧客がより大規模なLLMを動かすことを可能にする。このため、推論ではH100と比較してLlama 2 70Bで1.4倍、Bloom 176Bで1.6倍になり、学習では競合と同等の性能を実現している」と述べ、MI300XがH100と比較して、推論で性能が向上しており、学習では同等、そしてメモリ容量と帯域幅では上回っていることが特徴だと強調した。

CSPではAzure、OCIが提供。OEMメーカーはDell、Supermicro、Lenovoなどが提供する計画

今回の会見には、AMDのパートナーとなるCSP(クラウドサービスプロバイダー)やOEMメーカーなどが招待されて参加していた。MI300Xは、すでに11月に開催されたMicrosoftの年次イベント「Ignite」において、MI300XがMicrosoftのパブリック・クラウドサービス「Azure」でインスタンスとして提供開始される計画だと明らかにされている。

今回はそのMicrosoftからMicrosoft CTO 兼 AI担当上席副社長 ケビン・スコット氏が呼ばれて、MicrosoftのAMDのパートナーシップやMI300XのAzureでの提供などに関して説明された。

そして、その次にOracle OCI(Oracle Cloud Infrastructure)担当上級副社長 カラン・バッタ氏がステージに登場し、Oracleのパブリック・クラウドサービスであるOCIでMI300Xを採用する計画だと明らかにした。Oracleは、Oracle Exadata X10Mというミッションクリティカル向けデータベースサーバーでもAMDの第4世代EPYCプロセッサを採用することを発表しており、今回のOCIインスタンスでのMI300X採用はそれに次ぐものとなる。

OEMメーカーは、Dell Technologies、Supermicro、Lenovoの3社が呼ばれた。Dell ISG担当事業本部長 アーサー・ルイス氏、Supermicro CEO チャールズ・リアング氏、Lenovo 上席副社長 兼 インフラストラクチャーソリューション事業部 事業本部長 カーク・スコーゲン氏の3名が登壇し、それぞれMI300Xを搭載した製品を明らかにした。DellはDell PowerEdge XE9680を、SupermicroはSMC-AS8125GS-TNMR2を、Lenovoは2024年前半中にThinkブランドのサーバーで、MI300Xを搭載したシステムを提供開始すると説明した。

2EFLOPSのEl Capitanにも採用されたCPU+GPUのAPU「MI300A」

AMD 上席副社長 兼 データセンターソリューション事業部 事業本部長 フォレスト・ノロッド氏はMI300Aについて紹介した。ノロッド氏は「MI300Aは、MI300XのGPUのチップを2つ取り払って、CPUのチップを3つ搭載して構成されている。重要なことはCPUとGPUがHBMメモリを共有しており、CPUからGPUにデータをコピーしたりする必要がなく、それが高性能の理由になっている」と述べ、CPUとGPUが別チップになっているNVIDIAのH100のような仕組みに比べて、HPCのアプリケーションで大きな性能向上があると述べた。

ノロッド氏が示したOpenFOAM(オープンソースの数値解析、流体力学解析の開発ツール)での性能の違いによれば、H100に比較してMI300Aは4倍高速だという。その性能差の由来は、GPUだけだとほぼ同等だが、メモリ容量と帯域幅、そして最大の理由はユニファイドメモリだと説明した。

ユニファイドメモリとは、CPUとGPUが同じメモリアドレス空間を共有する仕組み。通常、CPUとGPUはそれぞれ異なるメモリとメモリ空間を持っており、CPUのデータをGPUで処理するにはCPUのメモリからGPUのメモリにデータをコピーする必要がある。そのため、CPUとGPUの間のインターコネクトの帯域幅がボトルネックになるなど、性能が低下する原因になる。

MI300Aのようなユニファイドメモリでは、最初から物理的にも論理的にも、CPUとGPUが同じメモリ空間を利用するため、そうしたCPUとGPU間でデータをコピーする必要がない。インターコネクトのボトルネックなどがないため、高い性能を発揮することが可能なのだ。

こうしたMI300Aは、LLNL(ローレンス・リバモア国立研究所)に設置されるスーパーコンピュータ「El Capitan」に採用される計画で、現在HPEがLLNLで構築を進めている。今回はHPEから上級副社長 兼 HPC/AI担当CPO トリッシュ・ダムクロガー氏がステージに呼ばれて、LLNLとHPEがどのようにEl Capitanの構築を進めていて、2EFLOPSという高性能を実現するためにMI300Aが役立っていることが説明された。

Ryzen AIを搭載したRyzen 8040シリーズを発表、Microsoftと一緒にAI PCを推進

また、スー氏は同日にAMDが発表したノートPC向けの「Ryzen 8040シリーズ」について触れ、業界で「AI PC」と呼ばれている、PCのローカルでNPUを利用して推論できるPCの実現に向けて努力して行くと明らかにした。今回発表されたRyzen 8040は、開発コードネーム「Hawk Point」で呼ばれる製品で、基本的には2023年1月に発表されたRyzen 7040シリーズ(Phoenix)のリフレッシュ版となる。ダイのリビジョンアップなどにより、より高クロックで動作させるようにした製品だ。

スー氏はAI PCの実現に向けてOSパートナーとなるMicrosoft 執行役員 Windows・デバイス担当 パバン・ダビュユリ氏をステージに呼び、AMDとMicrosoftが共同でAI PCの実現に向けて協業していくと説明した。

スー氏は「ソフトウェア業界の皆さんは、とにかくTOPSだという(笑)。そこで我々は今後も性能を強化していく計画で、AMDはAI PCに向けて非常に強力なロードマップをもっている。今回発表したRyzen 8040シリーズの先には2024年にStrix Pointを投入し、新しいNPUで性能を引き上げていく」と述べ、今後もAI PCの実現に向けてNPUを強化していく計画だと強調した。

AMDはAI向け製品を最優先。AIアクセラレータ市場に本格的に参入とアピール

スー氏は今回の講演の冒頭で、「50年になるIT業界の歴史の中でAIは最大の技術変革だ」と述べ、データセンター向けのAIアクセラレータ(GPUやASICで固定機能を実現するAIアクセラレータの両方)が今後も急速に成長し、2023年には450億ドル(日本円で6兆6150億円)が、2027年には4,000億ドルと75%もの年平均成長率で成長していく見通しであるというアナリストの分析を説明し、そこにAMDもInstinct MI300シリーズで本格的に参入するのだと強調した。

そして講演の最後には「AMDはAIをNo.1のプライオリティにしている」と述べ、AIでNVIDIAのような強力な競合と戦って市場をとっていくことが、AMDにとって最も重要な戦略になっていると強調し、今後すでにAIアクセラレータ市場でシェアを持つ競合と本格的に競争していく意向を明らかにした。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:4位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![ASUS エイスース 液晶ディスプレイ Eye Care [ 21.45型 / フルHD(1920×1080) / ワイド ] ブラック VP227HF 製品画像:18位](https://thumbnail.image.rakuten.co.jp/@0_mall/r-kojima/cabinet/n0000001479/4711387948569_1.jpg?_ex=128x128)

![呪術廻戦≡(モジュロ) 2【電子書籍】[ 芥見下々 ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/1612/2000019641612.jpg?_ex=128x128)

![無職転生 〜異世界行ったら本気だす〜 24【電子書籍】[ フジカワ ユカ ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/6100/2000019696100.jpg?_ex=128x128)

![M!LK 10th ANNIVERSARY PHOTOBOOK ~パリじゃん~ [ M!LK ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/5876/9784391165876_1_3.gif?_ex=128x128)

![[3月中旬より発送予定][新品]ゴールデンカムイ (1-31巻 全巻) 全巻セット [入荷予約] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/mangazenkan/cabinet/syncip_0021/m9880472800_01.jpg?_ex=128x128)

![松本清張の昭和 (講談社現代新書) [ 酒井 信 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2304/9784065422304_1_2.jpg?_ex=128x128)

![超かぐや姫!(1) (ファミ通文庫) [ スタジオクロマト・スタジオコロリド ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/7348/9784047387348_1_23.jpg?_ex=128x128)

![デコピンのとくべつないちにち (単行本 608) [ 大谷 翔平 ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9368/9784591189368.jpg?_ex=128x128)