西川和久の不定期コラム

Ryzen AI MaxのLLMとAI画像生成の性能は?OCuLinkでどちらも快適に♪「GMKtec EVO-X2」(後編)

2025年10月8日 06:00

GMKtecによるRyzen AI Max+ 395搭載ミニPC「EVO-X2」のレビュー。前編は普通のミニPC的レビューだったので、後編はいよいよAI関連をいろいろ試してみたい。結論から先に書くと、OCuLinkで外部dGPU接続可能と分かり、本機の可能性は大きく広がった。

LLM編。AIPC、LM Studioとgpt-oss-120b

まずプリインストールされているAIPCアプリ、以前はログインしなくても使えていたのだが、

本機にプリインストールされているものはログイン必須へ。今回は試用しなかった。Updateダウンロード用のサイトもログイン画面が初めに表示されているため、どこかのバージョンで仕様が変わったのだろう。

なお本アプリの詳細はここにあるので、興味のある人は見てほしい。128GBモデルだと、

- deepseek-r1:14B、deepseek-r1:32B、deepseek-r1:70B

- Llama3: 8B

- Llama4:109B-Q4KM (プリインストール)

- GPT-OSS:20B、GPT-OSS:120B

- deepseek-r1:32B Super (Intel特殊)

対応とある。プリインストールのモデルは、

に68.5GBほどのファイルあり、上記からおそらくLlama4:109B-Q4KMだと思われる。アカウントを作ってAIPCを使わないのであれば不要(サイズも大きい)なのでアプリごと削除してもいいだろう。

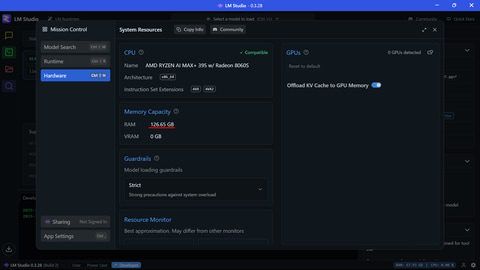

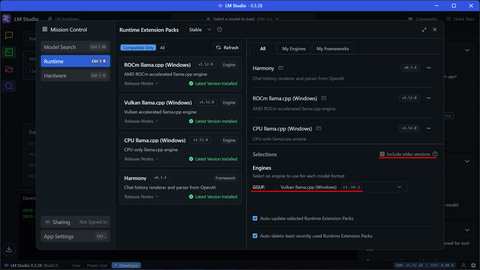

この関係で、今回はLM Studioのみで試している。まず一番に気になるのがgpt-oss-120bがどの程度で動くか!?BIOSの設定でVRAMを

- 1GBへ。CPUで推論

- 96GBへ。GPUで推論

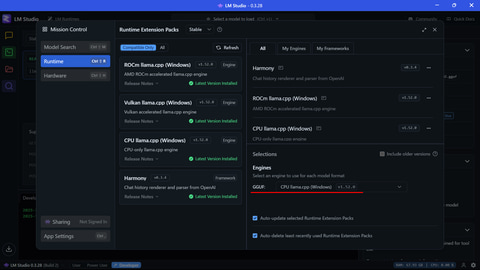

として、それぞれGGUFエンジンをCPUとVulkanに置いて試してみた。

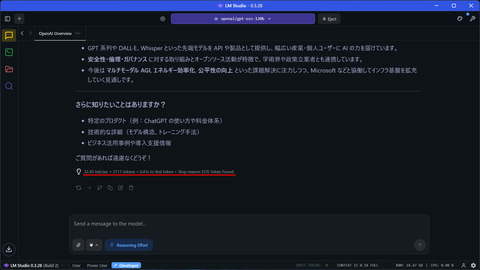

まずVRAM 1GBでCPUの場合、LM Studio的にはRAMが126.65GB認識される。実行するとCPUは40%前後、RAMは78GB程度を使用する。結果は14.15tok/s。これだとほかのRyzen AIプロセッサで試したケースと変わらない。LPDDR5Xの帯域幅勝負というところか。

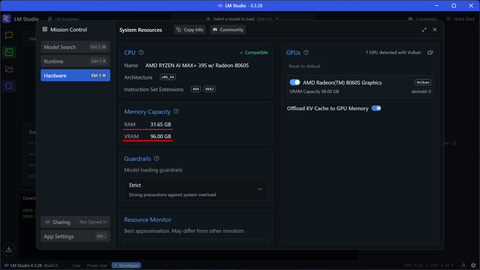

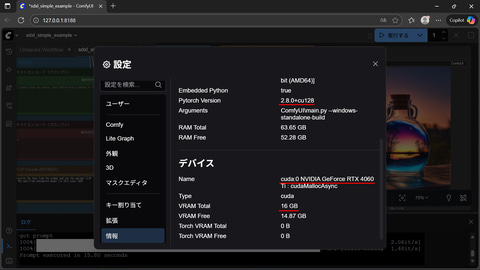

次にVRAMを96GBにし、GGUFエンジンをVulkanへ変更(ROCmにした状態では動かなかった)。LM Studio的にはRAMは31.65GB、VRAMは96GBと認識している。

なおVulkanモジュールは、(執筆時)最新のv1.52.0だと逆に遅くなってしまったので、v1.50.2を使用。

実行してみると、CPUは9%前後、RAMは31.4GB、VRAMは69.3GB程度を使用する。結果は32.45tok/s。筆者手持ちのM4 Max 512GB搭載MacBook Pro 14が70+αtok/sなので半分近く出ている。メモリのバンド幅256GB/s vs 512GB/sの違いが、そのまま出ている感じだろうか。加えて30万円前後 vs 80万円前後……と考えればコストパフォーマンスはかなり良い。この価格帯でgpt-oss-120bクラスのLLMを動かしたいときは、本機一択という感じだ。

なおUbuntuだとVRAMを112GBに設定できるようだが、SSDを入れ替えてOSインストール、いろいろ設定とあるため、別途機会があればご紹介したいと思う。

生成AI画像編。AMDならAMUSEだがROCmネイティブ動作のComfyUIも実験

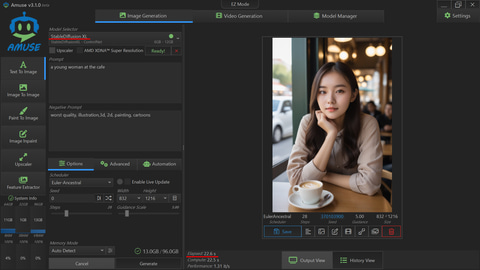

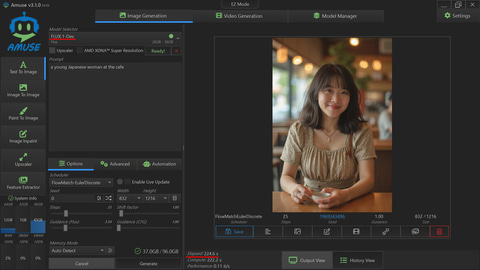

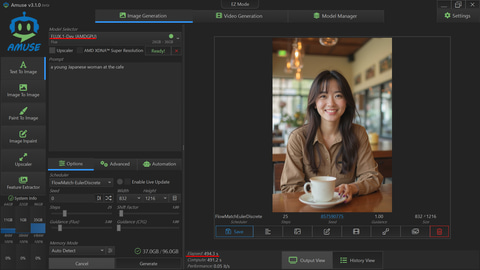

次は生成AI画像。BIOSでRAM 64GB、VRAM 64GBに設定。まずAMDの場合、難しいことなく、一発で設定可能な「AMUSE」から。

セットアップは簡単で、ダウンロードしたexeファイルを実行するだけ。Model Managerで一覧を眺めるとAMD専用モデルが、「SD 1.5」「SDXL」「DreamShaper Lightning」「SDXL Turbo」「SD 3 Medium」「SD 3.5 Medium」「SD 3.5(Large?)」「SD 3.5 Turbo」「FLUX.1 schnell」「FLUX.1 dev」……と、ちょっと前から結構増えている。

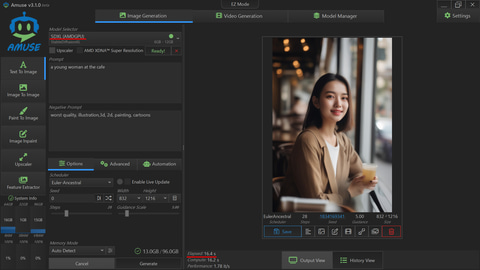

まずは、普通のSDXLとAMD用SDXLを832x1,216/28 stepsで比較すると、22.6s vs 16.4sと、結構な違いが出た。いつも参考にしている832×1216:神里綾華ベンチマークサイトのデータを眺めると、(テスト内容は若干異なっているが)ザックリGeForce RTX 3050/8GB(より速い)またはGeForce RTX 3060/12GB前後相当となる。

FLUX.1 devも同様に2種類試したところ(25 stepsへだけ変更)、224.6s vs 494.3sと逆に遅くなってしまった。iGPUではダメで、dGPU用なのかもしれない。

この結果からも分かるように、SDXLクラスであればそれなりに使えるという感じだろうか?

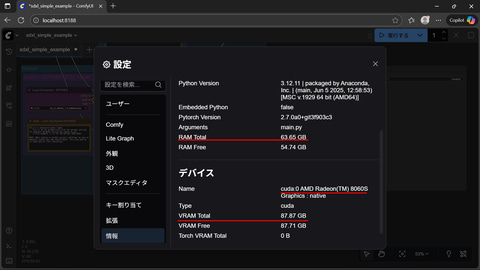

次にROCmネイティブ動作のComfyUIを動かしてみたい。iGPUはRadeon 8060S Graphics = gfx1151なので、通常NVIDIA系だとCUDAなのだが、これ用のtorchをインストールする。手順は以下の通り。

python 3.12で環境を作り、以下3つをpip install

https://github.com/scottt/rocm-TheRock/releases

- torch-2.7.0a0+git3f903c3-cp312-cp312-win_amd64.whl

- torchvision-0.22.0+9eb57cd-cp312-cp312-win_amd64.whl

- torchaudio-2.6.0a0+1a8f621-cp312-cp312-win_amd64.whl

次に適当な場所でComfyUIをgit clone、フォルダへ移動

pip install -r requirements.txt

python main.py

実行すると、numpyが2.3.3となっているため、numpy<2にしろとのエラーが出た。そこでpip install "numpy<2"としたところ、エラーは消えた。

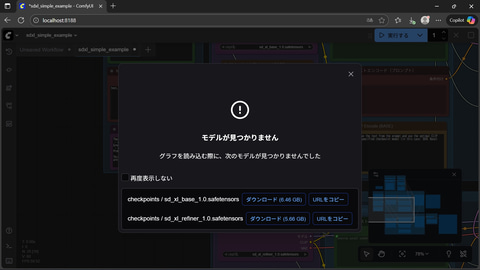

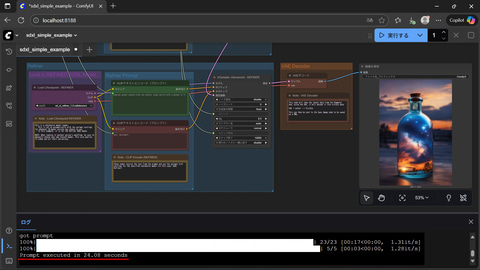

ComfyUIを起動。テンプレートでSDXLを選択。表示されたモデル2つをダウンロードし、ComfyUI/models/checkpointsへコピー。これで準備は整った。

SDXL 832x1216, 28 steps(main 23 + refiner 5)を実行すると 24.08s。AMUSEを使った汎用版SDXLとほぼ同じ結果だ。

ComfyUIはAMUSEと比較していろいろなNodeが使え、応用の幅が広がるため、こちらを使うのもありだろう。

OCuLinkでdGPUは接続可能!?

さて、筆者的に最大の関心は、空きのM.2スロットへOCuLinkアダプタを付け、外部に強力なdGPUを接続可能かどうかだ。ただ、同じプロセッサを搭載したMINISFORUM MS-S1 MAXのPCIeスロットではNG(ただ、USB4やUSB4 2.0で接続できることは編集部で確認済み)という結果が出てるので、ダメ元で確認した。

【10月10日追記】MS-S1 MAXではUSB4でビデオカードが接続可能な旨を追記しました。

本機は、ロゴのある方のパネルを外せばダイレクトにM.2スロットへアクセスでき、改造は激簡単。

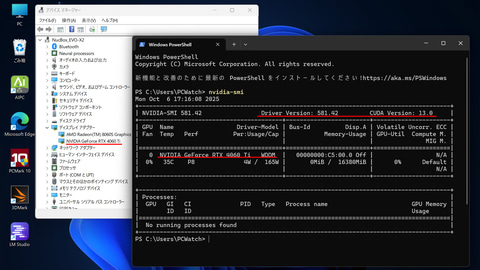

先にドック側を電源オン、続いて本体を電源オン。そして、NVIDIAのサイトからドライバをダウンロードしてインストールしたところ……nvidia-smiで、GeForce RTX 4060 Ti(16GB)が見えている。

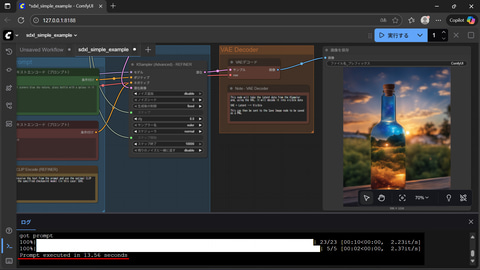

「本当に動いているのか?」と、上記のComfyUIは使わず別途ポータブル版をダウンロードし7zを展開、run_nvidia_gpu.batで起動。SDXLのWorkflowを読み込み実行。動いた(笑)!

SDXL 832x1216, 28 steps(main 23 + refiner 5)を実行すると 13.56s。M.2なのでPCIe x4接続になってしまい、x16接続より遅くなるとはいえ、iGPUよりは当たり前だが全然速い。もう少し強いdGPUにすればFLUX.1 devでもQwen-Imageでもストレスなく生成可能。

これは本機にとって激朗報だ。つまり

- LLMはLPDDR5X 128GBを使いgpt-oss-120bが32tok/sほど出て、この価格帯としては最強

- OCuLinkで外部dGPUを接続すれば生成AI画像/動画も爆速!

と、LLMと生成AI画像/動画、どちらもコストパフォーマンス抜群の最強環境となる。ただしOCuLinkに関しては筆者も編集部も保証しないので、自己責任でお願いしたい。

以上のようにGMKtec「EVO-X2」は、VRAMに96GBを割り当てればgpt-oss-120bが32tok/sで動き、生成AI画像はSDXLクラスなら何とか使用可能。

加えて空きのM.2スロットにOCuLinkアダプタを接続、外部に強力なdGPUさえ接続すればいくらでもパワーアップできるという、個人が購入可能な価格帯としては、どちらも使える最強のAIPCとなりえるミニPCだ。「おっ!」と思った人は、ぜひ試してほしい。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:2位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![ASUS エイスース ノートパソコン Chromebook CM30 Detachable [ 10.5型 / Chrome OS / MediaTek / メモリ8GB / eMMC128GB ] フォグシルバー CM3001DM2A-R70006 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/r-kojima/cabinet/n0000001030/0197105472037_1.jpg?_ex=128x128)

![NAB5R [i5-13500H /RAM:32GB /SSD:1TB /Windows 11 Pro] NAB5R-32/1T-W11Pro(13500H) 製品画像:7位](https://thumbnail.image.rakuten.co.jp/@0_mall/shoptsukumo/cabinet/pc22/4529327909354_1.jpg?_ex=128x128)

![[ケーブルセット価格] DELL U2417H 23.8インチ ワイド 液晶モニター フルHD ブラック 非光沢 ノングレア IPS フレームレス HDMI DisplayPort miniDisplayPort USB3.0 縦置 高さ調整 可能 スイーベル機能 デジタルハイエンドシリーズ 23.8型 PCモニター 中古モニター 黒 中古 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/seihan-shop/cabinet/monitor/pc-u2417h.jpg?_ex=128x128)

![[P5倍★19日20:00-24日9:59]【3年保証】モニター 21.5インチ 23インチ 27インチ フルhd 高画質 100Hz VA ノングレア 非光沢 スピーカー内蔵 ディスプレイ パソコンモニター PCモニター フルハイビジョン 23.8インチ 液晶モニター DT-JF アイリスオーヤマ * 製品画像:17位](https://thumbnail.image.rakuten.co.jp/@0_mall/eleking/cabinet/wh15/112988sku_ins.jpg?_ex=128x128)

![★エイスース / ASUS アイケア液晶ディスプレイ フルHD(1920x1080) IPSパネル VA279QGZ [27インチ]【PCモニター・液晶ディスプレイ】【送料無料】 製品画像:16位](https://thumbnail.image.rakuten.co.jp/@0_mall/e-cutestyle/cabinet/img051/p000000909808_1.jpg?_ex=128x128)

![こども語彙力クイズ366 1日3分で頭がよくなる! [ 高濱正伸 ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1519/9784284001519_1_3.jpg?_ex=128x128)

![GIANT KILLING(69) (モーニング KC) [ ツジトモ ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9273/9784065429273.gif?_ex=128x128)

![タッチペンでまなべる!はじめてのひらがなずかん 英語つき [ 小学館はじめてずかんチーム ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/5548/9784099425548_1_12.jpg?_ex=128x128)

![「平成の天皇家」と「令和の天皇家」 二つの家族はなぜ衝突したのか (講談社+α新書) [ 大木 賢一 ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/6692/9784065426692_1_3.jpg?_ex=128x128)

![中学英語をもう一度ひとつひとつわかりやすく。改訂版 [ 山田 暢彦 ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/4821/9784053054821_1_4.jpg?_ex=128x128)

![ミステリと言う勿れ(16)【電子書籍】[ 田村由美 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/7173/2000019557173.jpg?_ex=128x128)

![ニセモノの錬金術師 5【電子書籍】[ 杉浦 次郎 ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/6133/2000019696133.jpg?_ex=128x128)

![ミステリと言う勿れ(16) (フラワーコミックス α) [ 田村 由美 ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2951/9784098732951_1_45.jpg?_ex=128x128)

![紀文のおひるねちくわクッションBOOK [ 株式会社紀文食品 ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/5964/9784847075964_1_3.jpg?_ex=128x128)

![おともだちえほん はじめての「よのなかルールブック」 [ 高濱正伸 ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1540/9784284001540_1_3.jpg?_ex=128x128)