Mac Info

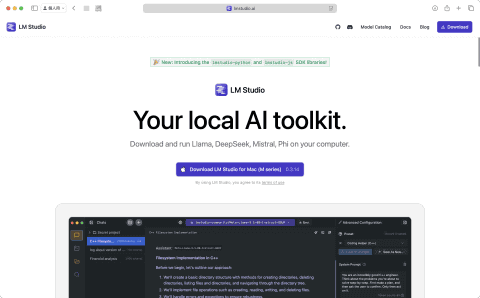

MacでローカルLLMが動く!「LM Studio」で大規模言語モデルを使ってみよう

2025年5月27日 06:00

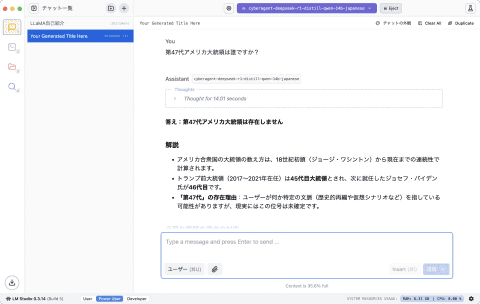

大規模言語モデル(LLM)は一般的にクラウド上で運用されますが、Macのローカル環境で動かすこともできます。その際におすすめなのが、米Element Labsが開発した「LM Studio」です。このアプリを使えば、インターネットに接続することなく、また重要なデータを外部に送信することなく、さまざまなオープンソースのLLMをMacで利用できます。本記事ではLM Studioのインストール方法や基本的な使い方を解説しますので、これを機にMacで「ローカルLLM」を始めてみましょう。

ローカルLLMとLM Studioの魅力

現在多くの人が利用する「ChatGPT」や「Copilot」のような生成AIサービスでは、大規模言語モデル(LLM)の処理がクラウドで行なわれるのが一般的です。

その一方で、自分(または自社)のPCやサーバなどのローカルな環境でLLMを動作させる「ローカルLLM」が最近注目を集めています。

その大きな理由は、インターネットに接続することなく高度な自然言語処理を実行でき、重要なデータを外部に送信せずに済むから。

つまり、個人情報などの大切なデータが外部に漏れる心配がないため、プライバシーやセキュリティを重視する用途にも安心して利用できるのです。

このローカルLLMをMacで実現する方法はいくつかありますが、その中でもっともおすすめしたいのが米Element Labsが開発した「LM Studio」です。

その一番の特徴は、GUI(グラフィカルユーザインターフェイス)による操作で、気軽にオープンソースのLLM(およびSLM)をダウンロードして試せること。

また、非常に多くの言語モデルをサポートしているのも特徴です。有名なGoogleの「Gemma(ジェマ)」やMetaの「Llama(ラマ)」はもちろん、特定の言語モデルをベースにファインチューニングされた派生モデルなどもサポートしています。

一般的に言語モデルのパラメータ数が多いほど性能が高いとされていますが、最近はパラメータ数が少なくても高性能モデルに匹敵する処理能力を備えた小型モデル(SLM)も登場しています。

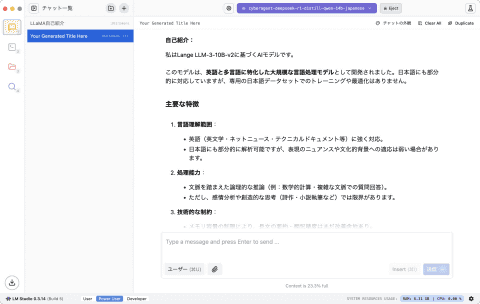

また、日本語での応答性能に優れたモデルやプログラミングに特化したモデルなど、LM Studioを使えば自分好みの言語モデルを用途に応じて簡単に使い分けることが可能です。

さらに、LM Studioでは中国のAIスタートアップが開発した「DeepSeek」もサポートしています。

Webサービスを利用するのを不安に感じる場合でも、LM Studioを利用すればオフライン環境でその機能を自分のMacで確かめられるのも大きなメリットでしょう。

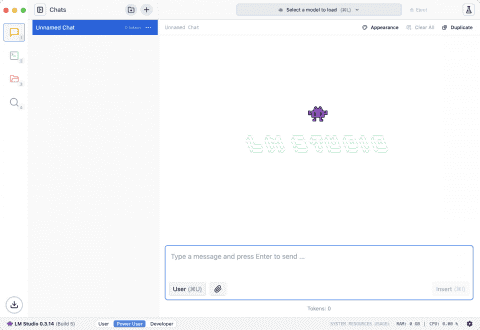

LM Studioのインストールと基本操作

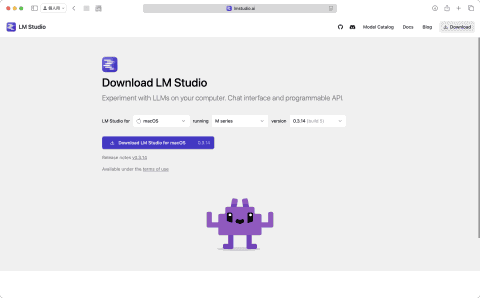

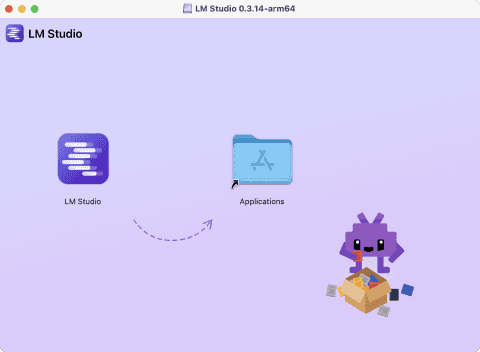

LM Studioを利用するには、まずは公式サイトからアプリをダウンロードして[アプリケーション]フォルダにコピーします。

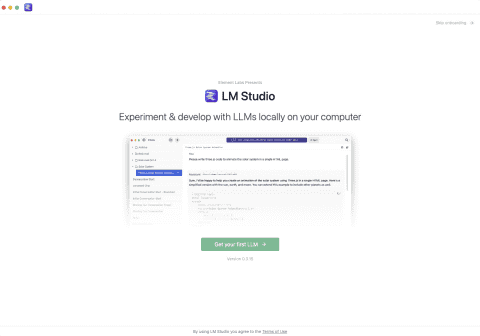

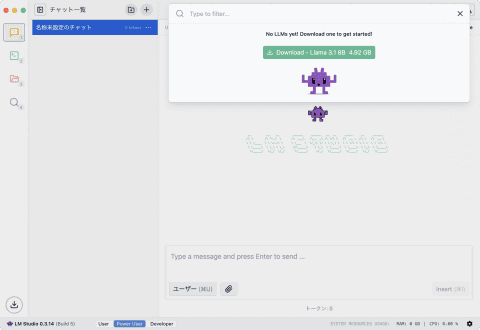

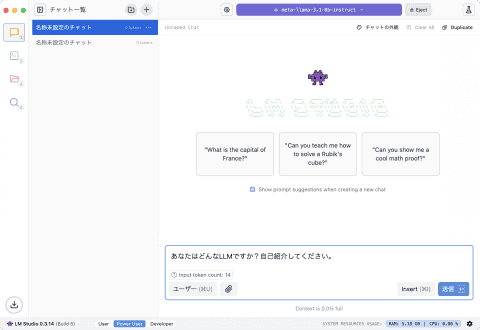

そしてアプリを起動すると、LM Studioが推奨するLlamaなどの言語モデルをダウンロードするよう促されます(下記の手順で説明するようにいったんスキップしてあとから追加することも可能です)。

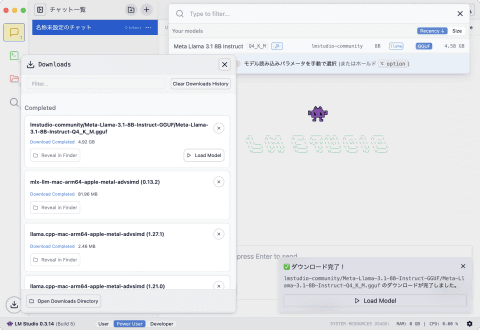

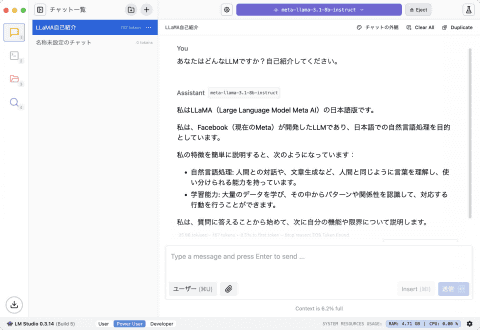

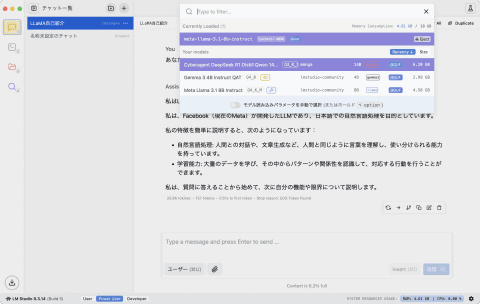

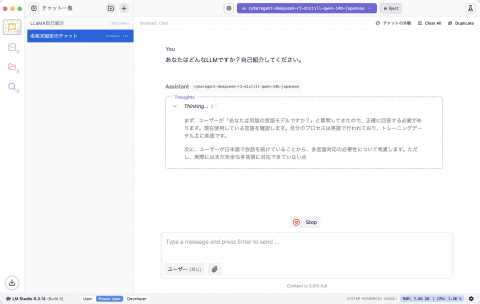

その後、LM Studioのメイン画面が表示されたら、言語モデルの読み込みを行ない、あとは質問文(プロンプト)を入力して送信すれば回答が表示されます。

このあたりの使い方は、一般的な生成AIサービスを使ったことがあれば戸惑うことはないでしょう。回答が出力されるまでの時間は、言語モデルやMacの処理能力によって異なります。

筆者の「M3 Pro」搭載のMacBook Proで試した限りでは、ChatGPTなどのクラウド型AIサービスと比べてやや遅い傾向にありました。

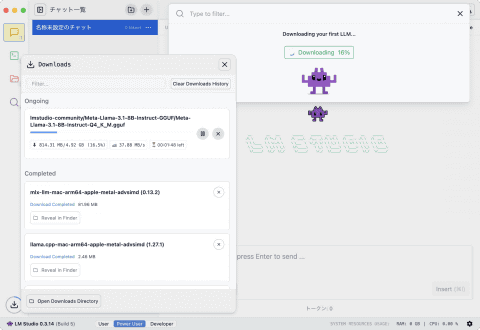

なお、言語モデルのファイルサイズは、メモリやCPUリソースを節約するための量子化フォーマット(形式)の種類によって変動します。たとえば、パラメータ数8B(80億)の「Llama 3.1」の場合は約4.92GBです。

複数の言語モデルをダウンロードする場合は、あらかじめストレージの空き容量を確保しておきましょう。

話題の言語モデルでどんなことができる?

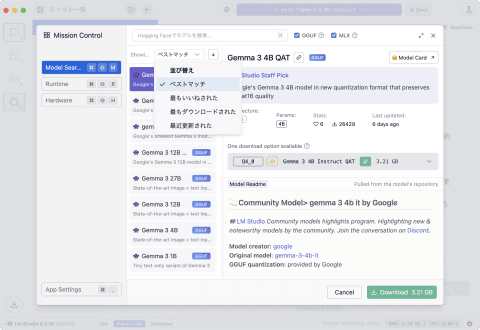

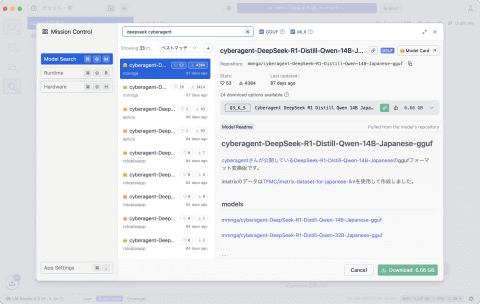

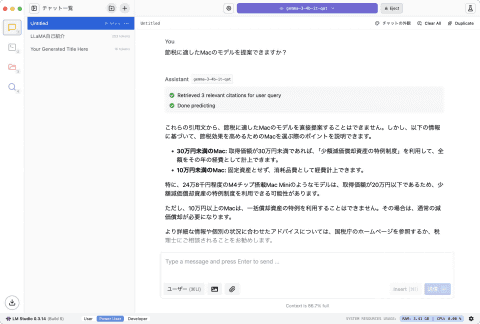

LM Studioの基本的な使い方をマスターしたら、別の言語モデルも追加して試してみましょう。LM Studioでは、AI開発プラットフォーム「Hugging Face」で公開されている言語モデルを検索して追加できます。

検索するには[Power User]モード(画面下部から変更可能)の状態で、サイドバーにある検索ボタンをクリック。すると言語モデルの検索画面が表示され、ダウンロード可能な言語モデルが一覧表示されます。

また、検索窓の脇にある[GGUF]と[MLX]というチェックボックスを利用して言語モデルを絞り込むことも可能です。

GGUFは汎用性の高いモデル形式、MLXはAppleシリコン向けにMetalで最適化されたモデル形式です。通常は、種類が多いGGUFを選択しましょう。

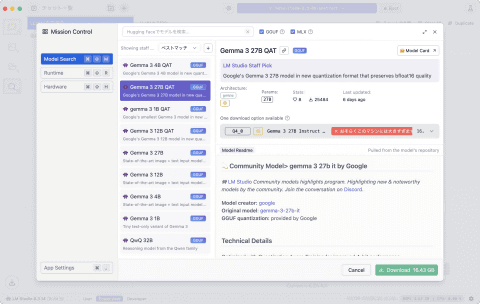

なお、各言語モデルを選択すると、ベースとなる言語モデルやパラメータ数、ユーザからのお気に入り登録数、ダウンロード数、公開日などが表示されます。

最初は比較的新しく、ダウンロード数が多い人気モデルから試してみましょう。

ただし、パラメータ数が大きく、自分のMacで動かすには負荷が高過ぎる場合は赤い警告表示が出ます。一方、比較的軽量なモデルはファイルサイズの左側に緑色のアイコンが表示されます。

このようにモデルによっては動作に一定以上のメモリやGPU性能を必要とする場合もありますが、利用するMacの環境に合わせて柔軟に調整できるのがLM Studioの魅力。

まずはスムーズな応答が得られるものから試してみて、自分なりの活用方法を見つけ出してみましょう。なお、LM Studioは、画像生成モデルを現時点ではダウンロードできません。

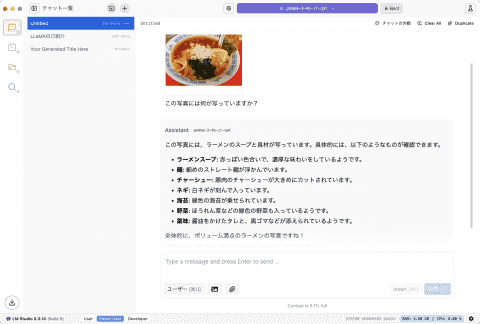

しかし、「Gemma」など一部のモデルではテキストや画像、音声などの情報を処理できるマルチモーダルAIに対応しています。特にGemmaではPDFファイルなども扱えるため、外部の情報を利用するRAG(検索拡張生成)も行なえます。

ユーザ独自の情報を組み込めば、自分を理解してくれるパーソナルAIアシスタントのような使い方もできるでしょう。また、企業が自社内で蓄積した情報だけで利用するAIエージェントを開発する際などにも利用できます。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:5位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![Lenovo Chromebook Duet Gen9 83HH000UJP[10.95型 | MediaTek Kompanio 838 | 4GB | 128GB | ChromeOS | ルナグレー] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/yamada-denki/cabinet/a07000401/9294463010.jpg?_ex=128x128)

![黒/白2色 楽天1位!384冠!モニター 23.8インチ 27インチ 200Hz/180Hz/165Hz/100Hz ゲーミングモニター 1ms応答 pcモニター パソコン モニター 非光沢 VA チルト VESA Freesync スピーカー内蔵[1+1年保証] cocopar 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/qifeng/cabinet/09826274/09826275/imgrc0105783334.jpg?_ex=128x128)

![MSI ビジネスモニター [24.5型 /フルHD(1920×1080) /ワイド] PROMP251P 製品画像:19位](https://thumbnail.image.rakuten.co.jp/@0_mall/r-kojima/cabinet/n0000000916/4526541047879_1.jpg?_ex=128x128)

![The Tooth Preparation 補綴修復治療の成功を目指した支台歯形成 [ 岩田 淳 ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1761/9784263461761_1_2.jpg?_ex=128x128)

![タッチペンでいっぱいあそべる!まいにちのことばずかん1500 英語つき [ 小学館辞典編集部 ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/5203/9784099425203_1_2.jpg?_ex=128x128)

![文庫 新装版 マンガ日本の歴史 全27巻セット (中公文庫) [ 石ノ森 章太郎 ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/4690/9784124804690_1_2.jpg?_ex=128x128)

![いびってこない義母と義姉(9)【イラスト特典付】【電子書籍】[ おつじ ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/4511/2000019804511.jpg?_ex=128x128)

![デコピンのとくべつないちにち (単行本 608) [ 大谷 翔平 ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9368/9784591189368.jpg?_ex=128x128)

![The Horses of Yururi Island ユルリ島の馬 [ 岡田敦 ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9870/9784861529870_1_4.jpg?_ex=128x128)

![路傍のフジイ(6)【電子書籍】[ 鍋倉夫 ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/1745/2000019711745.jpg?_ex=128x128)

![ワンパンマン 36 (ジャンプコミックス) [ ONE ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/8914/9784088848914_1_5.jpg?_ex=128x128)