ニュース

MicrosoftやAmazonに続き、Googleも生成AI向け独自CPU投入

2024年4月9日 21:00

Googleのクラウド部門「Google Cloud」は、9日からラスベガスにおいて年次イベント「Google Cloud Next '24」を開催する。それに先だって報道発表が行なわれ、同社が開発してきたArm CPUとなる「Google Axionプロセッサ」(グーグルアクシオン、以下Axion)を発表した。

これまでGoogle Cloud向けには、AI学習専用のTPU(Tensor Processing Unit)としてArm製のプロセッサが提供されてきたが、CPUに関してはIntelやAMDなどの汎用製品が用いられてきた。CSP(クラウドサービスプロバイダ)として独自CPUを投入するのは、AWS、Microsoftなどに続く形となる。

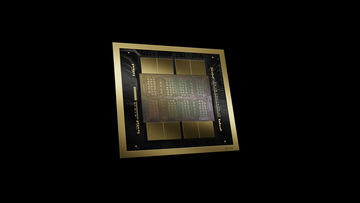

加えてGoogle Cloudは、2023年12月に発表したTPUの最新版「TPU v5p」がGA(General Availability、一般提供開始)になったこと、さらにはネットワークの帯域幅を2倍にした「NVIDIA H100 Tensor Core GPU」(以下H100)を採用したVM「A3 Mega」の投入を明らかにするなど、高まり続ける生成AIの学習を処理するための演算能力強化が発表されている。

AWS、Microsoftに続きGoogle CloudもArm CPUを投入

今回Google Cloudが発表したAxionは、Armが提供する「Neoverse V2」デザインを採用。CPUコア数などは現時点で未発表だが、性能に関しては触れられており、現在クラウド利用可能なArm CPUのインスタンスよりも30%高い性能を発揮し、Googleが提供するx86ベースのVM(Google Cloudでのインスタンスのこと)に比べて50%高性能で、60%電力効率が優れていると説明されている。

インスタンスという表示からも示唆されている通り、恐らくAWSのGravitonの、いずれかの世代と比較して30%性能が高いという意味だと理解できる。ただし、それが2023年11月に行なわれたAWS re:Invent 23で発表された「Graviton4」との比較なのか、その前の世代である「Graviton3」との比較なのかは現時点では明確ではない。

Graviton4は、Axionと同じNeoverse V2のデザインを採用しているので、コア数が同じならさほど性能は変わらないと想定できるので、Graviton4との比較ならCPUコア数が多いか、あるいはGraviton3との比較だと考えられる。

Googleが提供しているネットワークオフロードの「Titanium」と組み合わせることで、仮想マシンやネットワーク処理のオーバーヘッドをオフロードすることが可能になるという。

自社設計のArm CPUを自社のクラウドサービスに導入するのはCSPのトレンドになっており、2018年から取り組んできたAWSに加えて、2023年11月にはMicrosoftが「Cobalt」と呼ばれるArm CPUの導入を発表している。今回Google Cloudがその列に加わったことで、AWS、Microsoft Azure、Google CloudというCSPのトップ3がすべてArm CPUを自社のクラウドサービスに導入したことになる。

Googleによれば、Axionは2024年中にGoogle Cloudの顧客に提供開始される予定だ。

TPU v5eの一般提供開始。ネットワーク帯域幅2倍のA3 Megaは5月から

今回のGoogle Cloud Next '24において、Googleは高まり続ける生成AIの学習演算に向けたコンピューティング環境の拡充を明らかにしている。

まず、2023年12月のGemini発表時に同時に発表されたTPU v5pの一般提供が開始された。GoogleはTPU v5の世代ではすでに2つの製品を明らかにしており、2023年8月の「Google Cloud Next '23」で電力効率重視のTPU v5eを、その後12月に追加で性能重視のTPU v5pを、それぞれ発表していた。その時点ではTPU v5pは発表のみだったが、正式に一般提供開始が明らかにされたことになる。

また、Google Cloudは、NVIDIA H100を搭載した新しいVM「A3 Mega」を発表した。A3 Megaは従来A3として提供されていたH100を利用したVMをベースに、ネットワーク周りの帯域幅を2倍に拡張したものとなる。A3 Megaは5月から一般提供開始される予定。

加えて、NVIDIAが提供しているConfidential Computeの機能にも対応する計画で、Intel TDX(Trust Domain Extensions)対応CPUのVMを利用している場合には、CPUとGPU間のデータが暗号化され、情報漏洩の危険性を低下させられる。

さらに、NVIDIAが3月に発表した新GPU「Blackwell」へ対応する計画もすでに明らかにしており、今後NVIDIA HGX B200とNVIDIA GB200 NVL72を搭載したVMを段階的に提供する予定だ。前者はAI、データ解析、HPC向けに、後者はLLMなどの大規模モデルの学習向けに投入される見込み。いずれも2025年の初頭までにGoogle Cloudで提供される計画だ。

そのほか、Intelの最新x86プロセッサ(第5世代Xeon)を搭載したVM「C4」と「N4」も発表されている。C4は従来の競合のx86インスタンスと比較してコストパフォーマンスが19%優れており、従来のC3(第4世代Xeon SP)と比較してコストパフォーマンスが25%向上している。

N4はよりコストに最適化したVMで、少ないリソース構成から最大vCPUが80コアまでスケールアップして利用できるようになっており、従来世代と比較して20%スループットが改善されているとGoogle Cloudは説明している。

C4、N4ともに、本日より提供開始と発表されている。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:5位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![【全巻】 呪術廻戦 0-30巻セット (ジャンプコミックス) [ 芥見 下々 ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/7675/2100014367675_1_3.jpg?_ex=128x128)

![わたしの幸せな結婚 6巻通常版【電子書籍】[ 顎木あくみ ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/9084/2000019629084.jpg?_ex=128x128)

![くわしく学ぶ世界遺産300<第6版> 世界遺産検定2級公式テキスト [ 世界遺産検定事務局 ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/8999/9784839988999_1_3.jpg?_ex=128x128)

![黄泉のツガイ 12巻【電子書籍】[ 荒川弘 ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/9042/2000019629042.jpg?_ex=128x128)

![自分とか、ないから。 教養としての東洋哲学 [ しんめいP ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1273/9784801401273_1_16.jpg?_ex=128x128)

![超一流の書く習慣 [ 青木仁志 ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0423/9784866430423.jpg?_ex=128x128)

![晴れの日の木馬たち [ 原田 マハ ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/7562/9784103317562_1_24.jpg?_ex=128x128)

![新明解国語辞典 第八版 [ 山田 忠雄 ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0781/9784385130781.jpg?_ex=128x128)

![新漢語林 第二版 [ 鎌田正 ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1638/9784469031638.jpg?_ex=128x128)