西川和久の不定期コラム

Sora 2級の映像がもうローカルPCで?生成AI動画の急進化を追う

2026年1月9日 06:09

CESで硬い話ばかり続いていると思うので、少し柔らかい話を(笑)。去年2025年10月に生成AI動画の話を書き、最後にハロウィンにちなんだMVを作ったが、あの時はあくまでもサービスを利用した時のケース。ところがこの冬になって、ローカル生成環境でも似たことができるようになったので今回はその辺りを書いてみたい。

動画生成AI、2025年秋の陣までの話

本論に入る前に2025年秋の陣の生成AI動画を軽くおさらいしたい。それ以前の話は記事の冒頭で触れているので、興味のある人は合わせてご覧いただければと思う。

2025年夏は「Sora 2」「Veo 3.1」などが登場し、一気に生成AI動画のレベルが向上。特にSora 2はカメオ機能を持ち、アカウント本人の顔と声を学習しそっくりに生成したり、AIが作ったキャラクターを登録、再利用可能に。そして日本語も流暢に話し、シナリオがなくてもそれなりのストーリーを仕立て、またシナリオを書いたり、ストーリーボードを使うとその内容に沿って動画が生成されるという、ある意味とんでもない性能を誇っている。

作例は見苦しいのでここには掲載しないが(笑)、筆者が「良いお年を!」と言いながら新幹線で帰省するシーンをSora 2で作り、Xに掲載。新年会で親戚に見せたところ、「えっ?これAI!? 」的な反応で、もはや現実と区別できないレベルの映像が生成されるようになった。

ただ、Sora 2やVeo 3.1では、楽曲(mp3)をリファレンスとして渡すことができないため、課題のMV(ミュージックビデオ)は作れない。

そこで登場するのが、AIアバターと呼ばれる「OmniHuman Pro」(現在はOmniHuman 1.5)。これはリファレンス画像とサウンドデータを指定すると、リップシンクも含めた映像が生成されるものだ。

ただし、OmniHumanはサービス内で利用可能、つまりクローズで有償なのだ。オープンのものとしては「Wan2.2-S2V」もあるが、こちらは前者と比べるとご覧のようにやはり性能が落ちる。

と、ここまでが2025年秋までの話だ。では2025年冬、そして2026年1月はどうなったのか!? というのが、今回の話となる。

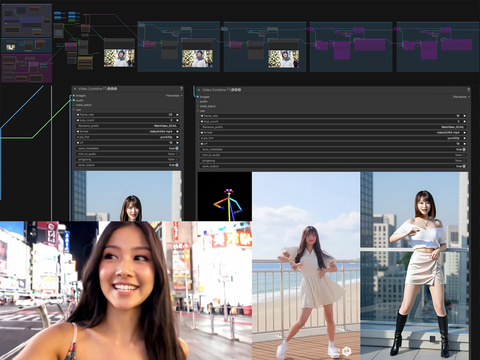

2025年冬Part 1。ダンスをコピー!? (wanvideo_SCAIL_pose_control)

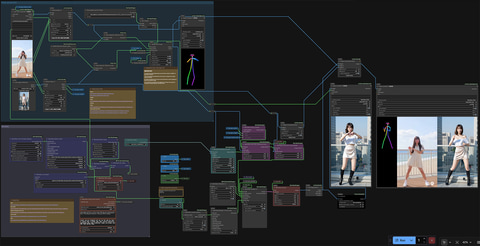

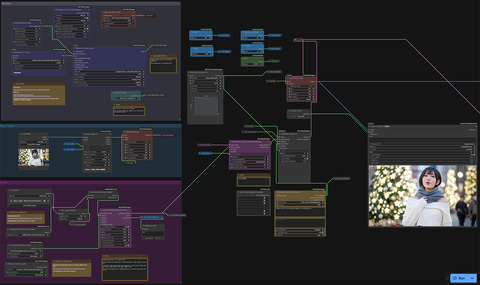

Wan 2.2にはいろいろなWorkflowがあり、その中の1つがwanvideo_2_1_14B_SCAIL_pose_control_example_01.json。これは何かというと、リファレンス動画の動きを再現する生成AI動画だ。

今回はダンスにしたが、動きがあるものであれば何でもコピーできる。

まずWorkflowをComfyUIへドロップするが、いろいろとノードがないので、ComfyUI ManagerのInstall Missing Custom Nodeで不足分をインストールして再起動する。

次はWan関連のモデルをダウンロード、所定のフォルダへ配置し、各ノードへパスをセット。

- fp8_scaled: models/diffusion_models/

- distill lora (should use I2V one): models/loras/

- Text encoder: models/text_encoders

- VAE: models/vae/

- clip_vision_h: models/clip_vision/

さらに、models/detection/を作り、そこへ、

を入れ、ONNX Detection Model Loaderノードのパスを設定する。ほかは初回自動的にダウンロードされる。

Workflowは上記のものを少し改造したのをzipで貼っておくので良かったら使ってほしい。

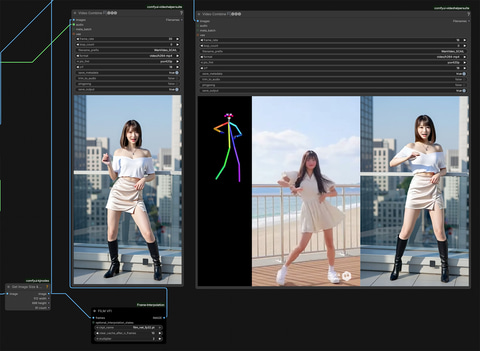

設定されている解像度は512×896ドットの縦長。4:7だが実質9:16に近い。スマホの画面に合う感じになっている。従って、参照動画も画像もできるだけこれに合わせる。今回、参照動画はSora 2の縦長、参照画像はZ-Image-Turboで880×1,536ドットにしている。後はWorkflow左上にあるリファレンス動画と画像をセットするノードに入れ実行すれば動くはずだ。

生成されるフレーム数は81=16x5+1の5秒。GeForce RTX 5090を使って145.36秒かかるものの、5秒の尺が2分ちょっとで作れるのなら、十分我慢できる範囲だろう。

添付したWorkflowで工夫したのは3点。1つはポーズ映像、オリジナル、生成動画の3つを並べて1つの映像にした。ただしこれは16fpsなので動きがガタつく。もう1つはFILM VFIというカスタムノードを使い、30fpsにフレーム補完した上にオリジナルからオーディオ信号を得て完成動画にしたこと。

3つ目は生成するフレーム数=生成秒数を簡単に変更できるようにしてある。中央下辺りにframesと書いてあるノードがあるので、81(5秒)から好きな数値に変更すれば良い。式は16fps×秒数+1。つまり10秒だと161になり、ここまでは行けることを確認している。もちろんこの場合、リファレンス動画の尺も10秒必要となる。

なお、今回掲載している動画はどちらも10秒版だ(zipのWorkflowは81の5秒)。

いかがだろうか?少しややこしいWorkflowで必要なファイルも多いが、完成形の30fps版だと、たとえばTikTokなどに載せるともう分からないレベルではないだろうか。縦1,536ドットなので、フルHDにアップスケールするのも無理ない範囲だ。

リファレンス画像は実写でも良く、まったく踊れない人なのに凄くうまく踊ってる……的な動画も生成可能である。面白く楽しいので興味のある人はぜひ試してほしい。

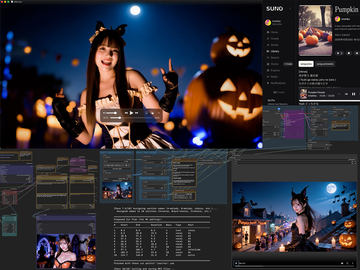

2025年冬Part 2クリスマスソングを歌い出す♪(LongCatAvatar)

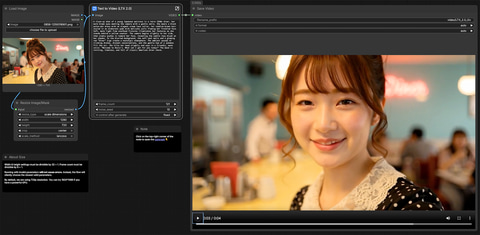

次は「LongCatAvatar」を紹介しよう。これは名前の通り、生成AI動画としては長時間のリップシンクが可能になる技術だ。

カラクリは筆者も良く分かっていないが(笑)、1つ約6秒(16fpsで93 frames)の動画を同一Seed内で並列につなぎ合わせることによって実現する。つまり、3つつなぐと(マージンがあるため)16秒となる。もちろんあまり長いと、後半一貫性に問題が出るパターンとなるため、無茶はできないものの、5秒や10秒というありがちな尺を突破することが可能だ。

上記のサイトを見ると、用途的にはセリフや歌などいろいろできそうだ。そこでSUNOを使い日本語の曲を作って当てたところ、うまくMVっぽくなったので、今回はこれをご紹介する(時期がクリスマスだったので、クリスマスソングなのはお許しを……)。

曲自体は以下のもの。J-POP風のクリスマスソングだ。この音(mp3)と、リファレンス画像1枚で歌った感じのMVにすることができる、というわけだ。

Workflowはこれを利用する。用意するのはリファレンス画像(832×480ドット)とボーカル入りの楽曲(mp3)、それとPromptとなる。

なお、mp3については、イントロが長いと、その分尺が無駄に伸びるため、なるべくいきなりボーカルが入るよう、工夫しておくのが吉だ。

Promptはサイトにあったのを少し真似て、“A woman sings, her voice echoing throughout the surrounding area.”とした。

必要なファイルは、

- main model、その2: models/diffusion_models/

- distill lora: models/loras/

これでWorkflowをComfyUIへドロップ、実行すれば生成開始となる。この時、WanVideo Model Loaderノードのattention_modeを何もしていなければsdpaへ。もしflash-attnやSageAttentionが入っているのならそれへ切り替える(速くなる)。sageattnにしてGeForce RTX 5090を使い6秒で約6分。こちらはかなり重い処理となる。

時間がかかるため、初めの6秒が終わった段階で歌い方などをチェックしておいて、もしおかしいなら停止し、seedを変更した方が無難だろう。

以前ご紹介したハロウィンMVより動きは少ないものの、リップシンクはしっかりしているのが分かる。うまくmp3を刻み、リファレンス画像を変え、編集すれば、もっとMVらしくなると思うが、とにもかくにもローカルでこれだけできるようになったことを喜びたい。2025年年末でこれなら、2026年の年末はもっとすごいことになってるハズだ。

2026年1月6日 Promptで言葉を指示し話せるようになったLTX-2登場!

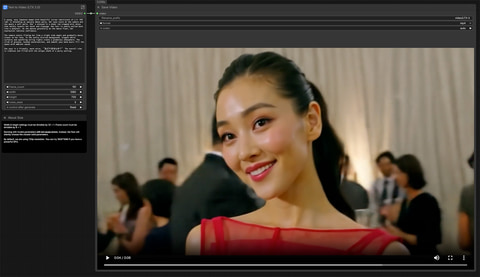

最後は1月6日に出たばかりの「LTX-2」を紹介しよう。

先述のものは、音に関して別途mp3を用意していたが、これはSora 2のようにPromptでそのまま指定して生成できるのが大きな違いとなる。t2v、i2v、そしてdepthやcanny、poseなどリファレンス動画からビデオを生成することも可能で、基本解像度はHD(1,280×720ドット)、24fpsだが、GPUパワーがあればフルHDもいけると説明にはある。

WorkflowはComfyUIのテンプレートにあるのでそれを使う。テンプレートを開くと、必要なファイルでないものはパネルが出るので、それに従ってダウンロード、指定のフォルダへコピーすれば終わり……と、非常に簡単だ。

なお、このWorkflowは先月ご紹介した、Subgraphを使い、難しいところをブラックボックス化、表面的にはすっきりした簡単なものになっている。

まずi2vから。これは先のBLOGにあるImage to Video / Example 1を少し変えただけの内容になる。24fpsで121 framesなので5秒。 英語であればナチュラルに話せる。

次にt2v。同じくWorkflowはテンプレートから。こちらは151 framesなので尺は6.25秒。なおLTX-2に関してはDGX Spark互換機を使用。t2v、151 framesで約150秒かかった。当然GeForce RTX 5090ならもっと速いが、1フレーム1秒。これなら待てない時間でもない(笑)。

セリフはもちろんBGMも流れており、Sora 2に後一歩的な雰囲気で生成される。ただし、日本語は完全ではなく、ひらがな、カタカナなら何とか。ダメな時はローマ字表記で……という感じで、現在のGrok Imagine動画に近い(一時期、完全に日本語OKだったが、現在元に戻っている)。

いずれにしても日本語に関しては、商用サービスならともかく、現状ではオープンなものはアメリカもしくは中国製がメインなので、残念ながらデフォルトで日本語対応は厳しいように思う。

従来、オープンとしてはこれ一本的なWanがversion 2.5、2.6と商用でオープンにならず、今後どうなるか不透明になる中、登場したLTX-2はまさに救世主的な存在。今後が楽しみといえよう。

【11時10分追記】

LTX2最新情報!S2Vで27秒のMVが完成♪。GeForce RTX 5090ではVRAM不足で、解像度は480p(後でHDへアップスケール)にしているものの、それでもこれはすごい♪(生成74秒)。

以上、2025年12月、そして2026年1月の最新ローカル生成可能なAI動画の情報をお伝えした。2024年秋のタイミングではローカルで生成可能な動画は、動画と呼ぶのにも厳しい状況だったのに、たった1年ちょっとでとんでもなく進化しているのが分かる。今年の秋頃であれば、それこそローカルでSora 2的なのが実現しているのではないだろうか!?

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:2位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![[P5倍★19日20:00-24日9:59]【3年保証】モニター 21.5インチ 23インチ 27インチ フルhd 高画質 100Hz VA ノングレア 非光沢 スピーカー内蔵 ディスプレイ パソコンモニター PCモニター フルハイビジョン 23.8インチ 液晶モニター DT-JF アイリスオーヤマ * 製品画像:8位](https://thumbnail.image.rakuten.co.jp/@0_mall/eleking/cabinet/wh15/112988sku_ins.jpg?_ex=128x128)

![ミステリと言う勿れ(16)【電子書籍】[ 田村由美 ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/7173/2000019557173.jpg?_ex=128x128)

![前田敦子写真集 Beste [ 前田 敦子 ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/7737/9784065417737_1_2.jpg?_ex=128x128)

![改訂第11版 救急救命士標準テキスト [ 救急救命士標準テキスト編集委員会 ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1071/9784867191071_1_2.jpg?_ex=128x128)

![歌詞の本棚 DEAR MY FRIEND [ Hi-STANDARD ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/3936/9784845643936_1_5.jpg?_ex=128x128)

![図説 足の臨床 [ 高倉 義典 ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1792/9784758321792_1_4.jpg?_ex=128x128)

![SPY×FAMILY 17 (ジャンプコミックス) [ 遠藤 達哉 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0092/9784088850092_1_6.jpg?_ex=128x128)

![きのう何食べた?(25)【電子書籍】[ よしながふみ ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/0973/2000019710973.jpg?_ex=128x128)

![ニセモノの錬金術師 5【電子書籍】[ 杉浦 次郎 ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/6133/2000019696133.jpg?_ex=128x128)

![青天 [ 若林 正恭 ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0665/9784163920665_1_10.jpg?_ex=128x128)