ニュース

SUPERや60は出なかったが、ソフトの力でこれだけスゴくなったGeForce RTX

2026年1月23日 13:04

NVIDIAは1月22日、都内で記者説明会を開催し、CES 2026で発表された内容について、いくつかのトピックをピックアップして紹介を行なった。

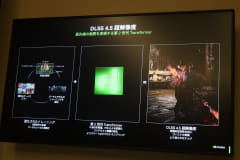

CES 2026でNVIDIAは、コンシューマ向けGeForceの新製品を発表しなかったのだが、代わりに第2世代Transformerモデルを採用した超解像技術「DLSS 4.5」などを発表し、ソフトウェアの力を借りて性能向上や画質改善を図っている。

DLSS 4.5

発表会でテクニカルマーケティングマネージャーの澤井理紀氏はまず、DLSS技術について紹介した。超解像/マルチフレーム補完技術の「DLSS 4」はローンチ当初、採用ゲームタイトルは75タイトルだったのだが、約1年を経て、250タイトルにまで増加したことをアピール。また、2026年にもすでに4タイトルが採用をうたっている。

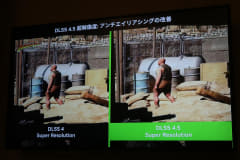

そのメジャーアップデートとなる4.5では、新たに第2世代Transformerモデルを採用。GeForce RTX 40/50シリーズでサポートされているFP8フォーマットにより、これらのGPUでは実行の高速化が図れるのだという。また、トレーニングセットを強化し、コンテキスト認識の強化、よりスマートなピクセルサンプリングにより、時間的安定性の向上、ゴーストの低減、より滑らかなエッジを実現できたとしている。

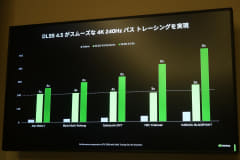

また、GeForce RTX 50シリーズでは、中間5フレームまで生成できるようになったMFG 6xをサポートし、さらにゲームをスムーズ化した。また、モニターのリフレッシュレートに合わせてターゲットを設定し、中間生成フレームを動的に変化させる「ダイナミック マルチフレーム生成」もサポートし、スムーズさと画質の両立を実現したとしている。

なお、第2世代TransformerモデルはすでにすべてのGeForce RTXで利用可能で、MFG 6xおよびダイナミック マルチフレーム生成は2026年春に利用可能になる見込み。

AIの性能改善

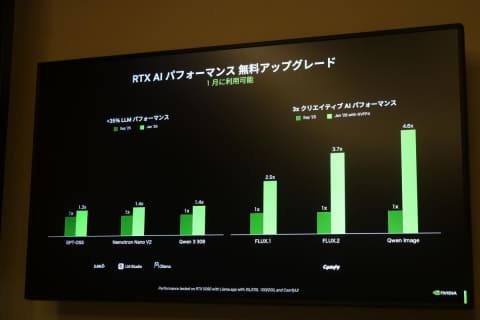

続いてはAI周りの進化について語られた。近年はローカルPCで実行するLLMの進化により、その利用者数も大幅に増えているが、1月に提供するアップデートにより、Llama.cpp、Ollama、LM Studioなどで性能は1.3~1.4倍向上するという。

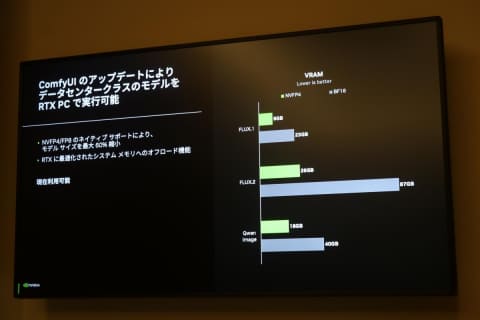

また、画像生成AIの筆頭であるComfy UIについては、コミュニティと協業し、新たにNVFP4のサポートを追加することで、「FLUX.1」では2.5倍、「FLUX.2」では3.7倍、「Qwen Image」では4.6倍、性能向上できるとしている。

なお、NVFP4およびFP8の対応によりモデルのサイズを最大60%削減可能で、これまでデータセンターのGPUでしか実行できなかったようなモデルがローカルでもVRAMに収まるサイズとなり、動作するようになっている。システムメモリへのオフロード機能も最適化されているため、性能低下を抑えられる。

生成AIが実現する次世代の効率的なワークフロー

発表会では、新機能ではないものの、生成AIを使ったさまざまなワークフローや業務の進化についてもデモがなされた。

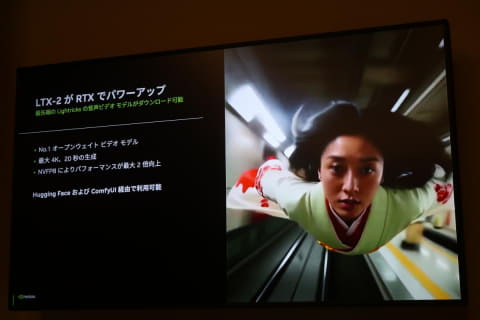

2026年に入ってからホットな生成AIといえば、動画生成の「LTX-2」だが、こちらもGeForce RTX上で動作可能。そして2月には「RTX Video」をComfy UI向けに提供し、720pの動画を高速で4Kビデオにアップスケールできるようにする。ちなみに、10秒の4Kビデオを生成するのに、従来のBF16フォーマットでの動画生成とほかのアップスケーラーでは15分かかっていたが、NVFP8とPyTorch-CUDAでの動画生成とRTX Videoでは3分に短縮できるという。

3D動画の制作フローも、NVIDIA GPUと生成AIによって大きく変化しそうだ。たとえばQwen SLMを用いて、テキストで記述したオブジェクトをTrellis 3D Generatorで3Dオブジェクトとして生成、それをBlenderに配置し、それをComfy UIのワークフローに統合。FLUX画像生成を利用して、動画の1番目のフレームと終わりのフレームを出力し、さらにLTX-2でその2つのフレームの間のものを生成する……といったことが可能になる。

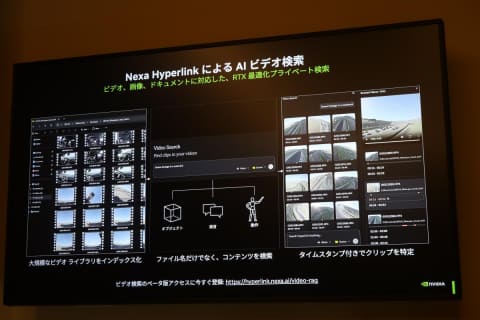

ビデオ制作においてもう1つの課題が、大量の素材の検索だが、これは現在ベータ版を提供している「Nexa Hyperlink」が解決する。これはPCに保存されているビデオを自動でインデックス化し、ビデオ内に映っているオブジェクトや発言、動きなどをテキストで検索できるようにするものとなっている。

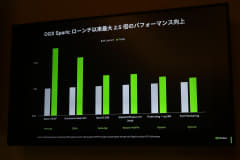

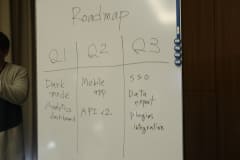

最後のデモが、Blackwell GPUをベースとした“卓上スパコン”の「DGX Spark」。澤井氏によれば、ローンチ以降最適化を継続的に進めており、投入当初比較して2倍以上性能の向上を実現した処理もあるのだという。また、同社は「Playbook」を公開しており、推論やファインチューニング、データサイエンス、ツール、ユースケースなどをまとめて紹介することで、ユーザーの可能性を広げ、スムーズに業務に取り入れられるようにしているとした。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:4位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![【エントリーで最大全額ポイント還元|3/11まで】 ASUS|エイスース PCモニター Eye Care ブラック VP227HF [21.45型 /フルHD(1920×1080) /ワイド /100Hz] 製品画像:5位](https://thumbnail.image.rakuten.co.jp/@0_mall/biccamera/cabinet/product/13384/00000014189403_a01.jpg?_ex=128x128)

![【エントリーで最大全額ポイント還元|3/11まで】 ASUS|エイスース PCモニター Eye Care VA249HG [23.8型 /フルHD(1920×1080) /ワイド /120Hz] 製品画像:4位](https://thumbnail.image.rakuten.co.jp/@0_mall/biccamera/cabinet/product/12947/00000014147044_a01.jpg?_ex=128x128)

![[新品]俺はロリコンじゃない! (1-8巻 全巻) 全巻セット 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/mangazenkan/cabinet/syncip_0031/m1295411856_01.jpg?_ex=128x128)

![現実が瞬く間に好転する 浄化の力 [ 片山 鶴子 ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1651/9784046071651_1_15.jpg?_ex=128x128)

![ハーバード、スタンフォード、オックスフォード… 科学的に証明された すごい習慣大百科 人生が変わるテクニック112個集めました [ 堀田秀吾 ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/3417/9784815633417_1_18.jpg?_ex=128x128)

![1日外出録ハンチョウ(22)【電子書籍】[ 上原求 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/5589/2000019775589.jpg?_ex=128x128)

![otona MUSE (オトナ ミューズ) 2026年 4月号 [雑誌] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0469/4912121650469_1_2.jpg?_ex=128x128)

![隔週刊 ZARD プレミアム ディスク・コレクション 2026年 3/25号 [雑誌] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0361/4912389040361.gif?_ex=128x128)

![肩関節拘縮の評価と運動療法 改訂版 [ 赤羽根良和 ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2599/9784904862599.jpg?_ex=128x128)