ニュース

GPT-4oとPhi-3でLLMとSLMの双方を取り込むMicrosoftのAI戦略

2024年5月22日 00:30

Microsoftは5月21日~23日(現地時間)、開発者向け年次イベント「Microsoft Build」を米国ワシントン州シアトルのシアトルコンベンションセンターで開催する。それに先立って同社は、生成AIのファンデーションモデル、Copilot+PC向けAIアプリの開発環境となる「Windows Copilot Runtime」、DirectMLのNPUへの拡張、さらにはCopilot for Microsoft 365やMicrosoft Edgeの拡張など、AIに関する広範な発表を行なった。

Copilot+PCに対応したWindows Copilot Runtime、DirectMLのNPUへの拡張

既報の通りMicrosoftは、Buildの前日に行なわれた記者会見の中で、「Copilot+PC」と呼ばれる次世代のAI PCプラットフォームに関する発表を行なった。Copilot+PCは、AIアプリケーションをローカルで動かすことがポイントになっている。最初の製品群はQualcomm Snapdragon X Elite/PlusをSoCとして採用しており、45TOPSというNPUとしては高い性能を活用して、AI処理を行なう。

このCopilot+PC向けの開発環境として「Windows Copilot Runtime」を、そして、それを活用してWindows上のオンデバイスアプリケーションを開発するためのAPIやAIモデルを提供する「Windows Copilot Library」が発表された。Copilot+PC向けのMicrosoft標準アプリケーションである「Recall」、「Cocreator」、「Live Captions」などは、いずれもWindows Copilot Runtime、Windows Copilot Libraryを利用して開発されている。

Windows Copilot Libraryには各種APIと、デバイス上でAIアプリケーションを構築するのに必要な40以上のAIモデルなどが提供されている。また、同時発表された「Windows Semantic Index」を活用すると、AIを活用したより高度な検索機能をアプリケーションに実装できる。

また、MicrosoftがSLM(Small Language Model)として開発したPhi-3を、Copilot+PC上で実行できるようにすることも発表されている。クラウドにつなげる必要がないため低遅延かつ、1.5Wの消費電力で650トークン/秒という電力効率に優れた言語モデルを実現できる。

また、Windows 11でSnapdragon X Elite以外のSoCに搭載されたGPU/NPUでも利用できるDirectMLの拡張や、AIアプリケーションの開発環境としてPyTorchを利用した場合でもDirectMLをネーティブにサポートすることが明らかにされた。

NVIDIAのGPUは、ドライバレベルでDirectMLをサポートしているので、PyTorchを利用してAIアプリケーションを構築する際、DirectMLを利用すると、CUDAを利用しなくてもAI推論でNVIDIA GPUを利用できるようになる。GPU対応は完了しており、今後NPUのサポートが追加される。

このほかにもWebNNを利用した場合のDirectMLのサポート、ONNX RuntimeからDirectMLを利用する際の高性能な推論機能の導入なども明らかにされた。

IntelのCore UltraのNPU(Intel AI Boost)、さらにはQualcomm Snapdragon X EliteのNPU(Hexagon NPU)のDirectML対応もまもなく開始されるということで、3DゲームがDirect3Dにより標準化が進んだように、DirectMLでAIが利用しやすくなる環境が整いつつあることを印象づけた。

Microsoft Edgeには動画のリアルタイム翻訳機能が実装

Microsoft Edgeの機能拡張として、動画のリアルタイム翻訳機能の実装計画が明らかにされた。たとえば、非母国語の動画を見ている時に、AIを利用して母国語にリアルタイムに翻訳し、音声で再生するか、字幕にするか、あるいは両方の形で動画に重ねて再生できる。

ただし、サービス側も対応する必要があり、まずはYouTube、LinkedIn、Reuters、CNBC News、Bloomberg、Courseraなどが対応する。言語については、スペイン語から英語と、英語からドイツ語、ヒンズー語、イタリア語、ロシア語、スペイン語への翻訳に対応する。対応言語は今後増えていく。

ビジネス向けのMicrosoft Edgeとなる「Microsoft Edge for Business」には2つのセキュリティ機能が実装される。1つは「Screenshot prevention」(スクリーンショット防止機能)で、企業側がIntuneなどのMDMなどを通じてScreenshot preventionのポリシーを設定することで、エンドユーザーがWebブラウザのスクリーンショットを撮れなくなる。

もう1つの「Easily stay up to date」では、ゼロデイ攻撃などにより脆弱性を悪用されるリスクを持つ、最新ではないブラウザインスチャンスをチェックし、それを強制的に再起動することを可能にする。同時にブラウザの自動更新を有効にし、保護を強化するためのセキュリティモードを有効にするなど、脅威の対策になるような設定を有効にできる。

「Team Copilot」の導入などCopilotの拡張が続く

Igniteにおいて、サティヤ・ナデラCEOは「MicrosoftはCopilotの会社になる」と強調したが、今回のBuildでもCopilotに関する発表が相次いでいる。

Microsoft 365のCopilotとなる「Copilot for Microsoft 365」の拡張としては「Team Copilot」の導入が発表された。Copilotは「パーソナルアシスタンス」と呼ばれるバーチャル秘書のような存在で、Team Copilotは部課全体で共有するバーチャル秘書のようなものだ。

部課のメンバー全員の予定を勘案してTeamsでの全体ミーティング予定を自動で設定したり、部課全体で共有すべき目標を部課員に知らせたりできる。また部課のモデレーターとしての役割も果たし、Teamsのミーティングやチャットなどの要約などを行なったり、プロジェクトの進行を管理したりすることが可能という。

「Microsoft Copilot Studio」は、Copilot for Microsoft 365を自社のニーズに合わせてカスタマイズする機能で、独自に構築したCopilotを利用して、自社の従業員や顧客などにサービスとして提供できる。SAPなどの外部サービスに接続し、カスタムプラグインなどを活用してLLMを利用した独自の対話型AIサービスなどを構築できる。

GithubにCopilotの機能を付加する「GitHub Copilot」向けには、「GitHub Copilot extensions」が発表された。GitHub Copilot extensionsは、Microsoft自身やサードパーティのパートナーが提供する拡張機能をGithub Copilotで利用できるようにする機能で、GitHub Copilotを開発者にとってより便利にしたり、カスタマイズ性を向上させたりする。GitHub Copilot extensionsは現時点ではプライベートプレビューが行なわれている。

「GPT-4o」にAzure AI StudioやAPIで対応

生成AI界隈では、OpenAIが先日発表した「GPT-4o」が話題を呼んでいる。GPT-4oはマルチモーダルなLLMで、テキスト、イメージ、オーディオなどを対話的に扱える。従来のGPT-4ベースのLLMでもマルチモーダルな処理は不可能ではないが、GPT-4oではより高度になっている。

今回Microsoftは、GPT-4oをAzure経由で提供する「Azure AI Studio」と、AzureのAPI経由での利用を発表した。Azure AI Studioは、企業などが自社カスタムのCopilotを開発するための開発ツールになる。これまでAzure AI Studioプレビュー版として提供されてきたが、今回から一般提供開始になった。

あわせて、Phi-3-small、Phi-3-medium、Phi-3-Visionという3つのPhi-3シリーズの新モデルも発表した。Phi-3ファミリーは小型なSLM(Small Language Model)であり、Phi-3-visionはその中でもマルチモーダルな処理を得意とするSLMとして、Azureで利用することが可能になる。

GPU逼迫の切り札となるか? AMD Instinct MI300XのVM

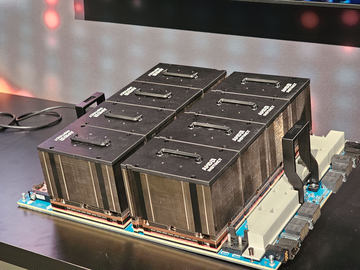

Microsoftは2023年11月に新ハードウエア「ND MI300X v5」をAzureのVM(仮想マシン)に導入すると発表していた。そのGPUとなるAMD Instinct MI300Xは、チップレットを利用して8つのGPUダイを1つのパッケージに封入している。

NVIDIAのGPUの強みはCUDAというソフトウェアのプログラミングモデルを持つことだ。しかし、クラウドマネージドサービスを利用している企業にとって、CUDAかそうではないかは大きな問題ではない。というのも、クラウド事業者が提供するAI開発ツールがハードウエアの違いを吸収することになるからだ。

現在、NVIDIAのAI用GPUは、需要が逼迫している。AzureでND MI300X v5のサービスが開始されたことは、AI開発者にとっても、AMD自身にとっても大きな意味がある。

ND MI300X v5は、AMD Instinct MI300X、1.5TBのHBMメモリ(5.2TB/秒)、NVIDIA Quantum-2 CX7 InfiniBandを採用。最大で数千個のVM(数万個のGPU)にスケールアップすることが可能。ND MI300X v5は既に一般提供が開始されている。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:4位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![Microsoft|マイクロソフト ノートパソコン 新生活応援モデル Surface Pro 12インチ プラチナ + キーボード(スリムペン付き)+ 充電器 EP2-46399 [Copilot+ PC /12.0型 /Windows11 Home /Snapdragon X Plus /メモリ:16GB /UFS:256GB /M365 (24か月) or Office 選択可能] 製品画像:1位](https://thumbnail.image.rakuten.co.jp/@0_mall/biccamera/cabinet/product/16366/00000014938175_a01.jpg?_ex=128x128)

![BenQ|ベンキュー USB-C接続 PCモニター Mac向けシリーズ MA270U-JP [27型 /4K(3840×2160) /ワイド /60Hz] 製品画像:2位](https://thumbnail.image.rakuten.co.jp/@0_mall/biccamera/cabinet/product/10950/00000013427993_a01.jpg?_ex=128x128)

![栄光ゼミナールの学習ポスターブック [ 栄光ゼミナール ] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2852/9784522442852_1_5.jpg?_ex=128x128)

![ねずみの初恋(9)【電子書籍】[ 大瀬戸陸 ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/5593/2000019775593.jpg?_ex=128x128)

![神さまの言う通り さとうみつろう短編集4 [ さとうみつろう ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1328/9784198661328_1_2.jpg?_ex=128x128)

![そうだ、売国しよう〜天才王子の赤字国家再生術〜 18巻【電子書籍】[ 鳥羽徹 ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/9018/2000019629018.jpg?_ex=128x128)

![底辺戦士、チート魔導師に転職する! 12巻【電子書籍】[ kimimaro ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/9052/2000019629052.jpg?_ex=128x128)

![義妹に婚約者を奪われた落ちこぼれ令嬢は、天才魔術師に溺愛される(コミック) : 8【電子書籍】[ オザイ ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/2586/2000019842586.jpg?_ex=128x128)

![書簡型小説「二人称」 ヨルシカ [ n-buna ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/6341/9784065416341_1_3.jpg?_ex=128x128)

![悪役令嬢と鬼畜騎士(5)【電子限定描き下ろし付き】【電子書籍】[ 生還 ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/4207/2000019844207.jpg?_ex=128x128)

![呪術廻戦≡(モジュロ) 2【電子書籍】[ 芥見下々 ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/1612/2000019641612.jpg?_ex=128x128)

![【楽天ブックス限定特典】山中柔太朗カレンダー2026.4-2027.3(通常版)(オリジナルフォトカード(スマホサイズ)) [ 山中柔太朗 ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9298/2100014739298_1_3.jpg?_ex=128x128)