ニュース

Z.ai、オープンソース最高の性能をうたうLLM「GLM-5」

2026年2月12日 18:04

Z.aiは、複雑なシステムエンジニアリングおよび長期的なエージェントタスクを得意とするLLM(大規模言語モデル)「GLM-5」を発表した。現在、Hugging Face上で公開されている。

GLM-5は、従来の「GLM-4.5」からパラメータ数を355Bから744Bに増加させるとともに、アクティブパラメータ数も32Bから40Bに向上させ、さらに事前学習データも23Tトークンから28.5Tトークンに増加させることで能力を高めた。また、DeepSeek Sparse Attention(DSA)を統合することにより、長期コンテキストのキャパシティを維持しながら、導入コストを大幅に削減したという。

GLM-5では、非同期強化学習インフラストラクチャである「slime」を開発して導入している。強化学習はこれまで学習効率の低さから、LLMへの大規模導入が困難だったが、slimeにより学習スループットと効率を向上させ、よりきめ細かな学習後の反復処理を可能とした。

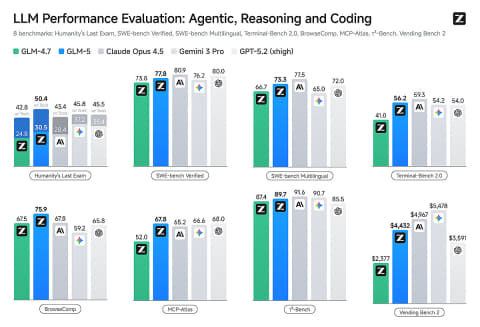

これにより、幅広い学術ベンチマークにおいて大幅な改善を実現し、推論、コーディング、エージェントタスクにおいて、あらゆるオープンソースモデルの中でクラス最高のパフォーマンスを達成し、最先端モデルとのギャップを埋めることに成功したとしている。

Introducing GLM-5: From Vibe Coding to Agentic Engineering

— Z.ai (@Zai_org)February 11, 2026

GLM-5 is built for complex systems engineering and long-horizon agentic tasks. Compared to GLM-4.5, it scales from 355B params (32B active) to 744B (40B active), with pre-training data growing from 23T to 28.5T tokens.…pic.twitter.com/uGYQUjIbbs

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:4位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![【新品未開封・国内正規品】MacBook Pro 14.2インチ Liquid Retina XDRディスプレイ MDE04J/A [スペースブラック] Apple M5 10コア RAM16GB SSD512GB 一年間メーカー保証有 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/akiba109/cabinet/imgrc0138208037.jpg?_ex=128x128)

![DELL|デル ゲーミングノートパソコン Dell G15 5530 クォンタム ホワイト NG595-DNHBCW [15.6型 /Windows11 Home /intel Core i7 /メモリ:16GB /SSD:1TB /Office Home and Business /2023年夏モデル] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/biccamera/cabinet/product/8202/00000011560900_a01.jpg?_ex=128x128)

![富士通 ★中古パソコン・Aランク★FMVD40001 [ESPRIMO D588/V(i5-8500 8GB SSD256GB Win10Pro)] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/etre/cabinet/itemimage33/1286094.jpg?_ex=128x128)

![27E1N5600AE/11 [27型液晶ディスプレイ /2560×1440/HDMI、USB Type-C、DisplayPort/スピーカー:あり] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/etre/cabinet/itemimage20/1251851.jpg?_ex=128x128)

![IOデータ Mini LED採用 200Hzゲーミングモニター KH-GDQ271JLAQ GigaCrysta [ 27型 / WQHD(2560×1440) / ワイド ] ブラック 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/r-kojima/cabinet/n0000001437/4957180182469_1.jpg?_ex=128x128)

![TRANSIT特別編集号 清水みさとの世界のサウナをめぐる冒険 (講談社 Mook(J)) [ ユーフォリアファクトリー ] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0378/9784065430378_1_2.jpg?_ex=128x128)

![Mono Max 2026年 4月号 [雑誌] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0467/4912187490467.gif?_ex=128x128)

![【楽天ブックス限定特典】乃木坂46川崎桜 1st写真集『エチュード』(限定カバー) [ 川崎桜 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1009/2100014821009_1_3.jpg?_ex=128x128)

![ワンパンマン 36 (ジャンプコミックス) [ ONE ] 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/8914/9784088848914_1_9.jpg?_ex=128x128)

![栄光ゼミナールの学習ポスターブック [ 栄光ゼミナール ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2852/9784522442852_1_5.jpg?_ex=128x128)

![BLUE GIANT MOMENTUM(7)【電子書籍】[ 石塚真一 ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/1765/2000019711765.jpg?_ex=128x128)