ニュース

スマホでローカルチャットAIの時代迫る。ファインチューニング向け超軽量モデルGemma 3 270M

2025年8月15日 15:18

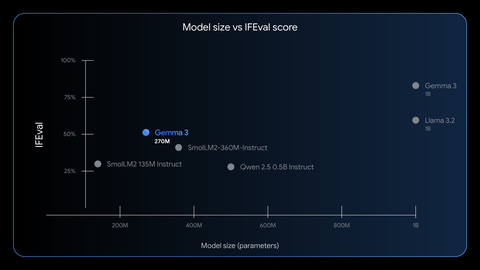

Googleは、2億7,000万パラメータのコンパクトな言語モデル「Gemma 3 270M」を発表した。あわせて、ブラウザ上でオフライン動作するデモアプリ「Bedtime Story Generator」を公開した。

Gemma 3 270Mは、特定のタスクに特化した小型高性能モデルを構築するためのベースモデルである。Googleはこれを「適材適所」(The right tool for the job)の哲学を体現するモデルだとし、無駄なく高速、低コストな生産システムを構築できるとしている。

Gemma 3 270Mの大きな特徴は、サイズに比して膨大な語彙力、優れたエネルギー効率、量子化耐性の3点である。Gemmaは2億7,000万パラメータのうち1億7,000万を単語や記号に対応するための埋め込みパラメータ用に割り振っており、25万6,000トークンという膨大な語彙を持つ(例として、GPT-3.5の語彙数はおよそ10万トークン、GPT-4oはおよそ20万トークンと言われる)。このため、より専門的な用語や珍しい単語も扱うことができ、特定の用途や言語への最適化がスムーズに行なえる。

Googleが行なった社内テストでは、int4量子化モデルをPixel 9 ProのSoc上で動作させた際、25回の応答に要したバッテリ消費量はわずか0.75%だったとしており、電力効率の高さを謳っている。

多くの自然言語モデルでは、メモリ消費量を小さくする「量子化」によって性能が低下する。Gemma 3 270Mには「Quantization-Aware Training」という、モデルの学習段階で量子化シミュレーションを行ない、その結果に基いて量子化を前提とした構造でモデル構築する技術が採用されている。これにより、int4精度の量子化でもパフォーマンス低下を最低限に抑えられるという。

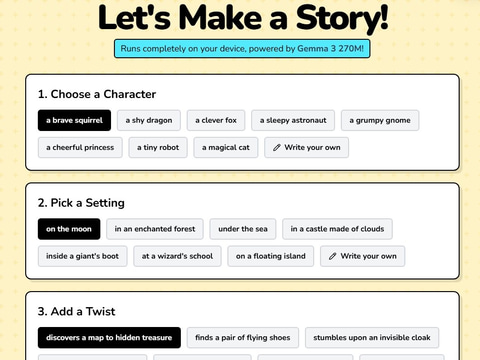

クリエイティブ目的での実装例として、Bedtime Story Generatorが公開されている。これはローカルで動作する、ユーザーからのお題に従ってBedtime Story(おとぎ話)を生成するブラウザアプリだ。

Gemma 3 270MはHugging Faceなどで配布されており、一般的なツールで推論や微調整が可能だ。Googleは、大規模かつ明確に定義されたタスクを実行する場合や、推論コストを削減したい場合、プライバシーを保護する必要がある場合などにこのモデルが最適だとしている。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:4位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![[SALE]ノートパソコン パソコン 第13世代CPU搭載 Windows11 14.1/15.6インチワイド液晶 フルHD cpu N95/N5095/J4025 メモリ 8GB 12GB 16GB 32GB 新品 SSD 128GB 256GB 512GB 1TB NVMe PCIe3.0 USB3.0 初期設定済 安い おすすめ 製品画像:24位](https://thumbnail.image.rakuten.co.jp/@0_mall/makanashop/cabinet/11775753/11862699/12110692/bbbby-1.jpg?_ex=128x128)

![[3月中旬より発送予定][新品]超かぐや姫! 公式ガイドブック ハッピーエンドのその先へ![入荷予約] 製品画像:30位](https://thumbnail.image.rakuten.co.jp/@0_mall/mangazenkan/cabinet/syncip_0067/m1140475507_01.jpg?_ex=128x128)

![【楽天ブックス限定デジタル特典】「修学旅行で仲良くないグループに入りました」ドラマ公式ビジュアルブック(公式ビジュアルブック撮影裏側動画配信データ - 2人きりの修学旅行編) [ ABC ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/8092/9784046858092_1_3.jpg?_ex=128x128)

![超かぐや姫! 公式ガイドブック ハッピーエンドのその先へ! [ ニュータイプ編集部 ] 製品画像:28位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0557/9784041170557_1_14.jpg?_ex=128x128)

![Mono Max 2026年 4月号 [雑誌] 製品画像:27位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0467/4912187490467.gif?_ex=128x128)

![デコピンのとくべつないちにち (単行本 608) [ 大谷 翔平 ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9368/9784591189368.jpg?_ex=128x128)

![みんなの日本語 初級1 第3版 本冊 [ スリーエーネットワーク 編 ] 製品画像:25位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/0003/9784868410003_1_3.jpg?_ex=128x128)

![SAKAMOTO DAYS 26【電子書籍】[ 鈴木祐斗 ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/rakutenkobo-ebooks/cabinet/1518/2000019641518.jpg?_ex=128x128)