ニュース

ノートPCでも128BのLLMが動く。そう、Ryzen AI Maxとメモリ128GBならね

2025年7月30日 17:36

AMDは、Windows用ドライバRadeon Software Adrenalin Editionに備わる可変グラフィックスメモリ(VGM)機能のアップグレードにより、Vulkan版llama.cppで最大128B(1,280億)パラメータまでのLLMを処理可能になったと発表した。

VGMはRyzen AI 300シリーズ向けに提供されている、システムメモリの一部を内蔵GPU専用メモリとして割り当てる機能だ。ドライバ経由でBIOSレベルの設定を変更するものであり、設定後に再起動することで適用される。

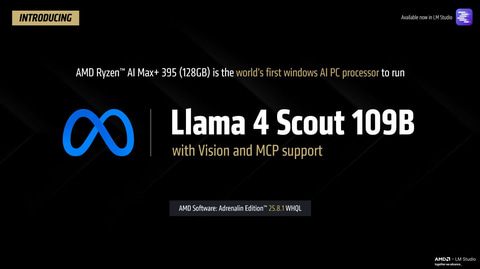

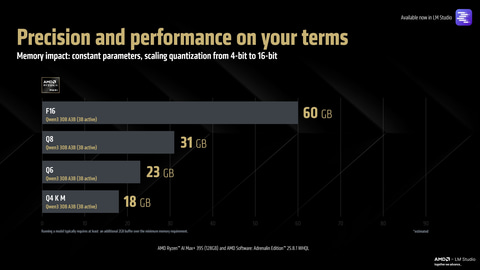

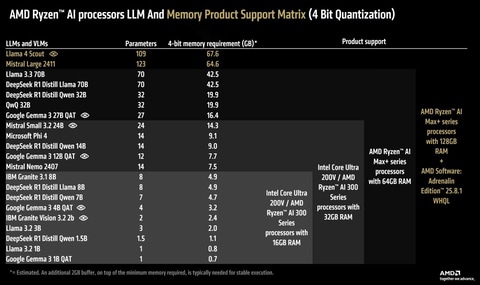

今回のアップグレードにより、メモリ128GBを搭載した環境で、VGMの最大割合である75%に当たる96GBをVRAMとして割り当てることで、LM Studio上にて128Bまでのパラメータを持つVulkan版llama.cppが実行可能になる。現在は公式リリースページから、本機能に対応したRadeon Software Adrenalin Editionプレビュー版がインストールできる。AMDが公開したデモでは109Bのパラメータを持つ「Llama 4 Scout(Q4 K M)」が15tok/sという実用的な速度で動作しており、これはWindows AI PCとして世界初だとしている。

また、「Qwen 3 30B A3B」のようなパラメータが少ないLLMモデルを使用する際には、VRAMに余裕があるため、量子化レベルを落として出力の精度を向上させるといった使い方も可能だ。

豊富なVRAMを生かしてトークン数を増やすこともでき、ドキュメントを読み込ませた上で詳細な指示を与えたり、MCPで得たデータを処理させたりといった、より複雑な動作が可能になるという。Llama 4 Scout使用時は25万6,000ものコンテキスト長で実行可能で、公式に行なわれたLlama 4 Scoutのデモでは、2万1,445トークンを要する処理を完了している。

128Bパラメータを持つLLMの実行に必要な環境として、128GBのメモリのほか、Ryzen AI Max+ 395が挙げられている。これらを満たす構成のPCとしてはHPのZBook Ultra G1a 14 inchなどが例示されている。

より小規模な構成でも、Ryzen AI 300シリーズ搭載PCにおいて32GBのメモリがあれば4bit量子化かつ24Bパラメータのモデルまで動作可能としており、具体例としRyzen AI 9 300シリーズとメモリ32GBのPCでは「Gemma 3 12B QAT」、同メモリ16GBのPCでは「Google Gemma 3 4B QAT」などが優れた選択肢になるとしている。

【20時45分追記】記事の内容を調整しました。

![[Amazon限定ブランド]CCL い・ろ・は・すラベルレス 2LPET ×8本 ミネラルウォーター 無味 製品画像:1位](https://m.media-amazon.com/images/I/41h0MHfvhkL._SL160_.jpg)

![【Amazon.co.jp限定】 伊藤園 磨かれて、澄みきった日本の水 2L 8本 ラベルレス [ ケース ] [ 水 ] [ 軟水 ] [ ペットボトル ] [ 箱買い ] [ ストック ] [ 水分補給 ] 製品画像:4位](https://m.media-amazon.com/images/I/41n0o65dSkL._SL160_.jpg)

![黒/白2色 楽天1位!384冠!モニター 23.8インチ 27インチ 200Hz/180Hz/165Hz/100Hz ゲーミングモニター 1ms応答 pcモニター パソコン モニター 非光沢 VA チルト VESA Freesync スピーカー内蔵[1+1年保証] cocopar 製品画像:8位](https://thumbnail.image.rakuten.co.jp/@0_mall/qifeng/cabinet/09826274/09826275/imgrc0105783334.jpg?_ex=128x128)

![I-O DATA|アイ・オー・データ ゲーミングモニター GigaCrysta 3年保証 ブラック KH-GD254U [24.5型 /フルHD(1920×1080) /ワイド /320Hz] 製品画像:4位](https://thumbnail.image.rakuten.co.jp/@0_mall/biccamera/cabinet/product/14752/00000014570246_a01.jpg?_ex=128x128)

![ぜんぶ絵で見て覚える 第2種電気工事士 学科試験 すい~っと合格 2026年版 [ 藤瀧 和弘 ] 製品画像:29位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/4316/9784274234316_1_2.jpg?_ex=128x128)

![湯浅政明大全 Sketchbook for Animation Projects [ 湯浅政明 ] 製品画像:26位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/1182/9784756261182_1_2.jpg?_ex=128x128)

![2026年度版 みんなが欲しかった! 宅建士の教科書 [ 滝澤 ななみ ] 製品画像:23位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9273/9784300119273_1_16.jpg?_ex=128x128)

![大きな文字で歌いやすい なつかしい歌260曲 [ 西東社編集部 ] 製品画像:22位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/9473/9784791629473.jpg?_ex=128x128)

![田中美久写真集 「ぜんぶ、ほんと」 [ 田中 美久 ] 製品画像:21位](https://thumbnail.image.rakuten.co.jp/@0_mall/book/cabinet/2167/9784087902167_1_58.jpg?_ex=128x128)